Blockchain und Nachhaltigkeit – Von der Vision zur belastbaren Datenbasis

Es gibt viele Gründe, warum Blockchain jetzt auf die Nachhaltigkeitsagenda von Unternehmen gehört: Dort, wo Nachvollziehbarkeit, Integrität und Automatisierung von Nachhaltigkeitsdaten zählen, wird sie zum strategischen Werkzeug. Regulatorische Anforderungen wie CSRD/ESRS, CSDDD/LkSG oder EUDR zwingen Unternehmen zu prüffesten, zeitnahen und möglichst automatisierten Nachweisen entlang der Wertschöpfungskette. Klassische Mittel wie Excel, manuelle Freigaben oder verteilte, heterogene IT-Systeme stoßen hier an Grenzen. Medienbrüche, Versionsprobleme und eingeschränkte Auditfähigkeit gefährden Glaubwürdigkeit und Effizienz der Prozesse. Blockchain adressiert genau diese Schwachstellen. Sie liefert eine unveränderbare, verteilte und transparente Datenbasis, auf der Nachhaltigkeitsinformationen fälschungssicher dokumentiert, geteilt und geprüft werden können.

Was die Blockchain-Technologie leisten kann

Die Technologie zeichnet sich durch folgende Kernprinzipien aus:

- Unveränderlichkeit

Einmal gespeicherte Daten lassen sich nicht stillschweigend manipulieren. Das ist ideal für Nachweise zu Herkunft, Emissionen oder Zertifikaten. - Dezentralität

Daten liegen gleichzeitig auf vielen „Knoten“. Das erhöht Ausfallsicherheit und senkt Manipulationsrisiken. - Transparenz & Nachvollziehbarkeit

Eine sogenannte Hash-Verkettung macht jeden Schritt historisch prüfbar: Hash-Ketten bezeichnen die kryptografische Verkettung von Datenblöcken, bei der jeder Block den Hashwert des vorherigen enthält und so die Integrität und Unveränderlichkeit der gesamten Datenkette sicherstellt. Ownership und Übergaben sind damit lückenlos dokumentiert. - Technologiegestütztes Vertrauen

„Trust by Design“ ersetzt Teile des institutionellen Vertrauens. Das ist bei global verteilten Lieferketten besonders wichtig.

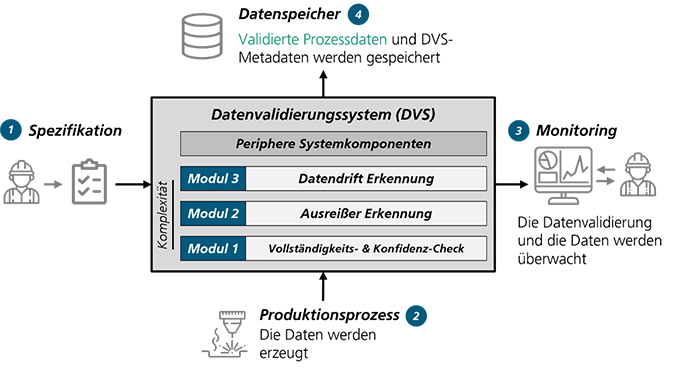

Einfach gesagt, Blockchain konserviert Wahrheit – allerdings auch Irrtum. Ohne eine Sicherstellung von belastbaren Eingabedaten (Audits, Sensorik, Mehr-Augen-Prinzip, Standards) zum Eintrittspunkt wird auch schlechte Qualität unveränderbar. Data-Quality-by-Default ist daher Pflicht.

Wo Blockchain im Nachhaltigkeitskontext punktet

Im Rahmen einer Arbeitsgruppe im Fachkreis Nachhaltigkeit der DGQ haben sich mehrere Wissenschaftler:innen und Praktiker:innen zu diesem neuen, komplexen und spannenden Thema ausgetauscht. Das Ergebnis ist in einer interaktiven Datei auf DGQplus mit fachlichen wie auch praktischen Impulsen abgebildet.

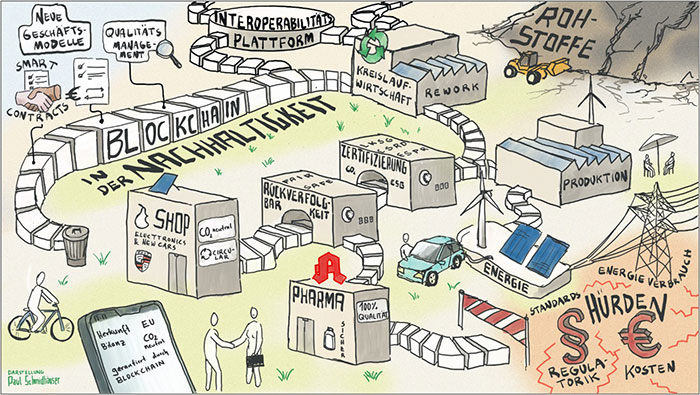

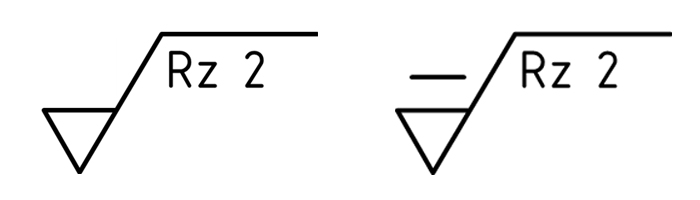

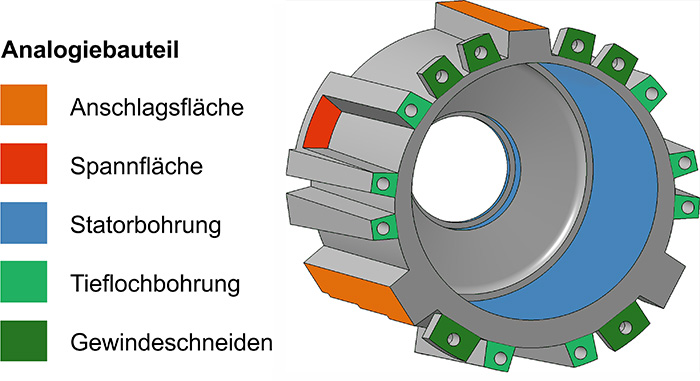

Abb. 1: Blockchain im “Alltag” (©DGQ-Fachkreis Nachhaltigkeit)

Im Rahmen der Fachkreisarbeit wurden insbesondere die Bereiche der Lieferketten-Transparenz und Herkunftsnachweise, CO₂-Bilanz und Emissionsdaten, Kreislaufwirtschaft und Produktpässe, Soziale Nachhaltigkeit und Due Diligence sowie Zertifizierung und Reporting als solche mit Potenzial der Blockchain-Anwendung identifiziert und näher betrachtet: So können etwa vom Kobalt aus zertifizierten Minen über Bio-Baumwolle bis FSC-Holz Übergabepunkte, Verarbeitungsschritte und Mengen fälschungssicher erfasst werden. Das reduziert Greenwashing-Risiken und ermöglicht Transparenz, zum Beispiel via QR-Code direkt am Produkt.

Auf das „Internet of Things“ gestützte Messwerte (etwa im Hinblick auf Scope 1–3 bei der Nachhaltigkeitsberichterstattung) können in Echtzeit „on-chain“ protokolliert, pro Produktcharge aggregiert und für Berichte ausgewertet werden. Im CO₂-Zertifikatehandel können Transaktionen als sogenannte Token, also digitale Abbilder von Werten oder Rechten auf der Blockchain, automatisch über Smart Contracts abgewickelt werden. Digitale Zwillinge bilden Materialzusammensetzung, Reparaturen und End-of-Life-Pfade ab. Token-basierte Anreizsysteme können die Rückgabe von Produkten, Komponenten oder Materialien fördern. So werden Re-Use und Recycling für Unternehmen messbar und wirtschaftlich attraktiver. On-chain Audit-Trails, digitale Identitäten und Schulungsnachweise können die Nachweisqualität in Arbeits- und Menschenrechtsfragen erhöhen. Das hilft, Human-Rights-Due-Diligence nachvollziehbar zu machen.

Und schließlich: Digitale Zertifikate (Bio, Fair Trade etc.) können manipulationssicher hinterlegt werden, Nachhaltigkeitsinformationen teilbar und für Prüfer:innen verifizierbar gemacht werden. Das könnte ein Hebel für zukünftige VSME- und CSRD-konforme Berichte sein.

Rückverfolgbarkeit als gemeinsames Fundament

Konkret verbindet Blockchain Qualitätsmanagement und Nachhaltigkeit, indem Rückverfolgbarkeit zum Fundament für Qualitäts- wie Nachhaltigkeitsnachweise wird. Sogenannte Smart Contracts automatisieren Prüfschritte, Freigaben und Reklamationsprozesse. Der kontinuierliche Verbesserungsprozess findet auf Basis valider Echtzeitdaten anstelle rückwirkender Rekonstruktion statt. Gleichzeitig gilt es, digitale Altlasten zu entsorgen. Denn wer auf manuelle Listen und Insellösungen setzt, verhindert skalierbare Nachweise und somit auch den Nutzen von Blockchain.

Die nachfolgende Tabelle zeigt den Nutzen in verschiedenen Branchen:

| Branche | Anwendung |

|---|---|

| Automotive | Teileauthentizität, Fahrzeughistorien, CO₂-Bilanz entlang Stahl/Aluminium, Smart-Charging, P2P-Energiehandel |

| Maschinenbau, Prozessindustrie | Sensorprotokolle, On-chain-Parameter (Druck/Temperatur), Emissions-Monitoring mit Grenzwert-Automatik |

| Elektronik | Echtheitszertifikate, End-of-Life-Rückverfolgung für Wertstoffe |

| Textil/Lebensmittel | Herkunft, faire Arbeit, Lot-Tracking, Rückrufmanagement, Abfallreduktion |

| Pharma/Medizin | Chargen-/Wirkstoffkontrollen, Fälschungsschutz |

Herausforderungen der neuen Technologie

Kritik an der Blockchain-Technologie zielt häufig auf den hohen Energiebedarf. Dieser wird verursacht durch das sogenannte Proof-of-Work (PoW)-Verfahren: Ein Verfahren, bei dem viele Computer schwierige Rechenaufgaben lösen müssen, um Transaktionen zu bestätigen. Das ist sehr sicher, jedoch extrem energieintensiv. Moderne Unternehmens- und Branchenlösungen setzen daher auf energieeffizientere Konsensverfahren wie „Proof-of-Stake“ – ein Verfahren, bei dem zur Transaktionsbestätigung sogenannte Coins eingesetzt werden, also eigene Kryptowährungen einer Blockchain. Dieses ist effizienter, weil kein aufwendiges Rechnen nötig ist. Alternativ wird auch das „Proof-of-Authority“-Verfahren genutzt, bei dem nur ausgewählte, geprüfte Teil-nehmende Transaktionen bestätigen dürfen. Das ist ebenfalls schnell und gleichzeitig energiearm.

Gleichzeitig entsteht durch die Blockchain-Technologie konkreter Mehrwert im Energiesektor. Herkunftsnachweise und Stromhandel ermöglichen die fälschungssichere Dokumentation sowie die direkte Vermarktung erneuerbarer Erzeugung. Zu weiteren Hürden gehören auch uneinheitliche Standards und Rechtsrahmen (einschließlich der teils fehlenden Anerkennung von Smart Contracts), praktische Implementationshemmnisse wie Anfangsinvestitionen, erforderliche IT-Reife und die Anbindung an Altsysteme sowie Wissenslücken und Akzeptanzprobleme, weil Blockchain noch oft mit Bitcoin gleichgesetzt wird. Die Konsequenz ist klar: Ohne belastbare Governance, stringentes Change-Management und eine saubere Zielarchitektur bleibt der Nutzen von Blockchain diffus.

Vorgehen bei Implementierung von Blockchain

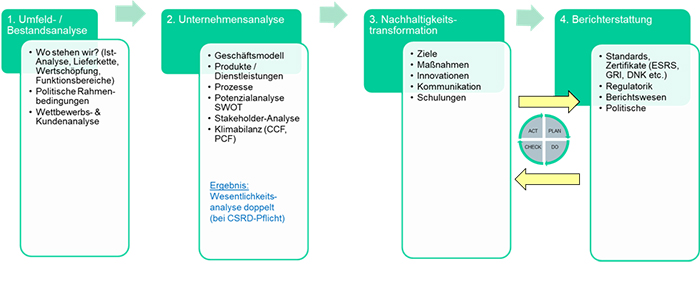

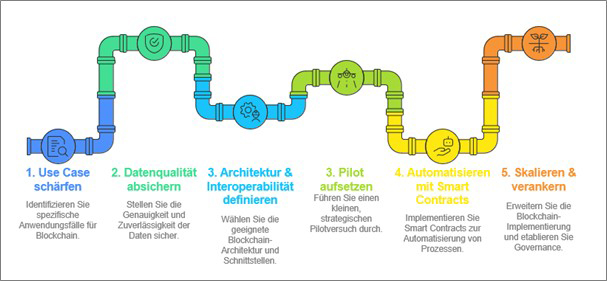

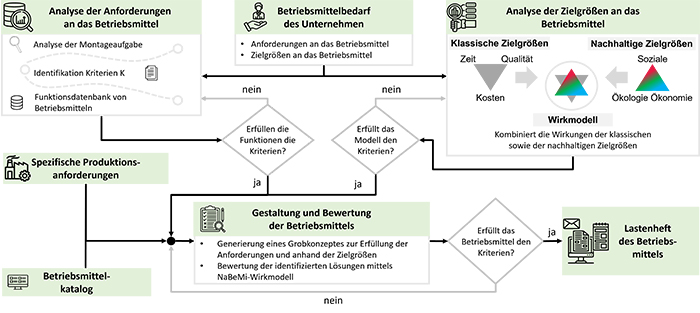

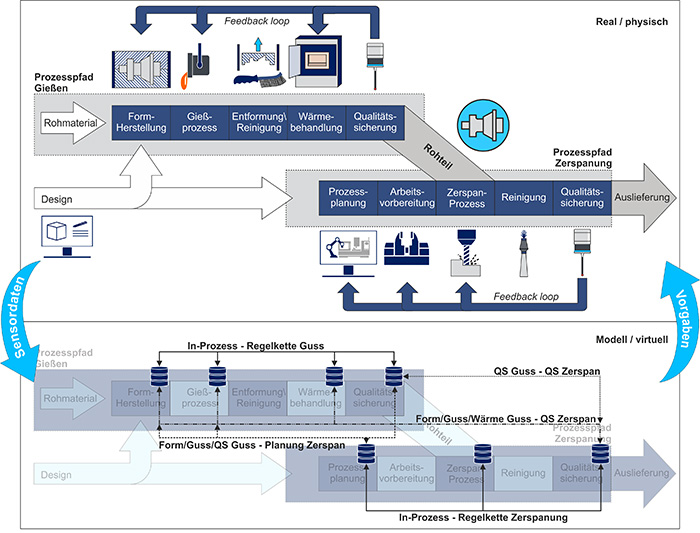

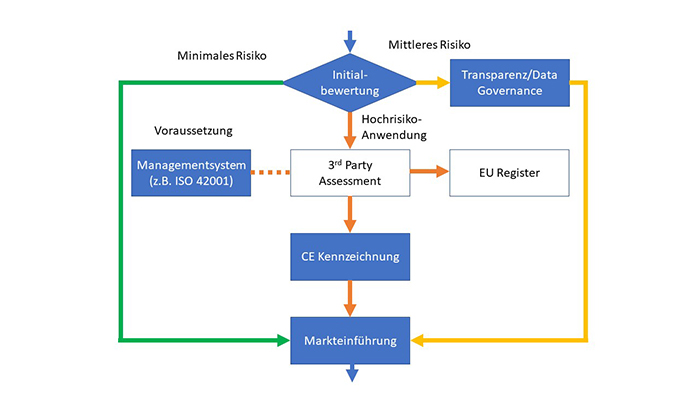

Für die Umsetzung in der Praxis ist es wichtig, dass es einen passenden Projekt-Case im Unternehmen gibt. Dieser ist daran zu erkennen, dass eine hohe Beleglast vorliegt, mit vielen Übergaben, Zertifikaten und Prüfungen, sodass Datenfehler spürbaren Schaden verursachen würden. Ihre Stärken entfaltet die Blockchain-Technologie insbesondere in verteilten Ökosystemen mit vielen Akteuren und Regionen, in denen technologiebasiertes Vertrauen skaliert. Maßgeblich ist zudem ein klarer Business-Impact durch die Nutzung der Blockchain-Technologie – messbar an geringerem Audit- und Reportingaufwand, reduzierten Rückrufkosten, höheren Rückgabequoten und einem schnelleren Time-to-Market. Auf Umsetzungsebene zählen eine energieeffiziente Architektur ohne Proof-of-Work im Enterprise-Kontext und eine nachvollziehbare Nachhaltigkeitsbilanz des IT-Stacks sowie eine interoperable Plattformstrategie, die die Anschlussfähigkeit an bestehende Brancheninitiativen und Standards sicherstellt. Abbildung 2 zeigt vereinfacht die fünf Schritte, wie bei der Umsetzung vorgegangen werden kann.

Abb. 2: Vorgehen bei Implementierung von Blockchain (©DGQ-Fachkreis Nachhaltigkeit)

Fazit

Blockchain wird zum Gamechanger, wenn sie gezielt dort eingesetzt wird, wo Integrität der Daten und Automatisierung den größten Unterschied machen, zum Beispiel in Lieferketten, bei CO₂-Bilanz, in der Kreislaufwirtschaft oder bei Zertifizierungen. Die Technologie ist jedoch kein Selbstzweck. Ihr Wert entsteht in der Verbindung aus Datenqualität, Standards, Governance und Interoperabilität. Am besten starten Unternehmen mit einem fokussierten Pilotprojekt, sichern die Datenqualität ab, automatisieren sie mit Smart Contracts und skalieren sie entlang klarer Kennzahlen. So wird aus „Hype“ prüffähige Realität und aus Nachhaltigkeits- sowie Qualitätspflichten ein Wettbewerbsvorteil.

Prof. Dr. Linda Chalupová ist Nachhaltigkeitsexpertin, Autorin und zertifizierte Aufsichtsrätin mit den Kernkompetenzen zum nachhaltigen Wirtschaften und Innovationen. Mit Ihrer Professur für Umwelt- und Nachhaltigkeitswissenschaften an der Hoch-schule Fulda strebt sie an, die Wissenschaft und Praxis voneinander profitieren zu lassen und so möglichst zügig effektive Lösungen für eine nachhaltige Entwicklung bereitzustellen. Sie engagiert sich in mehreren Arbeitsgremien, Beirats- und Vorstän-den sowie bei der DIN und ISO. Darüber hinaus ist sie Mitglied der Leitung des DGQ-Fachkreises Nachhaltigkeit. Luise Fuchs hat Oecotrophologie an der Hochschule Fulda studiert. In Ihrer Abschlussarbeit hat sie sich mit der Blockchain-Technologie und ihrem Einsatz in der Ernährungsindustrie beschäftigt. Dr.-Ing. Markus Kröll verantwortet den Geschäftsbereich „Nachhaltige Industrie“ am Fraunhofer-Institut für Produktionstechnik und Automatisierung IPA, nachdem er zu-vor bereits mehrere Jahre erfolgreich die Abteilung »Nachhaltige Produktion und Qualität« geführt hat. Gleichzeitig leitet er auch das S-TEC Zentrum für Ultraeffizienz (ZUE). Davor war er über 20 Jahre in der Automobilindustrie in verschiedenen verantwortlichen Leitungsfunktionen sowohl bei OEM als auch als Engineering Leiter bei einem Anlagenhersteller im Mittelstand tätig. Er bringt seine langjährige Praxiserfahrung und insbesondere Digitalisierungsexpertise in die Nachhaltigkeitsthemen im Produktionsumfeld ein und entwickelt mit seinem Team zielgerichtete, praxistaugliche Lösungen aller Nachhaltigkeitsfacetten für die Industrie. Dr. Bernhard Krömer, INGENIEURBÜRO DR. KRÖMER Mit über 30 Jahren Berufserfahrung, davon 25 Jahre in Führungspositionen der Industrie und fünf Jahre als Berater, sowie einer Promotion im Bereich integrierter Managementsysteme und zahl-reichen Zertifizierungen verfügt Dr. Krömer über umfassende Kenntnisse der Anforderungen von KMU und Konzernen. Er verfolgt einen ganzheitlichen, theoretisch fundierten und praxiserprobten Beratungsansatz. Seine Beratung deckt wesentliche Themenfelder wie Strategie- und Organisationsentwicklung, integrierte Managementsysteme und Qualitätsmanagement, Prozessoptimierung, KI-Management, IT-Sicherheit und Datenschutz sowie Umwelt- und Arbeitsschutz, Nachhaltigkeit und CSR ab und bietet praxisbewährte Lösungen aus einer Hand mit klarer Verantwortlichkeit. Prof. Dr.-Ing. Irina Mazilu-Eyaz ist Qualitäts- und Nachhaltigkeitsexpertin mit den Kernkompetenzen im industriellen Qualitätsmanagement und der interdisziplinären Verbindung von Technik und Nachhaltigkeit mit dem Schwerpunkt Circular Economy. In ihrer Professur für Qualitätswesen an der Hochschule Pforzheim bringt sie ihre langjährige Praxiserfahrung aus der Industrie in die Lehre ein. Zuvor war sie über elf Jahre in unterschiedlichen Funktionen im Qualitätsmanagement bei der Robert Bosch GmbH tätig. Sie engagiert sich als Vorstandsmitglied der Forschungsvereinigung Qualität e. V. (FQS) sowie in der Deutschen Gesellschaft für Qualität (DGQ), wo sie bis 2025 Teil des Leitungsgremiums des Fachkreises Nachhaltigkeit war.

Über die Autor:innen

“Circularity is no longer optional; it is an economic and societal necessity”

Juha Ylä-Autio, chief executive officer of excellence finland, explains the importance of the circular economy in an interview with DGQ. He also mentions the most important levers for the further establishment of the circular economy in Europe and the skills that employees in companies need.

Why is the circular economy no longer just “nice to have,” but strategically important for companies today?

Juha Ylä-Autio: The circular economy has moved from an environmental aspiration to a strategic business priority. Three forces drive this shift: regulatory pressure, cost volatility in materials and energy, and rapidly rising customer expectations. Companies that integrate circularity into their core business – rather than treating it as a side project – strengthen resilience, reduce dependency on scarce resources, and improve long-term competitiveness.

I have worked on circular economy issues for more than ten years, and I have seen firsthand what happens when the system breaks down: the waste mountains around cities such as Milan, Rome and other large European urban areas underline how the linear model has reached its limits. We simply cannot continue along that path. Circularity is no longer optional; it is an economic and societal necessity.

Can you share examples of companies that have already gained a competitive advantage by implementing circular economy practices?

Juha Ylä-Autio: Several Finnish and European companies demonstrate this clearly. In Finland, industrial and construction companies recovering steel, concrete and other secondary materials are already reducing costs and winning tenders because circularity is embedded in their operations. In Europe, manufacturers designing long-life, repairable and modular products benefit from recurring revenue streams through service-based business models. Their advantage comes not only from sustainability, but from efficiency, reliability and lifecycle performance.

How can the circular economy be implemented along international supply chains?

Juha Ylä-Autio: Three elements are decisive: transparency, standardization and collaboration. International supply chains must evolve from transactional steering to data-driven partnerships. Digital traceability – material passports, lifecycle data and harmonised reporting – allows companies to understand where materials originate and where they end up. When key suppliers share data and commit to joint improvement targets, circular practices become scalable across borders.

What are the most significant regulatory developments at the EU level that are relevant to the circular economy?

Juha Ylä-Autio: The most influential developments are the Circular Economy Action Plan (CEAP), the Eco-design for Sustainable Products Regulation (ESPR), the revisions to the Waste Framework Directive, and the increasing pressure from taxonomy-linked disclosure requirements under CSRD. These frameworks shift responsibility upstream: design, durability, repairability and data transparency are now compliance topics. They will reshape European industries significantly before 2030.

How would you describe the current level of circular economy implementation in Finnish companies?

Juha Ylä-Autio: Finland performs strongly on strategy, innovation and collaboration, but implementation varies by sector. Large industrial companies – forestry, metal, energy and construction – have integrated circularity into investment decisions and operational processes. SMEs are motivated but uneven in practice, often due to limited resources or lack of data. The foundations are solid, but scaling and commercialization remain key challenges.

What differences do you observe across European countries? Are there any national or regional particularities?

Juha Ylä-Autio: Nordic countries lead in digitalization, regulatory readiness and cross-sector cooperation. Germany and the Netherlands are strong in industrial-scale technical solutions and market-driven circular models. Southern Europe is progressing but faces structural challenges, although regulatory pressure has accelerated movement. The key differentiator across the EU is capability: data availability, ecosystem maturity and investment capacity matter more than ambition alone.

Which political or market conditions at the EU level could facilitate or accelerate the implementation of the circular economy?

Juha Ylä-Autio: Three conditions would provide immediate acceleration:

- More harmonised standards for reporting, material passports and product requirements.

- Incentives for secondary materials, reducing barriers to reuse, repair and remanufacturing.

- Clear integration of circular criteria into public procurement. When EU markets consistently reward long-lasting and resource-efficient products, companies will scale circular investments more rapidly.

How do you see the relationship between the circular economy, quality and quality management?

Juha Ylä-Autio: Quality management is the operational backbone that makes circularity viable. Circular business models require reliable processes, stable performance and consistent data across extended value chains. Without strong quality systems, circular initiatives remain pilots; with them, they become repeatable and profitable. In many ways, circularity is fundamentally a quality challenge: designing systems that maintain value for as long as possible.

With that in mind, how are skill requirements for employees changing—and how can training, knowledge transfer or collaboration support this transition?

Juha Ylä-Autio: Skill requirements are shifting rapidly toward lifecycle thinking, systems understanding, data competence and cross-functional teamwork. Circularity is no longer the responsibility of sustainability departments alone—it affects product development, procurement, logistics, maintenance and leadership.

Training, networks and international collaboration are essential to support this transition. They help companies translate regulation into practice, build shared understanding and develop the capabilities necessary for circular business models.

After more than a decade working with circular economy themes, one conclusion is clear: the transition succeeds only when organisations build the skills and habits that make circularity part of everyday work—not an exception.

Über den Interviewpartner:

Juha Ylä-Autio ist seit 2020 Chief Executive Officer der finnischen Qualitätsgesellschaft excellence finland. Zuvor war er seit 2003 in der finnischen Schifffahrtsindustrie in verschiedenen Geschäftsführungspositionen tätig, ehe er 2011 in den Bereich der Kreislaufwirtschaft wechselte.

„Für die SAQ ist Nachhaltigkeit ein integraler Bestandteil des umfassenden Qualitätsbegriffs“

Im Interview mit der DGQ erläutert Dr. Prisca Zammaretti, Geschäftsführerin der SAQ Swiss Association for Quality, die Schweizer Sicht auf Nachhaltigkeit. Außerdem berichtet sie, in welcher Form sich die SAQ bei diesem Thema engagiert und wie sich Nachhaltigkeit und Qualität integriert denken lassen.

Welchen Stellenwert genießt „Nachhaltigkeit“ in der Schweiz?

Zammaretti: Nachhaltigkeit hat in der Schweiz einen hohen gesellschaftlichen und wirtschaftlichen Stellenwert. Öffentliche Verwaltungen, Hochschulen und zahlreiche Unternehmen berichten inzwischen systematisch über ihre Nachhaltigkeitsziele und -maßnahmen. Themen wie ESG-Standards, Transparenz in der Berichterstattung sowie Energie- und Klimapolitik haben deutlich an Bedeutung gewonnen.

Gleichzeitig zeichnen internationale Indizes ein differenziertes Bild: Während Umwelt- und Ressourcenindikatoren meist positiv ausfallen, wird die Schweizer Klimapolitik und der Übergang zu erneuerbaren Energien teilweise als zögerlich bewertet. Die aktuelle geopolitische und wirtschaftliche Lage beeinflusst zudem das Tempo der Umsetzung. Insgesamt lässt sich sagen: Das Interesse und die Aktivitäten sind groß – doch Politik und Wirtschaft stehen zunehmend unter Druck, Ambitionen weiter zu steigern und Umsetzung zu beschleunigen.

Wo steht die Schweiz im europäischen Vergleich? Gibt es nationale Besonderheiten?

Zammaretti: Die Schweiz zählt in Europa zu den Umweltvorreitern – etwa bei Luftqualität und Abfallmanagement. In der Klimapolitik bleibt sie dagegen zurück: Der Ausbau erneuerbarer Energien stagniert, und internationale Bewertungen sehen Nachholbedarf. Föderale Strukturen, wirtschaftliche Besonderheiten und ein aktiver zivilgesellschaftlicher Diskurs prägen diesen ambivalenten Situationen.

Wie wirken sich EU-Vorgaben auf die Schweiz aus? Gibt es umgekehrt Schweizer Regelungen mit Einfluss auf EU-Staaten?

Zammaretti: Die Beziehungen zwischen der Schweiz und der Europäische Union (EU) sind durch einen spürbaren Einfluss der EU auf die Schweiz und durch einen milderen Einfluss der Schweiz auf die EU gekennzeichnet.

Hinsichtlich des Einflusses der EU auf die Schweiz lässt sich feststellen: Obwohl die Schweiz kein EU-Mitgliedstaat ist, steht sie in vielen regulatorischen Feldern unter dem Druck, EU-Standards zu übernehmen. Beispiele: Im Energiebereich verhandelt die Schweiz aktuell ein Abkommen mit der EU über den Zugang zum europäischen Strommarkt („Elektrizitäts- beziehungsweise Strommarktintegration“) mit dem Ziel, die rechtliche Basis für grenzüberschreitenden Stromhandel und Netzstabilität zu schaffen.

In anderen Bereichen wie Lebensmittel- und Produktsicherheit, Forschung (zum Beispiel Programme wie Horizon Europe) sowie digitale Regulierung wirkt die EU ebenfalls direkt oder indirekt auf die Schweiz ein. Damit ergibt sich: Die Schweiz übernimmt zwar nicht automatisch sämtliche EU-Vorgaben, aber Markt- und Regelzugang sowie wirtschaftliche Verknüpfungen führen zu einer starken Orientierung an EU-Regulierung.

Zum Einfluss der Schweiz auf die EU lässt sich festhalten: Der direkte regulatorische Export der Schweiz in großem Stil in die EU ist selten. Vielmehr zeigt sich der Einfluss eher indirekt: Schweizer Unternehmen in den Bereichen Finanzdienstleistungen, Chemie und Life Sciences gelten international als Vorreiter in Standards oder Good-Practices, die in Teilen auch in der EU wahrgenommen werden. Zudem kann Schweizer Rechtsprechung oder zivilgesellschaftlicher Aktivismus — etwa Gerichtsfälle zu Menschenrechten oder Klimafragen — Impulse für EU-Debatten liefern.

Allerdings besitzen solche Impulse meist weniger normative Kraft als die EU-Regulierungen, welche auf die Schweiz wirken. Zusammenfassend kann man sagen, dass die Schweiz sich also in einer „asymmetrischen“ Beziehung zur EU befinden: Viel stärker geprägt durch EU-Regulierungen, als dass sie selbst große regulatorische Impulse in der EU setzt. Für die Schweiz ergibt sich daraus ein permanenter Balanceakt zwischen regulatorischer Anpassung und nationaler Autonomie.

Welche Bedeutung hat „Nachhaltigkeit“ für die SAQ und hat sich die Rolle in den letzten Jahren verändert?

Zammaretti: Für die SAQ Swiss Association for Quality ist Nachhaltigkeit heute ein integraler Bestandteil des umfassenden Qualitätsbegriffs. Die SAQ versteht Qualität nicht mehr bloß als Prozess‑ und Qualiätssystemoptimierer, sondern verankert Umwelt‑, Energie‑, Gesundheits‑ und Governance‑Aspekte im Sinne einer integrierten Managementperspektive.

In den letzten Jahren hat sich die Rolle der SAQ spürbar erweitert: Neben herkömmlichen Angeboten zur Prozess‑ und Managementoptimierung bietet sie zunehmend Plattformen, Weiterbildung und Zertifizierungen zu Nachhaltigkeitsthemen – etwa im Bereich Reporting oder Nachhaltigkeitsmanagement.

Damit reagiert die SAQ auf das veränderte Umfeld: Wettbewerbsfähigkeit heute hängt nicht allein von Produkt‑ und Servicequalität ab, sondern auch von der Fähigkeit einer Organisation, Nachhaltigkeitsanforderungen systematisch zu adressieren. Qualität und Nachhaltigkeit werden so miteinander verknüpft.

Mit welchen Aktivitäten engagiert sich die SAQ für dieses Thema?

Zammaretti: Die SAQ engagiert sich in vielfältiger Weise für das Thema Nachhaltigkeit:

- Sie organisiert regelmäßig Fachveranstaltungen und Tagungen — etwa rund um Themen wie Qualität und Nachhaltigkeit oder „Nachhaltigkeit bei …“ in einzelnen Branchen.

- Über ihre Tochtergesellschaft SAQ QUALICON AG und ARIAQ SA bieten sie Seminare und Zertifikatskurse zu Nachhaltigkeits- und Umweltmanagement an, unter anderem mit Modulen wie „Nicht finanzielle Berichterstattung“, „Nachhaltigkeit in der Lieferkette“ oder „Umweltmanagementsysteme“.

- Im Verbandsorgan „MQ Management und Qualität“ erscheinen Fachbeiträge zu Themen wie Klimarisiken, Nachhaltigkeit und Umweltmanagementsystemen.

- Zudem betreibt die SAQ Netzwerk und Austauschformate: Sie fördert Expertengruppen, Fachforen und Kooperationen, bietet Plattformen für den Dialog von Praxis und Wissenschaft im Bereich Qualität und Nachhaltigkeit.

Wie sieht die SAQ den Zusammenhang zwischen Qualität und Nachhaltigkeit?

Zammaretti: Die SAQ betrachtet Qualität nicht mehr nur als „Produkt- oder Prozessqualität“, sondern als ganzheitliches Managementprinzip, das Nachhaltigkeitsaspekte mit einschließt: Nachhaltigkeit ist Qualitätsdimension (zum Beispiel langfristige Produkt-/Dienstleistungsfähigkeit, Lieferkettenstabilität, Einhaltung von ESG-Kriterien). Qualitätssysteme bieten Methoden (Risikobewertung, Prozesssteuerung, PDCA-Kreis), die auch Nachhaltigkeitsziele messbar und steuerbar machen.

Wie sieht die SAQ den Zusammenhang zwischen Qualität und Nachhaltigkeit?

Zammaretti: Die SAQ sieht Qualität heute nicht mehr lediglich als Produkt‑ oder Prozessqualität, sondern als ein ganzheitliches Managementprinzip, in dem Nachhaltigkeitsaspekte systematisch verankert sind. Nachhaltigkeit wird damit zu einer integralen Qualitätsdimension – beispielsweise durch die langfristige Leistungsfähigkeit von Produkten und Dienstleistungen, Lieferkettenstabilität oder die Einhaltung von zum Beispiel ESG‑Kriterien.

Qualitätssysteme liefern hierfür bewährte Methoden: Risikobewertung, Prozesssteuerung und der klassische PDCA‑Zyklus (Plan‑Do‑Check‑Act) ermöglichen es, Nachhaltigkeitsziele messbar zu machen und kontinuierlich zu verbessern. In diesem Sinne verbindet die SAQ traditionelle Qualitätswerkzeuge mit den Anforderungen einer nachhaltigen Unternehmensführung.

Wäre es aus Ihrer Sicht sinnvoll, Nachhaltigkeitsaufgaben im Qualitätsmanagement anzusiedeln oder ist es besser, eine eigene Abteilung innerhalb der Organisation vorzusehen?

Zammaretti: Aufbauend auf dem Verständnis der SAQ lässt sich folgendes formulieren: Nachhaltigkeit sollte im Top‑Management fest verankert und strategisch mit der Unternehmensführung verbunden sein. Gleichzeitig empfiehlt sich eine enge operative Verknüpfung mit dem Qualitätsmanagement – Prozesse, Audits und Kennzahlen im QM bieten bewährte Mechanismen zur Steuerung von Nachhaltigkeitszielen.

Ein Hybridmodell erweist sich daher als besonders geeignet: Das QM übernimmt die Systematik, Implementierung und Kontrolle; eine eigene Nachhaltigkeitsfunktion oder ein „Center of Excellence“ verleiht tieferes Fachwissen (zum Beispiel Klimabilanzen, Lebenszyklusanalysen, ESG‑Reporting) und adressiert Stakeholder‑ sowie Kommunikationsaspekte.

In kleinen und mittleren Unternehmen (KMU) kann das Qualitätsmanagement gleichzeitig „Home‐base“ für Nachhaltigkeit sein; bei größeren oder komplexeren Organisationen spricht vieles dafür, eine dedizierte Nachhaltigkeitseinheit einzurichten, die eng mit dem QM verzahnt ist.

Welche Kompetenzen sind wichtig, um Nachhaltigkeitsanforderungen zu erfüllen?

Zammaretti: Um heutigen Nachhaltigkeitsanforderungen gerecht zu werden, müssen Fach‑ und Führungskräfte eine Reihe von Kompetenzen entwickeln – sowohl operativ als auch strategisch.

- System‑ und Prozessdenken: Die Fähigkeit, komplexe Systeme zu überblicken, Prozesse zu vernetzen und Nachhaltigkeitskriterien in Managementsysteme einzubinden.

- Fachwissen zu ESG‑Standards und Regulierung: Kenntnis von EU‑ und nationalen Vorgaben (zum Beispiel CSRD/ESRS), Rechtsprechung und Reportinganforderungen.

- Datenanalyse und Reportingkompetenz: Beherrschung von Datenerhebung, KPI‑Design, Validierung und Berichterstattung (zum Beispiel ESG, GRI).

- Lifecycle‑ und Umweltbewertung (LCA): Lebenszyklusanalysen von Produkten oder Dienstleistungen, Bewertung ökologischer Auswirkungen.

- Risikomanagement und Due Diligence: Erkennen und Steuern von Lieferketten‑, Klimarisiken und rechtlichen Risiken im Nachhaltigkeitskontext.

- Interne Audits und Assurance: Prüfen, Nachweisführung und gegebenenfalls externe Verifikation von Nachhaltigkeitsprozessen.

- Stakeholder‑Engagement und Kommunikation: Dialog mit Mitarbeitenden, Kund:innen, Behörden und Investoren; überzeugende Darstellung von Nachhaltigkeitszielen.

- Change‑ und Projektmanagement: Umsetzung von Nachhaltigkeitsmaßnahmen, Förderung eines Kulturwandels, Schulung und Mobilisierung.

- Digitale Kompetenz und Datenanalyse: Einsatz digitaler Tools, Monitoring‑Systeme und Traceability zur Steuerung von Nachhaltigkeitsprozessen.

Viele dieser Kompetenzen finden sich bereits im klassischen Qualitätsmanagement‑Werkzeugkasten. Doch die heutigen Anforderungen erfordern eine Erweiterung – etwa mit ESG‑Reporting‑Experten oder LCA‑Spezialist:innen.

Über die Interviewpartnerin:

Seit 2021 steht Prisca Zammaretti als CEO an der Spitze der Swiss Association for Quality SAQ und prägt deren strategische Ausrichtung. Zuvor sammelte sie über mehrere Jahre hinweg umfassende Führungserfahrung in Schlüsselbereichen wie Quality & Regulatory sowie in der Entwicklung von Medizinprodukten, Lebensmitteln und Pharma. Ihre Laufbahn vereint tiefes Fachwissen mit unternehmerischem Weitblick – eine Kombination, die sie zu einer anerkannten Gestalterin macht.

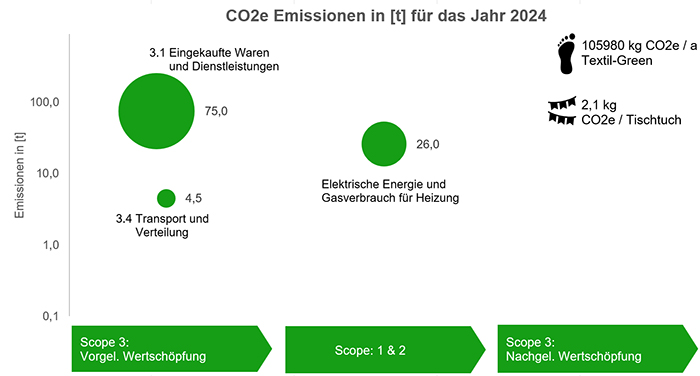

Corporate Carbon Footprint und die Bilanzierung von Emissionen

Immer mehr Unternehmen stehen vor der Herausforderung, ihre Treibhausgasemissionen transparent zu erfassen und zu reduzieren. Der Corporate Carbon Footprint (CCF) liefert dafür die entscheidende Grundlage. Wichtig ist eine präzise Datenerhebung über alle Emissionsquellen hinweg, die Nutzung etablierter Standards wie das Greenhouse Gas Protocol (GHG Protocol) sowie eine kontinuierliche Aktualisierung der Bilanz. Wer den CCF als strategisches Steuerungsinstrument versteht, schafft Transparenz, vermeidet Greenwashing und stärkt zugleich die eigene Wettbewerbsfähigkeit und Klimastrategie.

In Zeiten des Klimawandels gewinnt die Bilanzierung von Emissionen zunehmend an Bedeutung. Politisch maßgeblich ist dabei auch für den Corporate Carbon Footprint das Pariser Klimaabkommen. 2015 wurde es von nahezu allen Staaten der Welt unterzeichnet. Es verpflichtet die Vertragsstaaten, die Erderwärmung auf deutlich unter 2 °C, möglichst aber auf 1,5 °C gegenüber dem vorindustriellen Niveau zu begrenzen. Dieses sogenannte 1,5-Grad Ziel gilt als wissenschaftlich fundiert und ist häufig die Grundlage von Klimazielen. Eine Erderwärmung um 1,5 Grad würde zwar immer noch erhebliche Auswirkungen haben, aber diese wären deutlich weniger katastrophal als eine Erwärmung von zwei Grad oder mehr.

EU: Klimaneutral bis 2050

Die Europäische Union hat diese Vorgaben in ambitionierte eigene Klimaziele übersetzt: Bis 2030 sollen die Netto-Treibhausgasemissionen um mindestens 55 Prozent gegenüber 1990 reduziert werden („Fit for 55“), bis 2050 strebt die EU sogenannte Klimaneutralität an. Für 2040 ist zusätzlich ein Zwischenziel auf eine Reduktion der Netto-Treibhausgasemissionen um 90 Prozent angedacht (Stand der Information 24.11.2025). Allerdings ist es hierbei möglich, fünf Prozentpunkte durch Kompensationsprojekte auszugleichen und impliziert ein effektives Reduktionsziel von nur 85 Prozent. Die Ziele für 2030 und 2050 sind durch das EU-Klimagesetz bereits rechtlich verbindlich und beeinflussen zunehmend die regulatorischen Rahmenbedingungen in Europa.

Für viele Unternehmen wird dadurch die systematische Erfassung von Emissionen zu einer regulatorischen und marktrelevanten Anforderung. Kunden, Banken, Investoren erwarten belastbare Klimadaten, die mit hoher Qualität erfasst werden. Der Corporate Carbon Footprint ist dabei das zentrale Instrument, um die Auswirkungen von Unternehmen auf den Treibhausgaseffekt zu messen.

Was ist der Corporate Carbon Footprint (CCF)?

Der Corporate Carbon Footprint, auf Deutsch oft als „unternehmensbezogener CO₂ -Fußabdruck“ bezeichnet, meint die Gesamtheit der Treibhausgasemissionen, die direkt oder indirekt durch Aktivitäten, zum Beispiel durch ein Unternehmen, verursacht werden. Neben dem klimaschädlichen CO₂ gibt es noch weitere Gase, die zum Treibhausgaseffekt beitragen. Diese Emissionen werden in CO₂-Äquivalenten (CO₂e) erfasst, um die verschiedenen Treibhausgase einheitlich messbar zu machen.

Der CCF berücksichtig dabei nicht nur die direkten Emissionen eines Unternehmens, wie sie beispielsweise am eigenen Standort entstehen, sondern auch indirekte Emissionen, die entlang der gesamten Wertschöpfungskette anfallen.

Wichtige Aspekte bei der Bilanzierung von Emissionen sind „Datenerfassung und -qualität“, „Grenzen der Bilanzierung festlegen“, „Standardisierte Methoden und Vorgehensweisen“ sowie „Kontinuierliche Überprüfung und Verbesserung“.

Datenerfassung und -qualität:

Eine präzise Bilanzierung von Emissionen setzt eine umfassende und genaue Datenerfassung voraus. Hierbei ist es wichtig, sowohl die direkten als auch die indirekten Emissionen zu berücksichtigen. Die Qualität der Daten spielt eine entscheidende Rolle, da ungenaue oder unvollständige Daten zu fehlerhaften Ergebnissen führen können.

Grenzen der Bilanzierung (Scope) festlegen:

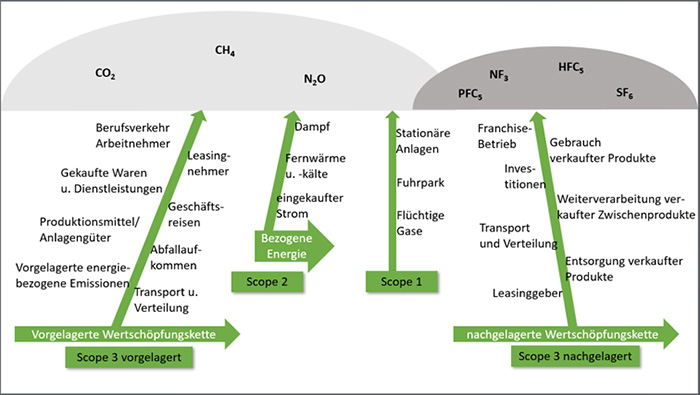

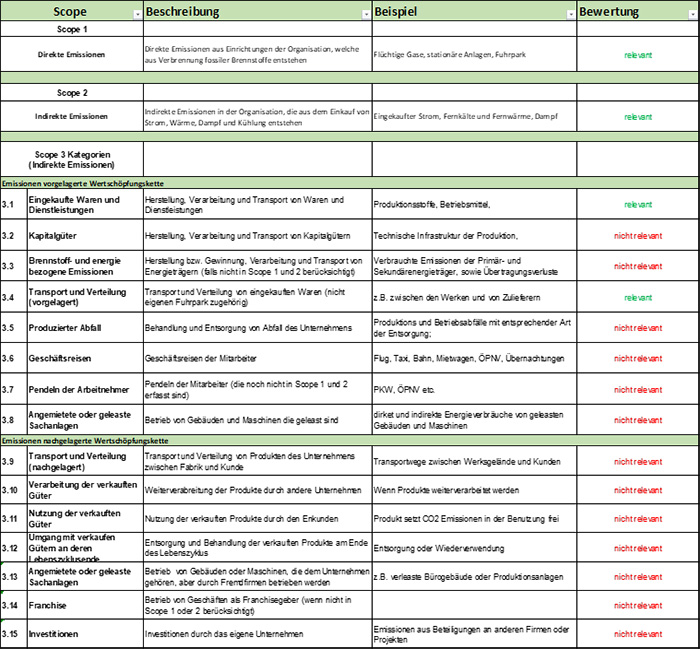

Bei der Bilanzierung von Emissionen ist es wichtig, klare Systemgrenzen zu definieren und diese auch zu dokumentieren. Dies umfasst die Festlegung, welche Emissionen in die Bilanz einfließen. Hierbei wird häufig zwischen Scope 1, Scope 2 und Scope 3 Emissionen unterschieden:

- Scope 1: Direkte Emissionen aus eigenen Anlagen und Fahrzeugen.

- Scope 2: Indirekte Emissionen aus dem Bezug von Energie (zum Beispiel Strom, Wärme).

- Scope 3: Alle weiteren indirekten Emissionen entlang der vor- und nachgelagerten Wertschöpfungskette (zum Beispiel durch Lieferanten, eingekaufte Güter, Transport, Nutzung und Entsorgung von Produkten).

Gerade Scope-3-Emissionen sind oft die größte Herausforderung, da sie schon bei der Erhebung eine enge Zusammenarbeit mit Lieferanten und Kunden erfordern.

Es ist dringend zu empfehlen, alle Scopes und alle Kategorien innerhalb der Scopes in der Bilanzierung zu berücksichtigen, da es kein standardisiertes Wesentlichkeitsprinzip gibt. Ein Auslassen von teils relevanten Emissionen würde zu Greenwashing führen.

Standardisierte Methoden und Vorgehensweisen:

Um eine transparente und einheitliche Vorgehensweise bei der Bilanzierung von Emissionen in Form eines CCF zu gewährleisten, sollten standardisierte Methoden verwendet werden. Das Greenhouse Gas Protocol (GHG Protocol) und die ISO 14064 Normenreihe gelten als bekannteste Standards in diesem Bereich. Sie bieten Unternehmen einen Orientierungsrahmen für die Erfassung und Berechnung von Emissionen. Möchte man einen CCF für sein Unternehmen berechnen, ist es ratsam, sich vor dem Beginn mit diesen Standards vertraut zu machen. Sie dienen nicht nur als Rahmenwerk, sondern auch als Leitfaden, um bei der Erstellung eines CCF zu unterstützen.

Dennoch ist es in diesem Kontext wichtig, zu beachten, dass auch diese anerkannten Standards einigen Raum für gewisse Anpassungen und Interpretationen offenlassen. Beispielsweise sind keine Schwellenwerte festgelegt, ab wann Emissionen von Unternehmen als „relevant“ einzustufen und zu berücksichtigen sind. Des Weiteren gibt es keine Vorgaben zur Nutzung einer einheitlichen Datenbank und einheitlicher Emissionsfaktoren. Dies kann je nach Qualität und wissenschaftlicher Evidenz der herangezogenen Daten, gravierende Unterschiede bei den Berechnungsergebnissen zur Folge haben. Trotz der Nutzung einheitlicher Rahmenwerke ist dann eine Vergleichbarkeit von CCF-Daten mehrerer Unternehmen nicht möglich.

Kontinuierliche Überprüfung und Verbesserung:

Die Bilanzierung von Emissionen ist kein einmaliger Prozess, sondern sollte kontinuierlich überprüft und verbessert werden. Dies umfasst die regelmäßige Aktualisierung der Datengrundlagen und die Anpassung der Methoden an neueste wissenschaftliche Erkenntnisse und technologische Entwicklungen. Es ist ratsam, mindestens jährlich eine umfassende Aktualisierung des CCF durchzuführen. Auf diese Weise liegen stets die aktuellen Daten vor. Zudem lässt sich der Erfolg von umgesetzten Klimaschutzmaßnahmen im Vergleich zu den Vorjahren bewerten.

Durch den CCF die Wettbewerbs- und Zukunftsfähigkeit stärken

Der Corporate Carbon Footprint ist der Schlüssel, um die klimatischen Auswirkungen eines Unternehmens zu verstehen und wirksam zu reduzieren. Auch wenn Ergebnisse aufgrund unterschiedlicher Berechnungsmethoden, Datenbanken und Systemgrenzen nicht vergleichbar sind, liefern sie wertvolle Ansätze für interne Reduktionsstrategien. Wer frühzeitig in ein fundiertes und systematisches Klimamanagement investiert, schützt nicht nur das Klima, sondern stärkt auch seine Wettbewerbs- und Zukunftsfähigkeit.

Über den Autor:

Yannic von Raesfeld ist Leiter des Nachhaltigkeitsmanagements der Werner & Mertz Gruppe. Dabei befasst er sich seit über 10 Jahre intensiv mit strategischer Nachhaltigkeit, sowie den Managementsystemen nach EMAS, ISO 14001 und der ISO 50001. Er ist Beauftragter für das Umwelt-, Energie-, und Lieferkettenmanagement an mehreren Standorten, sowie interner Auditor. Als zertifizierter ESG-Officer koordiniert er die Umsetzung regulatorischer Nachhaltigkeitsvorgaben. Darüber hinaus ist Yannic von Raesfeld als Dozent und Trainer im ESG-Bereich unterwegs.

Europäische Lieferketten-Richtlinie: Für was steht CSDDD und wie kann das deutsche LkSG helfen?

Die geplante Corporate Sustainability Due Diligence Directive (CSDDD) verpflichtet Unternehmen in der EU künftig, entlang ihrer gesamten Lieferkette Sorgfaltspflichten in Bezug auf Menschenrechte und Umweltstandards systematisch umzusetzen. Die finale Ausgestaltung wird derzeit noch in Brüssel verhandelt. Bereits jetzt zeichnet sich ab: Unternehmen, die bereits nach dem deutschen Lieferkettensorgfaltspflichtengesetz (LkSG) arbeiten, haben einen klaren Startvorteil.

Von national zu europäisch – Wann tritt die CSDDD in Kraft?

Während das LkSG heute vorrangig deutsche Unternehmen mit mehr als 1.000 Mitarbeitenden erfasst, soll die europäische CSDDD künftig EU-weit gelten, allerdings mit deutlich höheren Schwellenwerten im Anwendungsbereich. Laut dem Mitte Oktober 2025 vom Rechtsausschuss des EU-Parlaments angenommenen Kompromissvorschlag zwischen Konservativen, Liberalen und Sozialdemokraten zum sogenannten „Nachhaltigkeits-Omnibus“ soll die CSDDD zunächst für Unternehmen mit mehr als 5.000 Mitarbeitenden und einem Jahresumsatz von über 1,5 Milliarden Euro ab dem Jahr 2028 gelten. Die gleiche Umsatzschwelle gilt auch für Nicht-EU-Unternehmen.

Keine EU-weite zivilrechtliche Haftung mehr

Gegenüber der ursprünglichen Fassung wurden zentrale Inhalte abgeschwächt: Die Sorgfaltspflichten sollen sich nach einem vollständig risikobasierten Ansatz richten. Eine ursprünglich geplante EU-weite zivilrechtliche Haftung ist nicht mehr vorgesehen. Die Pflicht zur Aufstellung von Klimatransitionsplänen innerhalb der CSDDD soll ebenfalls entfallen. Auf Basis dieses Kompromisses laufen aktuell die Trilogverhandlungen zwischen EU-Kommission, Parlament und Rat. Ein Abschluss wird bis Ende 2025 angestrebt. Anschließend folgt die nationale Umsetzung in den Mitgliedstaaten. (Stand der Informationen 24.11.2025)

LkSG als Übergangslösung bis CSDDD

Die anstehenden Trilogverhandlungen und die Entwicklungen um die CSDDD werden auch in Deutschland genau verfolgt. Am 17. Oktober 2025 hat der Bundesrat bereits den Regierungsentwurf zur Änderung des LkSG beraten und passieren lassen. Neben der Aussetzung der Berichtspflicht nach dem LkSG sieht dieser Regierungsentwurf auch die Anpassung des Geltungsbereichs und die Fokussierung auf eine risikobasierte Priorisierung analog der CSDDD vor. Das modifizierte LkSG soll als Übergangslösung bis zur vollständigen Überführung der CSDDD in nationales Recht gelten. Die Anpassung des Gesetzes soll den bürokratischen Aufwand für deutsche Unternehmen reduzieren und gleichzeitig den Übergang zur CSDDD erleichtern.

LkSG als Übungsfeld für künftige EU-Anforderungen

Für viele Unternehmen fungiert das LkSG bereits als praxisnahes Trainingsfeld. Vollständige Lieferantenstammdaten, Risikoanalysen, Beschwerdemechanismen und Präventionsmaßnahmen gehören heute bereits beim LkSG zum Pflichtprogramm. Wer diese Prozesse bereits etabliert, schafft gleichzeitig die Grundlage für die künftigen europäischen Anforderungen.

ESG konforme Beschaffungsprozesse als Schlüssel

Für Unternehmen wird die Beschaffung zur zentralen Stellschraube, wenn es um die Erfüllung der Anforderungen von Lieferkettengesetzen geht. ESG-Kriterien (Environmental, Social, Governance) müssen künftig systematisch in Einkaufs- und Lieferantenprozesse integriert werden.

Die Auswahl von Lieferanten sollte künftig nicht mehr ausschließlich auf Basis finanzieller, qualitativer oder logistischer Kriterien erfolgen. Vielmehr gewinnen ökologische und soziale Aspekte zunehmend an Bedeutung, sowohl im Rahmen des LkSG als auch im Hinblick auf die kommende CSDDD. Bereits im Auswahlprozess lassen sich durch gezielte Anforderungen an Umwelt- und Sozialstandards potenzielle Risiken frühzeitig minimieren.

Überprüfung von Lieferanten anhand von CSDDD und LkSG

Ein bewährter Ansatz ist die Integration entsprechender Kriterien in Lieferantenfragebögen sowie die Forderung nach verpflichtenden Mindeststandards, etwa in Form von Umwelt- oder Sozialzertifizierungen (zum Beispiel ISO 14001, SA8000). Darüber hinaus sollte geprüft werden, ob potenzielle Geschäftspartner über eigene Prozesse und Strukturen zur Einhaltung menschenrechtlicher und umweltbezogener Sorgfaltspflichten verfügen, sowohl im eigenen Unternehmen als auch entlang ihrer eigenen Lieferkette.

Besonderes Augenmerk verdient die Risikoeinstufung nach Länder- und Branchenspezifika. Aus Sicht des Risikomanagements kann es sinnvoll sein, bevorzugt mit Zulieferern aus Regionen zusammenzuarbeiten, in denen bereits ein robuster gesetzlicher Rahmen für Umwelt- und Menschenrechte besteht.

Erfahrung aus Managementsystemen nutzen

Gerade bei der Auswahl von neuen – und der Bewertung von bestehenden Lieferanten können Expertinnen und Experten aus dem Bereich Managementsysteme mit ihrer Erfahrung in strukturierten Bewertungs- und Auditprozessen einen wertvollen Beitrag leisten. So wird die Beschaffung nicht nur regulatorisch compliant, sondern auch zu einem Hebel für nachhaltige Wertschöpfung und Resilienz.

Qualität von Lieferantenstammdaten sind essenziell

Die Qualität der Lieferantenstammdaten ist ein entscheidender Erfolgsfaktor für ein funktionierendes Lieferkettenmanagement. Nur wenn grundlegende Informationen, insbesondere zum Land und zur Branche eines Lieferanten, korrekt und vollständig vorliegen, lässt sich eine belastbare erste Risikoabschätzung vornehmen. Diese beiden Parameter sind essenziell, um potenzielle menschenrechtliche und ökologische Risiken entlang der Lieferkette frühzeitig zu identifizieren und geeignete Präventions- oder Abhilfemaßnahmen zu planen.

Ein systematischer Aufbau und die kontinuierliche Pflege dieser Stammdaten schaffen die notwendige Transparenz, um sowohl den Anforderungen des LkSG als auch der künftigen CSDDD gerecht zu werden.

Risikomanagement als Hebel für Lieferkettenstrategie

Ein wirksames Risikomanagement bildet das Herzstück einer nachhaltigen Lieferkettenstrategie. Es ermöglicht Unternehmen, potenzielle menschenrechtliche und umweltbezogene Risiken systematisch zu identifizieren, zu bewerten und zu priorisieren. Grundlage dafür sind strukturierte Prozesse zur Risikoanalyse, die regelmäßig aktualisiert und an neue Erkenntnisse angepasst werden müssen. Zur Durchführung einer fundierten Risikoanalyse von Lieferanten kann der Einsatz systemischer und automatisierter Lösungen entscheidend sein. Digitale Tools und Plattformen ermöglichen es, große Datenmengen effizient zu verarbeiten, Risiken anhand definierter Kriterien wie Branche, Herkunftsland oder Unternehmensstruktur zu bewerten und kontinuierlich zu überwachen.

Besonders im Rahmen des LkSG und der künftigen CSDDD ist es entscheidend, dass Unternehmen nicht nur auf bekannte Risiken reagieren, sondern auch proaktiv präventive Maßnahmen entwickeln. Dazu gehören die Einbindung relevanter Stakeholder, die Definition klarer Verantwortlichkeiten und der Aufbau einer Compliance-Struktur, die insbesondere die Zusammenarbeit mit Geschäftspartnern in den Fokus nimmt.

Frühzeitige Vorbereitung auf CSDDD und LkSG sinnvoll

Obwohl die CSDDD noch nicht final verabschiedet ist, sollten Unternehmen bereits frühzeitig mit der Vorbereitung beginnen. Die Erfahrungen aus der Umsetzung des LkSG zeigen: Auch Firmen, die formal nicht unter den Anwendungsbereich des Gesetzes fallen, wurden von größeren Kunden dazu verpflichtet, vergleichbare Anforderungen umzusetzen und diese wiederum an ihre eigenen Lieferanten weiterzugeben. Wer die Anforderungen des LkSG nicht nur formal erfüllt, sondern als Chance zur Weiterentwicklung nutzt, kann die kommenden europäischen Pflichten souverän und effizient meistern und gleichzeitig seine Resilienz in globalen Lieferketten stärken.

Über den Autor:

Yannic von Raesfeld ist Leiter des Nachhaltigkeitsmanagements der Werner & Mertz Gruppe. Dabei befasst er sich seit über 10 Jahre intensiv mit strategischer Nachhaltigkeit, sowie den Managementsystemen nach EMAS, ISO 14001 und der ISO 50001. Er ist Beauftragter für das Umwelt-, Energie-, und Lieferkettenmanagement an mehreren Standorten, sowie interner Auditor. Als zertifizierter ESG-Officer koordiniert er die Umsetzung regulatorischer Nachhaltigkeitsvorgaben. Darüber hinaus ist Yannic von Raesfeld als Dozent und Trainer im ESG-Bereich unterwegs.

Neugründung des Fachausschusses „Qualität in der Pflege“

Der DGQ-Fachausschuss „Qualität in der Pflege“ wird neu positioniert. Mit dieser Neuausrichtung verfolgt die DGQ das Ziel, sich als zentrale Plattform für den bundesweiten Qualitätsdiskurs in der Pflege weiter zu etablieren und den Austausch über zukunftsweisende Qualitätsansätze zu fördern.

Fokus auf integrierte Sicht der Qualität in der Pflege

Der Fachausschuss übernimmt eine beratende Rolle innerhalb der DGQ und soll Impulse für eine integrierte und ganzheitliche Sichtweise auf die Qualität in der Pflege liefern. Im Mittelpunkt steht ein regelmäßiger Austausch, der die unterschiedlichen Perspektiven und Erwartungen innerhalb der Pflege zusammenführt.

Eingebunden werden Vertretungen von Pflegeempfangenden sowie deren An- und Zugehörige, Leistungserbringende und -träger, Akteure aus Forschung, Wissenschaft und Lehre sowie Verbände, die sich in den Diskursen zu Nachhaltigkeit und Digitalisierung mit Bezug zur Pflege engagieren. Ziel ist die Einbeziehung der unterschiedlichen Sichtweisen, um aus dieser Position den gesellschaftlichen Diskurs zur Qualität in der Pflege maßgeblich mitzugestalten.

Erwartete Wirkung

Durch die Neupositionierung soll der Fachausschuss wesentlich zur Schärfung des DGQ-Profils im Themenfeld „Qualität in der Pflege“ beitragen. Er dient als Kompetenzforum und Impulsgeber mit dem Anspruch, Brücken zwischen Praxis, Wissenschaft, Politik und Gesellschaft zu schlagen. Zudem soll er den Qualitätsdiskurs in der Pflege aktiv lenken und weiterentwickeln – mit dem Ziel, Orientierung zu geben, Entwicklungen anzustoßen und Innovationsräume zu öffnen. Gleichzeitig trägt der Fachausschuss dazu bei, die Attraktivität des einzigartigen DGQ-Netzwerks zu steigern und neue Interessierte für den Qualitätsdiskurs zu gewinnen.

Die konstituierende Sitzung ist am 9. Februar 2026 in Berlin geplant.

Digitalisierung und KI im Qualitätsmanagement – Herausforderungen und Erwartungen in der Praxis

Künstliche Intelligenz, Automatisierung und regulatorische Anforderungen stellen Qualitätsverantwortliche vor neue Herausforderungen im Managementsystem – aber auch vor große Chancen. Im Interview berichtet Qualitätsmanagementexperte Dr. Wilhelm Griga über die Entwicklungen im QM, die praktischen Auswirkungen auf QM-Prozesse und welche Rolle die Revision der Norm ISO 9001 spielt.

Digitalisierung verändert viele Geschäftsbereiche – wie sehen Sie konkret die Auswirkungen auf klassische Qualitätsmanagementsysteme oder auch integrierte Systeme in der Praxis?

Griga: Die Digitalisierung verändert auch das Qualitätsmanagement grundlegend. Klassische, eher statische Systeme entwickeln sich zu dynamischen, datengetriebenen. Konkret bedeutet das, dass der Trend weg von Handbüchern und hin zu cloudbasierten, lebendigen und nachverfolgbaren Systemen geht. Dabei ist es sinnvoll, agile Prinzipien und iterativer Zyklen in das QM-System zu integrieren, um für schnelle Marktveränderungen gewappnet zu sein.

Zunehmend werden auch Remote- und KI-gestützte-Audits für datenbasierte, effiziente, effektive Prüfung und Verbesserung angewendet. Die Unternehmen setzen zudem auf Process Mining im Rahmen des Prozessmanagements zur Analyse aller Transaktionen in kurzer Zeit, um Optimierungspotenziale aufzudecken.

Predictive Analytics sowie KI-gestützte Dashboards helfen darüber hinaus dabei, Risiken und negative Trends proaktiv zu identifizieren. Das Managementsystem wird somit zunehmend zum „digitalen Betriebssystem der Organisation“, welches agil mit zielorientierter Flexibilität und Kundenorientierung weiterentwickelt wird.

Wo sehen Sie die größten Potenziale beim Einsatz von Künstlicher Intelligenz in QM-Prozessen?

Griga: Generell besteht das größte KI-Potential in der Unterstützung bei einfachen, administrativen Tätigkeiten im Qualitätsmanagement und bei repetitiven, strukturierten Tätigkeiten in der Qualitätssicherung. Nehmen wir zum Beispiel die Gap-Analyse. KI hilft (Norm-)Anforderungen mit bestehenden Prozessen abzugleichen und Abweichungen zu identifizieren.

Das Reklamationsmanagement kann durch Text-, Sprach-, Sentimentanalysen und KI-Agenten bei der Priorisierung und Bearbeitung von Kundenbeschwerden unterstützt werden. Bei der Qualitätsprüfung erhöhen Bildverarbeitung und Mustererkennung mit KI die Genauigkeit und Zuverlässigkeit. Autonome Systeme können sogar Qualität in Echtzeit überwachen und in Teilbereichen nachregeln.

Und wenn es um Audit-Unterstützung geht, erleichtert KI die Auswertung von Daten und Interviews, schlägt basierend auf früheren Erkenntnissen Auditmaßnahmen vor und vereinfacht die Erstellung von Auditberichten.

Kommen wir nun zu den Risiken. Die gibt es doch sicher auch?

Griga: Die KI ist nur so gut wie ihre Datenbasis. KI muss fair entscheiden und Diskriminierung vermeiden. Black-Box-Modelle erschweren dabei die Nachvollziehbarkeit. Die KI kann Fehler machen und übernimmt keine Verantwortung für Entscheidungen. KI-Systeme und Daten müssen grundsätzlich gegen Angriffe und Manipulation geschützt werden. Deshalb gilt: KI darf nicht blind vertraut werden, menschliche Fachkompetenz und Verantwortung bleiben unverzichtbar. Eine KI dient dem Menschen und nicht umgekehrt.

Welche regulatorischen Entwicklungen – etwa im Bereich Informations- und Cybersicherheit – sind aus Ihrer Sicht besonders relevant für den Alltag als Qualitätsmanager?

Griga: Die NIS2-Richtlinie erhöht die Anforderungen an Cybersicherheit für kritische Infrastrukturen und viele Industrieunternehmen. Betroffene Unternehmen müssen dies in ihren QM-Systemen stärker berücksichtigen.

Der EU AI Act ist hier ebenfalls zu nennen. Er beinhaltet wichtige Vorgaben für KI nach Risikoklassen. Für Qualitätsmanager kann das bedeuten, dass das Qualitätsmanagementsystem besondere Anforderungen erfüllen muss.

Diese Entwicklungen führen dazu, dass das Qualitätsmanagement sich mehr mit Fragen zu IT-Sicherheit, Datenschutz und Compliance beschäftigen muss, auch wenn die Verantwortung in anderen Unternehmensbereichen liegt.

Viele Organisationen tun sich schwer mit der Integration digitaler Tools in bestehende QM-Strukturen. Welche strategischen Erfolgsfaktoren sehen Sie für eine gelungene Transformation?

Griga: Aus meiner Sicht ist Digitalisierung ein Prozess und kein Projekt – über Ziele und Eckpunkte sollte Konsens vorhanden sein. Auf Basis agiler Prinzipien empfiehlt es sich, bei der Umsetzung klein zu starten, schnell zu lernen, zu verwerfen oder zu skalieren.

Kompetenzmanagement, Einbindung, Offenheit, Transparenz, Wertschätzung und Respekt sind dann einige der Punkte, die für erfolgreiches Change-Management stehen. Digitale Transformation und Agilität leben dabei von Vorbildern im Sinne von „Walk the talk“ und von selbstorganisierenden Teams, die schnelle Anpassungen ermöglichen. Iterative Zyklen von „Plan, Do, Check, Act“ sind hierbei auf allen Unternehmensebenen von Vorteil.

Digitale Transformation gelingt insbesondere dann, wenn Technik, Organisation und Kultur gemeinsam weiterentwickelt werden – dabei sollte das QMS über reine Compliance-Absicherung hinausgehen und eine qualitätsorientierte, agile, innovative Kultur ermöglichen.

Im kommenden Jahr wird die ISO 9001:2026 veröffentlicht. Was sind für Sie entscheidende Änderungen?

Griga: Die Revision bringt voraussichtlich einige wichtige Neuerungen, die ich sehr begrüße. Themen wie Klimawandel, Emerging Technologies – beispielsweise KI – und ethisches Verhalten werden explizit adressiert. Die Förderung einer Qualitätskultur und die Berücksichtigung psychologischer und sozialer Faktoren im Arbeitsumfeld stellen eine wichtige Ergänzung dar.

Die aktive Verwaltung von Organisationswissen wird verpflichtender, Nachhaltigkeit und Kundenerlebnis werden stärker im Design- und Entwicklungsprozesse berücksichtigt. Interne Audits und Managementbewertungen werden strategischer und nutzen breitere Datenquellen, zum Beispiel Social Media.

Mit welchem Gefühl und welcher Erwartung blicken Sie auf die Revision der ISO 9001?

Griga: Die Norm bietet bereits heute agile Gestaltungsoptionen und wird diese weiter ausbauen, um sowohl traditionelle als auch agile Arbeitsweisen zu unterstützen. Die Revision der ISO 9001 bedeutet mehr Agilität, Innovationsfähigkeit und Zukunftsorientierung. Sie bleibt ein stabiler Rahmen, aber mit klaren Impulsen für digitale Transformation, Nachhaltigkeit und ethische Verantwortung. In meinen Augen ist es wichtig, dass die neue ISO 9001 die Balance zwischen bewährten QM-Praktiken und neuen Anforderungen findet, um Organisationen dabei zu unterstützen, kundenorientierte Lösungen schneller und in verbesserter Qualität zu liefern.

| Informationsangebot der DGQ zur Revision der ISO 9001 Fakten statt Spekulation – unter diesem Motto hat die DGQ auf der Seite iso-9001-revision.info ein Informationsangebot rund um die Revision der ISO 9001:2026 zusammengestellt. Mit Hintergrundberichten, Interviews und Neuigkeiten zum Stand der Revision hält die DGQ alle Interessenten bereits im Vorfeld auf dem Laufenden. Ein wichtiger Bestandteil dieses Angebots bildet eine kostenlose Webinarreihe mit dem Titel „Revisions-Warm-up“. Sie vermittelt Kenntnisse über einige Kern- und Trendthemen, die eine Relevanz im Rahmen der Revision der ISO 9001 aufweisen. Mehr dazu findet sich unter iso-9001-revision.info/webinare » |

Über den Autor:

Dr. Wilhelm Griga ist Senior Quality Manager bei Siemens Digital Industries. Er ist dort unter anderem für die Themen internationale Organisationsentwicklung, digitale Transformation und agiles Managementsystem zuständig und Teil der Siemens-internen Arbeitsgruppe zur Revision der ISO 9001. Daneben gehört er zur DGQ-Regionalkreisleitung Nürnberg und ist als Dozent an der Hochschule zu Agility und Business Excellence aktiv.

Europa will Normung schneller, inklusiver und international stärker machen – Konsultationsphase gestartet

Bei der umfassenden Überarbeitung der EU-Normungsverordnung durch die Europäische Kommission hat kürzlich die Konsultationsphase begonnen. Ziel der Überarbeitung der „Verordnung (EU) Nr. 1025/2012 über die europäische Normung“ ist es, das europäische Normungssystem so weiterzuentwickeln, dass es schneller auf technologische Veränderungen reagiert, breitere Beteiligung ermöglicht und Europas Rolle in der internationalen Normung stärkt. Die Konsultationsphase endet am 17. Dezember 2025. Die Annahme durch die Kommission ist für das zweite Quartal 2026 geplant.

Hintergrund: Scope der Überarbeitung

Die Überarbeitung ist Teil des EU-Kompasses für Wettbewerbsfähigkeit 2025 und steht im Kontext der EU-Strategie für Normung von 2022. Die Kommission betont, dass Europas Wettbewerbsfähigkeit, technologische Souveränität und die Fähigkeit, eigene Werte und Interessen weltweit zu vertreten, zunehmend von seiner Rolle als globaler Normgeber abhängen.

Die Modernisierung der Normungsverordnung soll dazu beitragen, Normungsprozesse schneller und leichter zugänglich zu machen, insbesondere für kleine und mittlere Unternehmen (KMU) sowie Start-ups. Gleichzeitig verfolgt die EU das Ziel, Bürokratie abzubauen, Verfahren im Binnenmarkt zu vereinfachen und den Zugang zu Normen transparenter zu gestalten. Damit soll ein zukunftssicherer Rechtsrahmen entstehen, der die grünen und digitalen Transformationen Europas unterstützt und die rasche Entwicklung harmonisierter Normen ermöglicht.

Bestehende Strukturen als solide Basis – DGQ unterstützt die europäische Ausrichtung

Das derzeitige europäische Normungssystem (ESS) dient seit vielen Jahren als stabiler Rahmen für die Zusammenarbeit von Wirtschaft, Wissenschaft, Verwaltung und Zivilgesellschaft. Gleich-zeitig bietet es genügend Flexibilität, um auf neue technologische und regulatorische Herausforderungen zu reagieren. Dabei verfügt das ESS über ein hohes Innovationspotenzial und bietet mit seinen unterschiedlichen Formaten – von Europäischen Normen bis hin zu technischen Spezifikationen – die notwendige Vielfalt, um die regulatorischen Anforderungen der EU wirksam zu unterstützen.

„Als nationale Qualitätsorganisation unterstützt die DGQ die Bestrebungen, die europäische Normung zukunftsfähig, inklusiv und innovationsorientiert zu gestalten“, sagt Stefan Reitz, Projektmanager Normung bei der DGQ. „Normung ist ein zentraler Baustein zur Stärkung der Wettbewerbsfähigkeit von Organisationen in der Europäischen Union und leistet einen wichtigen Beitrag zur Stabilität und Weiterentwicklung des europäischen Binnenmarkts.“

Ergänzende Informationen zur Überarbeitung der Verordnung (EU) Nr. 1025/2012 finden Sie hier.

ISO/TC-176-Plenarwoche in Lima: Updates zu den Revisionen der 9000er-Normenfamilie

Die Entscheidungen über laufende Projekte und zukünftige Gremienarbeit sowie die Revisionen von ISO 9000, ISO 9001 und ISO 9002 standen im Mittelpunkt der Plenarwoche des ISO Technical Committees 176 Mitte Oktober. Die Arbeitsgruppen des für Qualitätsmanagement zuständigen Gremiums diskutierten insbesondere eine stärkere Verzahnung und Harmonisierung der Qualitätsmanagementnormen.

ISO 9001: Fortschritt in der Überarbeitung

Nach mehreren Sitzungsrunden arbeitet die zuständige Arbeitsgruppe WG 29 derzeit daran, ISO 9001 konsequenter an der Harmonized Structure der Managementsystemnormen auszurichten. Ziel ist es, die Anforderungen klarer und praxisnäher zu formulieren und gleichzeitig die Kompatibilität zu anderen Normen zu erhöhen. Ende August war der Draft International Standard (DIS) zur aktuell in Revision befindlichen ISO 9001 erschienen. Die nächste Runde zur Kommentarbehandlung findet im Januar 2026 in Mexico statt.

ISO 9000: Terminologie und Grundlagen im Zentrum

Teilnehmer aus Europa v.l.n.r. : Cedric Meunier, AFNOR (designierter Chairman TC 176), Thomas Votsmeier, DIN- und EOQ-Repräsentant, Bengt Rydsted, Repräsentant SIS Schweden

Das Unterkomitee SC 1 und seine Arbeitsgruppe 2 (WG 2) befassten sich in Lima mit den verbleibenden Kommentaren aus der DIS-Abstimmung zur ISO 9000. Eine überarbeitete Fassung wird nun für die Abstimmung des Final Draft International Standard (FDIS) vorbereitet.

Im Mittelpunkt steht dabei die Terminologie: Die neue Ausgabe der ISO 9001 wird künftig 20 Begriffe und Definitionen aus der harmonisierten Struktur der ISO enthalten, die ebenfalls in der ISO 9000 verankert sind. Damit wird die sprachliche und inhaltliche Abstimmung innerhalb der Normenfamilie weiter verbessert.

An den Arbeiten der WG 2 beteiligen sich als Vertreter des DIN der EOQ Thomas Votsmeier, Leiter Normung der DGQ, und DGQ-Mitglied Friedemann Weber.

ISO 9002 – Leitfaden zur Anwendung der ISO 9001 – und weitere Projekte

Darüber hinaus wurde bekannt, dass ISO 9002 – „Leitfaden zur Anwendung der ISO 9001“ nicht als Committee Draft (CD), sondern direkt als DIS zur Kommentierung und Abstimmung freigegeben wird, um den Zeitplan einzuhalten. In Lima wurde intensiv an der Entwicklung des Entwurfs gearbeitet.

Weitere Themen umfassten unter anderem die Überarbeitung des ISO-Handbuchs für Kleine und Mittlere Unternehmen, das künftig auch informelle Unternehmen und Start-ups einbeziehen soll. Zudem laufen die Vorbereitungen zur Aktualisierung der ISO 18091, die die Anwendung der ISO 9001 in der Kommunalverwaltung beschreibt.

Die Leitung des TC 176 wechselt von Kanada nach Frankreich. Am Rande der Sitzungen in Lima erfolgte dazu ein intensiver Austausch unter anderem zwischen europäischen Vertretern mit der zukünftigen Leitung der französischen Normungsorganisation AFNOR („Association française de normalisation”).

Die nächste Plenarwoche des ISO/TC 176 findet vom 12. bis 16. Oktober 2026 in London statt.

CE-Kennzeichnung von Medizinprodukten: Voraussetzung für den Marktzugang in Europa

Ein kleines Zeichen mit großer Wirkung – auch für Medizinprodukte: Die CE-Kennzeichnung entscheidet darüber, ob sie den Weg in Krankenhäuser, Arztpraxen oder Apotheken findet – oder eben nicht. Sie ist auch für viele andere Produkte der Schlüssel zum europäischen Markt, das sichtbare Signal, dass Sicherheit und Leistung überprüft und bestätigt wurden. Für Hersteller und Zulieferer ist sie damit weit mehr als ein formaler Schritt. Sie ist einerseits eine unverzichtbare Eintrittskarte in den Markt – und andererseits ein Versprechen an Patientinnen und Patienten.

Was steckt hinter der CE-Kennzeichnung?

Abb. 1.: Das korrekte Schriftbild des CE-Zeichens. Die Proportionen der Zeichen sind exakt festgelegt und müssen bei jeder Verwendung eingehalten werden. Veränderungen der Form oder das Verzerren sind nicht zulässig (©Adobe Stock)

Das CE-Zeichen wirkt unscheinbar. Doch hinter den beiden Buchstaben verbirgt sich ein komplexes Geflecht aus Regeln, Prüfungen und Nachweisen. Es ist kein Qualitätssiegel im klassischen Sinn, sondern eine rechtlich bindende Erklärung des Herstellers, dass sein Produkt die europäischen Vorgaben erfüllt. Ohne CE-Kennzeichnung ist ein Medizinprodukt in Europa schlicht nicht verkehrsfähig.

Der rechtliche Rahmen: Die MDR

Seit Mai 2021 bildet die Medical Device Regulation (MDR) den verbindlichen Rechtsrahmen für die CE-Kennzeichnung von Medizinprodukten in Europa. Sie regelt,

- welche Anforderungen ein Produkt erfüllen muss,

- wie Hersteller die Konformität nachweisen,

- welche Rolle unabhängige Prüfstellen spielen,

- und wie Produkte auch nach dem Inverkehrbringen überwacht werden.

Eine zentrale Rolle nehmen dabei die Benannten Stellen ein. Sie sind von den Behörden autorisierte, unabhängige Prüf- und Zertifizierungsorganisationen, die für Medizinprodukte der höheren Risikoklassen bewerten, ob die Anforderungen der MDR erfüllt sind.

Auch die Klassifizierung der Produkte nach Risikoklassen ist für die CE-Kennzeichnung entscheidend:

- Klasse I: geringes Risiko – etwa nicht sterile Verbandsmaterialien wie Pflaster oder Kompressen

- Klasse IIa/IIb: mittleres Risiko – zum Beispiel Ultraschallgeräte für die Diagnose (IIa) oder Infusionspumpen (IIb)

- Klasse III: hohes Risiko – wie Herzschrittmacher oder andere implantierbare Produkte, die unmittelbar lebenswichtige Funktionen beeinflussen

Während Hersteller Produkte der Klasse I meist eigenständig bewerten dürfen, ist bei höheren Risikoklassen zwingend eine Benannte Stelle einzubeziehen. Je höher die Risikoklasse, desto aufwendiger das Verfahren – und desto anspruchsvoller der Weg zum CE-Zeichen.

Das Qualitätsmanagementsystem als Fundament

Die MDR verpflichtet die Hersteller von Medizinprodukten, ein Qualitätsmanagementsystem (QMS) aufzubauen, um die Einhaltung der MDR auf wirksame und angemessene Weise zu gewährleisten. Es umfasst alle Teile und Elemente der Organisation eines Herstellers, die mit der Qualität der Prozesse, Verfahren und Produkte befasst sind und sorgt dafür, dass die regulatorischen Anforderungen konsequent umgesetzt werden. Es bildet zudem das organisatorische Rückgrat der CE-Kennzeichnung:

- Es regelt, wie Prozesse geplant, dokumentiert und überprüft werden.

- Es stellt sicher, dass normative und regulatorische Anforderungen in der täglichen Praxis umgesetzt werden.

- Es sorgt dafür, dass Daten aus Entwicklung, Produktion und Marktüberwachung konsistent zusammenfließen.

Ohne QMS sind die geforderten Nachweise und benötigte Unternehmensleistung kaum zu erbringen. Insbesondere bei Produkten der Klassen II und III ist ein zertifiziertes QMS daher Pflicht und eine Grundvoraussetzung für die Zusammenarbeit mit Benannten Stellen.

Der Weg zum CE-Zeichen

Die CE-Kennzeichnung ist das Ergebnis eines klar definierten, mehrstufigen Ablaufs, dessen Umfang und Anforderungen maßgeblich von Faktoren wie Produkttyp, Risikoklasse und gewähltem Konformitätsbewertungsverfahren abhängen. Typische Phasen sind die folgenden:

Phase 1: Definition der Zweckbestimmung und Klassifizierung des Produkts

Die CE-Kennzeichnung beginnt mit der Festlegung der Zweckbestimmung, auf deren Grundlage die Risikoklasse nach MDR Anhang VIII bestimmt wird – sie entscheidet maßgeblich über das weitere Verfahren.

Phase 2: Ermittlung und Umsetzung der regulatorischen Anforderungen

Der Hersteller identifiziert geltende Anforderungen aus der MDR sowie anwendbare Normen und setzt diese systematisch um.

Phase 3: Erstellung der Technischen Dokumentation

Die Technische Dokumentation enthält alle Nachweise zur Sicherheit, Leistung und Konformität, einschließlich Risikoanalyse, klinischer Bewertung, Gebrauchsanweisung und Etikettierung.

Phase 4: Durchführung des Konformitätsbewertungsverfahrens

Das Konformitätsbewertungsverfahren ist der formale Weg zur CE-Kennzeichnung; abhängig von der Risikoklasse erfolgt es entweder durch Eigenbewertung oder unter Einbeziehung einer Benannten Stelle.

Phase 5: Prüfung durch Benannte Stelle (sofern erforderlich)

Für Produkte der Klassen IIa, IIb und III prüft eine Benannte Stelle je nach gewähltem Konformitätsbewertungsverfahren das Qualitätsmanagementsystem, die Technische Dokumentation oder beides, bevor der Hersteller die Konformitätserklärung ausstellen darf.

Phase 6: Ausstellung der Konformitätserklärung und Anbringung des CE-Zeichens

Nach erfolgreichem Verfahren stellt der Hersteller die EU-Konformitätserklärung aus und bringt das CE-Zeichen an – bei Einbindung einer Benannten Stelle unter Angabe ihrer Kennnummer.

Mit der CE-Kennzeichnung endet der Prozess jedoch nicht: Durch Vigilanz, Post-Market Surveillance und Änderungsmanagement muss der Hersteller auch nach dem Inverkehrbringen sicherstellen, dass das Produkt dauerhaft die regulatorischen Anforderungen erfüllt. Die CE-Kennzeichnung ist damit kein einmaliger Stempel, sondern das Ergebnis kontinuierlicher, systematischer Bemühungen um Qualität und Sicherheit, die den gesamten Lebenszyklus eines Produkts begleiten.

Herausforderungen in der Praxis

Die Realität zeigt: Der Weg zum CE-Zeichen ist für viele Unternehmen ein Kraftakt. Engpässe bei Benannten Stellen, hohe Anforderungen an klinische Daten und eine umfangreiche Dokumentationslast machen das Verfahren langwierig und ressourcenintensiv. Viele Unternehmen berichten, dass gerade die klinische Bewertung einen großen Zeit- und Kostenfaktor darstellt.

Hinzu kommt, dass verschiedene Fachbereiche – Qualitätsmanagement, Regulatory Affairs und Entwicklung – eng zusammenarbeiten müssen. Erst dieses Zusammenspiel ergibt ein vollständiges Bild.

Besonders kleine und mittelständische Hersteller stoßen hier an Grenzen. Gleichzeitig zeigt sich: Wer ein stabiles QMS etabliert, interne Abstimmungen und Zusammenarbeit effizient gestaltet und Expertise aufbaut, verschafft sich einen entscheidenden Vorteil.

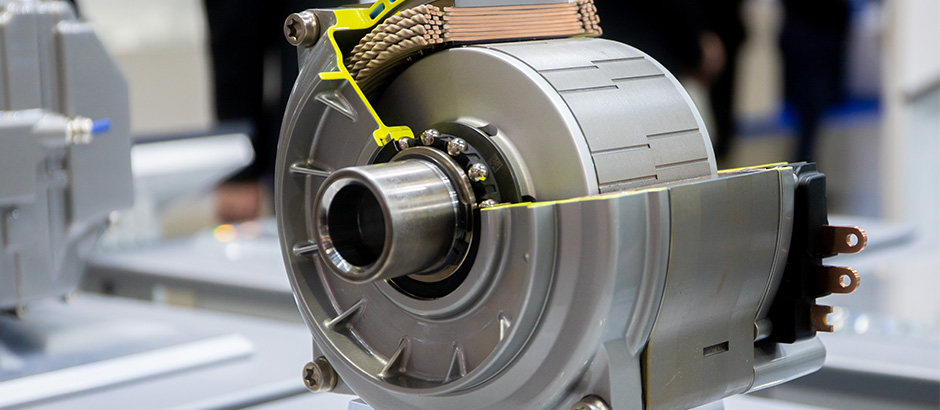

Wie Qualität als Sicherheitsfaktor im Verteidigungsumfeld wirken kann und AQAP zum Impuls für das QM wird

Die ISO 9001 bildet das weltweit anerkannte Fundament moderner Qualitätsmanagementsysteme. Mit ihrem risikobasierten Ansatz fordert sie die systematische Identifikation und Bewertung von Risiken sowie die kontinuierliche Verbesserung von Prozessen. Ihre Stärke liegt in der universellen Anwendbarkeit – zugleich ist dies ihre Grenze: Die Norm bleibt bewusst allgemein und trifft keine Aussagen zu sicherheitskritischen Produkten, staatlichen Eingriffsrechten oder vertraglichen Nachweispflichten.

Im Defence-Umfeld, wo Qualität für lange Lebenszyklen von Ausrüstungen wichtig und zudem unmittelbar sicherheitsrelevant ist, genügt ein generisches QM-System daher nicht. Hier greifen ergänzende Anforderungen der NATO.

AQAP – die NATO-Erweiterung der ISO 9001

Die Allied Quality Assurance Publications (AQAP), insbesondere AQAP 2110 „NATO Quality Assurance Requirements for Design, Development and Production“, konkretisieren und erweitern die ISO 9001 um verteidigungsspezifische Vorgaben. Sie fordern insbesondere:

- Konfigurationsmanagement (CM): Vollständige Rückverfolgbarkeit aller Configuration Items über den gesamten Lebenszyklus; Änderungen müssen eindeutig identifizierbar, dokumentiert und genehmigt sein.

- Government Quality Assurance (GQA): Nationale Behörden entsenden Government Quality Assurance Representatives (GQAR) mit umfassenden Einsichts- und Prüfungsrechten – auch innerhalb der Lieferkette.

- Certificate of Conformity (CoC): Jeder Liefergegenstand ist mit einem verbindlichen Konformitätsnachweis zu versehen; Abweichungen bedürfen der formalen Genehmigung.

- Lieferantensteuerung: Der Prime Contractor trägt die Gesamtverantwortung für die Einhaltung aller AQAP-Anforderungen in seiner Supply Chain – inklusive Subcontractors.

Ergänzende Standards und Werkzeuge

Zur praktischen Umsetzung verweist die NATO auf flankierende Dokumente wie STANAG 4427 (Configuration Management in System Life Cycle Management) und ACMP-2000 (Policy on Configuration Management). Diese legen Prozesse, Rollen und Schnittstellen im Konfigurationsmanagement verbindlich fest. Ergänzend definiert AQAP 2105 „NATO Requirements for Quality Plans“ den projektspezifischen Qualitätsplan als operatives Steuerungsinstrument. Er beschreibt, wie die Normanforderungen in einem konkreten Projekt umgesetzt werden – inklusive Prüf- und Auditplänen, Schnittstellen, Meldewegen und Abweichungsverfahren. Im Unterschied zu zivilen QM-Plänen ist der AQAP-Quality-Plan vertraglich bindend und unterliegt der behördlichen Freigabe.

Besonderheiten im Defence-Kontext

Qualität im Verteidigungssektor ist mehrdimensional: Sie vereint technische, vertragliche und sicherheitspolitische Aspekte. Neben der Produktqualität stehen Themen wie Geheimschutz, Exportkontrolle, Fälschungsschutz und Auditfähigkeit der gesamten Lieferkette im Fokus. Die Qualitätssicherung wird so zum Governance-Instrument – mit unmittelbarer Relevanz für staatliche Aufsicht und internationale Interoperabilität.

Hinweis für Qualitätsmanagement-Profis

Ein Managementsystem nach ISO 9001 schafft eine belastbare Grundlage für AQAP-konformes Qualitätsmanagement. Für den Defence-Bereich sind jedoch zusätzliche Prozesse, Rollen und Nachweispflichten erforderlich – insbesondere in Bezug auf Konfigurationsmanagement, staatliche Prüfrechte und vertragliche Nachweise. All dies ist in einem integrierten Managementsystem abbildbar. Nur durch diese Erweiterungen wird aus einem ISO-System ein audit- und nachweisfähiges AQAP-Managementsystem.

Querschnittswirkung

Die in AQAP etablierten Prinzipien – vollständige Rückverfolgbarkeit, externe Qualitätssicherung und risikoorientierte Lieferkettenüberwachung – werden verstärkt auch im zivilen Umfeld diskutiert. Mit der zunehmenden Digitalisierung werden auch die NIS2, der Cyber Resilience Act, Cybersecurity-Schutz von Anlagen und Produkten und regulatorische Transparenzpflichten an Bedeutung gewinnen. Die Schnittmengen zwischen zivilen und militärischen Qualitätsanforderungen nehmen in anspruchsvollen Themenbereichen zu. Qualität entwickelt sich damit von einem reinen Managementthema zu einem sicherheitsrelevanten Steuerungsinstrument.

Bedeutung integrierter Managementsysteme

Ein integriertes Managementsystem, das mehrere Normen (auch die ISO 9001) unterstützt, bietet eine solide Grundlage für AQAP-konformes Qualitätsmanagement. Für den Defence-Bereich sind jedoch zusätzliche Strukturen, Verfahren und Nachweispflichten erforderlich, um die erweiterten Anforderungen der NATO-Normen vollständig zu erfüllen. Diese können nach den Vorgaben im Managementsystem hinterlegt werden und sind dann auch fachlich verlinkt. Zum Beispiel kann das Managementsystem von Opexa die Grundlage bilden und die ISO 9001 (neben ISO 27001 etc.) abdecken. Darauf kann dann mit AQAP 2110 (ist im System bereits hinterlegt) aufgebaut werden.

Ausblick – Qualität mit neuer Dynamik

Das Qualitätsmanagement fristet in Organisationen teilweise ein Schattendasein: zu normativ, zu bürokratisch, zu weit entfernt vom operativen Geschäft. Doch mit AQAP bekommt das Thema neuen Impuls. Plötzlich geht es über Prozesskennzahlen oder Auditzyklen hinaus auch um Sicherheit, Verlässlichkeit und staatliche Verantwortung. AQAP macht Qualität strategisch relevanter – greifbarer, überprüfbarer, entscheidungswirksamer. Wo ISO 9001 das Fundament legt, bringt AQAP neue Bewegung in die Struktur: Verbindlichkeit statt Allgemeingültigkeit, Transparenz statt Dokumentationsroutine. Dies stärkt das Qualitätsmanagement in der Rolle, , die es heutzutage einnehmen sollte – als Rückgrat sicherheitskritischer Lieferketten und als Motor für Vertrauen in komplexen, geopolitisch sensiblen Zeiten

Über den Autor:

Klaus Kilvinger ist Geschäftsführender Gesellschafter der Opexa Advisory GmbH, einer auf die Themen Digitalisierung, Cyber- und Informationssicherheit, sowie deren Integration in Geschäftsprozesse spezialisiertes Beratungsunternehmen mit Hauptsitz in München. Er ist seit über 30 Jahren in der IT-Branche aktiv und verfügt über ein breites anwendungsbezogenes Erfahrungswissen, verfügt ferner über umfassende Kenntnisse und Erfahrungen im IT-Projektgeschäft sowie Fachwissen in der Software-Qualitätssicherung. Die Informationssicherheit im nationalen und internationalen Umfeld ist sein Zuhause. Als zertifizierter IT-Security Manager, IT-Security Beauftragter sowie Datenschutzbeauftragter verfügt er über breite Branchenkenntnisse, über die Fertigungs-, Automobilindustrie, den öffentlichen Sektor bis hin zur Wirtschaftsprüfung. Zur Website »

Aktuelles aus der Managementsystemnormung – Revisionen von ISO 9001 und Co.

Als Fachgesellschaft wirkt die DGQ regelmäßig an strategischen Entscheidungen und der thematischen Schwerpunktsetzung in der nationalen und internationalen Normung mit. Von besonderem Interesse sind in diesem Zusammenhang die Managementsystemnormen. Durch das internationale Engagement von DGQ-Expert:innen in den thematisch relevanten Gremien und zusätzlich national in Beiräten sowie ausgewählten Gremien erhält die DGQ die Möglichkeit, Synergien zwischen verschiedenen Normenrevisionen zu erkennen und zu nutzen. Ziel ist eine harmonisierte Weiterentwicklung im Sinne der Anwender:innen. Das Jahr 2025 steht dabei ganz im Zeichen der Revisionen von ISO 9001, ISO 9000 und ISO 19011, die von DGQ-Expert:innen intensiv begleitet werden.

Revision von ISO 9001: Draft International Standard (DIS) erreicht

Aktuell und noch bis zum 22. Oktober läuft die öffentliche Kommentierungsphase für den DIS (Draft International Standard) von ISO 9001. Nach Ablauf der Kommentierungsfristen wird die zuständige Arbeitsgruppe die Rückmeldungen bewerten und zum Final Draft International Standard (FDIS) einarbeiten.

Der aktuelle Zeitplan umfasst die folgenden Meilensteine:

- Dezember 2023 – Februar 2024: Erarbeitung des Working Drafts (WD), erster Entwurf und Kommentierung im Gremium London Meeting.

- März – Juni 2024: Bearbeitung und Kommentierung des ersten Committee Drafts (CD1)

- Juli – Dezember 2024: Auswertung der CD1-Kommentare im Rahmen des Detroit Meetings.

- Januar – Juni 2025: Erstellung und Kommentierung des zweiten Committee Drafts (CD2) im Paris Meeting.

- August 2025 – März 2026: Veröffentlichung und Diskussion des Draft International Standard (DIS) inklusive öffentlicher Kommentierung im Zuge des Mexico Meetings.

- April – Juni 2026: Finalisierung des Final Draft International Standard (FDIS).

- September 2026: Veröffentlichung der ISO 9001:2026.

Alle Termine verstehen sich als Zielmarken – kleinere Verschiebungen im Projektverlauf sind möglich. Der gesamte Revisionsprozess ist auf 36 Monate angelegt und wird vom internationalen ISO-Gremium TC 176 SC2 WG29 koordiniert.

Wesentliche Änderungen im DIS gegenüber der 2015er Version – Stand August 2025

Grundsätzlich halten sich die inhaltlichen Änderungen der in ISO 9001 festgelegten Anforderungen in Grenzen. Ein zentraler Punkt ist die Einarbeitung der aktuellen Vorgaben der in den ISO-Direktiven festgelegten „Harmonized Structure“ für Managementsystemnormen (HS). Die entsprechenden Inhalte hat die zuständige Arbeitsgruppe sprachlich präzisiert und vereinheitlicht. In Abschnitt 3 wurden sämtliche Begriffe aus der HS ergänzt, ohne dabei den Bezug zur ISO 9000 zu ändern.