EU KI-Gesetz: Neue Regelungen für sichere und gesetzeskonforme KI-Produkte

Von Predictive Maintenance und Kameraprüfungen bis hin zu intelligenten Konsumgütern – KI spielt eine entscheidende Rolle in der modernen Industrie. Das kürzlich verabschiedete EU KI-Gesetz bringt neue Anforderungen und Regulierungen, die erhebliche Auswirkungen auf die Entwicklung und den Einsatz von KI in Europa haben werden. Dieser Artikel erläutert grundsätzliche Begriffe der EU KI-Gesetzgebung und erklärt, worauf Unternehmen bei der Einführung neuer KI-Lösungen achten müssen.

Das KI-Gesetz definiert ein KI-System als „ein maschinengestütztes System, das für einen in unterschiedlichem Grade autonomen Betrieb ausgelegt ist und das nach seiner Betriebsaufnahme anpassungsfähig sein kann und das aus den erhaltenen Eingaben für explizite oder implizite Ziele ableitet, wie Ausgaben wie etwa Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen erstellt werden, die physische oder virtuelle Umgebungen beeinflussen können.“

Diese Definition von KI-Systemen ist deutlich breiter als der allgemeine Sprachgebrauch. Wenn heute von KI-Systemen die Rede ist, dann meist im Zusammenhang mit Chatbots wie ChatGPT oder Gemini. Tatsächlich sind in der Definition des KI-Gesetzes auch Systeme eingeschlossen, die heute bereits zum Alltag gehören, wie Empfehlungsalgorithmen bei YouTube oder Amazon. Auch Übersetzungsprogramme können in diese Kategorie fallen.

Das EU KI-Gesetz wurde entwickelt, um die sichere und ethische Nutzung von KI in Europa zu gewährleisten. Er schafft ein einheitliches Regelwerk, das Transparenz, Verantwortlichkeit und Sicherheit fördern soll. Ein gutes Beispiel für den Einsatz von KI-Systemen in der Industrie sind Predictive Maintenance-Anwendungen , zum Beispiel bei der Wartung von Windturbinen. Hierbei werden Maschinen und Anlagen kontinuierlich überwacht, um potenzielle Ausfälle frühzeitig zu erkennen und präventive Wartungsmaßnahmen durchzuführen. Diese prädiktiven Systeme nutzen große Mengen an Sensordaten und fortschrittliche Algorithmen, um Muster zu erkennen und Vorhersagen zu treffen.

Ein weiteres Beispiel sind automatische Kameraprüfungen. Klassische Kameraprüfungen arbeiten mit Helligkeits- oder Kantenerkennungen. Inzwischen setzen immer mehr Hersteller auf KI-Methoden, um Kameraprüfungen anhand von Beispielbildern zu trainieren. Auf diesem Weg lassen sich auch aufwändige Prüfungen realisieren, die ansonsten nur mit Hilfe von Werkern umsetzbar wären.

Das EU KI-Gesetz folgt einem risikobasierten Ansatz. Insbesondere wenn Sicherheitsaspekte oder die Interessen von natürlichen Personen berührt sind, müssen Anbieter von solchen KI-Systemen eine Vielzahl von Anforderungen einhalten. Solche Systeme fallen in der Regel in den Hochrisikobereich. In unserem letzten Artikel der Serie haben wir die grundsätzlichen Anforderungen an Hochrisiko-Systeme aufgelistet.

Prinzipien des KI-Gesetz zur Absicherung von KI-Systemen

Das KI-Gesetz folgt bei der Absicherung von KI-Systemen folgenden Prinzipien:

Transparenz:

KI-Systeme müssen so gestaltet sein, dass ihre Entscheidungen nachvollziehbar sind. Nutzer sollten erkennen, dass sie mit einem KI-System interagieren. Entscheidungen eines KI-Systems müssen im Zweifelsfall nachvollziehbar sein.

Sicherheit:

KI-Produkte müssen robuste Sicherheitsmaßnahmen enthalten, um Missbrauch und unerwünschte Auswirkungen zu verhindern.

Fairness und Datenschutz:

Der Schutz personenbezogener Daten muss gewährleistet sein. Entscheidungen und Empfehlungen müssen frei von ungerechtfertigter Diskriminierung sein. Diese Anforderungen sind bereits bei der Entwicklung des Systems zu berücksichtigen.

Überwachung und Verantwortlichkeit:

Es müssen Mechanismen zur kontinuierlichen Überwachung und Bewertung der KI-Systeme etabliert werden. Zudem ist klar festzulegen, wer die Verantwortung für das Funktionieren und die Entscheidungen der KI trägt.

Diese Prinzipen decken sich in großen Teilen mit denen vorangegangener Veröffentlichungen, wie dem KI-Prüfkatalog des Fraunhofer IAIS Instituts.

Herausforderungen bei der Absicherung von KI-Systemen

Eine Herausforderung bei der Absicherung von KI-Systemen besteht in der Tatsache, dass diese Systeme in der Regel lernfähig sind.

Traditionell produzierte Produkte durchlaufen in der Regel einen linearen Entwicklungsprozess: Design, Prototyping, Produktion, Qualitätskontrolle und schließlich Markteinführung. Diese traditionellen Produkte sind in ihrer Funktion festgelegt und ändern sich nicht wesentlich nach dem Verkauf. Auf lernfähige KI-Systeme trifft dies nicht zu. Sie können sich in ihrer Funktion durch das Erlernen neuer Informationen nach der Markteinführung noch verändern. Aus diesem Grund umfasst der Entwicklungsprozess von KI-Produkten nicht nur das ursprüngliche Design und die Produktion, sondern auch die Implementierung von Datenmanagementstrategien, die Entwicklung und das Training von Modellen sowie fortlaufende Überwachung und Updates nach der Markteinführung.

Für die praktische Umsetzung der gesetzlichen Vorgaben hat die EU der europäischen Normenorganisation Cen/Cenelec einen Normungsauftrag erteilt. In der Arbeitsgruppe JTC21 – Artificial Intelligence sind inzwischen 21 Normen und Richtlinen in Erstellung, die die unterschiedlichen Aspekte der EU KI-Gesetzgebung betreffen. Diese Normen regeln zum Beispiel das Qualitätsmodell für künstliche Intelligenz und beschreiben Methoden zur Vermeidung von ungewollten statistischen Verzerrungen (Bias) in Trainingsdatensätzen.

Unternehmen, die aktuell bereits KI in ihren Produkten einsetzen, sollten sich darauf einstellen, dass eine Vielzahl von Anforderungen in kurzer Zeit umgesetzt werden müssen. Ein Beispiel hierfür sind die Data Governance Anforderungen (CLC/TR 18115), die nach jetziger Planung am 29. August 2024 verabschiedet werden. Die zugehörigen gesetzlichen Anforderungen werden bereits im Mai 2025 verpflichtend für alle Systeme der mittleren und hohen Risikokategorie (siehe Abb. 1). Diese beiden Kategorien umfassen eine Vielzahl von Systemen von Chatbots über Empfehlungssysteme bis hin zu sicherheitskritischen Systemen (zum Beispiel in Medizin, Verkehr und Bildung).

Schritte zur Einführung von KI-Systemen gemäß EU-KI-Gesetzgebung

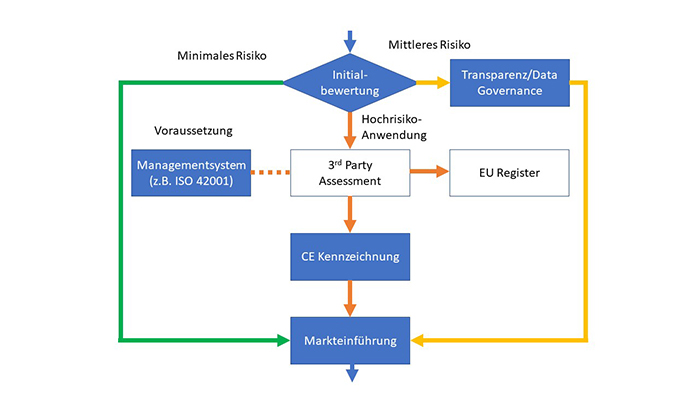

Das KI-Gesetz legt einen Großteil der Verantwortung für Absicherung zur Markteinführung und sicheren Betrieb in die Hände der Betreiber der KI-Systeme. Abbildung 1 zeigt die wichtigen Schritte zu Einführung von KI-Systemen gemäß EU KI-Gesetzgebung. Unternehmen, die KI einsetzen, müssen die eingesetzten KI-Systeme erfassen und die Risikokategorie selbstständig bestimmen. Unser KI-Selfassessment kann Sie bei dieser Aufgabe unterstützen. Eine nähere Beschreibung der Risikokategorien befindet sich im vorangegangenen Beitrag dieser Serie.

KI-Systeme, die in der EU zulässig sind, fallen in die Kategorien geringes Risiko (keine zusätzlichen gesetzlichen Anforderungen aus dem KI-Gesetz), mittleres Risiko (Transparenz- und Data-Governanceanforderungen) und Hochrisiko-Systeme.

Abb. 1: Einführung von KI-Systemen nach EU KI-Gesetz

Systeme mit mittlerem und geringem Risiko werden von den Unternehmen in Eigenregie überwacht. Für Hochrisiko-Systeme existieren weitere Anforderungen aus dem KI-Gesetz. Diese Anforderungen treten ab Mai 2026 in Kraft und werden nach Abschluss einer 12-monatigen Übergangsfrist im Mai 2027 verpflichtend. Bevor diese Hochrisiko-KI-Systeme in der EU in Verkehr gebracht werden dürfen, muss ein unabhängiges 3rd Party-Assessment durchgeführt werden. Voraussetzung für ein erfolgreiches 3rd Party-Assessment sind ein bestehendes Managementsystem und ein dazugehöriges Risikomanagement. In diesem Zusammenhang wird auch die ISO 42001:2023 als Systemnorm für künstliche Intelligenz an Bedeutung gewinnen. Sie ist zwar nicht explizit im Gesetzestext benannt, bietet aber eine gute Basis für die Entwicklung moderner KI-Systeme.

Nach bestandenem 3rd Party-Assessment muss die Hochrisiko-Anwendung in einer zentralen EU-Datenbank registriert werden. Auf dieser Basis kann das Unternehmen im Anschluss eine CE-Kennzeichnung erstellen und das Produkt in den Umlauf bringen.

Ausblick

Zusammenfassend kann gesagt werden, dass das EU KI-Gesetz einen bedeutenden Schritt zur Regulierung und Sicherstellung sicherer und ethischer KI-Systeme darstellt. Für Unternehmen bedeutet dies, dass sie ihre KI-Prozesse und -Produkte genau prüfen und an die neuen Anforderungen anpassen müssen. Der erste Schritt besteht in einer Bewertung der Risikokategorie aller bestehenden KI-Anwendungen, die bereits im Unternehmen oder in Produkten im Einsatz sind. Die Definition von KI-Systemen aus dem KI-Gesetz legt fest welche Systeme hierbei betrachtet werden müssen. Im zweiten Schritt muss die Einhaltung der relevanten Anforderungen sichergestellt werden. Hierbei sind insbesondere die Meilensteine für die Einhaltung der Transparenz- und Data Governance-Anforderungen ab Mai 2025 und das Ende der Übergangsfrist für Hochrisiko-Systeme im Mai 2027 zu beachten.

Lesen Sie mehr zum Thema “Künstliche Intelligenz in der Qualität” in den folgenden Fachbeiträgen:

- Teil 1: Künstliche Intelligenz in der Qualität – Bestehendes Know-how effektiv nutzen – zum Beitrag »

- Teil 2: Künstliche Intelligenz in der Qualität – Welche Qualifikationen werden benötigt? – zum Beitrag »

- Teil 3: Künstliche Intelligenz in der Qualität – Praktische Einführung durch iteratives Vorgehen – zum Beitrag »

Über die Autoren:

Dipl.-Ing. Waldemar Fahrenbruch ist Head of Q-Technology Division E-Mobility bei der ZF Friedrichshafen AG. Er ist verantwortlich für die Qualitätskostensenkung bei gleichzeitiger Optimierung von Qualitätskonzepten in den Werken der Division E (TCU, Power Electronics und E-Motoren Fertigung) durch Methodenkompetenz der Qualität, künstlicher Intelligenz und digitaler Transformation.

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Künstliche Intelligenz. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten. Kontakt: ki@prophet-analytics.de