Biodiversitätsmanagement im unternehmerischen Kontext: Tipps für die Praxis

Biodiversität ist essenziell für das Leben auf unserem Planeten. Wissenschaftler warnen: Mit schlechtem Klima lässt sich überleben, ohne Biodiversität nicht. Das Erreichen planetarer Belastbarkeitsgrenzen ist ein alarmierendes Signal für Unternehmen, ihren Fokus auf dieses Thema zu legen. Sie sollten daher Biodiversitätsmanagement in ihr Nachhaltigkeitsmanagement integrieren.

Aktuelle Situation

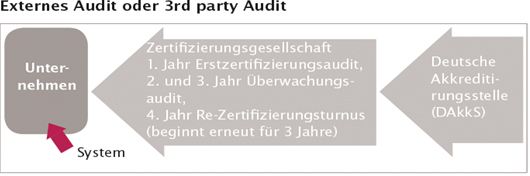

Biodiversität umfasst die Vielfalt des Lebens auf der Erde, einschließlich der Gene, Arten und Ökosysteme, die für die Stabilität und Produktivität unserer natürlichen und wirtschaftlichen Systeme unverzichtbar ist. 50 Prozent aller Emissionen werden von der Natur absorbiert. Ohne diese Absorption würden sich die Emissionen in der Atmosphäre drastisch erhöhen, was zu schwerwiegenden Klimaveränderungen führen würde. 75 Prozent der weltweiten Nahrungsmittelproduktion hängt von Bestäubern wie Bienen ab. Ihr Verlust kann die Erträge verringern und die Kosten für Bestäubungsdienste in die Höhe treiben. Die „Hochzeitstorte“ (Abbildung 1) verdeutlicht die Beziehung zwischen den UN-Zielen für nachhaltige Entwicklung (Sustainable Development Goals, SDGs) und der hohen Bedeutung der Natur und Biodiversität.

Mehr als die Hälfte des globalen Bruttoinlandsprodukts, rund 44 Billionen US-Dollar, hängt von einer intakten Natur ab (WWF, 2023). Laut dem World Economic Forum (WEF) zählen der Verlust der Artenvielfalt und der Zusammenbruch ganzer Ökosysteme zu den größten Risiken für die Weltwirtschaft (WEF, 2023). Der Verlust der Biodiversität führt schon jetzt jährlich zu wirtschaftlichen Einbußen von über 30 Billionen US-Dollar (NABU, BCG 2020), besonders in den Sektoren Pharmazie, Landwirtschaft, Fischerei und Tourismus. Veränderungen in natürlichen Systemen verursachen Ressourcenknappheit und erhöhen die Produktionskosten in wasserintensiven Branchen wie Landwirtschaft, Textil- und Getränkeindustrie. Die Degradierung von Ökosystemen und klimatische Veränderungen können Lieferketten destabilisieren, Versorgungsengpässe und Preisschwankungen hervorrufen. Angesichts der Biodiversitätskrise und der anderen Multikrisen ist dies keine erfreuliche Nachricht für Unternehmen. Der Global Risk Report 2024 zeigt, dass der Biodiversitätsverlust in einem Zehnjahreshorizont als drittgrößtes Risiko für Unternehmen wahrgenommen wird

Abb. 1: Beziehung der Ziele für nachhaltige Entwicklung – Biosphäre ist die Basis

(Quelle: Die Animation wurde von Azote für das Stockholm Resilience Centre erstellt; Lizenz: CC BY ND 3.0)

Biodiversität managen

Unternehmen nutzen die Leistungen der Natur und können Biodiversität durch verschiedene Maßnahmen managen, um negative Umweltauswirkungen zu minimieren und positive Beiträge zu leisten. Wichtige Strategien eines Biodiversitätsmanagements umfassen:

- Integration von biodiversitätsbezogenen Themen in Umweltmanagementsysteme, wobei EMAS als besonders geeignet scheint, da es die biologische Vielfalt als Schlüsselbereich ausweist und konkrete Indikatoren und Maßnahmen fordert.

- Systematische Erfassung und Bewertung der Auswirkungen des Unternehmens sowie seiner Lieferketten auf die lokale Flora und Fauna, einschließlich der Berechnung des eigenen Biodiversitätsfußabdrucks.

- SMARTE Ziele und Maßnahmen für den Biodiversitätsschutz setzen, zum Beispiel Schaffung naturnaher Flächen, Förderung einheimischer Pflanzenarten und Reduktion von Pestiziden.

- Schulungen und Sensibilisierungsprogramm für Beschäftigte und Anspruchsgruppen in der Wertschöpfungskette zur Schärfung des Bewusstseins für die Bedeutung der Biodiversität und zur Förderung umweltfreundlicher Praktiken.

- Regelmäßige Überwachung und Berichterstattung im Rahmen der neuen Nachhaltigkeitsberichtsstandards, speziell ESRS E4 – Biodiversity and ecosystems , um Fortschritte im Biodiversitätsschutz zu messen und transparent darzustellen.

| Berufsbild Klimaschutzmanager Kommunen und Unternehmen werden sich zunehmend ihrer Verantwortung für und den Herausforderungen durch den Klimawandel bewusst. Sie suchen daher immer häufiger nach Fachexperten, die sie bei der Umsetzung von Klimaschutzstrategien unterstützen können. Durch ihre Tätigkeit tragen Klimaschutzmanager dazu bei, Treibhausgasemissionen der Unternehmen und Kommunen zu reduzieren. Antworten auf die wichtigsten Fragen finden Sie in unserem Berufsbild zum Klimaschutzmanager:

|

Konkret können Unternehmen …

Unternehmen können nachhaltige Beschaffungspraktiken einführen, um sicherzustellen, dass Rohstoffe und Produkte aus umweltfreundlichen Quellen stammen. Durch die Förderung der Biodiversität auf Firmengeländen (PDF), etwa durch naturnahe Flächen und den Verzicht auf Pestizide, tragen sie zum Erhalt der Artenvielfalt bei. Maßnahmen wie insektenfreundliche LED-Lampen und der Verzicht auf Versiegelung von Parkflächen sind ebenfalls sinnvoll. Unternehmen können in ihrer Lieferkette Risikobewertungen vornehmen, um Produkte mit hohem Risiko für den Verlust der Biodiversität, wie Holzprodukte, zu identifizieren. Die Umstellung auf nachhaltige Beschaffungspolitiken kann den Einsatz umweltschädlicher Produkte reduzieren, indem zertifizierte Produkte wie MSC-Fisch oder FSC/PEFC-Holzerzeugnisse bevorzugt werden.

Es ist wichtig, das Wirkungsnetz zu berücksichtigen, da Klimaschutzmaßnahmen manchmal in Konkurrenz zu anderen Nachhaltigkeitszielen stehen, etwa wenn erneuerbare Energieprojekte Lebensräume beeinträchtigen. Ein integrierter Ansatz, der alle Umweltauswirkungen einbezieht, ist unerlässlich, um langfristig nachhaltige Lösungen zu gewährleisten. Die Zusammenarbeit mit Interessengruppen wie NGOs, lokalen Gemeinschaften und wissenschaftlichen Einrichtungen kann Unternehmen dabei unterstützen, effektive Biodiversitätsstrategien zu entwickeln und umzusetzen. Unternehmen können Programme zur Biodiversitätskompensation unterstützen, um negative Auswirkungen ihrer Aktivitäten auszugleichen. Dabei gilt der Hierarchie-Grundsatz: Vermeiden, Reduzieren und dann erst Kompensieren, idealerweise lokal, um die gleichen Ökosysteme und Arten zu unterstützen.

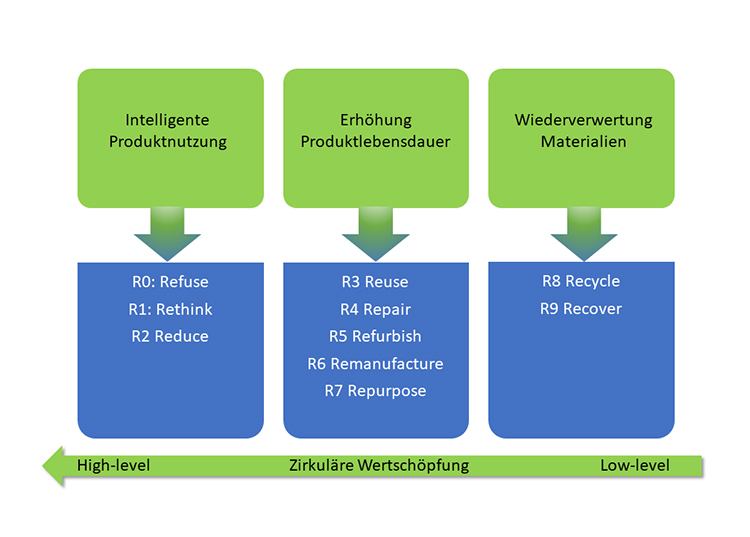

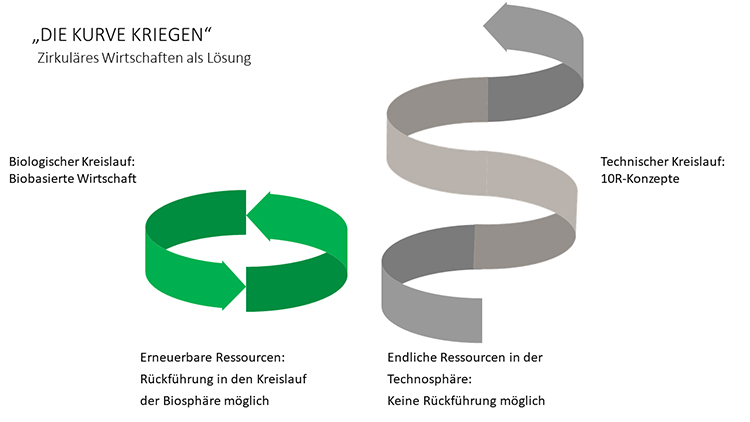

Beitrag von Kreislaufwirtschaft zur Biodiversität

Die Entwicklung nachhaltiger Produkte und Dienstleistungen, die den gesamten Lebenszyklus berücksichtigen, ist wichtig für den Erhalt der Biodiversität. Die Kreislaufwirtschaft zielt darauf ab, die Lebensdauer von Produkten zu maximieren, die Wiederverwendung von Materialien zu fördern und den Abfall zu minimieren. Obwohl diese Prinzipien auf Ressourcenschonung abzielen, sind die Effekte des zirkulären Wirtschaftens auf die Biodiversität noch nicht vollständig untersucht. Offensichtlich ist jedoch der Zusammenhang des linearen Wirtschaftsmodells mit dem Verlust an Ökosystemen durch Landveränderung oder Deponien. Es lohnt sich, die Kreislaufwirtschaft als positiven Effektgeber zum Erhalt der Biodiversität zu betrachten. Eine Meta-Studie aus dem Jahr 2023 aus Finnland bewertete im Bau- und Immobiliengewerbe sowie der Waldwirtschaft verschiedene Circular-Economy-Maßnahmen. Die Ergebnisse zeigen, dass die kaskadierende Nutzung von Holz, die Verbesserung der Materialeffizienz, die Wiederverwendung von Baumaterialien und die Verlängerung der Lebensdauer von Gebäuden großes Potenzial haben, den Druck auf die Biodiversität zu mindern. Allerdings könnten Maßnahmen, die die Nutzung heimischer Wälder erhöhen, die Biodiversität beeinträchtigen, wenn keine biodiversitätsfördernden Waldmanagementpraktiken genutzt werden und die Abholzung zu hoch bleibt.

Es reicht also nicht aus, auf vermeintlich erneuerbare und kompostierbare Rohstoffe zu setzen, wenn dadurch Lebensraum vernichtet wird. Es muss bei jedem Produkt abgewogen werden, welche Circular-Economy-Maßnahme die Biodiversität schützt. Ökobilanzen können unterstützen, indem sie eine ganzheitliche Perspektive bieten.

Drei Stellhebel der Kreislaufwirtschaft wirken positiv auf die Biodiversität: nachhaltiger Materialeinsatz, nachhaltige Geschäftsmodelle und nachhaltiger Mindset.

- Nachhaltiger Materialeinsatz:

Die Reduzierung der Ressourcenextraktion und die daraus resultierende Verringerung von Lebensraumzerstörung schützt natürliche Lebensräume und Arten. - Nachhaltige Geschäftsmodelle:

Durch die Reduzierung von Abfällen und das Schließen von Stoffkreisen wird die Umweltverschmutzung verringert. Sharing- und Streaming-Konzepte reduzieren CO2-Emissionen und schädliche Umwelteinflüsse wie Dürren, die die Biodiversität beeinträchtigen. - Nachhaltiger Mindset:

Die Circular Economy fördert ein Bewusstsein bei Konsumenten, die durch ihr Kaufverhalten die Umwelt schützen können. Dies stärkt regionale Ökonomien und führt zu einer höheren Akzeptanz für nachhaltige Produkte zu angemessenen Preisen – vorausgesetzt, diese werden nachhaltig und biodiversitätsfreundlich produziert.

| Next Level Nachhaltigkeit: Ihre Online-Konferenz für Berichterstattung, Qualität & ESG Die Integration von Nachhaltigkeit in bestehende Managementsysteme bietet eine wertvolle Chance, denn viele Unternehmen verfügen bereits über etablierte Strukturen und Daten, die es ermöglichen, Nachhaltigkeitsanforderungen systematisch zu managen und zu erfüllen. Mit unserer Online-Konferenz am 23. September 2025 bieten die Deutsche Gesellschaft für Qualität und das Kunststoff-Zentrum SKZ Unternehmen genau die Unterstützung, die Sie brauchen, um die aktuell bestehenden Herausforderungen erfolgreich zu meistern. Mit der Omnibus-Verordnung als neuem Rahmen gilt es für zukunftsorientierte Unternehmen jetzt mehr denn je, Nachhaltigkeit strategisch zu verankern und Wettbewerbsvorteile zu sichern – denn nachhaltige Unternehmensführung geht weit über eine bloße Berichtspflicht hinaus. Jetzt informieren und anmelden » |

Vernetzung

Der DGQ-Fachkreis Nachhaltigkeit vernetzt Interessierte und deren Kompetenzen durch verschiedene Aktivitäten. Arbeitsgruppen bearbeiten Themen wie Nachhaltigkeitskennzahlen, CO2-Fußabdruck, Nachhaltigkeitskompetenzen und Blockchain-Chancen. Eine Arbeitsgruppe zum Thema “Biodiversität in Unternehmen” ist ebenfalls denkbar. Interessierte können sich bei den Autorinnen des Blogbeitrags unter com@dgq.de melden.

Über die Autoren:

Prof. Dr. Linda Chalupová ist eine Nachhaltigkeitsexpertin, Autorin, Keynote-Speakerin und zertifizierte Aufsichtsrätin mit Kernkompetenzen im nachhaltigen Wirtschaften. Als Professorin für Nachhaltigkeitswissenschaften an der Hochschule Fulda strebt sie einen profitablen Transfer zwischen Wissenschaft und Praxis an, um schnellstmöglich effektive Lösungen für eine nachhaltige Entwicklung bereitzustellen. Sie engagiert sich als Vorständin und Beirätin in mehreren Berufsverbänden, Gremien und Arbeitskreisen und ist Unternehmensmentorin in den Bereichen ESG und Berichterstattung. Zu-dem ist sie Mitglied im Leitungsteam des DGQ-Fachkreises Nachhaltigkeit.

Prof. Dr. Irina Mazilu-Eyaz hat Materialwissenschaft an der Technischen Universität Darmstadt und am Imperial College London studiert. Während Ihrer 11-jährigen Berufstätigkeit bei einem internationalen Technologiekonzern sammelte sie Erfahrung im Qualitätsmanagement und wurde zur Methoden-Expertin für technische Problemlösung. Seit 2021 ist sie Professorin für Qualitätsmanagement und Werkstoffkunde an der Hochschule RheinMain und entwickelt auch neue Lehrveranstaltungen zum Thema Nachhaltigkeit. Im Mai 2023 wurde sie ins Leitungsteam des DGQ-Fachkreises Nachhaltigkeit gewählt.

Mit der nachfolgenden Linksammlung erhalten Interessierte kostenlosen Zugriff auf hilfreiche Informationen zum Thema Biodiversität: Risikofilter der Biodiversität (WWF) Biodiversität über den Tellerrand (Forschungsprojekt) Vielfalt am Standort – Schritte zu nachhaltigem Biodiversitätsmanagement (Bayerisches Landesamt für Umwelt) Leitfaden 2023 – Schutz der biologischen Vielfalt im Rahmen von Umweltmanagementsystemen (EMAS) Wege zum naturnahen Firmengelände (Bundesamt für Naturschutz)

Weiterführende Informationen

Nachhaltigkeit im Klinikbau – In Göppingen entsteht das erste „Green Hospital“ Baden-Württembergs

Die Kliniken Deutschlands durchleben einen massiven Transformationsprozess. Viele Krankenhäuser befinden sich in einer finanziell prekären – teilweise existentiell bedrohlichen – Situation. In dem gesetzlich vorgegebenem Dualen Finanzierungssystem sollen die laufenden Kosten über Fallpauschalen und die notwendigen Investitionen über Fördermittel der Bundesländer gedeckt werden. Seit vielen Jahren kommen die Länder dieser gesetzlichen Vorgabe nicht ausreichend nach, so dass sich bundesweit ein Investitionsstau in der baulichen Struktur vieler Kliniken in Milliardenhöhe angesammelt hat. Die Kliniken sind oftmals gezwungen, notwendige Investitionen und Instandhaltungen aus den laufenden Vergütungen zu finanzieren. Das Defizit der Kliniken Baden-Württembergs summiert sich im forecast auf die Jahresabschlüsse 2024 laut Landkreistagspräsident Joachim Walter auf rund 900 Millionen Euro.

Das ALB FILS KLINIKUM, in hundertprozentig kommunaler Trägerschaft des Landkreises Göppingen, hat sich vor mehr als 10 Jahren gegen die umfassende Sanierung eines Klinikgebäudes zugunsten eines kompletten Neubaus entschieden. Neben essenziellen wirtschaftlichen Gründen standen hier insbesondere prozessuale Optimierungen, die Attraktivität als Arbeitgeber und umfassender Gesundheitsdienstleister sowie die zu erwartenden Neustrukturierungen in der Krankenhauslandschaft im Vordergrund. Das neue Klinikum befindet sich nun im „Endspurt“ der Fertigstellung und wird sich in Teilen über eine „Effizienzrendite“ im Abgleich zum Weiterbetrieb der mehr als 50 Jahre alten Bestandsklinik refinanzieren. Der Grund dafür liegt unter anderem in der strategischen Prämisse des nachhaltigen und hoch energieeffizienten Bauens. Die erwartete Energiepreisentwicklung der kommenden Wirtschaftsperioden wird diese Effizienzrendite des Neubaus weiter steigern.

Raum für modernste prozessoptimierte Medizin und Pflege

Derzeit entsteht mit dem Neubau des ALB FILS KLINIKUMs in Göppingen eine der modernsten Kliniken in Europa. Mit einem Investitionsvolumen von rund 360 Millionen Euro wird auf 43.000 qm Nutzfläche und sieben Vollgeschossen Raum für modernste prozessoptimierte Medizin und Pflege geschaffen. Mit Baubeginn im Jahr 2019 entstehen dort unter anderem zwölf OP-Säle, inklusive Hybrid OP, drei Herzkatheterlabore, vier Kreißsäle, zwei Intensiv- und eine IntermediateCare-Stationen und ein Hubschrauberlandeplatz. Mit 645 Normalstationsbetten, modernster medizinischer Ausstattung sowie hellen und modernen Räumlichkeiten ist der bauliche Grundstein für eine optimale Behandlungsqualität der Patienten gelegt und auch das Personal profitiert von einer positiven Arbeitsplatzgestaltung.

Von der DGNB mit dem Vorzertifikat in Gold ausgezeichnet

Die Deutsche Gesellschaft für Nachhaltiges Bauen (DGNB) bewertet die Nachhaltigkeit eines Gebäudes und hat den Neubau des ALB FILS KLINIKUMs mit dem DGNB-Vorzertifikat in Gold ausgezeichnet. Die DGNB bestätigt damit, dass eine besonders umweltfreundliche, wirtschaftliche, effiziente, ressourcensparende und optimale Gebäudeplanung für den Neubau verfolgt wurde. Das ALB FILS KLINIKUM ist somit das erste „Green Hospital“ in Baden-Württemberg. Das Klinikum hat, der Unternehmensstrategie folgend, bereits vor Baubeginn und zu einem sehr frühen Planungsstadium diesen Ansatz konsequent verfolgt. Ziel war eine nachhaltige Planung und Umsetzung des Neubaus. Der Antrieb bestand im Besonderen darin, die Wirtschaftlichkeit zu erhöhen und mehr Lebensqualität bei gleichzeitig geringeren Betriebskosten zu erreichen – immer mit dem Fokus auf Mensch und Mitwelt.

Nachhaltigkeitsgedanke im Planungsprozess von Anfang an berücksichtigt

Durch die frühe Einstiegsphase konnten bereits wesentliche Optimierungspotenziale in der Grobplanung des Großprojektes berücksichtigt werden. So konnte beispielsweise eine Reduzierung des Wärmebedarfs um circa 60 Prozent sowie die Umsetzung einer Wärmerückgewinnung mit einem Effizienzgrad von über 85 Prozent realisiert werden. Darüber hinaus wurden die Voraussetzungen für weitere Förderungen durch den Bund geschaffen, indem das Haus am Ende des Planungs- und Optimierungsprozesses den extrem hohen Anforderungen des KfW-55-Programms entsprach.

Die Herausforderungen waren groß, aber machbar

Die größte Herausforderung bei der Berücksichtigung des nachhaltigen Ansatzes sind die höheren Kosten für nachhaltige Materialien. Beim Neubau des ALB FILS KLINIKUMs wurde insbesondere die Gebäudehülle nach KfW-55-Standard gebaut – dies war zu Baubeginn der höchste Standard unterhalb des Standards des Passivhauses. Verwirklicht wird außerdem eine komplexe Wärmerückgewinnung über Wärmetauscher. Ein gutes Raumklima wird durch eine „Betonkernaktivierung“ der Decken erreicht und durch die Auswahl besonders nachhaltiger Materialien mit positiven Eigenschaften, wie zum Beispiel geringe Ausdünstung, Langlebigkeit, Ursprung aus nachhaltigen Quellen und geringe Schadstoffbelastung. Ein weiterer wichtiger Baustein zur nachhaltigen Bauweise ist die PV-Anlage mit 425 kwh/p und einer hundertprozentigen Nutzung für den Eigenverbrauch. Grundsätzlich umfasst der Green-Hospital-Ansatz nach DGNB ökologisch-ökonomische, soziokulturelle, technische, prozessuale und standortbezogene Qualitäten und Kernbereiche.

Die positiven Effekte sind vielfältig

Durch die nachhaltige Bauweise erhofft sich das Klinikum, seine Attraktivität für Arbeitnehmer weiter zu steigern, denn die neuen Arbeitsplätze wurden mit viel Tageslicht und kurzen Wegen geplant und realisiert. Weiter sieht das Klinikum einen Wettbewerbsvorteil gegenüber anderen Kliniken bei der Patientengewinnung. Günstigere Bankkredite und Tilgungszuschüsse sind ebenso ein wesentlicher Aspekt, wie auch die Vorreiterrolle für andere Unternehmen. Ein positives Image in der Wahrnehmung der Öffentlichkeit ist bereits heute zu spüren.

Zudem stehen für diese nachhaltige Bauweise KFfW-55-Förderungmittel von der Bundesrepublik Deutschland zur Verfügung. Nach der Vorzertifizierung soll nun abschließend das DGNB-Zertifikat in Gold erreicht werden.

Bereits heute ist das ALB FILS KLINIKUM ein KLIMAWIN-Unternehmen des Umweltministeriums Baden-Württemberg und orientiert sich an den Sustainable Development Goals (SDGs) der Agenda 2030 der United Nation (UN). Die DGNB unterstützt ebenso diese Ziele. Um den Zusammenhang einer nachhaltigen Bauweise mit den SDGs herauszuarbeiten und transparent zu machen, sind sämtliche Kriterien zu den Zielen der UN überprüft. Als Ergebnis erhält jedes Projekt, das eine DGNB-Zertifizierung erfolgreich abschließt, künftig eine Aussage darüber, inwieweit es einen Beitrag zur Erreichung der SDG geleistet hat.

Nachhaltiges Bauen zahlt sich langfristig aus

Vor dem Hintergrund der Entwicklung der Nachhaltigkeit in den vergangenen Jahren und der weiteren Fokussierung der Gesellschaft auf dieses Thema war es in den Planungsjahren des Neubaus, 2014 bis 2018, völlig richtig, den Weg des „Green Hospital“ einzuschlagen. Bereits vor Bezug des Neubaus ist klar, dass das Gebäude in Sachen Nachhaltigkeit, Wirtschaftlichkeit und Flexibilität hohe Maßstäbe setzt – auch mit einem konsequenten Fokus auf biologische und nachhaltige Baustoffe. Hohe Wertstabilität sowie Transparenz bei den eingesparten Ressourcen und Emissionen sind gesetzt. Der Ansatz des nachhaltigen Bauens und der Wunsch, der eigenen Verantwortung gegenüber der Umwelt und ökologischen Werten nachzukommen, führten zu einem langen und manchmal schwierigen, Weg. Anderen Kliniken kann an dieser Stelle nur geraten werden, sich nicht entmutigen zu lassen. Bei der Planung von ähnlichen Bauprojekten rät das Klinikum, den CO2-Ausstoß bei den Entscheidungen mit „einzupreisen“ und in der Betrachtung über die reinen Baukosten hinauszugehen, denn das „Green Hospital“ muss in seinem gesamten Lebenszyklus der Immobilie gesehen werden – Langfristigkeit macht sich hier bezahlt.

Mehr Unterstützung würde helfen

Eine Anregung geht an die Politik auf Bundes- und Landesebene: Hier ist mehr Unterstützung wünschenswert. Bei den aktuellen finanziellen Problemen geht es vielen Kliniken rein ums Überleben. Ohne tiefgreifende Förderprogramme können sie Nachhaltigkeit nicht ausreichend berücksichtigen. Die Politik sollte das Engagement in Nachhaltigkeit und Zukunftsfähigkeit öffentlicher Infrastrukturen auch im Bereich „Green Hospital“ stärker fördern, zum Beispiel durch die Bereitstellung von Beratungs- und Zertifizierungspartnern über Bund und Länder. Dies würde auch längerfristige Transformationsprozesse hin zum „Green Hospital“ bei Bestandsimmobilien ermöglichen. So könnte das „Green Hospital“ zum Standard-Hospital werden – zumindest für Neubauten wäre es wünschenswert. Durch die aktuellen Rahmenbedingungen im Gesundheitswesen und den hohen Kostendruck im System wird es sich aber ohne weitere Anreiz- und Fördersysteme nur sehr langsam etablieren können. Der Fokus im Gesundheitssystem muss sich grundsätzlich aber auch an den Vorgaben und Klimazielen der UN und der EU orientieren. Auch die langfristige Unterstützung von öffentlicher Seite ist zwingend notwendig. Der öffentliche Gesundheitssektor wird diesen tiefgreifenden Transformationsprozess nur mit Unterstützung durch Bund und Länder leisten können. Ein gutes Beispiel könnten hier Vergleichsprojekte, wie beispielsweise die Digitalisierung mit der Förderung durch das KrankenhausZukunftsGesetz (KHZG) sein.

Über die Autoren:

Dr. Ingo Hüttner ist medizinischer Geschäftsführer sowie Vorsitzender der Geschäftsführung der ALB FILS KLINIKUM GmbH. Seit 2021 gehört Dr. Hüttner dem Vorstand der DGQ an.

Wolfgang Schmid ist Kaufmännischer Geschäftsführer der ALB FILS KLINIKUM GmbH.

Bildnachweis: ©Max Radloff Photography

Künstliche Intelligenz & Nachhaltigkeit – Was bedeutet das für die Weiterbildung?

Die Anfänge von Künstlicher Intelligenz (KI) gehen zurück bis in die 1950er-Jahren. Seitdem gab es vier Wellen der Künstlichen Intelligenz. Die Energie für die Verarbeitung von Daten wird zumeist fossil generiert und dies führt zu klimarelevanten Emissionen. KI-Algorithmen können zur gezielten Überwachung und Manipulation eingesetzt werden, was ethische Fragestellungen aufwirft. Überdies werden im Bildungswesen immer mehr KI-generierte Texte verwendet, was zudem die Frage aufwirft, wie zukünftig Lehr- und Lernformate sinnvoll gestaltet werden können, damit Lernende und Lehrende einen Mehrwert durch KI haben.

Die Begriffe – „Künstliche Intelligenz“ und „Nachhaltigkeit“

„Künstliche Intelligenz“ (KI) soll einen Computer dazu bringen, menschliches Verhalten zu imitieren. KI ist ein komplexes und umfangreiches Teilgebiet der Informatik. Bisher geht man von vier KI-Wellen aus. Die letzte, in der wir uns gerade befinden, gilt als sehr vielversprechend.

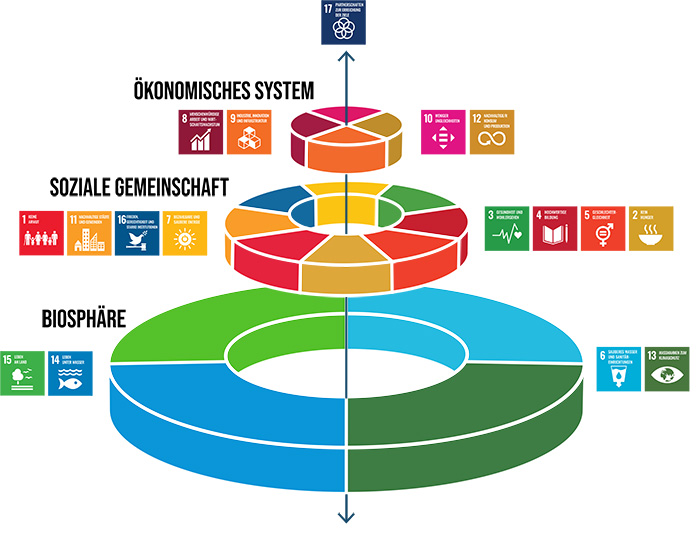

„Nachhaltigkeit“ bedeutet laut Weltkommission für Umwelt und Entwicklung, die Bedürfnisse eines Menschen zu befriedigen, ohne die Fähigkeit künftiger Generationen zu gefährden, ihren eigenen Bedürfnisse nachzugehen (vgl. WCED, 1987). Nachhaltigkeit beruht auf drei Säulen (sozial, wirtschaftlich, ökologisch) und stellt den Menschen in den Mittelpunkt. Zum Konzept gehören außerdem Umweltschutz, Gerechtigkeit, Ganzheitlichkeit und Langfristigkeit (siehe Abb. 1).

Abb. 1: Konzept der Nachhaltigkeit (Barbian, D., 2001)

Die vier Wellen der Künstlichen Intelligenz

Man unterscheidet vier Phasen der KI (vgl. Mertens, P., Barbian, D., Baier, S., 2017). In der ersten Phase wurden dem Computer “allgemeine” Problemlösungsfähigkeiten („General Problem Solver“) zuerkannt. Damit gelangte man schnell an Grenzen. Es erfolgte ein Paradigmenwechsel und man setzte sich das Ziel, Experten auf ihrem Spezialgebiet zu unterstützen (“Expertensysteme” (XPS)). Die dritte Phase war kurz und betraf Semantische Netze. Damit wurden Beziehungen zwischen Begriffen modelliert, zum Beispiel die Beziehung einer Bildungseinrichtung zu Kursteilnehmenden, zu den Lehrformaten etc. Auch die dritte KI-Welle erfüllte nicht die Erwartungen. Derzeit befinden wir uns in der vierten Welle. Nach dem Prinzip von Nervenzellen (Neuronen) werden künstliche neuronale Netze eingesetzt (vgl. Matzka, S., 2021). Für das Trainieren dieser Art von KI wird jedoch viel Energie benötigt, womit gerade die vierte Welle einen enormen Einfluss auf das Erreichen der Klimaziele hat (Es gibt KI-Algorithmen, die zu ähnlich guten Ergebnissen wie das künstliche neuronale Netz führen. Dazu zählen u.a. die logarithmische Regression, der Bayes‘sche Algorithmus und Decision Tree.)

Bereits 2019 machte der CO2-Ausstoß des globalen Datenverkehrs laut Think Tank The Shift Project 4% aus.

| Berufsbild Nachhaltigkeitsmanager Die Themen Nachhaltigkeit und Klimaschutz gehören zu den Megatrends unserer Zeit. Für Unternehmen wird es somit immer wichtiger, CSR-Maßnahmen umzusetzen und ihrer gesellschaftlichen Verantwortung gerecht zu werden. Mit dem größeren Fokus auf Nachhaltigkeit haben sich in den letzten Jahren eine Vielzahl an grünen Jobs entwickelt, wie beispielsweise der Job als Nachhaltigkeitsmanager. Antworten auf die wichtigsten Fragen finden Sie in unserem Berufsbild zum Nachhaltigkeitsmanager:

|

Einsatzszenarien von KI in der Weiterbildung – Vorteile und Herausforderungen

KI in der Weiterbildung kann Vorteile für Lernende und Lehrende bieten, jedoch sind auch die Herausforderungen nicht außer Acht zu lassen. Texte und Bilder mit KI zu generieren, ist durch den Einzug von ChatGPT einfacher denn je. Etwa 38 % der Schüler:innen in Deutschland nutzen dies laut Statista bereits. Überwiegend sind es jüngere Menschen, die von KI Gebrauch machen. Es ist daher angebracht, sich die Frage zu stellen, wie Lehr- und Lernformate zu gestalten sind.

Ein Vorteil durch den Einsatz von KI gestaltet sich für Menschen mit unterschiedlichen Lerntempos. Hier können KI-basierte Lernformate sich individuell an die Bedürfnisse anpassen sowie den Lernfortschritt verfolgen (adaptives Lernen). Weitere Vorteile für Weiterbildungsformate liegen in der Möglichkeit, Daten schnell zu analysieren. Damit können große Mengen an Lerndaten bewertet und Muster erkannt werden, die dann gezielt zur Unterstützung von Lehrenden und Lernenden genutzt werden können. Für die kontinuierliche Weiterbildung und berufliche Entwicklung bietet KI personalisierte Lernpfade etwa für berufstätige Personen, um sich gezielt weiter zu qualifizieren oder um Vorschläge zu Weiterbildungen zu erhalten. Bei der Bewertung von Prüfungen und Aufgaben bieten zudem automatisierte Systeme ein schnelles und sofort verfügbares Ergebnis. KI hat außerdem das Potenzial inklusiv zu sein, indem Lernmaterialien für Menschen mit Behinderungen zugänglicher gemacht werden.

Neben all diesen Vorteilen gibt es jedoch auch Herausforderungen. Zum einen hat KI einen erheblichen Einfluss auf das Klima und birgt ethische Gefahren bei der Nutzung.

KI-basierte Systeme sind sehr rechenintensiv. Sie müssen eine große Menge an Daten verarbeiten, was den Bedarf und die Abhängigkeit von Energie erhöht. Es ist nach wie vor schwierig, den genauen CO2-Ausstoß von KI zu quantifizieren. Einige wenige Organisationen versuchen, oftmals mit frei verfügbaren Tools die Umweltauswirkungen von KI zu ermitteln. Dazu gehören z. B. das Montreal Institute for Learning Algorithms mit dem Tool ML CO2 Impact , die Plattform CodeCarbon, und Climate Change AI.

Für eine nachhaltige KI (auch “Green AI” bzw. “Grüne Künstliche Intelligenz”) müsste neben der genauen Klimabilanz im Vorfeld ihres Einsatzes zunächst auch Transparenz zu den erhobenen Daten bestehen. Künstliche Intelligenz (KI) hat daher auch eine ethische Relevanz in der Weiterbildung. Dies betrifft den Datenschutz und die Sicherheit, da KI-Systeme große Mengen an persönlichen Daten sammeln können. Die Überwachung durch KI kann die Privatsphäre der Lernenden gefährden. Auch kann es zu einer Diskriminierung kommen, da KI bestehende Vorurteile verstärken und zu ungleichen Chancen führen kann. Die Qualität der Bildung könnte durch übermäßige Standardisierung und Abhängigkeit von der KI-Technologie leiden, was die Vielfalt und menschliche Interaktion mindert.

Mit besonders sensiblen Daten sollte auch aus Gründen der sozialen Nachhaltigkeit (s. Abb. 1) vorsichtig umgegangen werden. Unternehmen können durch eine Auswertung von Daten mehr über ihre Mitarbeitenden erfahren. Auch eine Manipulation und Überwachung ist möglich. Damit wirft der Einsatz von KI ethische Fragestellungen auf, was Sarah Spiekermann bereits 2019 in ihrem Buch über „Digitale Ethik“ thematisiert hat (Spiekermann, S., 2019). Das Sammeln von Daten durch Suchmaschinen erfolgt oft über sogenannte Tracking-Dienste. Dazu laufen im jeweiligen Tool entsprechende Dienste ab, die Daten z. B. zum Standort, den eingegebenen Suchwörtern, verwendeter Internet-Browser sammeln (Zuboff, S., 2018).

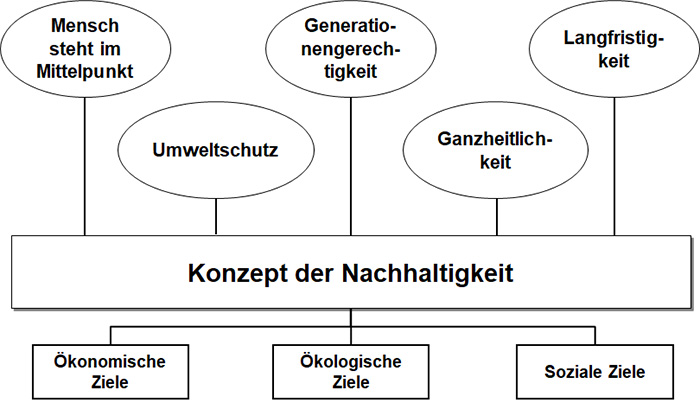

Bezug der KI zu den 17 Nachhaltigkeitszielen der Vereinten Nationen

KI spielt eine wichtige Rolle bei der Erreichung der 17 Ziele für eine nachhaltige Entwicklung (siehe Abb. 2) und hat das Potenzial, die globalen Bemühungen zur Gewährleistung einer Bildung für alle zu erreichen. Das UN-Nachhaltigkeitsziel Nr. 4 bezieht sich auf eine „Hochwertige Bildung“. Laut Definition soll eine inklusive, gleichberechtigte und hochwertige Bildung gewährleistet und Möglichkeiten lebenslangen Lernens für alle gefördert werden, unabhängig von Geschlecht, Herkunft oder Behinderung.

Abb. 2: Die Nachhaltigkeitsziele der Vereinten Nationen (DGVN, 2024)

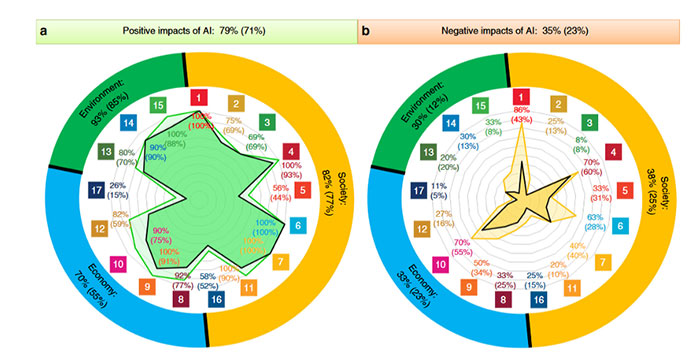

Die Studie “The role of artificial intelligence in achieving the Sustainable Development Goals“ (Vinuesa, R. et al., 2020) untersucht den potenziellen Einfluss von KI auf die 17 Nachhaltigkeitsziele der Vereinten Nationen (siehe Abb. 3). Laut der Studie könnten 134 der 169 Unterziele (79%) von der KI profitieren. Auf der anderen Seite gibt es aber auch einen negativen Einfluss der KI auf die Nachhaltigkeit, denn 59 der 169 Unterziele (35%) werden verschlechtert. Insgesamt überwiegt aber der positive Einfluss, jedoch muss der Einsatz von KI und die Art des Einsatzes bereits im Vorfeld genau überlegt werden.

Abb. 3: Positive und negative Auswirkungen von KI auf die Nachhaltigkeit (Vinuesa, R. et al., 2020)

Auch für eine „Hochwertige Bildung“ (Ziel Nr. 4) gibt es laut Abbildung 3 eher Chancen durch den Einsatz von KI.

Fazit

Künstliche Intelligenz und Nachhaltigkeit bedingen sich gegenseitig. Der hohe Energieverbrauch durch KI und ethische Fragestellungen haben einen Einfluss auf die Nachhaltigkeit. Bisher spielen diese Faktoren noch keine übermäßige Rolle in der Weiterbildung. Allerdings darf der Gebrauch von ChatBots wie bspw. ChatGPT gerade unter der jüngeren Bevölkerung nicht unterschätzt werden. Dies wirft Fragen auf, wie in Zukunft Lehr- und Lernformate gestaltet werden sollen.

KI bietet zwar Chancen für die Weiterbildung durch personalisiertes Lernen, eine Effizienzsteigerung und datengetriebenes Lernen. Gleichzeitig birgt sie Gefahren wie Datenschutzprobleme, mögliche Diskriminierung und ethische Dilemmata.

Tendenziell überwiegen jedoch die Vorteile durch KI. KI hat das Potenzial, die Weiterbildung zu revolutionieren, aber es sind sorgfältige Maßnahmen notwendig, um die Risiken zu minimieren und die Vorteile fair und ethisch zu nutzen.

Über die Autorin:

Dr. Dina Barbian ist Geschäftsführerin des eco2050 Institut für Nachhaltigkeit, einer Ausgründung der Universität Erlangen-Nürnberg. Sie ist als Beraterin für Unternehmen zu Themen wie Nachhaltigkeitsmanagement, CSR und Klimabilanzierung tätig sowie Autorin von Büchern und Fachartikeln. Als Lehrbeauftragte hält sie Vorlesungen in den Disziplinen Informatik, Ingenieurwesen und Nachhaltigkeit. Die Wirtschaftsingenieurin und promovierte Nachhaltigkeitsökonomin ist DGQ-Trainerin und -Prüferin.

WCED – World Commission on Environment and Development (1987): Our Common Future, New York Barbian, D. (2001) Ökonomie und Sustainable Development, Aachen, S. 64 Mertens, P., Barbian, D., Baier, S. (2017) Digitalisierung und Industrie 4.0 – eine Relativierung, Wiesbaden Matzka, S. (2021) Künstliche Intelligenz in den Ingenieurwissenschaften, Wiesbaden Spiekermann, S. (2019) Digitale Ethik: Ein Wertesystem für das 21. Jahrhundert, München Zuboff, S. (2018) Das Zeitalter des Überwachungskapitalismus, Frankfurt am Main / New York DGVN – Deutsche Gesellschaft für die Vereinten Nationen e.V. (2024), Ziele für Nachhaltige Entwicklung (https://dgvn.de/ziele-fuer-nachhaltige-entwicklung) Vinuesa, R. et al. (2020): The role of artificial intelligence in achieving the Sustainable Development Goals. NATURE COMMUNICATIONS, S.1-2

Literaturverzeichnis

Grüne Gesundheit: Nachhaltigkeit und Klimaschutz im Gesundheitswesen

In den letzten Jahren haben die Themen Nachhaltigkeit und Klimaschutz in nahezu allen Lebensbereichen an Bedeutung gewonnen. Besonders im Gesundheitswesen, einem der größten und ressourcenintensivsten Sektoren, ist die Notwendigkeit für Maßnahmen in Richtung nachhaltigeren Handelns evident. Der Klimawandel hat nicht nur für den Planeten drastische Folgen, sondern auch für die menschliche Gesundheit. Die klimatischen Veränderungen begünstigen die Zunahme von Allergien, Erkrankungen der Atemwege und des Herz-Kreislauf-Systems, sie führen zu steigenden Infektionszahlen und zur Zunahme von psychischen Erkrankungen wie Depressionen. Nachhaltigkeit und Klimaschutz anhaltend in den Fokus des Handelns im Gesundheitswesen zu rücken, ist somit von großer Relevanz.

Doch was bedeutet „Nachhaltigkeit“ und welche Ansätze gibt es, um Gesundheitseinrichtungen wie Krankenhäuser nachhaltiger und das Handeln im Einklang mit den Bemühungen um Klimaneutralität zu gestalten?

Die drei Dimensionen der Nachhaltigkeit

Das Bundesministerium für wirtschaftliche Zusammenarbeit und Entwicklung versteht den Begriff als ethisches Handlungsprinzip, das uns verpflichtet, „die Bedürfnisse der Gegenwart so zu befriedigen, dass die Möglichkeiten zukünftiger Generationen nicht eingeschränkt werden.“ Konkretisiert wird diese recht vage Definition durch das Drei-Säulen-Modell. Die drei Säulen bilden

- die Ökologie,

- die Ökonomie und

- das Soziale.

Der Parlamentarische Beirat für nachhaltige Entwicklung des Bundestages formuliert eine konkretere Handlungsmaxime: „Wir dürfen nicht heute auf Kosten von morgen leben! Wir sollen nicht mehr verbrauchen, als künftig wieder bereitgestellt werden kann.“ Angesichts der massiven Effekte des Klimawandels und den Auswirkungen für zukünftige Generationen liegt der Fokus der Diskussionen um Nachhaltigkeit und nachhaltiges Handeln auf der Säule „Ökologie“.

Nachhaltigkeit und Klimaschutz im Gesundheitswesen: Status Quo

Der Gesundheitssektor in Deutschland ist ein Wirtschaftszweig mit großer ökonomischer Bedeutung und spielt eine zentrale Rolle bei der Gesundheitsversorgung der Bevölkerung. Im Jahr 2022 betrugen die Gesundheitsausgaben in Deutschland 497,7 Milliarden Euro, was etwa 12,8 Prozent des Bruttoinlandsprodukts (BIP) ausmachte. Derzeit arbeiten rund 6 Millionen im Gesundheitswesen. Das entspricht etwa 17,7 Prozent der Gesamtbeschäftigung. Jeder achte Erwerbstätige in Deutschland ist somit in einer Einrichtung des Gesundheitswesens beschäftigt. Die Tendenz ist schon seit Jahren steigend.

Krankenhäuser und andere Gesundheitseinrichtungen verbrauchen global große Mengen an Energie und Wasser, erzeugen erhebliche Mengen an Abfall und emittieren eine Vielzahl von Schadstoffen. Die Bundesärztekammer berichtet mit Verweis auf den „Health care climate footprint report“, dass der Gesundheitssektor mit zwei Gigatonnen CO2 Äquivalent pro Jahr für 4,4 Prozent der globalen Nettoemissionen verantwortlich ist. Zur besseren Einordnung dieser Zahl bietet die Kammer einen anschaulichen Vergleich: „Wäre der globale Gesundheitssektor ein Land, wäre er der fünftgrößte Emittent von Klimagasen im weltweiten Ranking der Länder.“ Das Gesundheitswesen verursacht aktuell gar mehr Schadstoffemissionen als der Flugverkehr oder die Schifffahrt, zu dem Ergebnis kommt das von PwC veröffentlichte Healthcare-Barometer 2022. Mit rund 71 Prozent verursachen Medizinprodukte und die mit ihnen verbundenen Lieferketten den größten Anteil der Emissionen. Mit rund 5 Prozent des Gesamtrohstoffkonsums in Deutschland liegt das Gesundheitswesen auch in diesem Bereich weit vorne.

Die Aktivitäten des Gesundheitswesens tragen somit maßgeblich zur Belastung unseres Klimas und der Umwelt bei. Zugleich bedeutet dies, dass durch das Ergreifen geeigneter Maßnahmen ein signifikanter Beitrag für mehr Nachhaltigkeit und Klimaschutz beleistet werden kann.

| Berufsbild Klimaschutzmanager Kommunen und Unternehmen werden sich zunehmend ihrer Verantwortung für und den Herausforderungen durch den Klimawandel bewusst. Sie suchen daher immer häufiger nach Fachexperten, die sie bei der Umsetzung von Klimaschutzstrategien unterstützen können. Durch ihre Tätigkeit tragen Klimaschutzmanager dazu bei, Treibhausgasemissionen der Unternehmen und Kommunen zu reduzieren. Antworten auf die wichtigsten Fragen finden Sie in unserem Berufsbild zum Klimaschutzmanager:

|

Strategien und Maßnahmen zur Förderung der Nachhaltigkeit und des Klimaschutzes

Welche Maßnahmen sind nun geeignet, um Nachhaltigkeit und Klimaschutz im Gesundheitswesen anhaltend zu verankern? Es gibt eine Vielzahl von teilweise niedrigschwelligen Möglichkeiten und verschiedenen Ansatzpunkte. Um den Unternehmen den ersten Schritt in Richtung Handeln zu erleichtern, hat die Arbeitsgruppe „Klimawandel“ der Bundesärztekammer zehn Handlungsfelder identifiziert und für jedes Empfehlungen erarbeitet.

Die folgende Auflistung soll einen Eindruck vermitteln und einen Überblick geben:

- Unternehmensführung, bspw. Etablierung eines Berichtswesens zum CO2-Fußabdruck und zu den ergriffenen Maßnahmen, um den CO2-Ausstoß zu reduzieren.

- Energieverbrauch, bspw. Optimierung des Einsatzes von Energie zur Warmwassererzeugung durch Einsatz erneuerbarer Energien und durch Einsatz wassersparender Steuerungsmechanismen

- Gebäude und Gelände, bspw. Ausweitung von Grünanlagen inklusive Förderung der Biodiversität, klimaadaptierte Baumpflanzung

- Anästhesiegase / Inhaler / chemische Stoffe, bspw. Auffangen des freiwerdenden CO2 durch Filter, Reduktion von Inhalationssprays / Inhaler wo möglich durch Nutzung anderer Darreichungsformen der Medikamente

- Wasser, bspw. Minimierung des Wasserverbrauchs durch Sammeln von Regenwasser zur Bewässerung von Gartenanlagen

- Abfall, bspw. Reduktion der Verwendung von Einmalprodukten, Umstellung auf Recyclingpapier, Papiervermeidung durch Digitalisierung

- Transport, Vermeidung unnötiger Fahrten/Reisen durch Videokonferenzen und -sprechstunden, Teilnahme an Programmen zum Fahrradleasing

- Einkauf, bspw. Optimierung der Lieferketten

- Ernährung, bspw. vermehrte Nutzung lokaler und saisonaler Produkte für Patienten, Mitarbeiter und Besucher, vermehrt vegetarische Küche

- Büro / EDV, bspw. Nachhaltigkeit im Internet bei der Auswahl von Suchmaschinen und E-Mail-Diensten

Selbstredend dürfen die Maßnahmen die Einhaltung medizinischer Standards nicht gefährden. Das Patientenwohl ist nach wie vor das oberste Gut im Gesundheitswesen. In vielen Fällen sind die Maßnahmen zunächst mit Investitionen verbunden. Mittel- und langfristig können die Unternehmen jedoch anhaltend ihre Kosten reduzieren und möglicherweise ihre Prozesse effizienter gestalten.

Die Treiber für mehr Nachhaltigkeit und Klimaschutz im Gesundheitswesen

Die Einführung nachhaltiger Praktiken im Gesundheitswesen wird von einer Vielzahl von Faktoren und Treibern beeinflusst. Sie lassen sich in verschiedene Kategorien einteilen, die alle dazu beitragen, dass der Sektor ökologisch verantwortungsvoller wird.

- Medizinischer und technologischer Fortschritt:

Moderne Technologien wie energieeffiziente medizinische Geräte, digitale Gesundheitslösungen und telemedizinische Anwendungen haben nicht nur das Potential, die Qualität von und den Zugang zu Gesundheitsdienstleistungen zu steigern, sondern zugleich den Ressourcenverbrauch drastisch zu senken. Beispielsweise ermöglichen digitale Patientendaten eine effizientere Verwaltung bei verringertem Papierverbrauch.

- Demografische Veränderungen und steigende Gesundheitskosten:

Die alternde Bevölkerung in vielen Industrieländern führt zu einer erhöhten Nachfrage nach Gesundheitsdienstleistungen. Diese steigende Nachfrage übt Druck auf die Gesundheitssysteme aus und macht effiziente, nachhaltige und kostensensitivere Lösungen notwendig. Nachhaltige Praktiken, die beispielsweise den Energie- und Ressourcenverbrauch reduzieren und Abfall minimieren, tragen wesentlich dazu bei, die Betriebskosten der Einrichtungen zu senken.

- Gesetzliche und regulatorische Anforderungen:

Regierungen und internationale Organisationen arbeiten stetig an der Umsetzung neuer Vorschriften und Standards und stellen zunehmend strengere Anforderungen an die Einrichtungen des Gesundheitswesens. Die Richtlinie (EU) 2022/2464 zur Nachhaltigkeitsberichterstattung beispielsweise, die am 5. Januar 2023 in Kraft getreten und bis Mitte dieses Jahres in nationales Recht umzusetzen ist, bedeutet für die Unternehmen umfassende Änderungen der Anforderungen hinsichtlich der nichtfinanziellen Berichterstattung.

Die Hürden für mehr Nachhaltigkeit und Klimaschutz im Gesundheitswesen

Während der demografische Wandel, die zunehmende Digitalisierung und der technologische Fortschritt einerseits Treiber für mehr Nachhaltigkeit und Klimaschutz sein können, stellen sie Gesundheitseinrichtungen zugleich vor große Herausforderungen. Viele Häuser schaffen es angesichts der vielfältigen Anforderungen nicht, das in den Trends liegende Potenzial für ihre Organisation zu heben. Zugleich hemmen Entwicklungen wie der Fachkräftemangel die Verankerung von Nachhaltigkeit und Klimaschutz: Ein vom Bundesgesundheitsministerium in Auftrag gegebenes Gutachten nennt zudem die folgenden Faktoren als wesentliche Hemmnisse:

- Fehlende Anreize und Informationen: Angesichts fehlender monetärer oder regulatorischer Anreize entscheiden sich Unternehmen oft, sich nicht mit der Umsetzung von Maßnahmen zu beschäftigen. Zugleich fehlen in vielen Fällen Informationen zur Finanzierung von Nachhaltigkeitsmaßnahmen.

- Organisatorische Einschränkungen: Belange der Nachhaltigkeit werden in der Regel nicht im Management thematisiert und sind nur wenig in den Leitungsebenen der Unternehmen verankert.

- Ressourcenmangel: Es mangelt den Einrichtungen an Zeit, Geld und Personal.

Fazit

Wenngleich es praxistaugliche und teils niedrigschwellige Ansatzpunkte gibt, wird im Gesundheitswesen aktuell zu wenig Gewicht auf nachhaltige Praktiken gelegt. Um Nachhaltigkeit dauerhaft in den Prozessen zu verankern, bedarf es weiterer Impulse und regulatorischer Vorgaben, sowie der Platzierung des Themas auf Leitungsebene. Die Effekte des Klimawandels werden zunehmend deutlich. Die Bedrohungen für Gesellschaft und Umwelt betreffen alle. Jeder Akteur steht in der Pflicht, einen Beitrag zu leisten. Diese Sicht teilt auch die Ärzteschaft. Der 125. Deutsche Ärztetag konstatierte die Notwendigkeit einer nationalen Strategie für eine klimafreundliche Gesundheitsversorgung und fordert Klimaneutralität bis 2030. An geeigneten Maßnahmen fehlt es nicht. Seitens der Politik bedarf es jedoch der Schaffung der notwendigen Rahmenbedingungen und seitens der Unternehmen des Umsetzungswillens. So oder so, die Effekte des Klimawandels werden sich auch in Zukunft zunehmend verschärfen und die Menschen begleiten.

Über die Autorin:

Nathalie Roskaritz ist Produktmanagerin und in der DGQ Weiterbildung für die Angebote im Bereich Qualitätsmanagement im Gesundheits- und Sozialwesen verantwortlich.

Änderung der Gesundheits-Versorgung ohne Pflegeperspektive

Das Gesetz zur Verbesserung der Versorgungsqualität im Krankenhaus und zur Reform der Vergütungsstrukturen (KHVVG) findet große öffentliche Aufmerksamkeit. Die Bundesregierung ist angetreten, mit dieser Initiative die Weichen für die Bewältigung massiver Herausforderungen im Gesundheitssystem zu stellen. Gleichzeitig soll die in Deutschland vergleichsweise hohe Qualität der Krankenhausversorgung erhalten bleiben. Dabei benennt das Gesetz auch den besonderen Stellenwert der Pflege.

Traditionelles Denkmodell

Nach der einleitenden Nennung der Pflege als wichtigem Garanten für die Qualität der Versorgung, fällt sie anschließend in Bezug auf die gesetzlichen Regelungen zurück. Es werden nur noch medizinische Verbesserungen aufgeführt, obwohl es dem Namen nach um die „medizinisch-pflegerische“ Versorgung geht.

Die Perspektive des Gesetzgebers ist vielmehr ausschließlich die der Medizin. Das macht unter anderem die neue Finanzierungssystematik deutlich. Denn die begrüßenswerte Einführung von Leistungsgruppen umfasst ausschließlich medizinische Behandlungen. Entsprechend müssten sie eigentlich medizinische Leistungsgruppen heißen. Die pflegerischen Leistungsprozesse werden – der Denk-Tradition einer überlagernden Disziplin Medizin folgend – in dem Finanzierungssystem quasi als Anhängsel ärztlicher Tätigkeit betrachtet und nicht angesprochen.

Die medizinische Sichtweise spiegelt sich in der Wortwahl. Zum Beispiel ist mit ambulanter Versorgung die medizinische Infrastruktur außerhalb des Krankenhauses gemeint – und nicht pflegerische Leistungen in der Häuslichkeit nach der Pflegeversicherung. Die engere Verzahnung der stationären und der ambulanten Versorgung ist in der Medizin den großen Herausforderungen an dieser Schnittstelle geschuldet und ein unausweichliches Gebot.

Qualität der Pflege nicht im Fokus

Das träfe in der Tat genauso für die Pflege zu, sowohl beim Übergang vom Krankenhaus zur ambulanten Pflege in der Häuslichkeit, als auch an der Schnittstelle zwischen häuslicher Pflege und Heim. Dass dies umgekehrt eine Wirkung auf die medizinische Leistungsqualität hat, belegen die Versorgungslücken mit Drehtüreffekt zwischen Krankenhaus und Langzeitpflege. Das Gesetz nimmt darauf auch Bezug, indem interdisziplinäre und interprofessionelle Chancen insbesondere im Entlassungsfall erwähnt werden.

Aber es gibt keine konkreten Anreize, diese Verzahnung zwischen Medizin und Pflege auf Augenhöhe zu fördern und die Verantwortung der Pflege an dieser Schnittstelle zu stärken. Zwar lässt der Gesetzgeber mit dem Vorschlag, bestimmte Krankenhäuser zu sogenannten sektorenübergreifenden Versorgungseinrichtungen zu entwickeln, auch die Leistungserbringung von Kliniken aus der Pflegeversicherung zu. Medizinisch-pflegerische Behandlung soll dort aber nach wie vor auf ärztliche Anordnung nur zum Ziele der Absicherung einer medizinischen Therapie stattfinden.

Auch an dieser Stelle zeigt sich, dass eine pflegerische Perspektive fehlt und der entsprechende fachliche Diskurs keine Berücksichtigung findet. Der konzentriert sich nämlich in den letzten Jahren pflegesektorenübergreifend auf die personenzentrierte Pflege. Die spielt auch im Krankenhaus eine wichtige Rolle, wenn Menschen nicht allein auf die somatischen Defizite reduziert werden, sondern pflegerisches Handeln soziale, psychische und körperliche Dimensionen gleichermaßen einbezieht.

Wichtige Bedarfe von Patient:innen und Pflegenden bleiben unberücksichtigt

Außerdem liegt das Augenmerk im KHVVG klar auf Struktur- und Prozess-Merkmalen. Die sind sehr wichtig, wenn es zum Beispiel um die personelle und technische Ausstattung von Kliniken geht, die komplexe Leistungen anbieten. Für Patient:innen wäre aber wohl eine transparente Darstellung der Ergebnisqualität wünschenswert. Denn nicht allein die Quantität der vorgehaltenen Ressourcen entscheidet über die Qualität der Leistungen. Vielmehr gibt es für Klient:innen und Patient:innen viele Kriterien, die in der Summe ein gutes Outcome liefern. Doch dieses Projekt mit der Darstellung medizinischer Behandlungsergebnisse ist bis auf weiteres verschoben.

Eine der Achillesfersen der Krankenhausfinanzierung ist die Auslastung, die wiederum Hand in Hand geht mit den Personalvorgaben im Pflegebereich. Hier ergibt sich keine wesentliche Änderung, die zu einer Steigerung der Attraktivität des Arbeitsplatzes Krankenhaus für Pflegekräfte führen würde und so dazu beitragen könnte, das Auslastungspotenzial zu verbessern.

Im Gegenteil kann nur gemutmaßt werden: Mit der Verringerung der Anzahl an Krankenhäusern durch das KHVVG sollen Kräfte freigesetzt werden, die den demografiebedingt größeren Pflegepersonalbedarf in den verbliebenen Kliniken decken sollen. Dazu wäre unter anderem zusätzlich eine Ausbildungsoffensive erforderlich, um die veränderten Qualifikations-Bedarfe durch die Konzentration von Leistungen an bestimmten Orten aufzufangen.

Kein Empowerment für die Qualität der Pflege

In der Summe ist das KHVVG aus Sicht der Qualität der pflegerischen Versorgung ernüchternd. Die Versorgungsperspektive ist medizinisch, Indikatoren für die Ergebnisqualität werden nicht neu geregelt, eine Förderung der disziplin- und sektorenübergreifenden Leistungserbringung unter besonderer Berücksichtigung der Pflege findet nicht statt. Hier werden Potenziale der Reform verschenkt. Für Pflegepersonal ergeben sich außerdem Standort- und Qualifikationsfragen, die eine veränderte Krankenhausstruktur mit weniger Kliniken und größerer Spezialisierung mit sich bringen. Entsprechende Entwicklungs-Anreize lässt das Gesetz vermissen.

Über den Autor:

Holger Dudel ist Fachreferent Pflege der DGQ. Er ist gelernter Krankenpfleger und studierter Pflegepädagoge und Pflegewissenschaftler. Er hat zuvor Leitungsfunktionen bei privaten, kommunalen und freigemeinnützigen Trägern der Langzeitpflege auf Bundesebene innegehabt. Qualität im Sozialwesen bedeutet für ihn, dass neben objektiver Evidenz auch das „Subjektive“, Haltung und Beziehung ihren Platz haben.

Automatisierte Oberflächeninspektion dank industrieller Bildverarbeitung – welche Möglichkeiten gibt es?

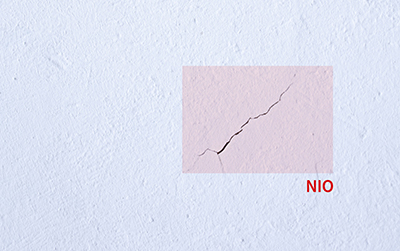

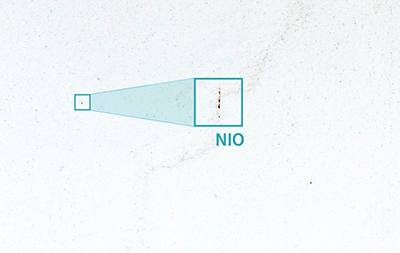

Ein feiner Riss, eine abgebrochene Ecke, eine verfärbte Stelle – und es winkt die kostspielige Reklamation. Oberflächen sind der erste Kontaktpunkt zwischen einem Produkt und einem Kunden. Bereits kleinste Makel stören das Gesamtbild und beeinträchtigen die Kundenzufriedenheit. Neben ästhetischen Aspekten wirken sich viele Fehler auf die Funktionalität eines Produktes aus und reduzieren dessen Lebensdauer. Die Inspektion von Oberflächen bildet daher einen unverzichtbaren Bestandteil der Qualitätsprüfung.

Warum die manuelle Oberflächeninspektion an ihre Grenzen stößt

Oberflächenfehler sind vielfältig. Verschmutzungen und Verfärbungen entstehen oft durch Kontaminationen während der Produktion. Beim Gießen von Kunststoff oder Beton führen Verdichtungsfehler zu Lunkern im Material. Kratzer entstehen durch Reibung mit Schmutzpartikeln, während Risse unter anderem durch Spannungskonzentrationen oder hohe Temperaturen auftreten.

|

|

|

| Abb. 1: Automatisierte Risserkennung auf Beton (© IDS Imaging Development Systems GmbH) | Abb. 2: Automatisierte Risserkennung auf Beton (© IDS Imaging Development Systems GmbH) |

Unterschiedliche Werkstoffe bringen zusätzliche Herausforderungen mit sich. Spiegelnde Materialien wie Metalle, Lack und Glas erzeugen je nach Lichteinfall unterschiedliche Reflexionen, die Oberflächenfehler leicht tarnen. Gekrümmte Objekte erschweren es, alle Winkel zuverlässig zu inspizieren.

Weitere Schwierigkeiten sind komplexe oder sehr kleine Fehler, die mit bloßem Auge kaum erkennbar sind. Hohe Stückzahlen pro Tag machen die Oberflächeninspektion zu einer monotonen Tätigkeit, bei der Konzentrationsschwächen auftreten können. All diese Aspekte gestalten eine manuelle Inspektion fehleranfällig.

Bildverarbeitungslösungen machen unsichtbare Fehler sichtbar

Ob hundert oder tausend Teile – eine maschinelle Prüfung führt Oberflächenprüfungen zuverlässig durch und erzielt reproduzierbare Ergebnisse. Dafür werden Industriekameras beispielsweise über Förderbändern installiert. Die Kameras erzeugen hochauflösende Bilder der Objekte, die im Anschluss von einer Bildverarbeitungssoftware analysiert werden. Klassische Bildverarbeitung arbeitet mit vordefinierten Regeln und Algorithmen. Auf dieser Basis untersuchen Kameras Objekte Pixel für Pixel. Die Bildverarbeitungssoftware extrahiert Merkmale aus den Bildern und analysiert, ob sie mit den festgelegten Regeln übereinstimmen. Im Gegensatz zum menschlichen Auge ermöglicht die Bildverarbeitung eine kontinuierliche Überwachung aus verschiedenen Blickwinkeln und erkennt selbst mikroskopisch kleine Abweichungen vom Soll-Zustand.

Noch flexibler dank künstlicher Intelligenz

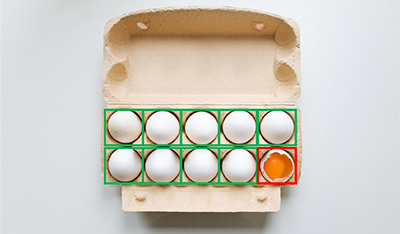

Viele Bildverarbeitungslösungen nutzen heutzutage künstliche Intelligenz (KI). Diese lernt, ähnlich wie ein Mensch, anhand von Bildern und Merkmalen, wie der gewünschte Zustand der zu prüfenden Objekte aussieht. Nach der Trainingseinheit ist sie in der Lage, unter verschiedenen Bedingungen flexibel zu agieren und eigenständig Rückschlüsse zu ziehen.

Bei unterschiedlichem Lichteinfall nimmt die künstliche Intelligenz beispielsweise automatische Beleuchtungskorrekturen vor und passt sich an neue Reflexionsmuster an. Des Weiteren besitzt ein Bildverarbeitungssystem mit künstlicher Intelligenz Stärken bei der Analyse von organischem Material, das in Form, Farbe und Struktur variiert. Früchte, Pflanzen und Menschen sehen immer unterschiedlich aus, weshalb keine Regeln vorprogrammiert werden können. Eine KI kann hingegen auch verschieden große Eier analysieren oder Gesichter voneinander unterscheiden.

|

|

|

| Abb. 3: Prüfung des Zustands von Eiern im Karton (© IDS Imaging Development Systems GmbH) | Abb. 4: Anomalieerkennung bei Pflanzen mit der IDS NXT (© IDS Imaging Development Systems GmbH) |

Von der Schweißnahtprüfung bis zur Reifegradbestimmung

Die Arbeitsweise der Bildverarbeitungslösungen kann überall eingesetzt werden, wo optische Qualitätskontrollen notwendig sind. Klassische Branchen und Beispiele sind:

- Automobilindustrie:

Lackkontrolle und Bauteilinspektion - Bauindustrie:

Schweißnahtkontrolle, Lunkererkennung in Beton- und Metalloberflächen, Kratzer- und Risserkennung in Fassaden, Fenstern und Türen - Kunststoffindustrie:

Kontrolle von Kunststoffteilen, Qualitätsprüfung von Spritzguss und Gusserzeugnissen - Elektroindustrie:

Defekterkennung an Leiterplatten, elektronischen Bauteilen und Gehäusen - Pharmaindustrie:

Inspektion von Tabletten sowie deren Verpackungen auf Beschädigungen oder Verunreinigungen, Etikettenkontrolle - Lebensmittelindustrie:

Pflanzenkrankheiten erkennen, Reifegradbestimmung von Obst und Gemüse

|

|

|

| Abb. 5: Reifegradbestimmung von Erdbeeren mit der IDS NXT (© IDS Imaging Development Systems GmbH) | Abb. 6: Kontrolle und Vermessung von Schweißnähten (© IDS Imaging Development Systems GmbH) |

Viele Industriekamerahersteller bieten heutzutage Bildverarbeitungslösungen für verschiedene Anwendungsfälle an. Des Weiteren hat sich der Marktplatz visionpier etabliert, auf dem sich über 120 Anwendungen befinden. Diese lassen sich in wenigen Schritten anfragen und auf individuelle Herausforderungen anpassen, ohne das eigene Kenntnisse in der industriellen Bildverarbeitung notwendig sind.

Zusammengefasst

Die automatisierte Oberflächeninspektion mithilfe industrieller Bildverarbeitung bietet präzise und zuverlässige Lösungen zur Erkennung selbst kleinster Fehler. Sie löst die Herausforderungen der manuellen Kontrolle und stellt sicher, dass Produkte höchste Qualitätsstandards erfüllen. Je nach Anwendungsfall kommt künstliche Intelligenz zum Einsatz, wodurch Anwendungen noch flexibler auf unterschiedliche Situationen reagieren können. Bildverarbeitungslösungen vereinen Hardware, Software und Integration, wodurch Unternehmen niederschwelligen Zugang zu zukunftsweisenden Technologien erhalten und wertvolle Entwicklungszeit sparen.

Über die Autorin:

Jacqueline Krauß arbeitet bei IDS Imaging Development Systems GmbH, einem langjährigen Mitglied der DGQ. IDS ist führender Industriekamerahersteller und Pionier in der industriellen Bildverarbeitung. Das Unternehmen mit Sitz in Obersulm, Baden-Württemberg, entwickelt 2D- und 3D-Kameras sowie Modelle mit künstlicher Intelligenz. Das nahezu unbegrenzte Anwendungsspektrum der Kameras erstreckt sich über verschiedenste nicht-industrielle sowie industrielle Branchen des Geräte , Anlagen- und Maschinenbaus. Mit dem Marktplatz visionpier bietet IDS Zugang zu über 120 Bildverarbeitungslösungen.

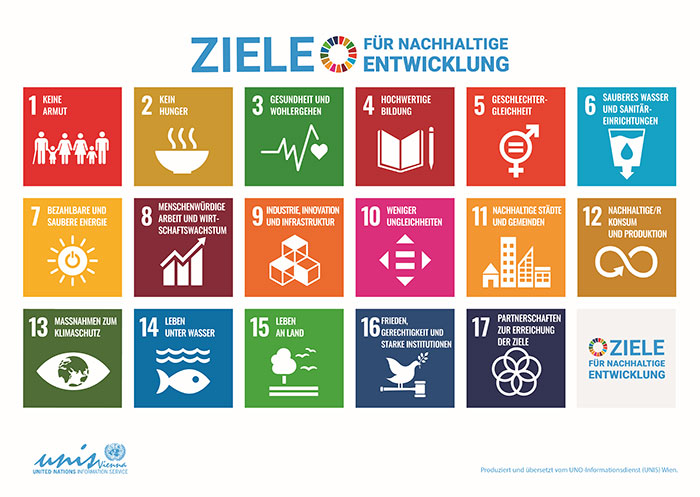

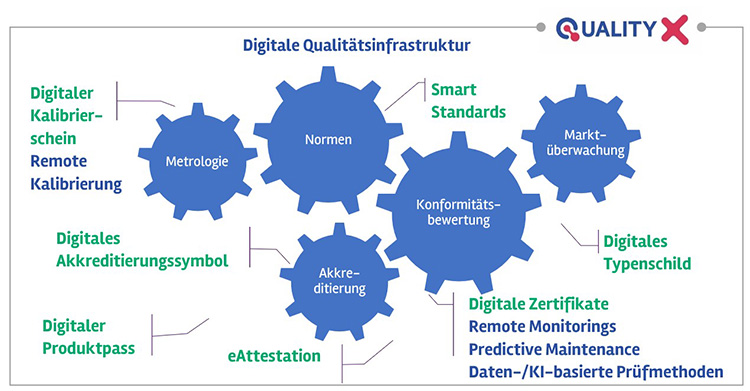

Die digitale Transformation in akkreditierten Laboren: Aktueller Stand, Herausforderungen und Chancen, Teil 1

Die Digitalisierung ist in aller Munde und macht auch vor den Laboren nicht Halt. Immer mehr Finanztöpfe werden für die digitale Transformation bereitgestellt, immer mehr Budgets freigegeben.

Aber wie ist der aktuelle Stand in den akkreditierten Laboren? Welche Hindernisse blockieren die digitale Transformation? Und welche Möglichkeiten eröffnen sich zum Beispiel durch generative KI? Gibt es das Labor 4.0 schon? Diese Fragen werden im Rahmen dieses Artikels und des zweiten Teils erörtert.

Das VUP-Konjunkturbarometer, welches vom VUP Deutscher Verband Unabhängiger Prüflaboratorien e.V. herausgegeben wird, vom November 2023 zeigt: Der Bereich IT und Digitalisierung hält mit 0,5 sein positives Niveau und trotzt der Krisensituation, obwohl in den akkreditierten Laboren in vielen Bereichen weniger investiert wird. Die Laborbranche investiert damit ganz gezielt in Zukunftstechnologien. Auch die QZ (Ausgabe 5/24) beschreibt in einem Artikel, dass die Investitionen für KI 2024 im Durchschnitt um 30 Prozent erhöht wurden. Die Labore richten hohe Erwartungen an die Digitalisierung hinsichtlich Effizienzsteigerung und Ausweitung der Geschäftsfelder. Doch laut einer aktuellen Horváth-Studie drohen diese Investitionen in vielen Unternehmen aufgrund fehlender Voraussetzungen ohne Mehrwert zu versickern.

Aktueller Stand in verschiedenen Laborarten

Der digitale Reifegrad in den verschiedenen akkreditierten Laboren ist sehr unterschiedlich und wird insbesondere bei der Betrachtung verschiedener Laborbereiche deutlich. In den technischen Laborsparten, beispielsweise im Automotive-Bereich, ist die Digitalisierung bereits wesentlich weiter fortgeschritten als in den medizinischen Laboren. Die Akkreditierungsanforderungen bezüglich der Informationssicherheit sind jedoch annähernd gleich. Viele Qualitätsmanagementsysteme (QMS) der medizinischen Labore sind noch sehr oder ausschließlich papierbasiert aufgebaut. Oft hört man die Aussage: „Weil wir das schon immer so gemacht haben.“ Dass diese Labore trotz ihres papierbasiertem QMS, das nicht mehr dem „Stand der Technik“ entspricht, ihre Akkreditierung erfolgreich bestehen, verstärkt diese Haltung zusätzlich. Warum das ganze Managementsystem ändern und hierfür viel Geld, Zeit und Ressourcen in die Hand nehmen, wenn die Akkreditierungsstellen dies nicht explizit fordern? Der Vorteil der digitalen Transformation ist für die Labore nicht deutlich genug. Zusätzlich ist der Gegenwind durch die Mitarbeitende für diesen ausgeprägten Change-Prozess häufig sehr hoch.

Labore, die beispielsweise als interne Qualitätssicherungslabore in innovativen und modernen Unternehmen verankert sind, etwa in der Werkstoff-, oder Materialprüfung, pflegen oft gleichfalls moderne und agile Prozesse. Die Mitarbeitenden sind an Veränderungen und Innovationen gewöhnt und gelten als resilienter und flexibler als Mitarbeitende in sehr konservativen Laborsparten.

Bei der Beurteilung der Automatisierung und Digitalisierung muss jedoch grundsätzlich zwischen dem Probendurchlauf, das heißt dem Laborprozess zur Probenbearbeitung und dem nach DIN EN ISO/IEC 17025 oder DIN EN ISO 15189 aufgebauten Managementsystem für die Aufrechterhaltung der Akkreditierung unterschieden werden.

Der Probenbearbeitungsprozess wird durch sogenannte Laborinformationsmanagementsysteme, abgekürzt LIMS, automatisiert und digitalisiert. Besonders bei sehr hohen Probenzahlen steigt der Automatisierungsgrad des Laborprozesses proportional und LIMS werden häufiger implementiert. Da medizinische Labore häufig hohe Probenzahlen untersuchen, nutzen medizinische Labore oft elektronische LIMS für die automatisierte Bearbeitung der Proben und die Anbindung der Geräte für die elektronische Ergebnisübertragung.

In den Prüf- und Kalibrierlaboren, die nach DIN EN ISO/IEC 17025 akkreditiert sind, werden regelmäßig weniger Proben getestet und LIMS sind seltener anzutreffen. Das heißt, speziell für den Laborprozess ist der digitale Automatisierungsreifegrad bei den Prüf- und Kalibrierlaboren und den technischen Laborsparten weniger ausgeprägt als bei den medizinischen Laboren.

Auf Ebene der Qualitätsmanagementsysteme nach DIN EN ISO/IEC 17025 und DIN EN ISO 15189 sehen wir ein gegenteiliges Bild. Medizinische Labore pflegen oft ein papierlastiges Managementsystem, wobei die Prüf- und Kalibrierlabore tendenziell stärker, zum Beispiel durch CAQ Systeme oder SharePoint digitalisiert sind. Ein Großteil der Labore unterhält momentan noch ein Hybridsystem aus Papierdokumenten und elektronischen Dokumenten.

Digitalisierung ist also nicht gleich Digitalisierung. Die Labore müssen sich fragen, welche Prozesse ihr „Nadelöhr“ sind, in welche Prozesse unverhältnismäßig viele Ressourcen und Kapazitäten fließen. In welchen Bereichen müssen sie effizienter, schneller und sicherer werden? Welchen Risiken unterliegen ihre Prozesse? Mancherorts werden etwa veraltete, nicht mehr unterstützte Systeme und MS Access Datenbanken genutzt, die nur von einer Person im Unternehmen verwaltet werden können. Was passiert mit diesen Prozessen, wenn diese Person ausfällt? Die Auswirkung für das Labor ist ähnlich einem Cyber-Angriff – der Stillstand aller Testungen und Prozesse.

Digitaler Umstellungsprozess in den akkreditierten Laboren

Die Umstellung von analogen zu digitalen Prozessen erfolgt in den Laboren in unterschiedlichen Stufen. Ausgedruckte Papierdokumente werden durch Excel- und Word-Dokumente ersetzt. Diese werden nicht mehr ausgedruckt, sondern digital gepflegt, gegebenenfalls mit elektronischen Unterschriften versehen und in den Audits und Begutachtungen digital präsentiert.

Der nächste Reifeschritt ist der Ersatz dieser Dokumente durch kommerzielle Softwaresysteme und Datenbanken oder -sätze, wie zum Beispiel CAQ, SharePoint für die Dokumentenlenkung, Pflege und Ablage.

Die Königsdisziplin ist eine kommerzielle Softwarelösung, auch „Software as a Service“ genannt (SaaS), die bereits bei der Auslieferung alle Akkreditierungsanforderungen erfüllt und schnell, also ohne großes Softwareimplementierungsprojekt, gestartet werden kann. Diese SaaS Lösungen, wie zum Beispiel 17025_SaaS von AUDITTRAILS Networks, sind seit wenigen Jahren für die Labore käuflich zu erwerben und bilden über Datensätze die kompletten Akkreditierungsanforderungen ab. Zum Aufbau eines Managementsystems muss auf diesem Wege nicht alles eigenständig erarbeitet werden. Die Labore können sich sicher sein, dass sie alle Akkreditierungsanforderungen erfüllen.

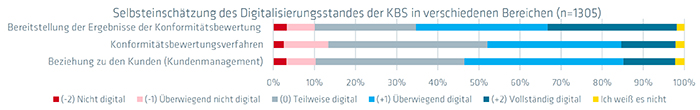

Selbsteinschätzung der Labore zum vorliegenden Digitalisierungsstand

Was sagen die Labore selbst über den Grad ihrer Digitalisierung? Welche Prozesse wurden bereits digitalisiert? Eine QI-FoKus-Studie von 2024, die in Zusammenarbeit mit der BAM erstellt wurde, befragte über 1.300 internationale Labore zu Digitalisierungsthemen.

Abb. 1: Selbsteinschätzung des Digitalisierungsstandes der KBS in verschiedenen Bereichen. Quelle: QI-FoKus-Studie 2024 zur Digitalisierung in der Konformitätsbewertung: Ein internationaler Vergleich

Die Studie ergab, dass hauptsächlich die Übermittlung der Prüfergebnisse an die Kunden digital erfolgt.

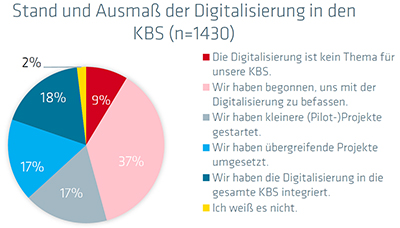

Auch wurde festgestellt, dass Digitalisierung häufig erst in den letzten Jahren für die Labore relevant wurde. Jede zweite Konformitätsbewertungsstelle, unter anderem Labore, hat erst in den letzten 5 Jahren begonnen, sich mit der digitalen Transformation zu beschäftigen. Nur 20 Prozent haben dies bereits vor 10 Jahren getan.

|

|

|

| Abb. 2: Stand und Ausmaß der Digitalisierung in den KBS. Quelle: QI-FoKus-Studie 2024 zur Digitalisierung in der Konformitätsbewertung: Ein internationaler Vergleich | Abb. 3: Von der Digitalisierung betroffene Bereiche. Quelle: QI-FoKus-Studie 2024 zur Digitalisierung in der Konformitätsbewertung: Ein internationaler Vergleich |

International haben nur 18 Prozent der Labore die Digitalisierung in das gesamte Labor integriert. Die meisten Digitalisierungsaktivitäten betreffen interne Prozesse, gefolgt von verbesserter Kommunikation. Nur in geringerem Ausmaß unterstützt die Digitalisierung jedoch die Erweiterung und Verbesserung der klassischen Labor-Tätigkeiten.

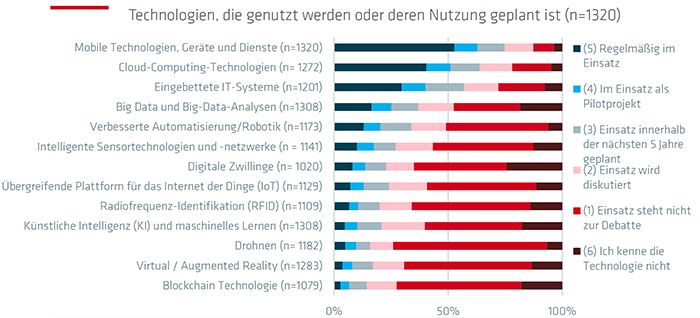

Abb. 3: Technologien, die genutzt werden oder deren Nutzung geplant ist. Quelle: QI-FoKus-Studie 2024 zur Digitalisierung in der Konformitätsbewertung: Ein internationaler Vergleich

Die neuesten digitalen Technologien, wie Blockchain, KI, Virtual Reality und Big Data Analytics werden nur in geringem Ausmaß in den akkreditierten Laboren eingesetzt. Regelmäßig zum Einsatz kommen bereits Mobile Technologien, Cloud-Computing-Technologien und eingebettete IT-Systeme. Auch Technologien und Anwendungen für Remote-Verfahren wie Videokonferenzsysteme und Chats sind fest im Alltagsgeschäft der Unternehmen verankert. Sie werden von 60 Prozent der befragten Unternehmen genutzt.

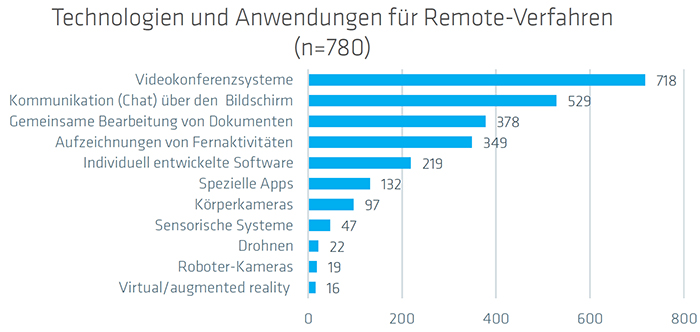

Abb. 4: Technologien und Anwendungen für Remote-Verfahren. Quelle: QI-FoKus-Studie 2024 zur Digitalisierung in der Konformitätsbewertung: Ein internationaler Vergleich

45 Prozent nutzen sie auch für ihre Audits. Als größte Hürden und Probleme bei den eingesetzten Remote-Methoden werden die mangelnde zwischenmenschliche Interaktion und Risiken bezüglich des Datenschutzes und der Informationssicherheit gesehen.

Mehr als die Hälfte der akkreditierten Routineprozesse wurden in 69 Prozent der internationalen Labore digitalisiert. 13 Prozent der Labore haben dagegen nicht einmal 10 Prozent ihrer Labortätigkeiten digitalisiert.

Zusammenfassung des aktuellen Standes der Digitalisierung in akkreditierten Laboren

In den letzten Jahren hat die Digitalisierung in diesen Laboren stark zugenommen. Die Fortschritte sind:

- Laborinformationssysteme (LIMS):

LIMS ermöglichen es, akkreditierten Laboren, die Probenbearbeitung und -verwaltung, die Datenverarbeitung sowie den gesamten Laborbetrieb automatisiert und digital abzubilden. Anfangs wurden diese Systeme häufig durch die eigene IT-Abteilung entwickelt. In den letzten Jahren wurden diese System wegen der gestiegenen Akkreditierungsanforderungen durch kommerzielle LIMS-Lösungen ersetzt. - Automatisierung von Prozessen:

Fortschrittliche Analysegeräte und Sensoren automatisieren die Datenerfassung und -analyse, was zu einer erhöhten Effizienz und Genauigkeit führt. Dies ist besonders wichtig für akkreditierte Labore, da die Genauigkeit und Reproduzierbarkeit der Ergebnisse von entscheidender Bedeutung sind. Besonders die Anbindung der Geräte an die Server führen durch die automatisierte Rohdaten- und Ergebnisübertragung zu enormen Effizienzsteigerungen und Fehlerreduzierungen. Auch die digitale Übertragung der Prüfergebnisse und Prüfberichte an die Kunden führt zu einem enormen Effizienzgewinn. - Datenmanagement und -sicherheit:

Die Nutzung von Cloud-Computing und Big-Data-Analyse ermöglicht es akkreditierten Laboren, große Datenmengen effizient und sicher zu speichern, zu verarbeiten und zu analysieren. Gleichzeitig wird die Sicherheit sensibler Daten gewährleistet. Diese Methodiken werden momentan in den internationalen Laboren noch nicht ausreichend genutzt. - Remote-Techniken:

Seit 2020 setzen Labore vermehrt Remote-Techniken für die Tätigkeiten und Kommunikationsabläufe in den Laboren ein. Videokonferenzsysteme stellen das am häufigsten verwendete Tool für die Remote-Arbeit dar, gefolgt von digitaler Kommunikation (Chat).

Über die Autorin

Susanne Kolb ist Geschäftsführerin der Laborberatungsfirma LaborConsultingGenius GmbH und berät seit über 10 Jahren alle Branchen von Prüf-, Kalibrier- und medizinischen Laboren bei Akkreditierungsprojekten nach DIN EN ISO/IEC 17025 und DIN EN ISO 15189. Zusätzlich war sie fast 10 Jahre leitende DAkkS Systembegutachterin und Fachbegutachterin und ist seit Jahren Trainerin und Prüferin des DGQ-Zertifikats Labormanagement.

Koch, C., Ladu, L (2022). QI-FoKuS-Studie in Zusammenarbeit mit der BAM, Auswirkungen der Corona-Pandemie auf Konformitätsbewertung und Konformitätsbewertungsstellen in Deutschland (qi-digital.de)

Literaturverzeichnis

Koch, C., Ladu, L (2024, März). QI-FoKuS-Studie in Zusammenarbeit mit der BAM (www.bam.de)

Frenzl, A. (2024, 26.März). Blogbeitrag: Moderne Managementsysteme – AUDITTRAILS Networks GmbH

Zeitschrift Laborpraxis 2024 : Dossier – Digitalisierung im Labor

VUP-Konjunkturbarometer, November 2023 (VUP – Verband unabhängiger Prüflabore)

Zeitschrift QZ 5/24, Seite 7, KI ist der Managementhype 2024 – und eine Investment-Falle, Hanser Verlag, Herausgeber DGQ

April 2024, DIALOGPROZESS „DIGITALE QI IN PRÜF- UND KALIBRIERLABOREN – VOM TREND ZUM TAGESGESCHÄFT“ Zentrale Erkenntnisse aus den Praxiswerkstätten #1 und #2

DGQ-Vortrag zu Digitalisierung: Zusammenspiel von Software, Hardware und Mensch im Blick

Qualitätsmanagement (QM) und Qualitätssicherung (QS) hinken derzeit digital noch hinterher: Das ist eine der Erkenntnisse aus dem Vortrag von Dr. Benedikt Sommerhoff, Leiter des Research Teams bei der DGQ, auf dem „Quality Day Software“ des Fachmagazins Quality Engineering. Unter dem Titel „Software, Hardware, Wetware – Alle(s) für die Qualität“ erörterte Sommerhoff als Keynote-Speaker unter anderem, worauf Unternehmen auf dem Weg in die Digitalisierung von Qualitätsmanagement (QM) und Qualitätssicherung (QS) achten sollten. Dabei stand insbesondere das Zusammenspiel von Software, Hardware und dem Menschen in Zeiten der beschleunigten Digitalisierung im Fokus.

Potenziale bewusst nutzen

In seinem Vortrag fokussierte sich Sommerhoff darauf, mit den Teilnehmerinnen und Teilnehmern ein gemeinsames Verständnis von Digitalisierung und ihres Potenzials zu erreichen sowie den unterschiedlichen Charakter von Soft- und Hardware zu vermitteln. Auch der Identifikation von Use Cases bei Software/Digitalisierung in und für QS und QM kam eine große Rolle zu sowie dem Ziel, Digitalisierung als Zusammenspiel von Software, Hardware und Mensch zu erkennen. Letzteres führte Sommerhoff zu der Fragestellung, wie dieses Zusammenspiel künftig die Rollen der Beteiligten verändern werde: Dabei sei mittlerweile insbesondere auch zu bedenken, wie Qualitätsverantwortliche in der Zukunft mit Künstlicher Intelligenz (KI) zusammenarbeiten werden. Sommerhoffs Appell: Organisationen sollten die Interaktion mit der KI bewusst und aktiv begleiten, und das auf Basis realistischer organisationsspezifischer Zielvorstellungen.

Interessierte können sich die Aufzeichnung des Vortrags hier anschauen:

Neue Anforderungen für KI in Unternehmen: Die EU-KI-Gesetzgebung und ihre Auswirkungen auf das Qualitätswesen

Künstliche Intelligenz (KI) durchdringt immer mehr Bereiche des täglichen Lebens und der Arbeit. Lange Zeit war künstliche Intelligenz nur für Entwicklungs- und Technologiebereiche interessant. In den letzten Monaten lässt sich beobachten, dass KI immer mehr auch zum Qualitätsthema wird. Überall dort, wo KI eingesetzt wird, um Kundenbedürfnisse zu erfüllen, wird sie auch Gegenstand des Qualitätsmanagements. Viele Unternehmen nutzen KI bereits in ihren Produkten, in ihren Herstellungsprozessen oder im Kundensupport. Auf diese Unternehmen kommen nun neue Anforderungen zu. Dieser Artikel ist Teil einer Serie. Der erste Teil möchte die Leser mit grundsätzlichen Qualitätsanforderungen an KI-Systeme in der aktuellen Rechtslage vertraut machen. Der Beitrag zeigt die großen Parallelen zwischen dem EU-KI-Gesetz und QM-Methoden. Folgende Artikel werden sich mit unterschiedlichen Aspekten wie KI-Absicherung und KI-Zertifizierung auseinandersetzen.

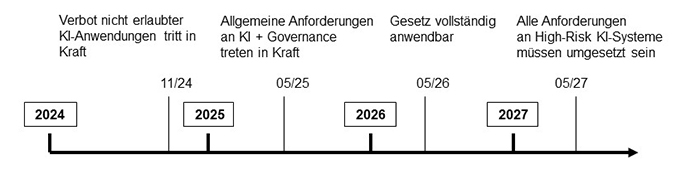

Die EU hat im Dezember 2023 das EU-KI-Gesetz verabschiedet, welches seit April 2024 in überarbeiteter Form vorliegt. Dieses Gesetz definiert Anforderungen für den Betrieb von KI-Systemen in der Europäischen Union und schafft einen einheitlichen gesetzlichen Rahmen für Hersteller und Betreiber. Die EU-KI-Gesetzgebung bewertet KI-Systeme nach einem risikobasierten Ansatz, der starke Ähnlichkeit mit bestehenden Management-Systemen wie ISO 9001 oder ISO 14001 aufweist.

KI-Anwendungen mit unzulässigen Risiken

Abbildung 1 zeigt die vier Risikokategorien für KI-Systeme gemäß EU-KI-Gesetz. Die Einstufung in eine Risikokategorie ergibt sich im Wesentlichen aus den möglichen Auswirkungen auf interessierte Parteien wie Nutzer, die Gesellschaft als Ganzes oder die Umwelt. Das KI-Gesetz verwendet den Ausdruck interessierte Partei dabei nicht. Die oberste Kategorie bezeichnet KI-Anwendungen mit unzulässigen Risiken. Beispiele hierfür sind Social-scoring-Systeme, die dazu gedacht sind, das Verhalten von Menschen zu beeinflussen. Der Betrieb solcher Systeme ist in der EU nach Ablauf einer sechsmonatigen Übergangsfrist untersagt.

Abb. 1: Risikokategorien des EU-KI-Gesetzes mit Beispielen

KI-Systeme mit hohem Risiko

Die zweithöchste Kategorie sind KI-Systeme mit hohem Risiko. Allgemein fallen in diese Kategorie Systeme, die funktionale Sicherheitsanforderungen haben (zum Beispiel in der medizinischen Diagnostik oder dem Straßenverkehr) oder die persönlichen und wirtschaftlichen Interessen von natürlichen Personen betreffen (zum Beispiel im Finanzwesen oder der Bildung). Annex III des EU-KI-Gesetzes enthält eine Auflistung von Hochrisiko-Bereichen. In der aktuellen Fassung des wurde ein neues Kapitel zu KI-Modellen mit allgemeinem Verwendungszweck aufgenommen. Für Hersteller dieser Modelle, zu denen auch große Sprachmodelle zählen, gelten besondere Anforderungen (zum Beispiel gpt4, das Modell hinter ChatGPT). Je nach Komplexität des Modells können die Anforderungen im Hochrisiko-Bereich oder sogar darüber liegen, wenn ein systemisches Risiko festgestellt wurde.

Hochrisiko-KI-Systeme müssen eine CE-Kennzeichnung aufweisen und durch eine unabhängige dritte Stelle zertifiziert werden. Alle Hochrisiko-KI-Systeme müssen in einer zentralen EU-Datenbank registriert werden. Wenn erwiesen ist, dass ein KI-System aus einem Annex III gelisteten Bereich keinen Einfluss auf Sicherheit oder Interessen natürlicher Personen hat, dann kann das System auch als System mit mittlerem oder niedrigem Risiko behandelt werden. Die Pflicht zur externen Zertifizierung entfällt in diesem Fall, aber das System muss trotzdem an die zentrale EU-Datenbank gemeldet werden. Die Erfassung in der EU-Datenbank und die Zertifizierung gelten für einzelne KI-Produkte, nicht für eine Organisation als Ganzes. Die Zertifizierung muss für alle größeren Eingriffe wiederholt werden.

Für Hochrisiko-KI-Systeme stellt das EU-KI-Gesetz eine Vielzahl von Anforderungen. Eine genauere Betrachtung der Anforderungen wird in einem separaten Artikel besprochen. An dieser Stelle sollen nur die wichtigsten Anforderungen genannt werden:

- Einhaltung von Datenschutzvorschriften und Informationssicherheit

- Vorhandensein eines Qualitätsmanagementsystems

- Risikomanagement für vorhersehbare Fehler

- Verpflichtung zu Test und Validierung des KI-Systems

- Einhaltung der branchenspezifischen Vorschriften für funktionale Sicherheit

Die oben aufgeführten Stichpunkte zeigen den starken Überlapp zwischen der neuen EU-KI-Gesetzgebung und Methoden des klassischen Qualitätsmanagements. Aus diesem Grund gehen wir davon aus, dass das Qualitätsmanagement in Zukunft eine zentrale Rolle bei der Einführung und Überwachung von KI-Systemen einnehmen wird.

KI-Systeme mit mittlerem Risiko

Neben Hochrisiko-KI-Systemen gibt es noch Systeme mit mittlerem Risiko. In diese Kategorie fallen Systeme wie Chatbots für den Kundensupport. Diese Systeme haben nur unwesentliche persönliche und keine sicherheitsrelevanten Auswirkungen für Nutzer. Für diese Systeme gelten lediglich Transparenzanforderungen. Dies bedeutet, dass für Nutzer ersichtlich sein muss, wenn er mit einem KI-System interagiert. Der Nutzer muss ferner in Verständlicher Art und Weise über die Verarbeitung seiner Daten aufgeklärt werden. KI-generierte Inhalte sollten in maschinenlesbarer Art und Weise als solche gekennzeichnet sein (zum Beispiel durch Fingerprinting). Die EU arbeitet aktuell an einem Code of Conduct, der näher erklären soll, wie diese Anforderungen umzusetzen sind. Aktuell gibt es jedoch noch kein Veröffentlichungsdatum.

Es ist wichtig zu betonen, dass die Verantwortung für die Einhaltung von Transparenzregeln und Absicherung der korrekten Funktion hauptsächlich der Organisation zufällt, die das KI-System in Umlauf bringt. Dabei handelt es sich oft nicht um den Hersteller des KI-Modells. Insbesondere bei der Verwendung großer Sprachmodelle ist diese Unterscheidung wichtig. Chatbots sind in der Regel kundenspezifisch angepasst. Hersteller großer Sprachmodelle wie openAI agieren in diesem Fall als Lieferanten für Firmen, aber übernehmen in der Regel keine Haftung für firmenspezifische Anpassungen. Dieser Artikel beschreibt einige der Risiken, die dabei entstehen. Die Verantwortung für die Validierung der korrekten Funktion und die Einhaltung von Vorschriften obliegt der Firma, die das System für den Nutzer bereitstellt. Firmen werden somit selbst Prozesse zur Validierung ihrer KI -Lösungen implementieren müssen, wenn sie KI in ihren Produkten oder Prozessen nutzen möchten.

KI-Systeme mit vernachlässigbarem Risiko

Alle KI-Systeme, die nicht in die obersten drei Risikokategorien fallen, werden als Systeme mit vernachlässigbarem Risiko eingestuft. Für Anwendungen mit vernachlässigbarem Risiko stellt das KI-Gesetz neuen Anforderungen. Bestehende Anforderungen, zum Beispiel aus der Datenschutzgrundverordnung bleiben aber weiterhin bestehen. Wir stellen dazu ein kostenloses Self-Assessment bereit, mit dem die Risikoklasse einer KI-Anwendung bestimmt werden kann.

Abbildung 2 zeigt Umsetzungszeiten für die EU-KI-Gesetzgebung, wie sie zum 1. Mai 2024 bekannt waren. Das Verbot von Anwendungen mit unzulässigem Risiko wird bereits im November 2024 in Kraft treten. Die ersten Anforderungen, für Anwendungen mit mittlerem und hohem Risiko werden nach heutigem Kenntnisstand ab Mai 2025 in Kraft treten. Zu diesem Zeitpunkt greifen Verpflichtungen im Bezug auf Transparenz und Data Governance. Data Governance bedeutet, dass Trainings- und Testdatensätze alle für die Anwendung relevanten Kategorien oder Personengruppen abdecken müssen und dies auch nachvollziehbar zu dokumentieren ist.

Abb. 2: Zeitschiene der Implementierung der EU-KI-Gesetzgebung