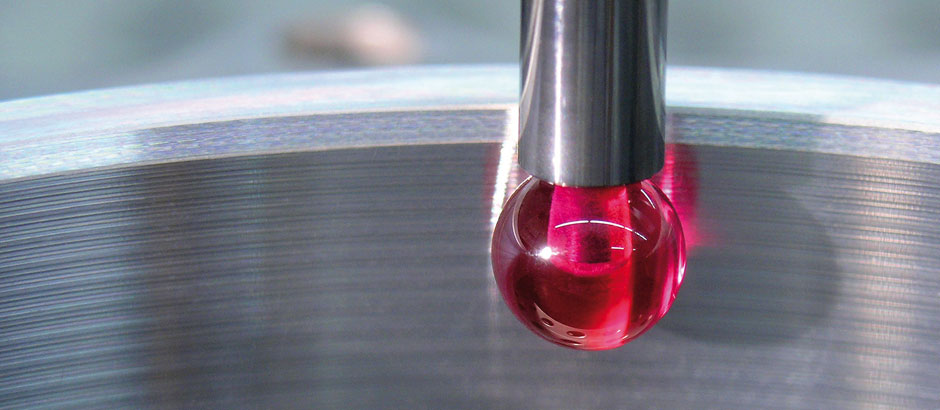

ISO-GPS: Oberflächenbeschaffenheit / Rauheit (ISO 21920)

Die DIN EN ISO 1302 für die Angaben der Oberflächenbeschaffenheit und die Normen zu den Begriffen, den Parametern und den Spezifikationsoperatoren wurden im Dezember 2022 durch die neue Normenreihe DIN EN ISO 21920 ff. ersetzt. Zurzeit stehen folgende Normen zur Verfügung:

- DIN EN ISO 21920-1:2022-12

GPS – Profile Teil 1: Angabe der Oberflächenbeschaffenheit

(Ersatz für DIN EN ISO 1302:2002) - DIN EN ISO 21920-2:2022-12

GPS – Profile Teil 2: Begriffe und Parameter für die Oberflächenbeschaffenheit

(Ersatz für DIN EN ISO 4287, DIN EN ISO 13565-2, -3) - DIN EN ISO 21920-3:2022-12

GPS – Profile Teil 3: Spezifikationsoperatoren

(Ersatz für DIN EN ISO 4288)

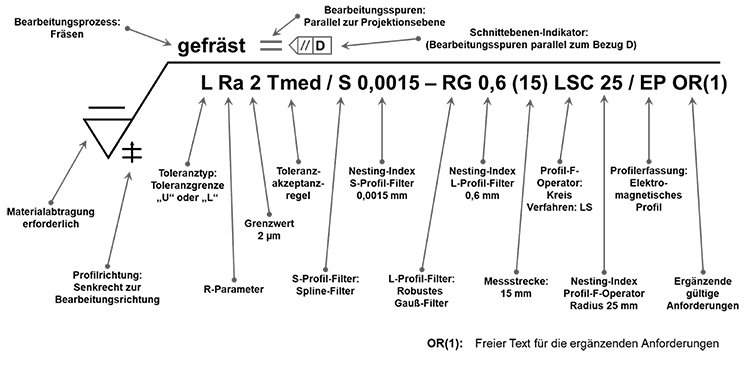

Mit diesen Normen sind neue Angabemöglichkeiten und Regeln vorhanden:

- Oberflächenmessverfahren (mechanische und elektromechanische Profile)

und Messrichtung (Profilrichtung) - Filterung nach der Normenreihe DIN EN ISO 16610-21 und DIN EN ISO 16610-31.

- Spezielle Mess- und Auswerteverfahren zur Beurteilung der Funktion einer Oberfläche.

- Angaben und Auswertung von Materialanteil/Traganteil sind definiert.

- Die Messparameter werden nicht mehr nach einer Vormessung bestimmt, sondern aus

der Spezifikation (Zeichnungsangabe oder default nach Norm). - Keine Unterscheidung zwischen periodischen und nicht-periodischen Profilen bei der Filterung.

Da die ISO 21920 die ISO 1302 ersetzt, gilt bei Zeichnungsänderung automatisch die neue Norm. Wenn das nicht gewollt ist, muss hinter der alten Norm ISO 1302:2002 das Ausgabedatum ergänzt werden.

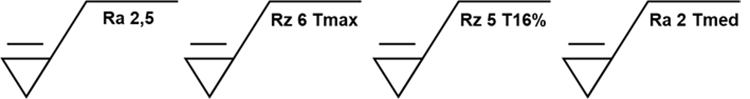

Die aktuellen Toleranzakzeptanzregeln sehen drei Spezifikatoren vor:

- „Tmax“ – Höchstwert-Toleranzakzeptanzregel ist anzuwenden

- „T16%“ – 16%-Toleranzakzeptanzregel ist anzuwenden

- „Tmed“ – Median- Toleranzakzeptanzregel ist anzuwenden (n ≥ 3)

(Messwerte außerhalb der Spezifikation werden nicht berücksichtigt)

Die Höchstwert-Toleranzakzeptanzregel „Tmax“ stellt die Default-Definition dar. Sie gilt mit und ohne „Tmax“-Angabe. Tmax kann zur Eindeutigkeit an einer Spezifikation angegeben werden.

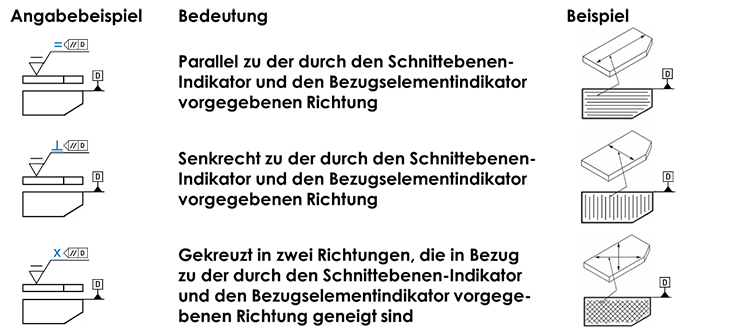

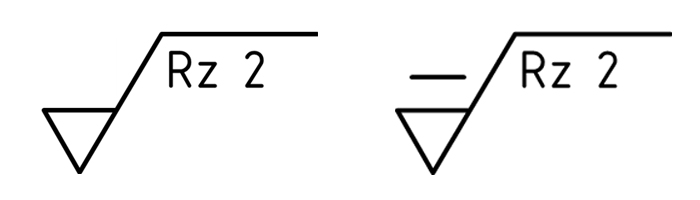

Mögliche Zeichnungseintragungen nach DIN EN ISO 21920-1

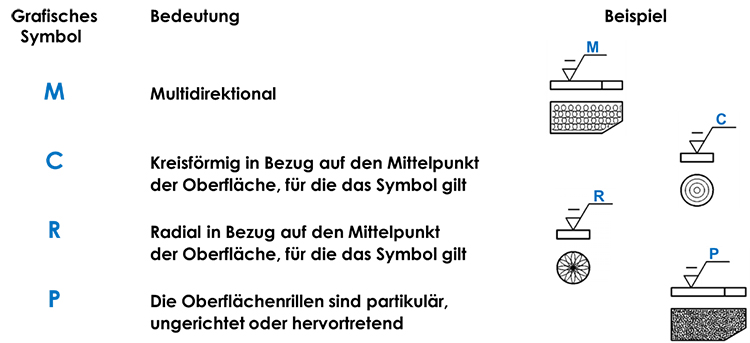

Angabe der Oberflächenrillen ohne einen Bezug

Angabe der Oberflächenrillen und der Richtung der Bearbeitungsspuren in Bezug zu einem Geometrieelement des Werkstücks

Abb. 4: Angabe der Oberflächenrillen und der Richtung der Bearbeitungsspuren in Bezug zu einem Geometrieelement des Werkstücks

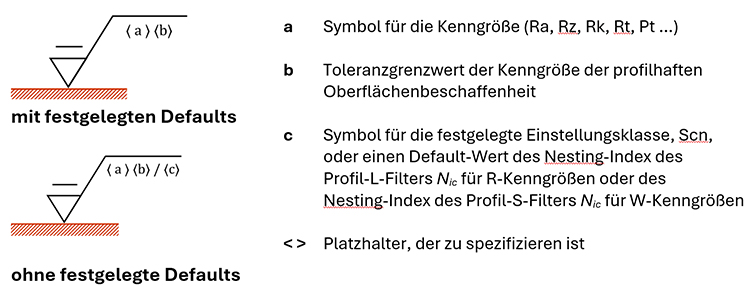

Mindestangabe von Kenngrößen mit und ohne festgelegte Defaults

Aktuelle Begrifflichkeiten zur Oberflächenbeschaffenheit nach DIN EN ISO 21920

| Begrifflichkeit | Definition |

|---|---|

| S-Filter (S – small) | Filter zur Eliminierung kurzwelliger Anteile (Tiefpass-Filter) -> (bisher λs) (Profil-Filtertypen der Normenreihe ISO 16610) |

| L-Filter (L – large) | Filter zur Eliminierung langwelliger Anteile (Hochpass-Filter) -> (bisher λc)(Profil-Filtertypen der Normenreihe ISO 16610) |

| F-Operator | Formentfernung (z.B. LS-Linie, LS-Radius, Polynom) |

| Nesting Index (Nis, Nic, Nif) | Numerischer Wert für S-Filter, L-Filter oder Form-Operator (Grenzwellenlänge) |

| Profilpunktkenngröße (Auswertelängen-Kenngrößen) | definiert über alle Messpunkte des Profils (gilt für die Mehrzahl der Parameter – alte, umbenannte und neue) |

| Merkmalkenngröße (Abschnittlängen-Kenngrößen) | an ausgewählten topografischen Merkmalen definiert (gilt nur für wenige Parameter) |

| le – Auswertelänge | (bisher Gesamtmessstrecke ln) / Auswertelängen-Kenngrößen |

| lsc – Abschnittslänge | (bisher Einzelmessstrecke lr) / Abschnittslängen-Kenngrößen |

| nsc – Anzahl Abschnitte | (bisher Anzahl Einzelmessstrecken) |

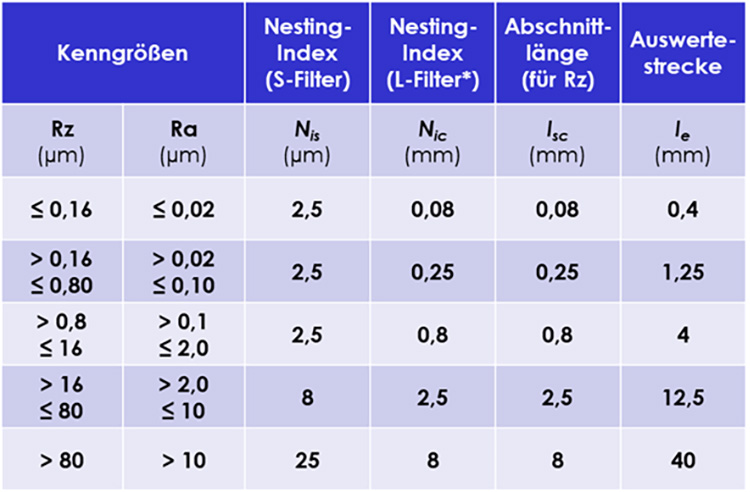

Messbedingungen für Rz und Ra nach ISO 21920-3

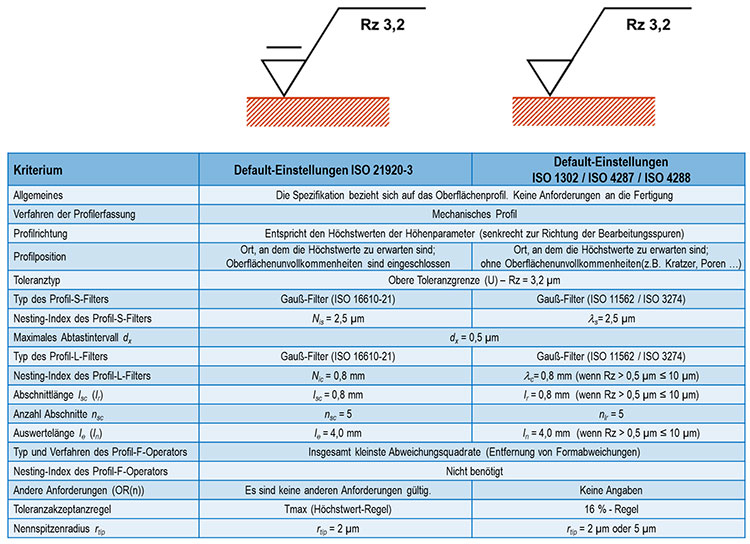

Interpretation und Vergleich von Zeichnungsangaben

| Informieren Sie sich in weiteren Fachartikeln der ISO-GPS-Beitragsreihe In der ISO-GPS-Beitragsreihe erhalten Sie einen kompakten Überblick über das ISO-GPS-System, den aktuellen Normungsstand, den Tolerierungsgrundsätze, dem GPS-Matrix-Modell und die Möglichkeiten zur Anwendung:

|

Der Autor Manfred Weidemann ist DGQ-Trainer und Geschäftsführer von Quality Office. Quality Office betreut seit über 25 Jahren kleine und mittelständische Unternehmen in den Bereichen Qualitätsmanagement, Prozessoptimierung, Zeichnungsprüfung und Längenprüftechnik/Fertigungsmesstechnik.

ISO-GPS: Aktuelle Allgemeintoleranzen – ISO 22081

Wie schon im März 2017 vom Deutschen Institut für Normung (DIN) angekündigt, wurde die Norm mit den Angaben zu den Allgemeintoleranzen (ISO 2768-2) durch die neue ISO 22081 ersetzt. Die Gründe sind nicht eindeutige Vorgaben und große Lücken bezüglich der vollständigen und eindeutigen Tolerierungsmöglichkeiten.

Durch die Anwendung der bisherigen „Plus-Minus-Tolerierung“ (Zweipunkt-Messung) sind Produktspezifikationen nachweislich schon immer mehrdeutig. Dies kann aufgrund eines großen Interpretationsspielraums zu vertragsrechtlichen Problemen zwischen Herstellern und Abnehmern führen.

Dass die „Plus-Minus-Tolerierung“ dazu geeignet ist, die Geometrie eines Bauteils vollständig, eindeutig sowie funktions- und prüfgerecht zu spezifizieren, ist ein Irrtum, den viele Verantwortliche nicht wahrhaben wollen. Mit der Einführung der neuen ISO 22081 sollen die Produktspezifikationen und die Prüfungen mit den Konformitätsnachweisen vollständig und eindeutig werden.

Da die ISO 22081 die ISO 2768-2 ersetzt, gilt bei Zeichnungsänderung automatisch die neue Norm. Wenn das nicht gewollt ist, muss hinter der alten Norm ISO 2768 das Ausgabedatum ergänzt werden.

Beispiel: ISO 2768-2:1989

Genau genommen führt diese Ersatzbeziehung dazu, dass jede undatierte Angabe der ISO 2768-2 (zum Beispiel auf Produktzeichnungen vor der Veröffentlichung von ISO 22081:2021) auf ISO 22081 übergeht. Dies verursacht in einem Vertragsverhältnis möglicherweise erhebliche Risiken, wenn die entsprechenden Unterlagen nicht aufwändig überarbeitet werden:

- In der ISO 22081 werden keine Toleranzwerte in Abhängigkeit von Nennmaßen vorgegeben.

- Sie unterscheidet allgemeine geometrische Spezifikationen und allgemeine Maßspezifikationen.

- Zur Tolerierung kommen allgemeine geometrische Spezifikationen (Flächenprofiltoleranz) und allgemeine Größenmaßspezifikationen zum Einsatz.

- Der erforderliche Toleranzwert und ein vollständiges Bezugssystem müssen vom Konstrukteur festgelegt werden.

- Die Regeln und Spezifikationen der ISO 22081 gelten ausschließlich für integrale Geometrieelemente (Größenmaßelemente, wirkliche Werkstückoberfläche).

- Die Regeln und Spezifikationen der ISO 22081 gelten nicht für abgeleitete Geometrieelemente oder integrale Linien oder andere Maße (Stufenmaße, Bohrungsabstände …) als lineare Größenmaße oder Winkelgrößenmaße.

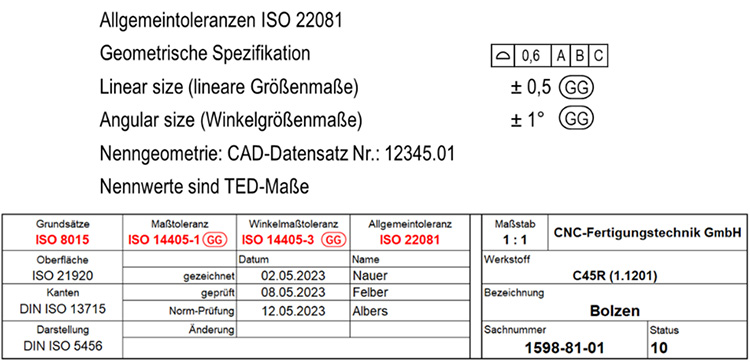

Beispiel zu möglichen Angaben am Schriftfeld:

Abb. 1: Beispiel zu möglichen Angaben am Schriftfeld der ISO 2768-2:1989 (Quelle: www.quality-office.de)

Die Toleranzwerte können direkt oder als Variable mit Toleranztabelle (zum Beispiel Werknorm, DIN 2769 …) angegeben werden!

Ergänzende Allgemeintoleranzen – DIN 2769

Die Norm DIN 2769 dient zur Ergänzung der Allgemeintoleranzen der DIN EN ISO 22081. Sie entstand auf Anregung der deutschen Industrie, um das etablierte Konzept mit festgelegten Toleranzwerten und Toleranzklassen ISO-GPS-konform fortzuführen.

- Im Gegensatz zur ISO 2768-Reihe gibt es mehr Toleranzklassen und die Anwendung ist technologie- und materialunabhängig.

- Die Konstruktion ist gefordert, die Grundsätze des ISO-GPS-Systems nach DIN EN ISO 8015 einzuhalten und alle Geometrieelemente, vollständig und eindeutig zu spezifizieren.

Beispiel zu möglichen Angaben am Schriftfeld:

Abb. 2: Beispiel zu möglichen Angaben am Schriftfeld der DIN EN ISO 22081 (Quelle: www.quality-office.de)

Die Flächenprofiltoleranz beträgt 1,6 mm. Die Toleranz für lineare Größenmaße ist abhängig vom jeweiligen Nennmaß. Beispiel: bei 35 mm beträgt die Toleranz ± 0,3 mm. Die Toleranz für Winkelgrößenmaße ist abhängig vom jeweiligen Nennwinkel. Beispiel: bei 40° beträgt die Toleranz ± 2°.

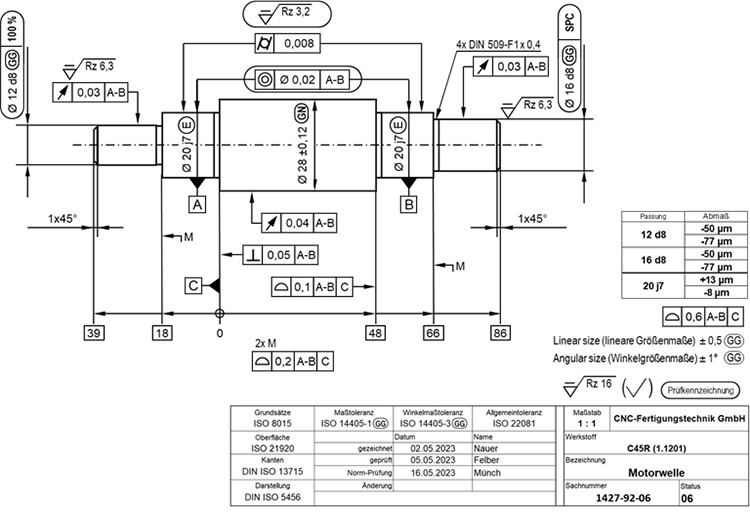

Beispiel zu möglichen Angaben an einer Welle:

| Informieren Sie sich in weiteren Fachartikeln der ISO-GPS-Beitragsreihe In der ISO-GPS-Beitragsreihe erhalten Sie einen kompakten Überblick über das ISO-GPS-System, den aktuellen Normungsstand, den Tolerierungsgrundsätze, dem GPS-Matrix-Modell und die Möglichkeiten zur Anwendung:

|

Der Autor Manfred Weidemann ist DGQ-Trainer und Geschäftsführer von Quality Office. Quality Office betreut seit über 25 Jahren kleine und mittelständische Unternehmen in den Bereichen Qualitätsmanagement, Prozessoptimierung, Zeichnungsprüfung und Längenprüftechnik/Fertigungsmesstechnik.

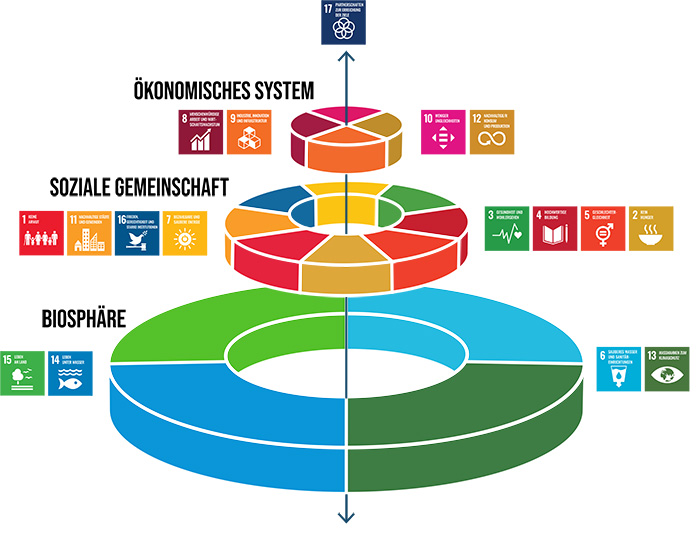

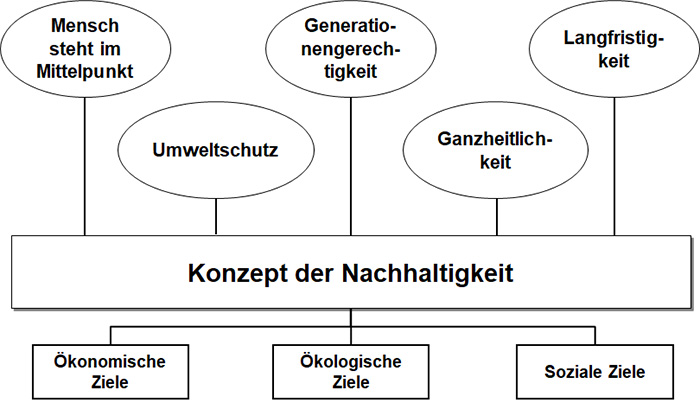

FQS-Forschungsprojekt NaBeMi: Nachhaltige Betriebsmittelplanung für die manuelle und hybride Montage

Nachhaltigkeit gewinnt zunehmend an Bedeutung für produzierende Unternehmen – nicht nur als gesellschaftliches Ziel, sondern auch als strategischer Wettbewerbsfaktor. Insbesondere in kleinen und mittleren Unternehmen (KMU) bestehen jedoch Hemmnisse bei der Umsetzung entsprechender Maßnahmen in der Produktionsplanung. Während ökologische, ökonomische und soziale Aspekte in der Produktentwicklung teilweise berücksichtigt werden, fehlt es in der Betriebsmittelplanung, speziell im Bereich der Montage, häufig an systematischen Ansätzen zur Integration dieser Zielgrößen.

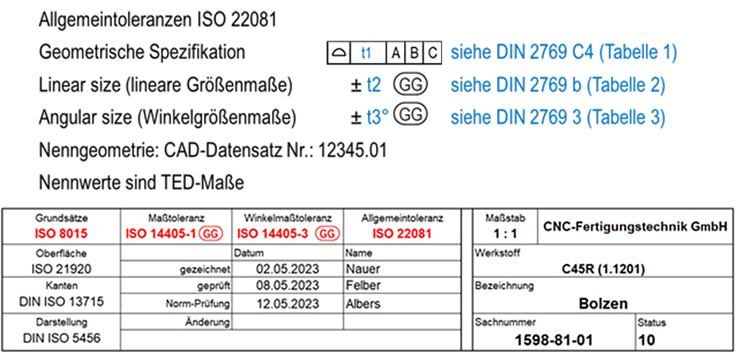

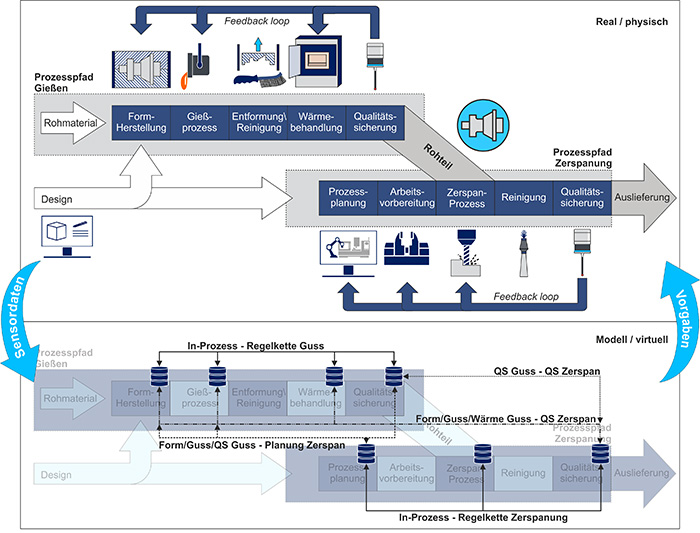

Das über die FQS – Forschungsgemeinschaft Qualität geförderte Forschungsprojekt NaBeMi widmet sich im Rahmen einer zweijährigen Laufzeit der Entwicklung eines digitalen Assistenzsystems, das eine nachhaltigkeitsorientierte Planung von Betriebsmitteln in manuellen und hybriden Montagesystemen ermöglicht. Im Zentrum steht ein ganzheitliches Zielgrößensystem, das klassische Planungsziele wie Zeit, Kosten und Qualität mit den drei Nachhaltigkeitsdimensionen verbindet. Die methodische Grundlage bilden drei miteinander verknüpfte Qualitätsregelkreise zur systematischen Erfassung von Anforderungen, Zielgrößen und möglichen Lösungskonfigurationen (siehe Abb. 1).

Durch die Strukturierung des Planungsprozesses und die Bereitstellung einer IT-gestützten Lösung soll insbesondere KMU der Zugang zu nachhaltiger Betriebsmittelplanung erleichtert und die Planungsqualität langfristig erhöht werden.

Durchführende Forschungseinrichtungen sind das Bremer Institut für Produktion und Logistik (BIBA) sowie das Institut für Fabrikanlagen und Logistik (IFA). Begleitet wird das Projekt von sieben Unternehmen im Projektbegleitenden Ausschuss. Zudem unterstützen die Industrie- und Handelskammer Bremen sowie die Region Hannover das Vorhaben.

Im Interview gibt Dirk Schweers (BIBA) einen Ausblick auf das Projekt und erläutert, wie Unternehmen von den Forschungsergebnissen profitieren können.

Aus welcher Problemstellung heraus ist das Forschungsprojekt entstanden?

Schweers: Bei der Planung neuer beziehungsweise der Umstrukturierung bestehender Betriebsmittel werden die Anforderungen und Ziele in einem Lastenheft gebündelt, um Fremdfirmen mit der Erstellung zu beauftragen. Die Ausgestaltung stützt sich häufig auf bestehende Lösungen, persönliche Erfahrungen oder kurzfristige Wirtschaftlichkeitsaspekte. Die Vielfalt an Anforderungen, die sich aus variierenden Montageaufgaben, Automatisierungsgraden oder organisatorischen Rahmenbedingungen ergeben, werden kaum methodisch erfasst. Die Folge sind für Auftragnehmer schwer verständliche Lastenhefte und erhöhter Kommunikationsaufwand. Für die Auftraggeber entstehen nicht selten suboptimale Investitionen, zum Beispiel durch eingeschränkte Wiederverwendbarkeit von Betriebsmitteln oder verpasste Chancen zur Mitarbeitendenentlastung und Energieeinsparung. Soziale und ökologische Kriterien werden bislang nicht berücksichtigt.

Welches Know-how wird im Rahmen des Forschungsprojekts NaBeMi entwickelt und wie kann es zur Lösung der geschilderten Problemstellung beitragen?

Schweers: Im Projekt NaBeMi wird ein methodisches und technisches Wissen aufgebaut, das auf die Integration von Nachhaltigkeitsaspekten in die Betriebsmittelplanung ausgerichtet ist. Zentraler Bestandteil ist die Entwicklung eines ganzheitlichen Zielgrößensystems. Neben klassischen Kriterien wird es auch soziale, ökologische und ökonomische Wirkungen systematisch abbilden. Um die vielfältigen Zusammenhänge zwischen diesen Zielgrößen sichtbar zu machen, kommen Wirknetze zum Einsatz. Diese ermöglichen es, Abhängigkeiten, Wechselwirkungen und mögliche Zielkonflikte transparent darzustellen und in der Planung zu berücksichtigen.

Das System wird durch eine mehrstufige Methodik operationalisiert, die in Form digitaler Assistenzfunktionen umgesetzt wird. Dazu gehören die strukturierte Anforderungsanalyse, eine Zielgrößenbewertung unter Einbezug der Wirknetze sowie die Generierung und Bewertung von Lösungskonfigurationen für konkrete Betriebsmittelbedarfe. Ergänzt wird dieses methodische Know-how durch ein webbasiertes Software-Tool, das die Anwendung der entwickelten Methoden in der Praxis erleichtert.

Das entwickelte Wissen befähigt insbesondere KMU, fundierte Entscheidungen auf Basis nachvollziehbarer Kriterien zu treffen – unabhängig von individueller Erfahrung. Die Nutzung von Qualitätsregelkreisen trägt dazu bei, die Planungsgüte zu erhöhen und langfristige Wirkungen bereits in frühen Planungsphasen zu berücksichtigen.

Abb.1: Konzept von NaBeMi: Drei miteinander verknüpfte Qualitätsregelkreise zur systematischen Erfassung von Anforderungen, Zielgrößen und möglichen Lösungskonfigurationen.

(© Institut für Fabrikanlagen und Logistik (IFA), Maik Nuebel)

Wer soll von den Ergebnissen profitieren und welcher konkrete Nutzen ergibt sich für Unternehmen?

Schweers: Das Projekt richtet sich primär an kleine und mittlere Unternehmen mit einem hohen Anteil manueller oder hybrider Montagetätigkeiten. Diese Zielgruppe soll durch die entwickelten Methoden und das digitale Assistenzsystem in die Lage versetzt werden, Betriebsmittel systematisch und unter Berücksichtigung nachhaltiger Kriterien zu planen. Dabei profitieren insbesondere Unternehmen, die bisher wenig methodische Unterstützung oder digitale Werkzeuge in der Planung einsetzen konnten.

Der konkrete Nutzen liegt in einer verbesserten Planungsqualität, die über systematische Zielgrößenabwägung, strukturierte Anforderungsdefinition und transparente Entscheidungsgrundlagen erzielt wird. Unternehmen erhalten ein Tool, mit dem nicht nur klassische wirtschaftliche Zielgrößen, sondern auch ökologische und soziale Wirkungen – etwa Ergonomie, Energieverbrauch oder Wiederverwendbarkeit – in die Entscheidungsfindung einfließen können. Darüber hinaus trägt die Methodik zur Entkopplung der Planung von individueller Erfahrung einzelner Fachkräfte bei und ermöglicht eine nachvollziehbare, dokumentierte Ableitung von Investitionsentscheidungen. Neben Effizienzgewinnen und Ressourceneinsparungen können Unternehmen auch Wettbewerbsvorteile realisieren, etwa bei Ausschreibungen mit Nachhaltigkeitskriterien oder im Hinblick auf Arbeitgeberattraktivität durch mitarbeitendenzentrierte Arbeitsplatzgestaltung.

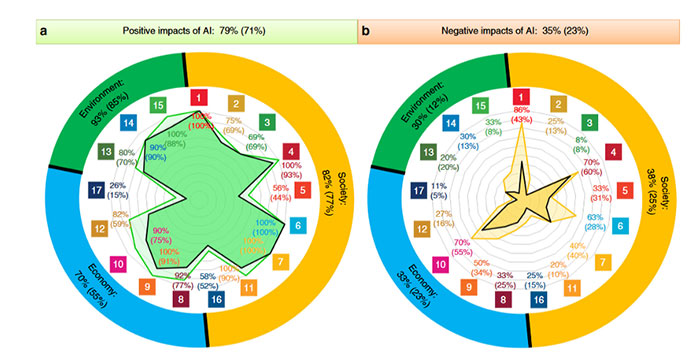

Ein erstes Meinungsbild aus dem Projektbegleitenden Ausschuss über die Potentiale des Assistenzsystems ist in Abb. 2 zu sehen.

Abb. 2: Potenziale des Assistenzsystems für die nachhaltige Planung von Betriebsmitteln

(© BIBA – Bremer Institut für Produktion und Logistik GmbH)

Wie sieht das weitere Vorgehen im Forschungsprojekt aus?

Schweers: Zunächst werden die inhaltlichen Grundlagen der drei Qualitätsregelkreise weiter ausdifferenziert, insbesondere im Hinblick auf funktionale Anforderungen, Zielgrößen und Bewertungsmaßstäbe. Wichtige Impulse hierzu liefern Workshops mit den beteiligten Unternehmen, in denen Anforderungen an Betriebsmittel, relevante Zielgrößen sowie die Gewichtung zentraler Key Performance Indicators (KPIs) diskutiert und abgestimmt werden.

Parallel dazu erfolgt die technische Konzeption des webbasierten Assistenzsystems, welches die entwickelten Methoden für die praktische Anwendung verfügbar macht. In enger Zusammenarbeit mit den Praxispartnern werden die Module des Systems prototypisch umgesetzt und in Anwendungsszenarien getestet. Dabei liegt der Fokus auf der Validierung in realitätsnahen Montagesettings – etwa in der IFA-Lernfabrik oder durch den Projektbegleitenden Ausschuss. Rückmeldungen aus der Praxis fließen systematisch in die Weiterentwicklung ein.

Abschließend erfolgt die vollständige Integration der Einzelkomponenten in das Gesamtsystem sowie eine abschließende Evaluierung hinsichtlich Anwendbarkeit, Nutzbarkeit und Planungsqualität. Ziel ist es, zum Projektende ein praxistaugliches Tool bereitzustellen, das in Unternehmen mit wenigen Anpassungen eingesetzt werden kann – ergänzt um Dokumentationen, Schulungsunterlagen und Handlungsempfehlungen für eine nachhaltigkeitsorientierte Betriebsmittelplanung.

Stimmen aus dem Projektbegleitenden Ausschuss:

Dr. Ing. Melvin Isken, Head of IT, cellumation GmbH:

Als junges, innovatives Start-up-Unternehmen aus dem Bereich der Intralogistik sind wir stets daran interessiert, unsere Prozesse nachhaltiger zu gestalten. Die Qualität der Prozesse und Produkte spielt gerade für den Eintritt in neue Märkte eine entscheidende Rolle. Mit unserem Produkt „celluveyor“ stellen wir ein weltweit einzigartiges, hochflexibles, modulares Förder- und Positioniersystem zur Verfügung, welches Unternehmen in einem sich wandelnden Produktionsumfeld die nötige Effizienz und Flexibilität bietet. Die Entwicklung und Montage der einzelnen Module und der Systeme, in denen diese zum Einsatz kommen, geschieht komplett bei uns vor Ort. Im Rahmen von NaBeMi wollen wir unsere Montageprozesse unter sozialen, ökologischen und ökonomischen Nachhaltigkeitskriterien qualitativ verbessern.

Über den Interviewpartner:

Dirk Schweers, Senior Research Associate, BIBA – Bremer Institut für Produktion und Logistik GmbH

Über das Forschungsprojekt:

Das Projekt wird im Rahmen des Programms “Industrielle Gemeinschaftsforschung” durch das Bundesministerium für Wirtschaft und Klimaschutz aufgrund eines Beschlusses des Deutschen Bundestages gefördert (Förderkennzeichen: 01IF23363N; Forschungsvereinigung: FQS – Forschungsgemeinschaft Qualität e.V.)

Weitere Informationen zum Projekt und zu Beteiligungsmöglichkeiten können über die Geschäftsstelle der FQS bezogen werden. Eine Mitarbeit im Projekt ist auch nach Laufzeitbeginn noch möglich.

Über die FQS:

Die FQS – Forschungsgemeinschaft Qualität e. V. (FQS) unterstützt seit 1989 die anwendungsorientierte Forschung rund um das Thema Qualität in Deutschland. Sie versteht sich selbst als Forschungsbereich der Deutschen Gesellschaft für Qualität e. V. (DGQ) und wird von ihr getragen. Die FQS fördert innovative Forschungsideen über das Instrument der Industriellen Gemeinschaftsforschung (IGF) und des Forschungsnetzwerks CORNET des Bundesministeriums für Wirtschaft und Klimaschutz (BMWK). Ziele der Förderung sind möglichst anwendungsnahe Forschungsideen, die einen unmittelbaren Nutzen für die Wirtschaft, insbesondere für kleine und mittelständische Unternehmen (KMU), erbringen.

Vorstellung der FQS Forschungsgemeinschaft Qualität e.V.

Wer ist die FQS Forschungsgemeinschaft Qualität e.V. und was tut sie? Lernen Sie im Video den Forschungsbereich der DGQ kennen und erfahren Sie von Dr. Christian Kellermann-Langhagen, wissenschaftlicher Geschäftsführer der FQS, wie die FQS arbeitet, welche Themen beforscht werden und wie sich Unternehmen in der FQS beteiligen und von den eingesetzten Förderprogrammen profitieren können.

Kontakt:

FQS – Forschungsgemeinschaft Qualität e. V.

August-Schanz-Straße 21A

60433 Frankfurt am Main

infofqs@dgq.de

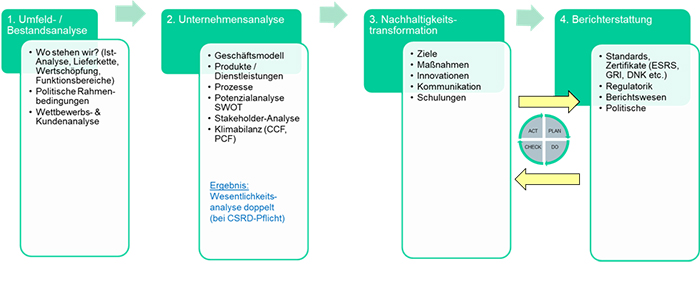

Fünf Schritte zum CO2-Fußabdruck

Die Kenntnis des CO2-Fußabdrucks ist für alle Unternehmen essenziell. Das gilt unabhängig von den aktuellen Diskussionen um das Ominbus Paket 1 der Europäischen Union sowie der Stop-the-Clock Richtlinie vom 14. April 2025 und den damit in Verbindung stehenden Regelwerken:

- Corporate Sustainability Reporting Directive (CSRD),

- European Sustainability Reporting Standards (ESRS),

- Corporate Sustainability Due Diligence Directive (CSDDD, in Deutschland das

- Lieferkettensorgfaltspflichtengesetz LkSG),

- EU-Taxonomie-Verordnung

- etc.

Eine andere häufig verwendete Bezeichnung für den CO2-Fußabdruck ist der Corporate Carbon Footprint (CCF) – nicht zu verwechseln mit dem Product Carbon Footprint (PCF). Der CCF beschreibt die direkten und indirekten Gesamtemissionen einer Organisation. Der PCF konzentriert sich auf ein Produkt oder eine Dienstleistung.

Um den anthropogenen, von Menschen gemachten, Klimawandel zu beschreiben, hat sich die Messgröße CO2-Äquivalent (CO2e) etabliert. Dazu wurden verschiedene Treibhausgase (THG), wie zum Beispiel Methan (CH4), Lachgas (N2O) und zahlreiche fluorierte Treibhausgase (F-Gase) über die entsprechende Äquivalentwerte auf das Kohlendioxid (CO2) normiert, um ihren Beitrag zur Erderwärmung zu bestimmen.

Trotz aller zu erwartenden regulatorischen Erleichterungen – Verschiebung der Berichtspflicht, Anhebung der Schwellenwerte, Reduktion der Berichtspflichten und Vereinfachung der Standards – ist für eine ganzheitliche Klimastrategie die Kenntnis des Fußabdrucks wichtig. Kenngrößen wie CO2e / EUR oder EUR / CO2e sind in vielen Organisationen bereits fest verankert.

Die Frage ist, wie ermittelt man den CO2-Fußabdruck seiner Organisation?

Die nachfolgenden fünf Schritte:

- Management einbeziehen

- Systemgrenzen festlegen

- Daten und Informationen aufbereiten

- Berechnungsmethode festlegen

- Carbon Footprint ermitteln

liefern eine Antwort auf die Frage.

Beispielhaft wird für ein imaginäres Textilunternehmen exemplarisch die Ermittlung des CO2-Fußabdrucks erläutert. Bewusst wurden in dem Beispiel einige Vereinfachungen vorgenommen, um die Übersichtlichkeit zu wahren und die Komplexität nicht unnötig zu erhöhen. Für eine ausführliche Beschreibung der fünf Schritte wird auf das Fachbuch Nachhaltigkeit und Qualitätsmanagement verwiesen.

Folgende Annahmen wurden für das imaginäre Unternehmen getroffen:

Herr Tuch ist verantwortlich für das Qualitätsmanagement, Umweltmanagement und Energiemanagement in einem Textilunternehmen. Das Unternehmen, Textil-Green, ist nahe der Wupper im Städtedreieck Remscheid-Solingen-Wuppertal ansässig. Das Unternehmen hat sich auf die Herstellung von Tischtüchern spezialisiert.

Immer häufiger fragen externe Stakeholder (zum Beispiel Kunden, NGOs, Versicherungen, etc.) an, wie viel CO2-Emissionen bei der Herstellung eines Tischtuchs entstehen. Das gesellschaftliche Interesse ist ebenso sehr groß. Endkunden wollen wissen, wie groß der CO2-Fußabdruck eines Tischtuchs ist und wie viel Emissionen pro Jahr das Textilunternehmen verantwortet.

Schritt 1: Management einbeziehen

Der Geschäftsführer des Unternehmens spricht Herrn Tuch sein Vertrauen aus und beauftragt ihn mit der Erstellung des CO2-Fußabdrucks für das Unternehmen Textil-Green. Herr Tuch ist als Beauftragter des Integrierten Managementsystems sehr gut innerhalb des Unternehmens vernetzt. Er kennt die Geschäftsprozesse inkl. der Prozessbeschreibungen und er kennt sich mit Kennzahlen aus. Zu Beginn klären die beiden einige grundlegende Fragen.

Nachfolgend eine Auswahl der wichtigsten Fragen:

- Wer wird in dem Projektteam benötigt (zum Beispiel Kolleg:innen aus dem Bereich Controlling, Produktion, Entwicklung, Logistik, Einkauf)?

- Stehen die notwendigen Ressourcen zur Verfügung (aufgrund der hohen Priorisierung müssen die Bereiche die Ressourcen zur Verfügung stellen und ggf. Vertretungen organisieren)?

- Wer ist im Steuerungskreis (das Top-Management stellt den Steuerkreis)?

- An wen wird, wie oft und in welcher Form wird berichtet (an den Steuerkreis wird einmal im Monat mit Hilfe der etablieren Projektmanagementtools berichtet)?

- Wie sieht das Eskalationsprozess aus (der Eskalationsprozess aus dem Projektmanagement wird übernommen, die 1. Eskalationsstufe sind das Projektteam und der Projektleiter, die 2. Eskalationsstufe sind die Vorgesetzten, die 3. Eskalationsstufe ist der Steuerkreis?)

- Die Zielsetzung ist SMART beschrieben. Die Abnahmekriterien für das Projekt sind eindeutig definiert.

Um alle Beschäftigten über das Projekt zu informieren, verfasst der Geschäftsführer eine Information im Internet. Die Ermittlung des CO2-Fußabdrucks stellt er als ersten großen Meilensteine der bevorstehenden nachhaltigen Transformation dar und kündigt eine Nachhaltigkeitsstrategie für das Unternehmens an. Der Geschäftsführer lädt persönlich das Projektteam und alle Interessierten zum Kick-off Gespräch ein und hält im Kick-off Gespräch die Eröffnungsrede. Dabei geht er auf die Zielsetzung des Projekts ein, stellt die strategische Bedeutung des Projekts nochmals heraus und wünscht Herrn Tuch und seinem Projektteam viel Erfolg.

Schritt 2: Systemgrenzen festlegen

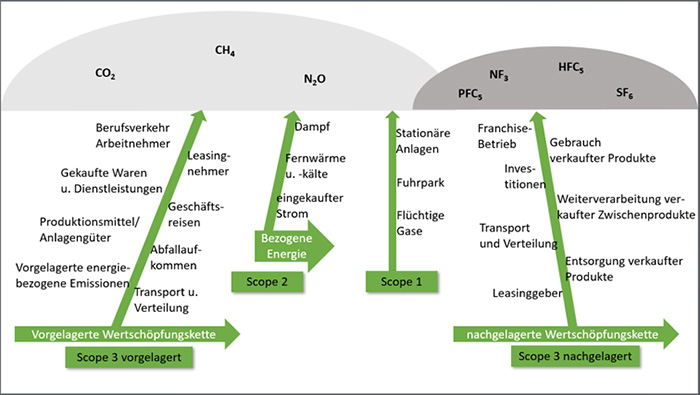

Für das erste Treffen im Projektteam hat sich Herr Tuch vorgenommen, die zeitlichen, operativen und organisatorischen Systemgrenzen zu klären. Die zeitliche Systemgrenze hatte Herr Tuch bereits mit dem Geschäftsführer abgestimmt. Der CO2-Fußabdruck soll für das vergangene Geschäftsjahr 2024, vom 1. Januar 2024 bis 31. Dezember 2024, bestimmt werden. Das Jahr 2024 soll auch als Referenzjahr für die zukünftigen Berechnungen und Vergleiche dienen. Als operative Systemgrenzen legt das Projektteam fest, dass die Scope-1-, -2- und -3-Emissionen berücksichtigt werden. In Abb. 1 sind die Scope-1-, -2- und -3-Emissionen dargestellt.

Abb. 1: Erläuterung der Scope-1-, -2-, -3-Emissionen, ©Wilhelm Floer

Bei den Scope-3-Emissionen wird zwischen vor- und nachgelagerten Emissionen unterschieden. Diese Emissionen sind in 15 Kategorien eingeteilt. Die ersten acht Kategorien stehen für Emissionen in der vorgelagerten, die letzten sieben Kategorien für die Emissionen der nachgelagerten Wertschöpfungskette.

Die organisatorischen Systemgrenzen sind schnell ermittelt, da Textil-Green nur einen Standort hat. Bei mehreren Standorten hätte man entscheiden müssen ob alle Standorte zu Beginn berücksichtigt werden oder unter Umständen auch iterativ vorzugehen ist.

Schritt 3: Daten und Informationen aufbereiten

Die Datenherkunft und Datenqualität ist für die Aufbereitung der Daten und Informationen von hoher Bedeutung.

Für die Scope-1- und -2-Emissionen kann das Projektteam auf Primärdaten zugreifen. Diese „low hanging fruits” stehen Hr. Tuch durch das Energiemanagementsystem auf Knopfdruck zur Verfügung: Um die kontinuierliche Verbesserung der energetischen Leistung des Energiemanagementsystems zu dokumentieren, hat Herr Tuch den Gas- und Stromverbrauch der vergangenen Jahre festgehalten. Die Verbrauchswerte hat der Energieversorger mit der Jahresabrechnung bereitgestellt. Auf der Abrechnung sind auch die Verbrauchswerte in CO2-Emissionen umgerechnet aufgeführt. Somit entfällt das Bestimmen der Emissionsfaktoren und das Ausrechnen der Emissionen für den Gas- und Stromverbrauch.

Laut der Jahresabschlussrechnung liegen die Emissionen für den Gasverbrauch bei 18.139 kg CO2e für Scope 1 und für den Stromverbrauch bei 7.965 kg CO2e für Scope 2.

Den kompletten Fuhrpark hat das Unternehmen 2023 auf Elektroantrieb umgestellt. Dadurch fallen für Scope 1 keine weiteren Emissionen an.

In Summe ergeben sich damit für Scope 1 und 2 ca. 26.000 kg CO2e oder 26 t CO2e.

Die Scope-3-Emissionen müssen häufig mit Hilfe von Sekundärdaten abgeschätzt werden, da keine Verbrauchsdaten vorliegen. Ein erstes Screening kann hierbei sehr hilfreich sein, um herauszufinden, welche der Scope-3-Kategorien die größten THG-Emissionen verursacht.

Bzgl. der Datenqualität und Informationsaufbereitung gelten die Grundsätze der finanziellen Rechnungslegung:

- Relevanz: der Treibhausgasemissionen

- Konsistenz: hinsichtlich der Berechnungsmethode und Vergleichbarkeit

- Genauigkeit: mit Verweis auf zuverlässige Informationsquellen

- Transparenz: bezüglich der dokumentierten Informationen, Annahmen und Schätzungen

- Vollständigkeit: Ausnahmen werden dokumentiert

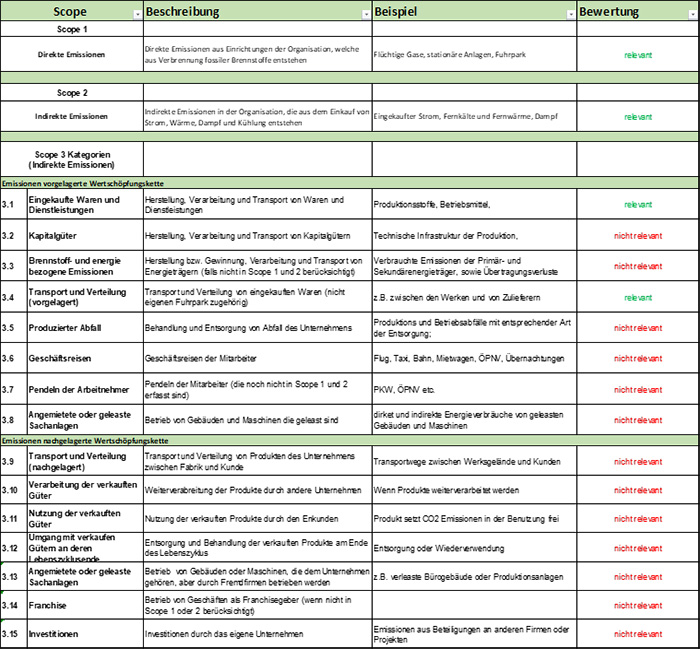

Welche der 15 Kategorien für Textil-Green relevant sind, legt das Projektteam zusammen fest. Das Ergebnis der Bewertung und die Erläuterung der 15 Kategorien ist der Checkliste in Abb. 2 zu entnehmen.

Abb. 2: Checkliste Treibhausgasemissionen Scope1, 2, 3, © Wilhelm Floer

Das Projektteam ist zu der Erkenntnis gekommen, dass die nachgelagerte Wert-schöpfungskette vernachlässigt werden kann. Für die vorgelagerte Wertschöpfungskette sind die Kategorien 3.1 und 3.4 relevant.

Schritt 4: Berechnungsmethode festlegen

Vorweg: Einen rechtlich verbindlichen Standard für die Berechnung des CO2 -Fußabdrucks gibt es nicht. Zur Erstellung einer CO2-Bilanzierung haben sich jedoch die folgenden drei Regelwerke etabliert:

Die drei Standards sind hier sehr detailliert erläutert und gegenübergestellt. Die am häufigsten verwendete Methode ist die Berechnung nach dem Greenhouse Gas Protokoll (GHG). Für die Berechnung der Treibhausgasemissionen werden Emissionsfaktoren benötigt. Diese findet man häufig auch im Internet. Nachstehend sind einige kostenlose Datenbanken für Emissionsfaktoren aufgeführt:

- Defra: Emissionsumrechnungsfaktoren, die von britischen und internationalen Organisationen verwendet werden

- GHG: Diverse Listen von Emissionsfaktoren

- IEA: Internationale Energieagentur, Indikatoren in Bezug auf Emissionen aus der Strom- und Wärmeerzeugung

- IZU: EXCEL-Template zu Berechnung der Scope 1und Scope 2 Emissionen, (Emissionsfaktoren sind hinterlegt)

- IPCC: umfangreiche Emissionsfaktoren des Intergovernmental Panel on Climate Change (IPCC)

- UBA: Sehr viele und umfangreiche Informationen über und Publikationen zu Emissionsfaktoren

- BAFA: Infoblatt zu den CO2-Faktoren der Bundesförderung für Energie- und Ressourceneffizienz in der Wirtschaft – Zuschuss

Sind die notwendigen Emissionsfaktoren bekannt, ist die Berechnung der CO2 Emissionen trivial. Die Aktivitätsdaten müssen dazu nur mit dem zugehörigen Emissionsfaktor multipliziert werden und als Ergebnis erhält man die Emissionslast in CO2e, wie nachfolgendes Beispiel zeigt:

| Aktivitätsdaten x Emissionsfaktor | = CO2e Emissionen |

| Stromverbrauch x CO2e Emissionsfaktor | = CO2e Emissionen [kg pro Jahr] |

| 1.000.000 kWh pro Jahr x 0,363kg CO2e/kWh | = 363.000kg CO2e pro Jahr |

Hier wurde der Emissionsfaktor gemäß deutschem Strommix für das Jahr 2024 angesetzt.

Herr Tuch und das Projektteam erfahren große Unterstützung durch ihre Lieferanten. Die Lieferanten notieren schon seit einiger Zeit die für die Herstellung ihrer Produkte anfallenden CO2-Emissionen auf den Lieferscheinen. Damit erleichtert sich die Situation um ein Vielfaches. Somit müssen nur alle Lieferscheine für 2024 gesichtet und die Emissionen addiert werden. Für die Herstellung der eingekauften Waren nach Scope 3 Kategorie 3.1 ergeben sich somit 75.364 kg CO2e Emissionen.

Um die Scope-3-Kategorie 3.4 für den Transport der eingekauften Waren zu ermitteln, müssen die Transportwege und Transportmittel analysiert werden. Die eingekauften Waren werden von Asien per Schiff nach Rotterdam transportiert. Von dort geht es dann weiter mit einem LKW zu Textil-Green.

In Summe wurden 1.690 l Diesel für den Transportweg eingesetzt, was 4512 kg CO2e THG entspricht.

Schritt 5: Carbon Footprint ermitteln

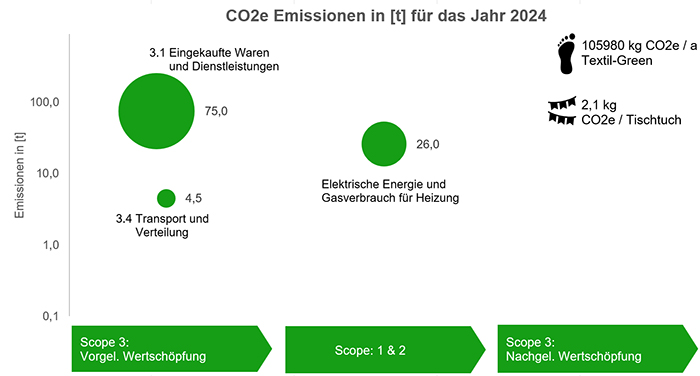

Sobald für alle Aktivitäten die CO2 Emissionen nach Scope 1, 2 und 3 vorliegen, kann durch Aufsummieren der CO2-Fußabdruck für die Organisation ermittelt werden.

In nachfolgender Tabelle sind die THG-Emissionen für Scope 1, 2 und 3 sowie die Summe der Emissionen für Textil-Green für das Jahr 2024 zusammengefasst:

| Scope | CO2e Emissionen [kg] |

|---|---|

| Scope 1 und 2 | 26.104 |

| Scope 3, Kat. 3.1 | 75.364 |

| Scope 3, Kat 3.4 | 4.512 |

| Summe | 105.980 |

Für die Herstellung von 50.000 m² Tischtuchware ergibt sich somit ein CO2-Fußabdruck von 105.980 kg CO₂e, gerundet 106 t CO₂e. Pro Tischtuch mit einer Fläche von 1 m² und einem angenommenen Gewicht von ca. 100 g entstehen also 2,1 kg CO₂e.

An dieser Stelle sei noch einmal darauf hingewiesen, dass sich für Textilunternehmen in der Praxis gänzlich andere Werte ergeben können.

In Abb. 3 ist der CO2-Fußabdruck und die Verteilung der Scope 1, 2, 3 Emissionen grafisch dargestellt. Es wird deutlich, dass die THG-Emissionen der Kategorie 3.1 mit ca. 71 Prozent am größten sind. Lediglich 25 Prozent der Emissionen sind Scope 1 und 2 zuzuschreiben.

Abb. 3: CO2-Fußabdruck und die Verteilung der Scope1, 2, 3, Emissionen, ©Wilhelm Floer

Zusammenfassung und Ausblick

Anhand eines imaginären Textilunternehmens wurde eine strukturierte Vorgehensweise zur Ermittlung des CO2-Fußabdrucks vorgestellt. Die eingangs genannten fünf Schritte haben sich mehrfach bewährt:

- das Management einbeziehen: Das Management stellt Ressourcen und Geld zur Verfügung und unterstreicht die Wichtigkeit des Themas.

- Systemgrenzen festlegen: Was will ich untersuchen, was nicht? Betrifft Standorte, Organisationseinheiten, Scope 1, 2 und/oder 3 etc.

- Daten und Informationen aufbereiten: Welche „low hanging fruits“ haben wir, zum Beispiel internes System, Energie- und Umweltmanagement? Was brauchen wir noch?

- Berechnungsmethode festlegen: GHG oder ISO 14064 oder PAS2060? (Kostenlose Software für Emissionsfaktoren verwenden).

- Carbon Footprint ermitteln: Emissionen für Scope 1, 2 und 3 summieren und darstellen, siehe Abb. 3.

Wie geht es danach weiter?

Ist der CO2-Fußabdruck bekannt, geht es darum eine Klimastrategie zu entwickeln und kontinuierlich die Emissionen im Fokus zu halten. Die Faustregel für die nächsten Schritte lautet:

- vermeiden

- reduzieren

- kompensieren

Bezogen auf Textil-Green würde das bedeuten, zunächst über Vermeidungsmaßnahmen nachzudenken. Hierzu gehört zum Beispiel der Einsatz regenerativer Energiequellen (zum Beispiel Sonnen- und Windenergie).

Um den Energieverbrauch und somit auch die THG-Emissionen zu reduzieren, bieten sich neue, hocheffiziente Technologien an, beispielsweise durch die Investition in eine neue Heizung, Umrüstung auf energetisch effiziente Maschinen und Anlagen oder den Austausch von ineffizienten Antrieben. Durch den Einsatz von recyceltem Garn könnte Textil-Green bei der Herstellung und Veredelung Emissionen reduzieren. Ebenso könnte sich durch die Bündelung der Lieferantentransporte der Kraftstoffverbrauch reduzieren.

Für die verbleibenden unvermeidbaren CO2-Emissionen könnten im letzten Schritt Kompensationsprojekte herangezogen werden. Hierfür müsste Textil-Green Emissions-Zertifikate erwerben.

Das Umweltbundesamt sieht die CO2-Kompensationen unter folgenden Bedingungen als sinnvoll an:

- Gleichen Sie unvermeidbare Treibhausgasemissionen nach Möglichkeit durch freiwillige Kompensationszahlungen aus.

- Achten Sie bei Kompensationszahlungen auf die Qualität von Anbieter und Angebot (Goldstandard).

- Beachten Sie: „Klimaneutrale“ sind nicht automatisch auch umweltfreundliche Produkte.

- Geben Sie der Vermeidung von Treibhausgasemissionen Vorrang vor deren Kompensation.

Warum sind „Qualitäter“ und Managementsystemverantwortliche gefordert?

Für einige Unternehmen ist schon jetzt das Nachhaltigkeitsmanagement das neue Qualitätsmanagement. Nachhaltigkeit ist Pflicht und Wettbewerbsvorteil zugleich und eine große Chance für Qualitätsmanager und Managementsystemverantwortliche. Organisationen müssen schneller auf neue Anforderungen in einem disruptiven Umfeld reagieren und gleichzeitig ihre Resilienz erhöhen. Hierbei können QMler und Managementsystemverantwortliche einige ihrer grund- und disziplinspezifischen Kompetenzen einbringen, wie zum Beispiel:

- sehr gute Vernetzung innerhalb der Organisation,

- ausgezeichnete Kenntnisse über Normen und Gesetze,

- hohes Prozessverständnis,

- umfangreiche Stakeholder- und Risikomanagementerfahrungen,

- umfassende Kommunikation mit extenen Stakeholdern,

- charakteristische Fähigkeiten zur Organisationsentwicklung,

- ausgeprägte Affinität zu Kennzahlen

- signifikantes Methoden- und Fachwissen

Wie groß ist der CO2-Fußabdruck Ihrer Organisation?

Der obenstehende Leitfaden, wenn auch sehr vereinfacht an einem imaginären Beispiel aus der Textilindustrie dargestellt, soll Orientierung geben und als Roadmap dienen, um den Fußabdruck in der eigenen Organisation zu ermitteln. Setzen Sie sich mit Geschäftsführung und Kolleg:innen zusammen. Gestalten Sie die nachhaltige Transformation proaktiv mit und warten Sie nicht, bis Stakeholder (zum Beispiel Kunden, Banken, Versicherer, etc.) danach fragen oder gesetzliche Vorgaben greifen. Extremwetterereignisse führen uns regelmäßig die Folgen des Klimawandels vor Augen. Die Hauptursache des anthropogenen Klimawandels ist der Ausstoß der Treibhausgase.

Bei Fragen können Sie Sich gerne an die Community des DGQ-Fachkreises Nachhaltigkeit wenden.

Die im Beitrag dargestellten Inhalte basieren auf der Erarbeitung einer Arbeitsgruppe, bestehend aus Wilhelm Floer, Greta Hansen, Joachim Heißner und Christian Tigmann, aus dem DGQ-Fachkreis Nachhaltigkeit.

Über den Fachkreis Nachhaltigkeit:

Der Fachkreis Nachhaltigkeit bietet eine entscheidende Plattform, über die wir Wissen teilen, gemeinsam lernen und Umsetzungsbeispiele für die Praxis erarbeiten und bereitstellen. Wir wollen damit einen Gestaltungsspielraum für engagierte Personen aus Organisationen bieten, die sich ihrer unternehmerischen Verantwortung gegenüber der Umwelt und der Gesellschaft, aber auch der eigenen Organisation bewusst sind. Dies gilt für die Gegenwart und die Zukunft. Somit vereinen wir Managementsysteme und Nachhaltigkeitsbestrebungen.

Über den Autor:

Dr. Wilhelm Floer hat als promovierter Maschinenbauingenieur und Qualitätsmanagement-Experte zahlreiche praktische Erfahrungen im Bereich QM, QS und Audits gesammelt. Er war über zehn Jahre im Bereich Automotive in den unterschiedlichsten Positionen bei verschiedenen Unternehmen (OEM und First Tier) tätig. Bei einem namhaften Haushaltsgerätehersteller hat er sich unter anderem für agiles QM und als Energie- und Umweltmanagementvertreter für Nachhaltigkeitsthemen eingesetzt sowie als Co-Autor bei der Erstellung der Nachhaltigkeitsberichte mitgewirkt. Als Dozent für die DGQ leitet er verschiedene Trainings und führt im Namen der DGQ-Beratungsprojekte durch. Er ist Gründungsmitglied und Mitglied des Leitungsteams des DGQ Fachkreis Nachhaltigkeit.

Interview zum FQS-Forschungsprojekt AIDpro: Datenvalidierung für Produktionsprozesse

Angesichts wachsender ökologischer und wirtschaftlicher Herausforderungen müssen nicht zuletzt kleine und mittelständische Unternehmen (KMU) ihre Produktionseffizienz absichern und idealerweise steigern, um wettbewerbsfähig zu bleiben. Durch die Digitalisierung und die Nutzung einer datenbasierten Wertschöpfung mittels künstlicher Intelligenz (KI) kann die Produktivität und Flexibilität der Fertigungsprozesse in Industrie-4.0-Umgebungen gesteigert werden. Allerdings stellen die Implementierung und das Training serienreifer KI-Lösungen sowie ihre sichere Anwendung eine komplexe Herausforderung dar.

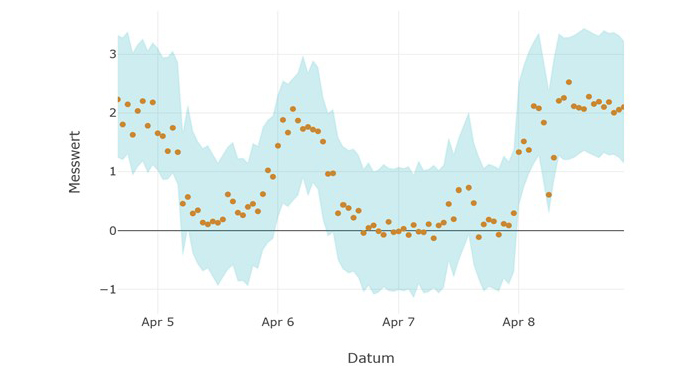

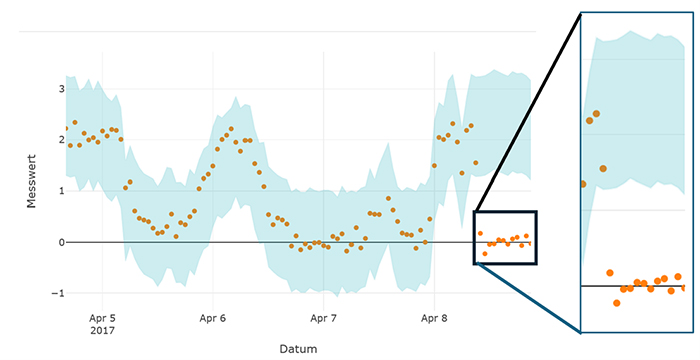

Oft sind die Prozessdaten, die die KI-Modelle im laufenden Betrieb verarbeiten, nicht vollständig durch die zuvor verwendeten Trainingsdaten repräsentiert. So weisen Sensordaten im Betrieb häufig Abnormalitäten oder Fehler auf, die durch externe Störungen, Übertragungsfehler oder defekte Sensoren verursacht werden. Zudem können Faktoren wie Saisonalität, Verschleiß und Verschmutzung dazu führen, dass sich Prozessdaten im Laufe der Zeit dynamisch ändern. Folglich können eingesetzte KI-Modelle unvorhersehbare Entscheidungen treffen, wenn aktuelle Anwendungsdaten stark von den Trainingsdaten abweichen. Um zu verhindern, dass Datenfehler die Entscheidungsfindung beeinträchtigen, müssen diese Anomalien mit höchstmöglicher Zuverlässigkeit erkannt werden, damit entsprechend gegengesteuert werden kann.

Im Rahmen des über die FQS – Forschungsgemeinschaft Qualität e.V. geförderten Forschungsprojekts AIDpro entwickeln das Fraunhofer-Institut für Produktionstechnologie IPT und das Fraunhofer-Institut für Angewandte und Integrierte Sicherheit AISEC über einen Zeitraum von zwei Jahren ein System zur automatisierten Datenvalidierung und Überwachung der Anwendungsphase von KI-Lösungen. Die Forschungsarbeiten werden von acht Unternehmen im Projektbegleitenden Ausschuss unterstützt.

Im Interview geben Jana Hüls (Fraunhofer IPT) und Wei-Herng Choong (Fraunhofer AISEC) einen Ausblick auf das Projekt und erläutern, wie Unternehmen von den Forschungsergebnissen profitieren können.

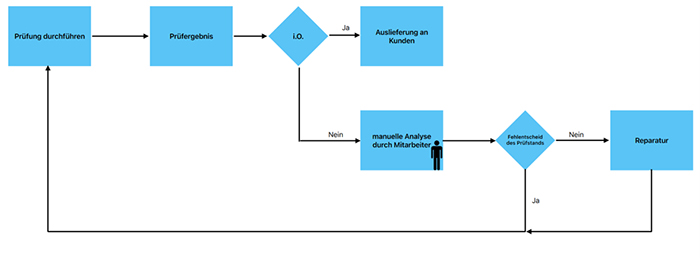

Aus welcher Problemstellung heraus ist das Forschungsprojekt entstanden?

Hüls: Die Entwicklung von serienreifen KI-Lösungen gliedert sich in zwei Phasen: die Modellbildungsphase und die Anwendungsphase. In der Modellbildungsphase erfolgen die Datenauswahl, Datenvorverarbeitung, Algorithmenauswahl sowie das Training und die Validierung des Modells. Während diese Schritte traditionell von Expertinnen und Experten übernommen werden, ermöglichen neue Ansätze im Forschungsgebiet des Automated-Machine-Learning (AutoML) eine teilweise Automatisierung bestimmter Schritte. Dadurch können KI-Lösungen auch für KMU ohne spezifische Fachkenntnisse interessanter werden.

In den cyber-physischen Produktionssystemen der Fertigungsindustrie liegen die Herausforderungen neben der Modellbildung allerdings vor allem in der Anwendungsphase von KI-Modellen. Diese Herausforderungen resultieren aus geringer Datenqualität, verursacht durch Sensorfehler und zeitlich variierende Abweichungen, den hohen Effizienzansprüchen der Branche sowie wirtschaftlichen Risiken und komplexen, oft intransparenten Systemfunktionen von KI. Besonders relevant sind die Anfälligkeit für fehlerhafte sowie sich dynamisch ändernde Daten und die wirtschaftlichen Risiken, die mit KI-Fehlentscheidungen verbunden sind. Im Betrieb leiten KI-Modelle aus Prozessdaten Informationen ab, die entweder zur Entscheidungsunterstützung oder zur autonomen Befehlsausführung genutzt werden. Dabei errechnen sich die Modellausgaben aus den im Training identifizierten Modellparametern und den momentanen Eingangsdaten. Weicht die Eingabe an die KI signifikant von den prinzipiell erlernten Strukturen der Trainingsdaten ab, können unvorhergesehene Entscheidungen durch die KI getroffen werden.

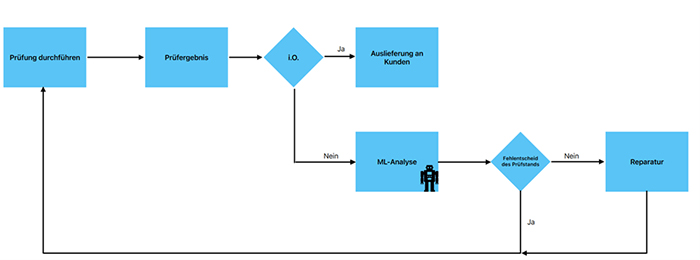

Choong: Da KI-Systeme perspektivisch auch in KMU zum Einsatz kommen müssen, um den Effizienzanforderungen gerecht zu werden, ist es entscheidend, das Risiko unvorhersehbarer KI-Entscheidungen zu minimieren. KI-Entscheidungen, die auf unzuverlässigen Daten basieren, bergen erhebliche Risiken für Produkte, Maschinen und Mitarbeiter. Für viele produzierende KMU ist die fehlende Qualität ihrer Prozessdaten und das damit verbundene Risiko ein Hemmnis beim Einsatz von KI-Modellen. An dieser Stelle soll das Forschungsprojekt AIDpro ansetzen und durch automatisierte Datenvalidierung und Überwachung der Anwendungsphase der KI-Lösungen die Grundlage für den sicheren Einsatz von KI in der Produktion ermöglichen. Dies gilt es durch geeignete, automatisierte Ansätze zur Anomalieerkennung zu adressieren.

Welches Know-how wird im Rahmen des Forschungsprojekts AIDpro entwickelt und wie kann es zur Lösung der geschilderten Problemstellung beitragen?

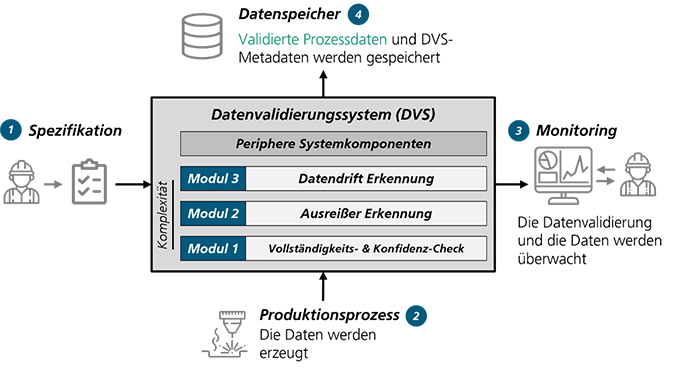

Hüls: Das Ziel von AIDpro ist die Entwicklung eines Datenvalidierungssystems (DVS) für eine automatisierte Prüfung und Sicherstellung der Datenqualität und eine Überwachung der Anwendungsphase von KI-Lösungen. Dabei wird das System speziell für den Einsatz in produktionstechnischen Systemen anhand konkreter Anwendungsfälle aus dem Projektbegleitenden Ausschuss entwickelt. Das DVS soll keine bloße Software-Bibliothek darstellen, sondern ein umfassender praxisnaher Leitfaden samt anwendungsbezogenem Software-Demonstrator sein. Der Leitfaden wird dazu dienen, KMU zu befähigen, selbstständig erste Schritte im Bereich Machine Learning zu gehen, indem eine validierte Datengrundlage aufgebaut wird.

Abb. 1: Darstellung des geplanten Datenvalidierungssystems (DVS) ©Fraunhofer IPT

Choong: Das DVS soll modular aufgebaut sein und eine direkte Schnittstelle zu den Daten aus den Produktionsprozessen haben. Zunächst werden Vollständigkeits- und Konfidenz-Checks durchgeführt, die regelbasiert überprüfen, ob alle Daten vollständig und innerhalb der von Experten vordefinierten Wertebereiche liegen. Ergänzend wird eine Erkennung von Ausreißern durchgeführt. Dafür werden insbesondere neuartige, KI-basierte Erkennungsmethoden verwendet. Des Weiteren wird das System zeitliche Veränderungen in den Daten, sogenannte Datendrifts, überprüfen. Diese Information kann Aufschluss über veränderte Produktionsbedingungen geben und dazu genutzt werden, das KI-Modell mit den veränderten Bedingungen neu zu trainieren.

Die validierten Daten inklusive der Metadaten werden anschließend gespeichert, um sie zum Beispiel für das Training von KI-Modellen für Einsätze wie intelligente Qualitätskontrolle zu nutzen. Daneben wird auch ein Data-Monitoring-Ansatz entwickelt, der die Datenvalidierung und die Daten überwacht. Das übergeordnete Ziel des DVS ist es demnach, Datenfehler, Anomalien und Datendrifts zu erkennen, zu visualisieren beziehungsweise zu alarmieren und diese – in Zusammenwirkung mit Anwendenden – zu handhaben.

Wer soll von den Ergebnissen profitieren und welcher konkrete Nutzen ergibt sich für Unternehmen?

Hüls: Von den Ergebnissen sollen insbesondere produzierende KMU profitieren. Die validierten Prozessdaten, die das DVS bereitstellt, schaffen die Voraussetzung für den industriellen Einsatz von KI. Die Überwachung der Daten während der Anwendungsphase von KI schützt zudem vor den Risiken von Fehlentscheidungen durch fehlerhafte Datenpunkte. Der praxisnahe Leitfaden unterstützt Unternehmen zusätzlich, um – aufbauend auf den validierten Daten – KI-Potenziale zu erschließen, die sich zum Beispiel in der Qualitätskontrolle, der intelligenten Wartung, oder der Identifizierung ressourceneffizienter Betriebspunkte und Qualitätsvorhersagen ergeben. Außerdem können die Unternehmen durch das DVS und das transparente Data Monitoring eine unternehmensinterne Datenkompetenz aufbauen.

Wie sieht das weitere Vorgehen im Forschungsprojekt aus?

Choong: Zunächst werden wir eng mit dem Projektbegleitenden Ausschuss zur Identifizierung und Definition relevanter Anwendungsfälle zusammenarbeiten. Unser Ziel ist es, eine vielfältige Sammlung von praxisnahen und relevanten Anwendungsfällen und Datensätzen zu erstellen, um ein allgemeines DVS entwickeln zu können. Basierend auf diesen Anwendungsfällen leiten wir die Spezifikationen und Anforderungen an das DVS ab, die uns bei der Entwicklung und Implementierung des Gesamtkonzepts leiten. Nach der erfolgreichen Implementierung des DVS führen wir mit den Industriepartnern die Validierung und Evaluierung des DVS in einer realen Fertigungsumgebung zusammen durch. Das Feedback der Unternehmen wird in eine weitere Entwicklungsiteration einfließen. Anschließend werden wir weiterführende Anwendungsszenarien für das DVS identifizieren und bewerten, wobei der Schwerpunkt auf Themen wie Predictive Maintenance und Qualitätssicherung liegt.

Stimmen aus dem Projektbegleitenden Ausschuss:

André Heinke, Leiter Vertrieb und Marketing, Bitmotec GmbH:

Als Partner im Projektbegleitenden Ausschuss des Forschungsprojekts AIDpro engagiert sich die Bitmotec GmbH für die Entwicklung standardisierter Methoden zur Sicherung der Datenqualität in Produktionsprozessen. Mit unserer Industriellen Datenplattform BITMOTECOsystem verbinden wir Maschinen und Sensoren in produzierenden Unternehmen, um beispielsweise OEE-Lösungen umzusetzen. Aus unserer langjährigen Erfahrung mit KI-Technologien in der Industrie wissen wir, dass die Qualität und Integrität der erfassten Daten eine zentrale Rolle spielen. Nur wenn Industrieunternehmen ihren Daten vertrauen, sind sie bereit, den Ergebnissen zukünftiger KI-Technologien zu glauben und diese gewinnbringend einzusetzen.

Durch die Teilnahme an AIDpro wollen wir innovative Ansätze zur kontinuierlichen Überwachung und Validierung von Prozessdaten erarbeiten. Die Identifikation von Ausreißern und Datendrifts – etwa durch Verschleiß oder Messfehler – ist essenziell, um verlässliche Entscheidungsgrundlagen für KI-gestützte Optimierungen zu schaffen. Die Erkenntnisse aus dem Forschungsprojekt helfen uns, unsere Lösungen für die digitale Produktion weiterzuentwickeln und unseren Kunden eine noch höhere Datenqualität sowie Prozesssicherheit zu bieten. So schaffen wir eine stabile Basis für den erfolgreichen Einsatz von KI in der industriellen Praxis.

Daniel Narberhaus, Research & Development, Aventus GmbH & Co. KG:

Unsere Motivation für die Teilnahme am Forschungsprojekt AIDpro ist klar: Wir wollen KI nicht nur anwenden, sondern verstehen – und vor allem auf einer qualitativ hochwertigen Datenbasis weiterentwickeln. Statt auf bloße Datenmengen zu setzen, legen wir den Fokus auf plausible, nachvollziehbare Daten. Nur so können wir KI-Lösungen schaffen, die nicht nur leistungsfähig, sondern auch vertrauenswürdig und praxisnah zum Nutzen unserer Kunden sind. Die im Projekt gewonnenen Erkenntnisse fließen direkt in die Neu- und Weiterentwicklung unserer digitalen AVENTUS-Produkte ein – mit dem Ziel, für unsere Kunden noch intelligentere und verlässlichere Lösungen für eine leistungsstarke Produktion zu entwickeln.

Über die Interviewpartner:

Jana Hüls, Wissenschaftliche Mitarbeiterin, Production Quality, Fraunhofer-Institut für Produktionstechnologie IPT

Wei Herng Choong, Department Cognitive Security Technologies, Fraunhofer-Institut für Angewandte und Integrierte Sicherheit AISEC

Über das Forschungsprojekt:

Das Projekt wird im Rahmen des Programms „Industrielle Gemeinschaftsforschung” durch das Bundesministerium für Wirtschaft und Klimaschutz aufgrund eines Beschlusses des Deutschen Bundestages gefördert (Förderkennzeichen: 01IF23103N; Forschungsvereinigung: FQS – Forschungsgemeinschaft Qualität e.V.) Weitere Informationen zum Projekt und zu Beteiligungsmöglichkeiten können über die Geschäftsstelle der FQS bezogen werden. Eine Mitarbeit im Projekt ist auch nach Laufzeitbeginn noch möglich.

Weitere Informationen finden Sie auf der Website des Fraunhofer IPT »

Über die FQS:

Die FQS – Forschungsgemeinschaft Qualität e. V. (FQS) unterstützt seit 1989 die anwendungsorientierte Forschung rund um das Thema Qualität in Deutschland. Sie versteht sich selbst als Forschungsbereich der Deutschen Gesellschaft für Qualität e. V. (DGQ) und wird von ihr getragen. Die FQS fördert innovative Forschungsideen über das Instrument der Industriellen Gemeinschaftsforschung (IGF) und des Forschungsnetzwerks CORNET des Bundesministeriums für Wirtschaft und Klimaschutz (BMWK). Ziele der Förderung sind möglichst anwendungsnahe Forschungsideen, die einen unmittelbaren Nutzen für die Wirtschaft, insbesondere für kleine und mittelständische Unternehmen (KMU), erbringen.

Vorstellung der FQS Forschungsgemeinschaft Qualität e.V.

Wer ist die FQS Forschungsgemeinschaft Qualität e.V. und was tut sie? Lernen Sie im Video den Forschungsbereich der DGQ kennen und erfahren Sie von Dr. Christian Kellermann-Langhagen, wissenschaftlicher Geschäftsführer der FQS, wie die FQS arbeitet, welche Themen beforscht werden und wie sich Unternehmen in der FQS beteiligen und von den eingesetzten Förderprogrammen profitieren können.

Kontakt:

FQS – Forschungsgemeinschaft Qualität e. V.

August-Schanz-Straße 21A

60433 Frankfurt am Main

infofqs@dgq.de

Wer managt die Nachhaltigkeit? – Neue Themen, neue Zuständigkeiten

In Unternehmen ist Nachhaltigkeit ein Thema, das Können und Zeit erfordert, Kompetenz und Ressource. Wachsende Verpflichtungen auf Basis neuer gesetzlicher Anforderungen und auch wachsende Einsicht in die Notwendigkeit der Zukunftssicherung begründen neue Funktionen: Nachhaltigkeitsmanager, -berater und -experten. Sie stellen aber vor allem kleine und mittelständische Unternehmen vor erhebliche Herausforderungen.

Welche neuen Rollen zeichnen sich ab, wie richten Unternehmen die Funktionen ein, welche Zuständigkeiten kristallisieren sich heraus? Wird das Thema Nachhaltigkeit eigens adressiert oder mit anderen, wie dem Qualitätsmanagement kombiniert? Die DGQ geht diesen Fragen nach und stützt sich dabei auf Recherchen, Diskussionen in ihrem Netzwerk sowie eine eigens durchgeführte, nicht repräsentative Kurzumfrage mit 100 Teilnehmenden.

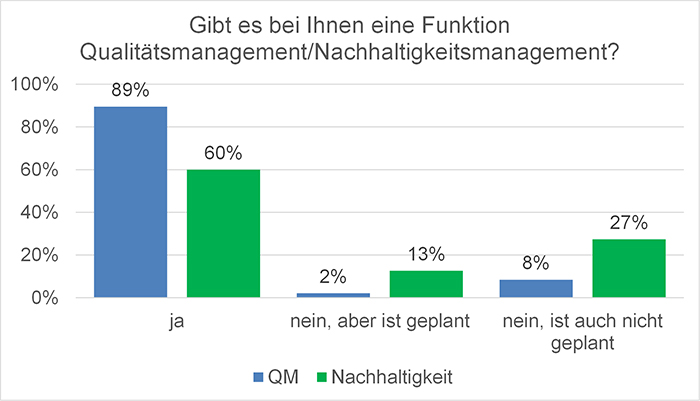

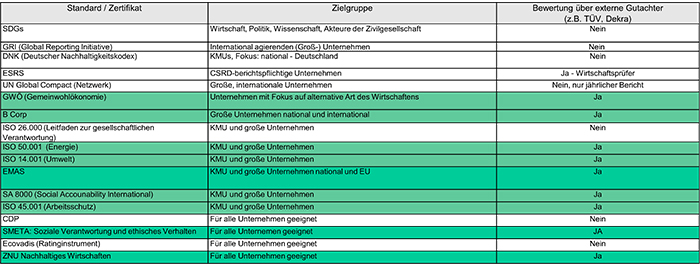

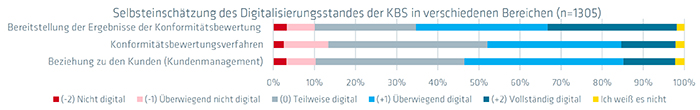

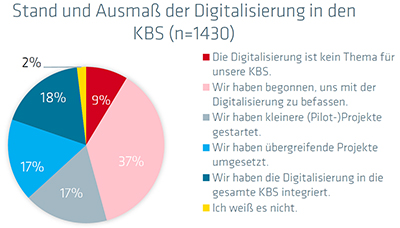

Im Vergleich zum Qualitätsmanagement, das in vielen Unternehmen schon lange eingerichtet und mit eigenem Personal ausgestattet ist, sind Stellen für das Nachhaltigkeitsmanagement in weniger Unternehmen und erst seit einigen Jahren geschaffen worden, zumeist innerhalb der vergangenen fünf Jahre. 13 Prozent der Unternehmen in der DGQ-Kurzumfrage planen die Einrichtung einer Stelle für Nachhaltigkeit, 27 Prozent haben und planen zurzeit keine, siehe Abb. 1. Doch das kann sich ändern, wenn externer Druck und interne Notwendigkeit weiter anwachsen.

Abb. 1: Vorhandensein der Funktionen Qualitätsmanagement und Nachhaltigkeitsmanagement

Budget bei den Großen …

Je größer das Unternehmen, desto länger und zahlreicher sind neue Berufsbilder bereits im Einsatz, desto eher ist für Nachhaltigkeit ein eigener Bereich aufgebaut worden. Und gerade in den großen Unternehmen genießt die Nachhaltigkeit zurzeit große Aufmerksamkeit und direkte Anbindung an Vorstände und Geschäftsführungen. Das ist verständlich, ist deren gesetzliche Verpflichtung und persönliche Verantwortung doch besonders umfangreich und weitreichend und der Blick der globalen Öffentlichkeit auf ihre Nachhaltigkeitsaktivitäten und vor allem auch -unterlassungen fokussiert. Die Nachhaltigkeitsbereiche der Konzerne erfahren zurzeit eine Bedeutung, Wertschätzung und Budgetierung, auf die andere Stabs- und Expertenfunktionen durchaus sehnsüchtig und nicht selten ein wenig neidisch blicken.

Pragmatismus bei den Kleinen …

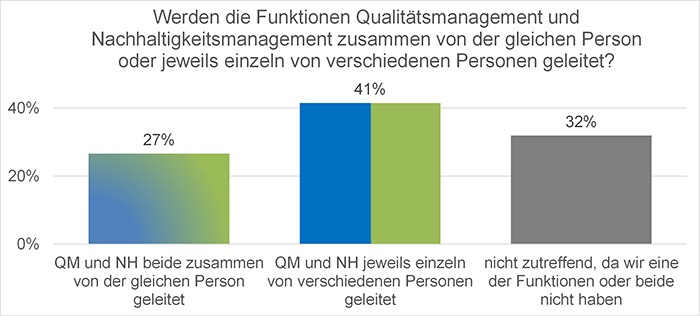

Im Mittelstand, vor allem in den zahlreichen kleinen Unternehmen, zeigt sich ein anderes Bild. Einige Unternehmen schlagen die recht neue Funktion Nachhaltigkeitsmanagement sehr pragmatisch einer bereits vorhandenen Stelle zu. Ein naheliegender Kandidat ist das Qualitätsmanagement, siehe Abb. 2.

Abb. 2: Einzel- oder Doppelfunktion

Zum einen herrscht gerade ein Engpass an Expertinnen und Experten für Nachhaltigkeit und die großen Unternehmen sowie Unternehmensberatungen grasen den ohnehin dünn besetzten Bewerbermarkt ab. Zum anderen schlägt der Aufbau dieser Personalressourcen umso stärker zu Buche, je kleiner das Unternehmen ist.

Kleine Unternehmen, insbesondere produzierende, haben zumeist eine Beauftragte oder einen Beauftragten für Qualitätsmanagement und bitten diese pragmatisch, das Thema Nachhaltigkeit mitzuverarbeiten. Dieser Impuls ist umso stärker, wenn Leitungen Nachhaltigkeit vor allem mit formaler Anforderungserfüllung und Berichtspflichten verbinden. Dann gibt es ausgeprägte Verwandtschaften zum und Synergien mit dem Qualitätsmanagement.

Dennoch erzeugt dieses „Job Enrichment“, diese Aufgabenanreicherung, zusätzliche Aufwände, ohne dass mehr Ressource verfügbar wäre. Sie verlangt von den Qualitätsbeauftragten, sich neue Kompetenzen anzueignen, was für sie den Initialaufwand für die Übernahme des Nachhaltigkeitsmanagements noch deutlich erhöht. So sind in der Praxis einzelne Qualitätsmanagerinnen und -manager nicht glücklich über den Themenzuwachs. Andere begrüßen, dass das Unternehmen hier aktiver wird, und haben durchaus selbst auch Motivation und Interesse, das Nachhaltigkeitsmanagement auszubauen oder weiterzuentwickeln.

| Berufsbild Nachhaltigkeitsmanager Die Themen Nachhaltigkeit und Klimaschutz gehören zu den Megatrends unserer Zeit. Für Unternehmen wird es somit immer wichtiger, CSR-Maßnahmen umzusetzen und ihrer gesellschaftlichen Verantwortung gerecht zu werden. Mit dem größeren Fokus auf Nachhaltigkeit haben sich in den letzten Jahren eine Vielzahl an grünen Jobs entwickelt, wie beispielsweise der Job als Nachhaltigkeitsmanager. Antworten auf die wichtigsten Fragen finden Sie in unserem Berufsbild zum Nachhaltigkeitsmanager:

|

Risiken der Trennung und Chancen der Integration

Je größer ein Unternehmen, desto stimmiger ist eine Spezialisierung und damit einhergehende Differenzierung von Stabs- und Expertenbereichen. Doch ob organisatorisch getrennt oder nicht: Zusammenarbeit ist ein Schlüssel zur Wirksamkeit. Oder andersherum, fehlende Kooperation schafft Widersprüchlichkeiten, Dysfunktionalitäten, Verschwendung, Konflikte sowie die dadurch entstehenden zum Teil enormen Kosten und sie beschädigt die Effektivität sowie die Akzeptanz im Unternehmen.

Und wenn es schon eigene und unabhängige Funktionen und Bereiche für Nachhaltigkeit gibt und diese zumindest temporär hochrangig angebunden, exzellent ausgestattet und weitreichend befugt werden, ist es dennoch notwendig, sie zur Kooperation und Integration zu verpflichten. Besonders wichtig sind Kooperation und Integration auf Prozessebene, auf Managementsystemebene sowie bei Anforderungsmanagement, Wirkungsmessung und Reporting. Eine gute Integration bietet die Chancen einer effizienten Themenbearbeitung sowie auch der höheren Mitarbeitendenbeteiligung und -akzeptanz.

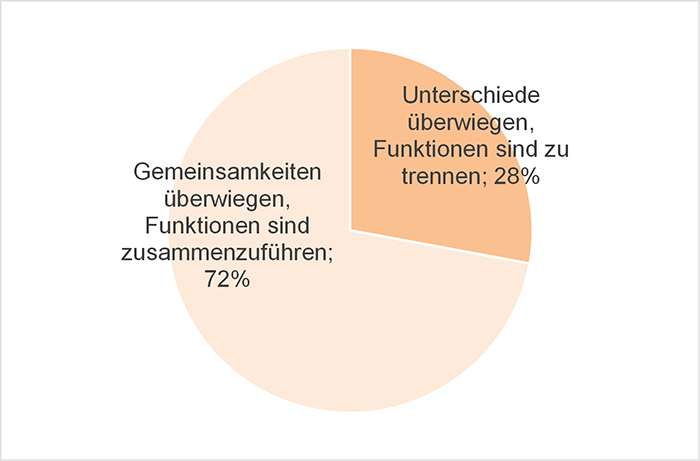

Die Mehrheit der Befragten der DGQ-Kurzumfrage favorisiert folgerichtig die Zusammenlegung der Funktionen, siehe Abb. 3.

Abb. 3: Trennen oder Zusammenlegen der Qualitätsmanagement- und Nachhaltigkeitsfunktionen

Im Mittelstand sind kombinierte Funktionen leichter anzulegen und können helfen, die zusätzliche erforderliche Ressource möglichst gering zu halten. Das kann aber nur gelingen, wenn Qualitäts-, Nachhaltigkeits- und zudem auch Arbeitssicherheitsmanagement, IT-Sicherheitsmanagement und weitere stark extern regulierte Thematiken besser miteinander kombiniert werden. All diese und weitere Themen sollten über ein System gemanagt werden, das System und seine einzelnen Prozesse, Spezifikationen sollten schlank angelegt und gut synchronisiert werden. Die Anwendbarkeit durch Mitarbeitende im Alltag und nicht Auditierungen und akribische Regelauslegung, die oft in die Überformalisierung führt, sollten dabei im Fokus stehen.

Viele etablierte klassische und nach wie vor sehr dokumentenlastige Managementsysteme leisten das nicht gut. Gerade weil externe Reglementierung eskaliert, muss interne Übersetzung in Prozesse und Spezifikationen so schlank und nutzerfreundlich wie möglich erfolgen. Dazu können immer bessere KI-basierte Assistenzsysteme eingesetzt werden. Statt in mehreren parallel gültigen Dokumenten mühsam die relevanten Vorgaben zu suchen oder sie riskant zu ignorieren, sollten diese Systeme im Workflow genau und nur das anzeigen, was jetzt zu tun und zu lassen ist, um gesetzliche, normative und vertragliche Verpflichtungen und Anforderungen einzuhalten.

Schlanke interne Formalisierung ist eine eigenverantwortliche Antwort auf eskalierende externe Bürokratisierung

Leitungen sollten von ihren bestehenden und neu eingesetzten Qualitäts- und Nachhaltigkeitsmanagerinnen und -manager Nutzerorientierung und einen Regelungsminimalismus einfordern. Wer externes Wachstum an Bürokratie nur beklagen, aber nicht beeinflussen kann, muss im eigenen Verantwortungsbereich gut gemeinte, aber oft übergriffige und in Summe dysfunktionale externe Vorgaben in gut gemachte interne Systeme und Regeln transformieren.

Über den Autor:

Benedikt Sommerhoff leitet bei der DGQ das Themenfeld Qualität & Innovation. Er beobachtet, analysiert und interpretiert die Paradigmenwechsel und Trends in Gesellschaft und Wirtschaft sowie ihre Wirkungen auf das Qualitätsmanagement. Seine zahlreichen Impulse in Form von Publikationen und inspirierenden Vorträgen geben Orientierung in Zeiten des Wandels. Sie ermutigen zur Neukonzeption des Qualitätsmanagements und der Qualitätssicherung. Gemeinsam mit Expertinnen und Experten des DGQ-Netzwerks aus Praxis und Wissenschaft arbeitet Sommerhoff in Think Tanks und Pionierprojekten an der Entwicklung, Pilotierung und Vermittlung innovativer Konzepte und Methoden.

Lean Management und Six Sigma: Prozessoptimierung in wirtschaftlich heraufordernden Zeiten

Steigende Kosten, volatile Lieferketten und hohe Kundenanforderungen machen es notwendig, Prozesse nicht nur zu verschlanken, sondern auch in ihrer Zuverlässigkeit und Vorhersagbarkeit zu optimieren. Durch die Kombination von Lean-Methoden und Six Sigma-Techniken können Unternehmen nachhaltig wettbewerbsfähiger werden. Besonders in unsicheren Zeiten profitieren Unternehmen von robusten, standardisierten Prozessen, die eine höhere Produktivität, geringere Kosten und eine verbesserte Kundenzufriedenheit ermöglichen.

Wo liegt der Unterschied zwischen Lean Management und Six Sigma?

Während Lean darauf abzielt, Prozesseffizienz durch Verschlankung und Standardisierung zu erreichen, konzentriert sich Six Sigma auf die Fehlerminimierung durch prozess- und datenbasierte Analyse und Prozesskontrolle. Six Sigma nutzt einen statistischen Ansatz, um Schwachstellen zu identifizieren und nachhaltig zu eliminieren.

Obwohl beide Methoden das Ziel verfolgen, Prozesse zu optimieren und Unternehmen wettbewerbsfähiger zu machen, gibt es wesentliche Unterschiede:

| Aspekt | Lean Management | Six Sigma |

|---|---|---|

| Zielsetzung | Eliminierung von Verschwendung und nicht-wertschöpfenden Tätigkeiten | Reduzierung von Variabilität und Fehlern |

| Fokus | Effizienzsteigerung und schnelle Durchlaufzeiten | Qualitätsverbesserung und statistische Kontrolle |

| Methodik | Visuelle Werkzeuge wie Wertstromanalyse, 5S, Kaizen | Prozess- und datengetriebene Analyse mit DMAIC-Zyklus |

| Ansatz | Ganzheitliche Optimierung der Wertschöpfungskette | Detaillierte Prozessanalyse auf Basis statistischer Methoden |

| Typische Anwendung | Produktionsoptimierung, Logistik, Supply Chain | Qualitätsmanagement, Fehlerreduktion in Produktion und Dienstleistung |

Six Sigma wurde ursprünglich von Motorola in den 1980er-Jahren entwickelt und setzt auf eine datengestützte Methodik zur Fehlerreduktion. Dabei folgt Six Sigma dem DMAIC-Zyklus:

- Define (Definieren): Klare Problemstellung und Zielsetzung.

- Measure (Messen): Erfassung und Analyse von Daten zur Bewertung des Ist-Zustands.

- Analyze (Analysieren): Identifikation von Fehlerquellen und deren Ursachen.

- Improve (Verbessern): Entwicklung und Implementierung von Lösungen zur Fehlerreduzierung.

- Control (Steuern): Langfristige Überwachung und Standardisierung der verbesserten Prozesse.

Lean Six Sigma – eine sinnvolle Ergänzung beider Methoden

Die Kombination von Lean-Methoden mit dem DMAIC-Zyklus ermöglicht eine ganzheitliche Prozessoptimierung, die sowohl Effizienzsteigerung (Lean) als auch Fehlerminimierung (Six Sigma) umfasst. Jede Phase des DMAIC-Zyklus kann durch Lean-Prinzipien und -Werkzeuge gezielt ergänzt werden, um den Nutzen zu maximieren.

DEFINE: Problemstellung und Ziele klar definieren

- Wertstromanalyse (Value Stream Mapping, VSM): Visualisierung des gesamten Prozesses zur Identifikation von Engpässen und nicht-wertschöpfenden Aktivitäten.

MEASURE: Datenerhebung zur Ist-Analyse

- 5S-Methode: Standardisierung und Organisation des Arbeitsplatzes, um Messungen unter stabilen Bedingungen durchzuführen.

- Spaghetti-Diagramm: Analyse von Bewegungsabläufen zur Identifikation von ineffizienten Wegen.

ANALYZE: Identifikation der Hauptursachen für Probleme

- Ishikawa-Diagramm (Ursache-Wirkungs-Diagramm): Systematische Untersuchung von Verschwendungsursachen.

- Pareto-Analyse: Konzentration auf die wesentlichen Ursachen nach dem 80/20-Prinzip.

IMPROVE: Entwicklung und Implementierung von Lösungen

- Kaizen (kontinuierliche Verbesserung): Iterative, kleine Verbesserungen im Prozess.

- Pull-System (Kanban): Einführung einer bedarfsgerechten Steuerung, um Überproduktion zu vermeiden.

CONTROL: Nachhaltige Sicherstellung der Verbesserungen

- Standardisierte Arbeitsanweisungen (SOPs): Dokumentation und Vereinheitlichung der optimierten Prozesse.

- PDCA-Zyklus (Plan-Do-Check-Act): Sicherstellung einer kontinuierlichen Verbesserung nach der DMAIC-Umsetzung.

Praxisbeispiel 1: Lean Six Sigma in der Produktionslinie

Ein mittelständisches Unternehmen aus der Automobilzulieferindustrie litt unter hohen Ausschussraten in der Produktion, die zu steigenden Kosten und Verzögerungen in der Lieferkette führten. Um die Probleme zu lösen, wurde ein Lean Six Sigma-Projekt initiiert.

Analyse der Situation:

- Die Produktionslinie produzierte 5 % Ausschuss, was jährliche Verluste von mehreren Hunderttausend Euro verursachte.

- Durch eine Wertstromanalyse wurden unnötige Wartezeiten und ineffiziente Abläufe identifiziert.

- Mit der Six Sigma-Methodik wurde festgestellt, dass ein bestimmter Maschinenprozess für 70 % der Fehler verantwortlich war.

Umsetzung mit Lean Six Sigma:

- Anwendung der 5S-Methode zur besseren Arbeitsplatzorganisation.

- Anpassung der Maschinenparameter durch eine statistische Versuchsplanung (Design of Experiments, DOE).

- Schulung der Mitarbeiter auf Fehlervermeidungstechniken.

Ergebnis:

- Reduzierung der Ausschussrate von 5 % auf 1,2 % innerhalb von sechs Monaten.

- Einsparungen von über 500.000 Euro pro Jahr.

- Höhere Kundenzufriedenheit durch pünktlichere Lieferungen und bessere Produktqualität.

Dieses Beispiel zeigt, dass Unternehmen durch die Kombination von Lean- und Six Sigma-Methoden nachhaltige Verbesserungen erzielen und langfristig wettbewerbsfähig bleiben können.

Praxisbeispiel 2: Lean Six Sigma in der Logistik

Ein großes Handelsunternehmen mit europaweiter Distribution stand vor erheblichen Herausforderungen in seiner Logistik.

Analyse der Situation:

- Lieferverzögerungen von durchschnittlich 48 Stunden aufgrund ineffizienter Prozesse in der Lagerhaltung und Kommissionierung.

- Hohe Fehlerrate von 7 % in der Auftragsabwicklung, was zu Rücksendungen, Nachlieferungen und steigenden Kosten führte.

- Überfüllte Lagerbestände, die Kapitalbindung verursachten, während gleichzeitig Engpässe bei gefragten Produkten auftraten.

Umsetzung mit Lean Six Sigma

Anwendung von Lean-Methoden zur Effizienzsteigerung:

- Eine Wertstromanalyse (Value Stream Mapping) deckte auf, dass es unnötige Transportwege im Lager gab, wodurch sich die Kommissionierzeiten verlängerten.

- Die Einführung eines 5S-Systems optimierte die Lagerorganisation und reduzierte Suchzeiten für Artikel.

- Durch die Umstellung auf ein Pull-System (Kanban) wurden Bestände dynamischer gesteuert, wodurch Engpässe und Überbestände minimiert wurden.

Anwendung von Six Sigma zur Qualitätsverbesserung:

- Eine Fehlermöglichkeits- und Einflussanalyse (FMEA) identifizierte, dass die häufigste Fehlerquelle fehlerhafte Bestandsdaten im ERP-System war.

- Durch den Einsatz statistischer Prozesskontrolle (SPC) wurden Unregelmäßigkeiten in der Bestandsführung frühzeitig erkannt.

- Die Mitarbeiterschulung auf standardisierte Arbeitsanweisungen (SOPs) und die Einführung von modernen Barcode-Scannern führten zu einer deutlichen Senkung der Fehlerquote.

Ergebnis:

- Reduzierung der Lieferverzögerungen um 60 % (von 48 Stunden auf 19 Stunden).

- Fehlerrate in der Auftragsabwicklung von 7 % auf 1,5 % gesenkt.

- Lagerbestand um 22 % reduziert, ohne Lieferengpässe zu verursachen.

- Kosteneinsparungen von 750.000 € pro Jahr durch reduzierte Nachlieferungen und effizientere Lagerhaltung.

Dieses Beispiel zeigt, dass Lean Six Sigma in der Logistik nicht nur Prozesse effizienter gestaltet, sondern auch die Qualität der Auftragsabwicklung erheblich verbessert.

Fazit: Die Zukunft gehört integrierten Optimierungsstrategien

Lean als Basis zur Optimierung der Wertströme, Six Sigma zur datengetriebenen Verbesserung der Prozessqualität – gemeinsam führen sie zu maximaler Effizienz und Stabilität. In einer zunehmend komplexen und dynamischen Wirtschaftsumgebung sollten Organisationen beide Aspekte im Blick haben.

Lean Six Sigma bietet einen bewährten Rahmen, um Prozesse strategisch zu optimieren, Kosten zu senken und Qualitätsstandards nachhaltig zu steigern. Die methodische Verbindung beider Ansätze ermöglicht es Unternehmen, sich langfristig gegen Wettbewerber zu behaupten und auch in wirtschaftlich schwierigen Zeiten erfolgreich zu agieren.

Die erfolgreiche Umsetzung erfordert jedoch eine konsequente Verankerung der Lean Six Sigma-Philosophie im Unternehmen. Fach- und Führungskräfte müssen nicht nur die Methoden verstehen, sondern auch die Prinzipien von kontinuierlicher Verbesserung, datenbasierter Entscheidungsfindung und nachhaltiger Prozesskontrolle in ihrem Unternehmen implementieren. Nur so lässt sich der Grundgedanke von Lean Management und Six Sigma zu einem leistungsfähigen Gesamtmodell vereinen.

Mit den DGQ-Trainings zum „Lean Six Sigma Green Belt“ oder „Lean Six Sigma Black Belt“ erfahren die Teilnehmenden konkret, wie sie Lean-Methoden mit der DMAIC-Vorgehensweise nachhaltig für die Prozessverbesserung einsetzen können.

Über den Autor:

Oliver Schneider ist als Produktmanager seit 2015 bei der DGQ und verantwortet in der DGQ Weiterbildung das Trainingsportfolio zum Thema Qualitätsmanagement und Lean Six Sigma. Seine Qualifizierungen als Qualitätsmanager und Lean Six Sigma Green Belt ermöglichen es ihm, die Weiterentwicklung dieser Themen aktiv zu gestalten und Fachkräfte gezielt zu beraten.

Gamification im Qualitätsmanagement – innovatives Lernen durch digitale Team-Battles

Wie Festo durch spielerisches Lernen Teamgeist und Qualitäts-Know-how stärkt

Im Qualitätsmanagement der Festo SE & Co. KG, einem weltweit führenden Anbieter in der pneumatischen und elektrischen Automatisierungstechnik, herrscht eine ungewöhnliche Atmosphäre. QM-Mitarbeiter aus unterschiedlichen Unternehmensbereichen und Standorten diskutieren Qualitätsfragen und tippen um die Wette Antworten in ihre Smartphones und PCs. Der Grund: Ein innovatives Gamification-Projekt in Form eines Quiz-Gewinnspiels. Das Familienunternehmen mit Hauptsitz in Esslingen, das seit über 60 Jahren Impulsgeber in der Automatisierung ist und auf das weltweit 300.000 Kunden in der Fabrik- und Prozessautomation vertrauen, geht neue Wege in der Qualifizierung seiner Belegschaft. Als innovative Ergänzung zu klassischen Trainings treten die QM- Mitarbeiter in einem digitalen Quiz-Battle gegeneinander an und frischen dabei spielerisch ihr Fachwissen über das Qualitätsmanagement auf.

Learning by Gaming mit der DGQ-Lern-App

Manchmal entstehen die besten Ideen aus persönlicher Erfahrung. Wie Stefan Schwerdtle, Vice President Corporate Quality, berichtet, stand er als Quereinsteiger im Qualitätsmanagement vor einer typischen Herausforderung: „Wie komme ich schnell auf Augenhöhe mit erfahrenen QM-Experten?” Auf der Suche nach einer adäquaten Fachausbildung entschied er sich für die Lehrgangsreihe der DGQ Weiterbildung zum Qualitätsmanager, die ihm das nötige Grundhandwerkzeug für seine neue Rolle vermittelte.

Während des Trainings lernte er die Vorteile der DGQ-Lern-App kennen. „Abends im Tagungshotel habe ich viel lieber mit der App gelernt, als den auch zur Verfügung gestellten Papierordner durchzuarbeiten“, beschreibt Schwerdtle seine Erfahrung. Das didaktische Konzept, ein digitales Karteikastensystem mit intelligentem Wiederholalgorithmus, überzeugte ihn: „Wenn man eine Frage dreimal richtig beantwortet hatte und sie damit in der ”3x-Richtig-Box“ landete, war das Wissen für die Prüfung abrufbar.”

Der Quiz-Aspekt kam per Zufall dazu, als ein Festo-Kollege aus demselben Kurs Schwerdtle abends zu einem Quiz-Battle herausforderte. „Das war der Moment, wo der Spaß am Lernen begann“, erinnert er sich. „Man hat sich in der Woche gegenseitig herausgefordert und schnell gemerkt, welche Kategorie man schon besser konnte als der andere und wo man noch nacharbeiten musste.” Auch nach der Zertifizierung setzen die Kollegen die Quiz-Runden fort. Dies inspirierte Schwerdtle, das DGQ-Quiz in größerem Rahmen für die Mitarbeiterqualifizierung zu nutzen. Im Sommer 2023 startete ein erster Durchlauf mit etwa 50 Mitarbeitern aus dem Bereich Corporate Quality – mit durchschlagendem Erfolg und einer Beteiligungsquote von nahezu 100 Prozent.

„Ich war damals wirklich überwältigt, wie toll das angenommen wurde!“, berichtet Schwerdtle. „Das hat sich für niemanden anstrengend angefühlt.”

Besonders positiv überraschte ihn die breite Wirkung des Quiz. Sowohl erfahrene QM-Experten als auch Mitarbeiter ohne QM-Hintergrund fanden Gefallen daran. „Es hat mich wirklich fasziniert, wie einfach es gehen kann, in zwei Wochen Grundlagenwissen an eine breite Mannschaft von 50 Personen zu bringen und gleichzeitig im Teamwettbewerb gegeneinander zu spielen und Spaß zu haben“, resümiert Schwerdtle.

Standortübergreifendes Community-Building

Die guten Erfahrungen führten zu einer zweiten, größeren Quiz-Runde, bei der von November bis Mitte Dezember 2024 rund 250 Mitarbeiter aus unterschiedlichen Standorten und QM-Bereichen teilnahmen. In dieser bereichsübergreifenden Struktur sieht Schwerdtle weitere Vorteile: „Das eine ist, dass man sich eine gemeinsame Wissensbasis erarbeitet. Jeder schärft sein Grundwissen nach, egal ob er in einem Produktionswerk ist, in einer Vertriebsgesellschaft oder im Headquarter bei der Produktentwicklung.” Teilnehmer Abdullah Sag, Leiter Qualitätsmanagement am Produktionsstandort Scharnhausen, bekräftigt: „Die wertvollsten Momente sind die fachlichen Diskussionen im Anschluss. Während manche Fragen für Qualitätsexperten Routine sind, entwickeln sich bei anderen intensive Gespräche, die zu einem echten Erkenntnisgewinn führen.” Die einheitliche Wissensbasis verbindet erfahrene Mitarbeiter und Neueinsteiger über alle Unternehmensbereiche hinweg.

Einen zusätzlichen Vorteil erkennt Schwerdtle in der abteilungs- und länderübergreifenden Vernetzung von QM-Teams, die im Arbeitsalltag wenig Berührungspunkte haben. Teilnehmer Florian Schuchart, der im Qualitätsmanagement kundenspezifischer Lösungen tätig ist, kann dies bestätigen: „Durch das Quiz kommen wir mit Kollegen ins Gespräch über Fachinhalte – und zwar auch mit denen, die wir sonst nur selten treffen.” Teilnehmer Oliver Walte, Leiter Qualitätsmanagement des Produktionsstandorts Pieterlen in der Schweiz, stimmt zu: „Wir hätten auch ein Quiz nur innerhalb einer Abteilung oder im Headquarter machen können. Aber diese globale Dimension fand ich sehr schön. Es motiviert unheimlich, wenn man gegen andere Abteilungen spielt. Der Teamgedanke über Ländergrenzen hinweg hat das Ganze noch verstärkt.”

Das große Finale als Höhepunkt

Siegerehrung nach dem Finale: (v.l.n.r.) Matthias Merkle (Projektleiter), Florian Schuchart (Sieger des Quality Quiz Duells) und Philipp Schreiner (Quality Quiz Duell Kernteam). ©Festo SE & Co. KG

Den spannenden Schlusspunkt des Quality Quiz Duells setzte ein Live-Finale. Der Teamgedanke stand auch dabei wieder im Vordergrund: „Wir haben uns bewusst dazu entschieden, im Team zu spielen“, betont Mathias Merkle, der Projektleiter des Quality Quiz-Duells. „Daher haben wir einen Spielmodus entwickelt, bei dem am Ende das beste Team eines jeden Standorts ins Live-Finale kommt.“ Die insgesamt rund 130 Teilnehmer des Events waren mit vollem Einsatz bei der Sache – egal ob beim Public Viewing im Headquarter oder live zugeschaltet aus den Standorten. Den Gesamtsieg sicherte sich am Ende Team Saarland. Ausgezeichnet wurden auch die drei erfolgreichsten Einzelspieler.

Erfolgsfaktoren für die Umsetzung

Als Schlüssel zum Erfolg sehen Schwerdtle und Merkle eine sorgfältige Vorbereitung. Zentral ist dabei die Benennung eines Projektleiters, bei dem alle Informationen zusammenlaufen. „Ein gut funktionierendes Kernteam und erweiterte Teams in den Standorten sind außerdem die Basis für den Erfolg“, ergänzt Merkle.

Man sollte sich genau überlegen, wie das Quiz in der eigenen Organisation optimal genutzt werden kann, rät Schwerdtle. Dabei gilt es, grundlegende Fragen zu klären: Wird im Team oder einzeln gespielt? Wie lang sind die Spielrunden? Auch praktische Aspekte wie Ferienzeiten und die Einbindung des Betriebsrats müssen berücksichtigt werden. „Vor Spielstart sollte man einen Plan machen, bei dem jeder Meilenstein gesetzt ist“, betont Projektleiter Merkle. Gemessen an der Zahl der erreichten Mitarbeiter schätzt Schwerdtle den Gesamtaufwand für Vorbereitung und Durchführung jedoch als überschaubar ein.

Überraschend einfacher Einstieg

„Entscheidend für den Erfolg sind zwei bis drei Personen in den Bereichen, die das Quiz kennen und die verstehen, was Quiz-Battle heißt“, meint er. Diese Mitarbeiter prägen durch ihre Erfahrungen den “Flurfunk” in der Kaffeeküche und wecken Neugier im Team. Diese Beobachtung bestätigt auch Teilnehmerin Lara Schneider, die als Qualitätsingenieurin im Logistikbereich arbeitet, und ergänzt: „Auch Kollegen, die nicht direkt am Quiz-Battle beteiligt waren, haben ständig nachgefragt: „Wie weit seid ihr jetzt? Auf welchem Platz steht ihr?“ Sie wollten sogar die Fragen sehen. Das Interesse im Büro war von allen Seiten wirklich sehr groß.” So entsteht eine Eigendynamik, die das Quiz nach kurzer Anlaufphase ohne aufwendige Anleitungen zum Selbstläufer macht.

Qualitätsstrategie und moderne Didaktik

Das Quiz-Projekt ist bei Festo nicht als isolierte Maßnahme konzipiert, sondern fügt sich in ein modernes, digitales Gesamtkonzept des Qualitätsmanagements ein. Neben dem Quiz setzt das Unternehmen auch andere innovative Formate ein, etwa eine Darstellung des Qualitätsmanagements in Comicform, bei der Avatare der Führungskräfte Sachverhalte erklären.

Schwerdtle ist überzeugt, dass moderne Mitarbeiterqualifizierung von einer durchdachten Herangehensweise lebt: „Über die Qualifizierungsformate sollte man sich sehr genau Gedanken machen, wenn man seine Mannschaft weltweit auf dem Stand halten will. Ich kann den besten Inhalt haben, wenn ich den aber in einem schlechten didaktischen Format vermittele, dann ist die Frage: Was bleibt wirklich hängen?“