Messen auf eigene Gefahr: Normkonformität in der Messtechnik sicherstellen

Normen einzuhalten ist für eine zuverlässige Messtechnik essenziell. Besonders hervorzuheben ist dabei die DIN EN ISO 5459, die spezifische Vorgaben zur Tolerierung und zur Festlegung von Bezugssystemen macht. Seit Oktober 2024 ist die Neufassung der Norm ISO 5459 für Bezüge und Bezugssysteme offiziell in Kraft. Diese neue Fassung, die bisher ausschließlich in englischer Sprache verfügbar ist, bringt grundlegende Neuerungen mit sich, vor allem bei der Bezugsbildung. Diese Änderungen stellen Anwender:innen sowie Hersteller von Messtechnik und Softwarelösungen vor besondere Herausforderungen, die weit über das bloße Verstehen der neuen Festlegungen hinausgehen.

Präzisere Bezugsbildung für moderne Anforderungen

Die Berechnung von Bezugsflächen spielt eine entscheidende Rolle in der normgerechten Tolerierung und Auswertung geometrischer Merkmale. Bislang galt bei der Berechnung ebener Bezugsflächen die Zielfunktion nach Tschebyscheff/Minimax mit der Nebenbedingung des Außenmaterials als Standard. Dies wurde durch das Symbol [CE] dargestellt, das jedoch nicht explizit in Zeichnungen gekennzeichnet werden musste, da es als Default galt (s. auch PDF-Datei “Symbole, Abkürzungen und Benennungen für die Maß-, Form- und Lagetolerierung“)

Mit der aktuellen ISO 5459 wurde dieser Standard geändert. Nun erfolgt die Berechnung ebener, geschlossener Bezugsflächen standardmäßig mithilfe der Zielfunktion nach Gauß (kleinste Abweichungsquadrate) bei gleichzeitiger Berücksichtigung des Außenmaterials. Dieses neue Standardverfahren wird durch das Symbol [GE] kenntlich gemacht.

Eine Ausnahme existiert jedoch für komplanare, unterbrochene Ebenen, wie beispielsweise kombinierte Bezüge (A-A oder A-B). Hier bleibt die ursprüngliche Zielfunktion nach Tschebyscheff/Minimax bestehen. Wichtiger Hinweis zu der Norm: Es darf keine Verwechslung mit dem Assoziationskriterium [G+] geben, da dies zu unterschiedlichen Ergebnissen führt. Die Unterscheidung beruht auf den jeweiligen mathematischen Prinzipien und Definitionen der Symbole.

Eine weitere wesentliche Neuerung der aktualisierten Norm ist die Einführung des morphologischen Hüllfilters [EM]. Dieser Ansatz berücksichtigt funktionale Anforderungen stärker und ermöglicht robustere, präzisere Ergebnisse. Durch seine anwendungsorientierte Analyse unterstützt der morphologische Hüllfilter die Optimierung der räumlichen Ausrichtung von Bauteilen.

Mit diesen und weiteren Änderungen stellt die ISO 5459 sicher, dass die Bezugsbildung den steigenden Ansprüchen in der Messtechnik gerecht wird. Das Verständnis und die korrekte Anwendung dieser Neuerungen sollten daher zum unmittelbaren Bestandteil der Qualitätssicherung werden. Die frühzeitige Auseinandersetzung mit den neuen Anforderungen ist unerlässlich, weil die Änderungen eine bessere Zusammenarbeit zwischen Konstruktion, Messtechnik und Qualitätssicherung ermöglichen.

Softwarekompatibilität als Herausforderung

Die Nutzung moderner Messsoftware ist heute fester Bestandteil der Qualitätssicherung. Die fortschreitende Normung bringt nicht nur fachliche Neuerungen mit sich, sondern stellt auch die Softwarekompatibilität in der Messtechnik vor Herausforderungen. Für Messtechniker stellt sich somit die Frage: „Ist mein Messsystem bereits auf dem neuesten Stand und wird es den aktuellen Normanforderungen tatsächlich gerecht?“

Der erste Entwurf der überarbeiteten ISO 5459 wurde 2017 veröffentlicht und bot damals schon spannende neue Ansätze und Möglichkeiten für die Messtechnik. Der Besuch der Control 2025 zeigte auf, dass die Neuerungen der Norm noch nicht flächendeckend umgesetzt wurden, was der Branche zugleich eine wertvolle Gelegenheit zur Weiterentwicklung bietet. Es wird deutlich, dass die Umstellung auf neue Normen eine gewisse Zeit sowie eine klare Kommunikation erfordert.

Die Angleichung an die ISO 5459 schafft eine solide Basis für die Weiterentwicklung von Qualitätssicherungsprozessen und technologischen Standards. Hersteller und Nutzer:innen von Messtechnik und Softwarelösungen können durch eine frühzeitige Anpassung nicht nur eine präzisere Normenkompatibilität gewährleisten, sondern auch ihre Marktposition langfristig stärken.

Fazit: Qualität durch Kompetenz – Den Wandel aktiv gestalten

Die Neuerungen der ISO 5459 unterstreichen, wie entscheidend die Aktualisierung von Normen für eine präzise und funktionale Messtechnik ist. Sie beeinflusst die gesamte Zusammenarbeit zwischen Konstruktion, Fertigung und Qualitätssicherung. Allerdings zeigt die schleppende Einführung in vielen Bereichen, dass ein klarer Bedarf an Aufklärung besteht. Hersteller von Messsystemen, Anwender:innen und Qualitätssicherer müssen die Neuerungen konsequent in ihre Arbeit integrieren, wenn sie normgerechte Prüfungen und langfristige Qualität sicherstellen wollen. Frühzeitige Sensibilisierung und praxisnahe Schulungen sind der Schlüssel, um Kompatibilitätsprobleme zu vermeiden und die Potenziale der Norm optimal auszuschöpfen.

Letztlich ist dies nicht nur eine Frage der Normerfüllung, sondern auch die der Wettbewerbsfähigkeit und Innovationskraft der gesamten Industrie. Die Zukunft der Messtechnik steckt voller Potenziale und diejenigen, die frühzeitig handeln, profitieren nachhaltig vom Wandel und der technologischen Entwicklung.

Über den Autor:

Colin Jambé, Bachelor Professional ist seit 2019 DGQ-Trainer in den Bereichen Längenmesstechnik, ISO-GPS und Prüfmittelverwaltung tätig. Er arbeitet bei der Kostal Kontakt Systeme GmbH & Co. KG in Lüdenscheid. Seine Schwerpunkte liegen in der modernen 3D Messtechnik, der Zeichnungsprüfung sowie in der Moderation von Schulungen und Workshops. Zudem beschäftigt er sich intensiv mit den Normen und deren Anwendung in der Messtechnik.

Technische Präzision als Teamarbeit: Die Rolle der DIN EN ISO 8015 in technischen Zeichnungen und Toleranzsystemen

Die DIN EN ISO 8015:2011-09 ist seit vielen Jahren eine zentrale und unverzichtbare Norm in der Welt der Technik. Häufig findet sich ihr Verweis im Schriftfeld technischer Zeichnungen. Die Norm dient Konstrukteur:innen, Entwickler:innen, Messtechniker:innen und Qualitätsprüfer:innen als unverzichtbares Werkzeug, um Missverständnisse zu vermeiden, klare Prüfbarkeit sicherzustellen und die Einhaltung hoher Qualitätsstandards zu fördern. Ihre konsequente Anwendung ermöglicht nicht nur präzisere Abläufe, sondern leistet durch Effizienzsteigerung einen wichtigen Beitrag zur globalen Wettbewerbsfähigkeit von Unternehmen.

Doch wie wird sichergestellt, dass diese Norm nicht nur auf dem Papier existiert, sondern in der Praxis sinnvoll und effektiv umgesetzt wird? Dieser Artikel beleuchtet die Bedeutung im produktiven Zusammenspiel zwischen den beteiligten Abteilungen, damit technische Zeichnungen den Stellenwert erhalten, den sie verdienen: ein Kommunikationstool für Präzision und Wirtschaftlichkeit.

Die 13 Grundsätze der DIN EN ISO 8015: Verantwortung und Zusammenarbeit

Ein zentraler Bestandteil der fundamentalen Norm DIN EN ISO 8015 sind die 13 Grundsätze. Dazu zählen unter anderem der Grundsatz des Aufrufens, der Grundsatz Normenhierarchie sowie der Grundsatz der Unabhängigkeit. Der Grundsatz der Verantwortung führt regelmäßig zu Diskussionen. Er fordert unmissverständlich, dass die eindeutige und funktionsgerechte Spezifikation eines Bauteils in der Verantwortung der Konstrukteur:innen liegt. In der Praxis zeigt sich jedoch, dass diese Verantwortung nicht ausschließlich auf der Konstruktionsebene angesiedelt sein sollte.

Dabei spielt der Grundsatz der Dualität, ebenfalls in der DIN EN ISO 8015 verankert, eine entscheidende Rolle. Dieser weist die Verantwortung für die Verifikation der Qualitätsplanung und Qualitätssicherung zu. In der Praxis zeigt sich jedoch, dass eine enge Verzahnung zwischen der Verifikation und Spezifikation notwendig ist. Erst durch dieses Wechselspiel zwischen Qualitätsplanung und Konstruktion wird sichergestellt, dass die Anforderungen an das Produkt vollständig und realistisch spezifiziert werden können.

Die Entwicklung moderner Produkte erfordert ein enge Zusammenarbeit von Konstruktion, Fertigung, Messtechnik, Qualitätssicherung und weiteren Fachbereichen. Nur wenn alle Beteiligten abgestimmt und im Team agieren, lässt sich gewährleisten, dass ein Produkt nicht nur funktional, sondern auch wirtschaftlich und herstellbar bleibt.

Kommunikative Funktion von technischen Zeichnungen: Mehr als Maße und Linien

Technische Zeichnungen sind ein zentrales Kommunikationsmittel zwischen den verschiedenen Ebenen und Abteilungen entlang der gesamten Wertschöpfungskette. Damit sie die Fertigung und Qualitätskontrolle wirkungsvoll unterstützen können, müssen sie lösungs- und praxisorientiert gestaltet werden.

Die Entscheidung, ein Nennmaß auf eine Zeichnung zu bringen, basiert deshalb nicht allein auf funktionalen Anforderungen. Vielmehr fließen juristische, praktikable, fertigungs- und prüftechnische Überlegungen in diese Entscheidung mit ein.

- Ein zentrales Prinzip lautet: Nur ein Nennmaß, das alle relevanten Anforderungen erfüllt, sollte auf die technische Zeichnung gebracht werden. Ein Maß, das nicht funktional relevant ist, sollte weggelassen werden, um unnötige Komplexität zu vermeiden.

- Nennmaße müssen eine Normverbindlichkeit haben. Unklare oder anderweitig normwidrige Zeichnungseintragungen gelten rechtlich als Konstruktionsfehler und können teure Konsequenzen, von zusätzlichen Anpassungen über Qualitätsmängel bis hin zu Produkthaftungsansprüchen, nach sich ziehen.

- Ein Nennmaß auf einer technischen Zeichnung muss praktikabel sein. Das heißt, mit den Fähigkeiten der eingesetzten Werkzeuge, Maschinen und Prüfmethoden übereinstimmen. Maß und Toleranz dürfen weder die Fertigung überfordern noch überspitzt toleriert sein, wenn diese Präzision für Funktion oder Montage nicht erforderlich ist. Dadurch wird sichergestellt, dass die Maßvorgaben technisch machbar und wirtschaftlich sinnvoll sind.

- Ein Nennmaß ist erforderlich, wenn es einen direkten Einfluss auf die Fertigung des Bauteils hat. Das Maß muss an den Fertigungsprozess angepasst sein und sollte realistisch und herstellbar sein. Hierbei ist es essenziell, dass die Vorgaben von der Konstruktion in enger Zusammenarbeit mit der Fertigungsplanung definiert wurden. Ein schlecht spezifiziertes oder unrealistisches Maß ohne Erklärung führt dagegen zu Problemen und muss auf der Zeichnung vermieden werden. Mögliche Probleme umfassen unter anderem erhöhte Kosten durch Verzögerungen, Ausschuss sowie Fertigungsprobleme in der Produktion.

- Nennmaße müssen prüfbar sein. Das heißt, sie müssen während oder nach der Fertigung, mit geeigneten Messmitteln überprüft werden können. Nicht oder nur schwer prüfbare Maße führen zu Problemen in der Qualitätssicherung und der Fertigung. Daher sollte ein Nennmaß niemals auf einer Zeichnung bleiben, wenn es nicht messtechnisch überprüfbar ist und keine zusätzlichen Maßnahmen zur Lösung des Problems (zum Beispiel alternative Messmethoden, Funktionstests, Toleranzanpassung) durchgeführt werden können. Sollten solche Maße erforderlich sein, müssen alternative Lösungen wie angepasste Prüfmethoden oder Funktionstests definiert werden.

Teamarbeit als Schlüssel zum Erfolg: Die Rolle der Entwickler:innen

In der Praxis können Entwickler:innen selten alle Fragen zur Fertigung, Prüfbarkeit und Umsetzung eines Bauteils allein beantworten. Das moderne Produktentwicklungsumfeld ist daher von einer interdisziplinären Zusammenarbeit mit dem Ziel geprägt, aus unterschiedlichen Perspektiven gemeinsam die optimalen Lösungen zu erarbeiten.

Die Verantwortung von Entwickler:innen besteht somit darin, die gestellten technischen Anforderungen klar und eindeutig zu formulieren. Gleichzeitig ist es wichtig, dass sie frühzeitig den Dialog mit den Fachkolleg:innen aus Werkzeugbau, Fertigung, Messtechnik und Qualitätssicherung suchen. Nur auf diese Weise können Vorgaben herstell- und prüfbar spezifiziert werden. Ein funktionierender Informationsaustausch ist in diesem Zusammenhang kein „Nice-to-have“, sondern ein Muss.

Fazit: Gemeinsam die Norm als Chance begreifen

Die DIN EN ISO 8015 fordert Unternehmen dazu auf, technische Zeichnungen als verbindliche Kommunikationsmittel zu betrachten und diese sorgfältig sowie zielführend zu gestalten. Entwickler:innen müssen nicht alle Antworten kennen, sondern die richtigen Fragen stellen und lösungsorientiert vorgehen. In einer globalisierten Produktionswelt gelingt dies jedoch nur, wenn alle Beteiligten, von der Entwicklung über die Konstruktion bis hin zu Messtechnik und dem Qualitätsmanagement, gut zusammenarbeiten. Nur so lassen sich die Herausforderungen meistern und hohe Standards für Qualität, Effizienz sowie Präzision etablieren.

Über den Autor:

Colin Jambé, Bachelor Professional ist seit 2019 DGQ-Trainer in den Bereichen Längenmesstechnik, ISO-GPS und Prüfmittelverwaltung tätig. Er arbeitet bei der Kostal Kontakt Systeme GmbH & Co. KG in Lüdenscheid. Seine Schwerpunkte liegen in der modernen 3D Messtechnik, der Zeichnungsprüfung sowie in der Moderation von Schulungen und Workshops. Zudem beschäftigt er sich intensiv mit den Normen und deren Anwendung in der Messtechnik.

Lenkung dokumentierter Informationen – ein Weg in die digitale Welt

Jede Leistung eines Unternehmens muss sich an Anforderungen, die an die verschiedenen Merkmale der Leistung gestellt werden, messen lassen. Aber wo kommen die Anforderungen her, wer hat sie festgelegt, geprüft und ihre Umsetzbarkeit bewertet?

Die Anforderungen beziehen sich nicht nur auf ein Produkt, sondern auch auf Prozesse, Verfahren, Qualifikationen, Qualität, Arbeitssicherheit, Umwelt, Energie und so weiter. Zu den Anforderungen gesellen sich nun noch die geforderten Nachweise, die belegen, dass die Anforderungen auch erfüllt wurden.

All diese dokumentierten Informationen müssen erstellt, geprüft, freigegeben, verteilt sowie gegebenenfalls wieder eingezogen und am Ende auch noch vernichtet werden. Da kommt schnell ein Berg von Papier zusammen, der gepflegt und verwaltet werden will.

Anforderungen müssen verständlich und nachvollziehbar sein

Um diese Flut an dokumentierter Information zu kanalisieren und einheitlich in Form und Struktur zu gestalten, ist es unabdingbar, ein Dokumenten-Managementsystem aufzubauen und zu unterhalten. Dies kann unter Zuhilfenahme der IT in mehr oder weniger geschickt aufgebauten Verzeichnisstrukturen unter Verwendung von Standard-Softwareprogrammen erfolgen.

Hier werden meist über zentrale Funktionen, unter Beteiligung von Fachabteilungen, Dokumente erzeugt, geprüft, frei- und herausgegeben, was einen erheblichen personellen Aufwand mit großem Fehlerrisiko bedeutet.

Jedes Dokument erhält eine eindeutige Zuordnung und, sofern es sich um ein Dokument mit Vorgabecharakter handelt, auch einen Revisionsstand und ein Ausgabedatum. Diese Stammdaten werden darüber hinaus noch in Dokumentenlisten geführt, die im Idealfall mit regelmäßigen Revisionsintervallen versehen sind.

Das kann schnell zu einem Vollzeitjob werden.

| Berufsbild Qualitätsmanager Qualität ist von entscheidender Bedeutung für den Erfolg jedes Unternehmens und ein wichtiger Faktor für Kunden. Um Qualität zu erzeugen, braucht es ein gutes Konzept und ein reibungsloses Zusammenspiel aller Beteiligten. Eine Schlüsselrolle dabei haben Qualitätsmanager. Sie helfen der Unternehmensleitung, den Führungskräften, Prozesseignern und Mitarbeitenden, das Unternehmen qualitätsfähig zu machen. Als „Systemarchitekten“ unterstützen Sie dabei, ein Qualitätsmanagementsystem aufzubauen und weiterzuentwickeln. Finden Sie eine Karriere im Qualitätsmanagement spannend? Antworten auf die wichtigsten Fragen finden Sie in unserem Berufsbild zum Qualitätsmanager:

|

Interaktive Dokumentenlenkungssysteme

Dieses Thema lässt sich mit einem Beispiel aus der Praxis beleuchten, wie es sich sicherlich in vielen Betrieben so oder so ähnlich antreffen lässt.

Die Ausgangssituation:

In einem mittelständigen, kunststoffverarbeitenden Betrieb, wurden alle, das Qualitätsmanagement auf verschiedenen Ebenen betreffende Vorgabedokumente in Form von Word- und Exceldateien sowie deren PDF-Derivaten erstellt und gepflegt. All diese Dokumente unterlagen einer manuellen Pflege durch eine zentrale Stelle und wurden zusätzlich in Excel-Tabellen geführt, um eine Übersicht der aktuellen Ausgabestände zu gewährleisten.

Die Vorgehensweise zur Erstellung, Änderung, Prüfung und Freigabe der Dokumente sowie die Zugriffsberechtigungen mit Schreib- und Leserechten wurde in einer Arbeitsanweisung festgelegt.

Zu Schulungszwecken und im Rahmen von Audits wurden die Dokumente herangezogen, blieben aber ansonsten weitgehend unbeachtet, da die Abläufe den Beteiligten „ja bekannt“ waren. Mangels regelmäßiger Überprüfungen blieben viele Dokumente über lange Zeiträume unverändert und somit bezüglich ihrer Aktualität zumindest fragwürdig.

Die Lösung:

Seit Jahren werden IT-gestützte Systeme zur Dokumentenlenkung angeboten, als Einzellösung, als Teil eines CAQ Systems (Computer Aided Quality) oder im Rahmen einer BPM Lösung (Business Process Management).

Im Zusammenhang mit solchen Systemen werden Routinen der Dokumentenlenkung automatisiert und im besten Fall über Workflows online abgewickelt. Dokumentierte Informationen werden automatisch referenziert, mit Versionsstand und Ausgabedatum sowie Prüf- und Freigabevermerken versehen, und an den im System festgelegten Verteilerkreis herausgegeben. Altversionen werden automatisch zurückgezogen und archiviert.

Die Dokumentation von Prozessen orientiert sich zudem in den meisten Fällen an den Forderungen der ISO 9001, Kapitel 4.4. Dadurch werden die normseitigen Anforderungen bezüglich der Prozess-Rahmenbedingungen systematisch erfüllt.

Sollte in einem solchen System auch noch die Möglichkeit bestehen, die Prozesse des Unternehmens auf verschiedenen Ebenen als Haupt-, Unter- und Teilprozesse in Form von Flussdiagrammen oder Swimlanes abzubilden, können die dokumentierten Informationen mit Vorgabecharakter den einzelnen Aktions- und Entscheidungsboxen per Verlinkung zugeordnet werden. Hier kann sich in vielen Fällen jede und jeder Einzelne online und interaktiv durch das Managementsystem bewegen und verfügt grundsätzlich immer über die aktuellen Versionen der dokumentierten Informationen.

Ein weiterer wichtiger Aspekt bei einem solchen System ist die aktive Einbeziehung aller Mitarbeitenden. Durch Ausfüllen eines Kommentarfeldes, können diese Anmerkungen, Ergänzungen und Änderungen an dokumentierten Informationen anregen. Der Kommentar wird dann an den Dokumenteneigner zur Bewertung und Entscheidung weitergeleitet.

Die Umsetzung:

In dem oben beschriebenen, konkreten Fall hat sich die oberste Leitung entschieden, das Dokumentenlenkungssystem „Q.wiki“ der Modell Aachen GmbH einzusetzen. Zunächst um die bestehenden Dokumente in eine übersichtliche Struktur zu bringen. Nun bestehen für alle Vorgabedokumente, neben einer sinnvollen Dokumentenstruktur, die Zuständigkeiten und Verantwortlichkeiten für die Erstellung, Prüfung und Freigabe sowie ein definierter Zugriff durch die jeweiligen Zielgruppen. Bei der Gelegenheit wurden die Dokumente inhaltlich hinterfragt sowie gegebenenfalls überarbeitet und aktualisiert. Durch regelmäßige, automatisierte Revisionsintervalle von 12 bis 24 Monaten wird sichergestellt, dass die Dokumente aktuell gehalten und weiterentwickelt werden. Die Termine im Rahmen der Erstellung, Prüfung, Freigabe und Revision der Dokumente werden systemseitig überwacht und bei Bedarf eskaliert.

Mit diesem Einstieg in die Welt der interaktiven Managementsysteme eröffnen sich weitere Möglichkeiten einer übersichtlichen Prozessdarstellung, einer Bündelung des Wissens der Organisation sowie eine vereinfachte Kommunikation mit Workflowunterstützung.

Fazit

IT-gestützte, automatisierte Dokumentenlenkungssysteme zum Führen der dokumentierten Informationen eines Unternehmens kosten nicht unerheblich viel Geld und Aufwand im Rahmen der Einführung.

Wenn man aber die hier angeführten Punkte und die damit verbundenen Kosten auf das eigene Unternehmen und die Informationsflut sowie die wachsenden Nachweispflichten im Tagesgeschäft reflektiert und dem personellen Aufwand sowie den durch eine manuelle Dokumentenlenkung entstehenden potenziellen Fehlerkosten gegenüberstellt, könnte das Kosten-Nutzen-Verhältnis durchaus positiv ausfallen.

Es empfiehlt sich, die Fehlleistungen im Unternehmen mal intensiv zu analysieren und die Ursachenermittlung, beispielsweise mittels 5-Why-Methode, in der Tiefe zu betreiben. Auch dabei könnte herauskommen, dass Information und Kommunikation eine signifikante Rolle spielen.

Über den Autor:

Dipl.-Ing. Bernd Flormann verfügt über eine nahezu 40-jährige Erfahrung im Qualitätsmanagement in verschiedenen Funktionen und unterschiedlichen Branchen wie der Metall- und Kunststoffverarbeitung, der Elektroindustrie, der Haus- und Schreibgeräteindustrie sowie im Bereich von Kinder- Sicherheitsprodukten. Er ist seit 1992 im Wesentlichen freiberuflich tätig mit Schwerpunkten als Lead Auditor QM/UM der DQS und als Trainer der DGQ in den Bereichen QS/QM, sowie als Berater.

KI sicher einsetzen: So bleibt Ihre Qualitätssicherung auf Kurs

Künstliche Intelligenz (KI) hat die Industrie im Sturm erobert. Auch wenn der größte Hype um ChatGPT sich langsam legt, bleibt die Erkenntnis, dass KI viele Bereiche der Wirtschaft nachhaltig verändern wird. Auch die Qualitätssicherung zählt hierzu. Für Entscheider und Mitarbeiter hat der schwierige Teil nun begonnen: Die wertschöpfende Integration von KI in die täglichen Abläufe des Unternehmens. Dieser Artikel soll zeigen, wie Mitarbeiter und Entscheider der Qualitätssicherung ihr Unternehmen auf KI vorbereiten können.

Wenn es um Digitalisierung und Automatisierung geht, hat die Qualitätssicherung in vielen Unternehmen lange eine Vorreiterrolle gespielt. Die Erfassung von Leistungskennzahlen und deren statistische Auswertung ist seit jeher eine Kernkompetenz der Qualitätssicherung. KI-gestützte Prüftechnik kommt in produzierenden Betrieben seit vielen Jahren zum Einsatz (zum Beispiel bei Kameraprüfungen). Bedeutet dies also „business as usual“ für die Qualitätssicherung?

Hier liegt ein Trugschluss vor: Viele Unternehmen rühmen sich mit Schlagworten wie „big data“, „analytics“ und KI, sind aber tatsächlich kaum auf die Veränderungen vorbereitet, die KI mit sich bringt. Der Bereich Qualitätssicherung bildet hier keine Ausnahme. An allen Ecken und Enden entsteht Verschwendung durch ineffiziente Datenerfassung, händische Datenübertragungen von Tabellen in PowerPoint-Präsentationen und wieder zurück. Das Problem dabei ist: Diese Verschwendung bindet wertvolle Arbeitskraft, aber sie verschwindet oft in intransparenten Overheadkosten und bleibt unsichtbar. Bis jetzt.

KI wird diese Ineffizienzen schonungslos offenlegen. Analysen, die früher Tage gedauert haben sind mittels KI in Sekundenschnelle möglich. KI erlaubt es komplexe Herstellungsprozesse deutlich schneller zu optimieren, als dies mit klassischen Methoden möglich wäre. Ausfälle an Teilen und Maschinen können mittels analytischer Modelle vorhergesagt und verhindert werden, bevor schlechte Teile ausgeliefert werden oder ein Maschinenschaden entsteht. Unternehmen, die diese Vorteile nutzen können, verschaffen sich einen erheblichen Vorsprung vor der Konkurrenz.

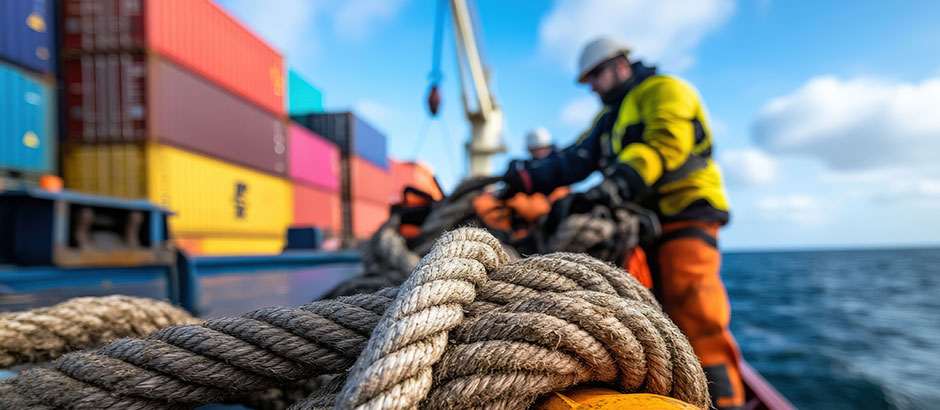

Abb. 1: Mit ChatGPT generiertes Bild, ©Stefan Prorok, Prophet Analytics

Was können Entscheider in der Qualitätssicherung tun, um Einsparpotentiale durch KI für ihr Unternehmen zu erschließen? Das Bild von KI als Sturm bildet eine nützliche Analogie. KI bringt Veränderung, Gefahren und Möglichkeiten und wie gute Seeleute müssen Entscheider und Mitarbeiter ihr Unternehmen sturmsicher machen. Nur so können sie verhindern vom Hype fortgeblasen zu werden oder Schiffbruch zu erleiden. Die wichtigsten Aktivitäten sind hier stichpunktartig zusammengefasst.

Maschinen und Treibstoffvorrat prüfen

Dass Daten die Grundlage für KI darstellen, hat sich inzwischen herumgesprochen, aber noch immer wissen viele Unternehmen nicht was damit gemeint ist. Eine eingescannte Fehlersammelkarte ist zwar streng genommen ein digitaler Datensatz, aber für KI gänzlich unbrauchbar. Entscheider in der Qualitätssicherung müssen darauf achten, dass Daten maschinenlesbar erfasst werden. Excel-Tabellen sind besser als Text oder Bilder. Noch besser sind aber Formate mit einer fest vorgegebenen Struktur, wie JSON, xml oder Datenbanktabellen. Vermeiden Sie Freitext, wo immer es geht. Nutzen Sie stattdessen fest vorgegebene Auswahlmöglichkeiten. Mit diesen einfachen Mitteln schaffen Sie eine gute Grundlage für die KI-Nutzung.

Die Maschine, die diese Daten verarbeitet sind Visualisierungs- und KI-Werkzeuge. Glücklicherweise müssen Mitarbeiter heute nicht mehr programmieren, um KI nutzen zu können. Die meisten Unternehmen starten ihre KI-initiativen mit Datenanalysen („Data Analytics“). Es gibt eine ganze Reihe von grafischen Data Analytics Werkzeugen, die frei verfügbar sind und sich problemlos in Unternehmen nutzen lassen (PowerBI und Knime sind zwei weit verbreitete Beispiele). Auch ChatGPT lässt sich für grafische Datenanalysen einsetzen. Grafische Werkzeuge erleichtern der Mannschaft den produktiven Umgang mit den eigenen Daten und stellen den ersten Schritt für einen effektiven KI-Einsatz im Unternehmen dar.

Die Mannschaft trainieren

Artikel 4 der KI-Verordnung schreibt vor, dass Mitarbeiter, die mit der Entwicklung und dem Betrieb von KI-Systemen betraut sind, über ein angemessenes Maß an KI-Kompetenz verfügen müssen. Das Gesetz sieht zwar keine direkten Sanktionen vor, wenn Unternehmen dieser Pflicht nicht nachkommen. Die Qualifikation der Mitarbeiter liegt jedoch im eigenen Interesse. Chatbots, wie zum Beispiel Copilot oder ChatGPT können Fehler machen und eine grundlegende Kenntnis, wann mit Fehlern zu rechnen ist und wie sie sich vermeiden lassen ist für einen effektiven Einsatz unerlässlich. Grundlagen der Datenanalyse und des maschinellen Lernens stellen ebenfalls einen wichtigen Qualifikationsbaustein dar und verbessern den wertschöpfenden Umgang mit Daten.

Das Schiff sturmsicher machen

Es gibt einige wichtige gesetzliche Anforderungen, auf die Entscheider beim Einsatz von KI achten müssen. Hierzu zählen zuvorderst das Urheberrecht, die Datenschutzgrundverordnung und die KI-Verordnung. Entscheider sollten leicht verständliche Arbeitsinstruktionen und Leitfäden erstellen, welche Daten mit KI verarbeitet werden dürfen. Durch eine verbindliche Vorgabe kann der rechtskonforme Einsatz von KI im Unternehmen gesichert werden.

Eine besondere Hürde stellt dabei die Einhaltung der Datenschutzgrundverordnung dar. Da viele KI-Modelle (wie sie auch von ChatGPT oder Copilot genutzt werden) in den USA gehostet werden, sind personenbezogene Daten dort in der Regel nicht geschützt. Es drohen somit Rechtsverstöße. Zusätzlich muss vorab geklärt werden, ob eine rechtssichere Verarbeitungsgrundlage vorliegt. Die erste Anlaufstelle für diese Fragen ist der Datenschutzbeauftragte des Unternehmens. Es gibt rechtssichere Möglichkeiten für die Verarbeitung personenbezogener Daten durch KI, aber es erfordert eine sorgfältige Vorbereitung.

Neben den oben genannten Gesetzen gibt es noch eine Vielzahl von anderen gesetzlichen Anforderungen und sektoralen Vorschriften, die beim Einsatz von KI relevant werden können (zum Beispiel Kritis für kritische Infrastruktur oder Dora für das Finanzwesen). Insbesondere in hoch regulierten Bereichen lohnt sich daher das Anlegen eines Rechtskatasters.

Den Wetterbericht verfolgen

KI als Technologie bringt sowohl Chancen als auch Risiken mit sich. Dies gilt besonders in der Qualitätssicherung. In diesem Bereich liegen viele Daten in hoher Qualität vor, die nutzbar gemacht werden können. Für Entscheider müssen neue Technologien nicht bis ins letzte Detail verstehen, aber sie müssen wissen, woher der Wind weht. Welche Technologien lassen sich heute schon wertschöpfend einsetzen und bei welchen Technologien ist Vorsicht geboten?

KI-Methoden des maschinellen Lernens sind beispielsweise sehr ausgereift und heute in vielen Softwarelösungen integriert. Ein Beispiel die Statistiksoftware Minitab. Minitab ist populär bei SixSigma-Anwendern und es unterstützt inzwischen auch KI und maschinelles Lernen. KI und maschinelles Lernen werden in der Qualitätssicherung schon lange als zusätzliche Werkzeuge im Methodenkoffer eingesetzt und haben sich in der Praxis bewährt.

Neuere Methoden, wie der Einsatz großer Sprachmodelle (zum Beispiel ChatGPT und Copilot) haben diese Bewährungsprobe noch vor sich. Es gibt viele interessante Anwendungsmöglichkeiten von ChatGPT in der Qualitätssicherung. Besonders bei der Verarbeitung von unstrukturierten Daten haben Chatbots ein großes Potential, aber die Anwendungsfälle müssen differenziert betrachtet werden.

Eine zweite wichtige Information für Entscheider ist die Innovationsgeschwindigkeit. Wie beim Quecksilber im Barometer müssen Entscheider wissen, in welchen Bereichen eine hohe Innovationsgeschwindigkeit vorhanden ist. Wenn die Innovationsgeschwindigkeit hoch ist, ist es schwierig langfristig zu planen, weil die angestrebte Lösung in sechs Monaten schon wieder obsolet sein kann. Ein Beispiel hierfür sind KI-Agenten, die Zugriff auf externe Dienste haben (zum Beispiel Websuche, E-Mail oder Dateisuche). Die großen KI-Unternehmen wie Microsoft, Amazon oder Google arbeiten daran ihre KI-Modelle mit solchen externen Diensten zu verbinden, aber es hat sich noch kein Standard durchgesetzt. In solchen Fällen ist es sinnvoll, Projekte mit kurzer Amortisationszeit durchzuführen und sich nicht zu früh auf einen Anbieter festzulegen.

Bei anderen Anwendungsfällen, wie zum Beispiel vorausschauender Instandhaltung („predictive maintenance“) ist die Innovationsgeschwindigkeit deutlich niedriger. Hier können auch KI-Lösungen mit einer Amortisationszeit von 18 Monaten oder mehr sinnvoll sein.

Fazit

Zusammenfassend kann gesagt werden: Der Schlüssel, um KI in der Qualitätssicherung effektiv zu nutzen liegt in den vier Grunddisziplinen, die auch gute Seeleute beherzigen, wenn sich der Sturm ankündigt:

- Gute Vorbereitung (der Daten) und Bereitstellung geeigneter Werkzeuge

- Gute Ausbildung der Mannschaft

- Aufmerksamer Umgang mit Risiken

- Den Finger am Puls der Zeit haben

Durch die Einhaltung dieser Grunddisziplinen schützen Sie sich und ihr Unternehmen vor überzogenen Erwartungen an KI. Gleichzeitig können Sie KI nutzen, um langfristig Wertschöpfung zu erzielen, ohne dem Hype zu erliegen. Die DGQ hat ein Portfolio von mehreren Trainings erstellt, um Fach- und Führungskräfte bei der Umsetzung dieser vier Disziplinen zu unterstützen.

Über den Autor:

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Künstliche Intelligenz. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten. Kontakt: ki@prophet-analytics.de

Einsatz der Messmittelfähigkeit zur Absicherung von künstlicher Intelligenz

Künstliche Intelligenz hat sich in rasender Geschwindigkeit in vielen Bereichen der Wirtschaft durchgesetzt. Insbesondere große Sprachmodelle werden dabei in immer mehr Anwendungen integriert. Die Frage, die sich dabei stellt, ist: Wie können diese Systeme sinnvoll abgesichert werden? In diesem Fachbeitrag soll gezeigt werden, dass etablierte Fähigkeitsanalysen, wie MSA oder VDA Band 5 auf ein breites Spektrum von KI-Systemen anwendbar sind.

Ein Blick in die KI-Verordnung aus dem Jahr 2024 zeigt, dass für KI-Systeme im Hochrisikobereich (zum Beispiel bei Sicherheitsbauteilen oder in der Bildung) ein Nachweis über die Genauigkeit vorgeschrieben ist (siehe Art. 15 (2) KI-Verordnung). Dabei wird explizit die Zusammenarbeit mit „Metrologischen Behörden“ seitens der EU-Kommission herausgestellt. Momentan ist noch unklar, wie genau diese Zusammenarbeit aussehen wird. Es kann davon ausgegangen werden, dass sich Behörden, wie die Deutsche Akkreditierungsstelle für eine einheitliche Begriffsdefinition mit bestehenden Normenwerken stark machen werden. Von zentraler Bedeutung ist dabei eine einheitliche Definition von Messunsicherheit und die Eignung eines KI-Systems für eine gegebene Anwendung.

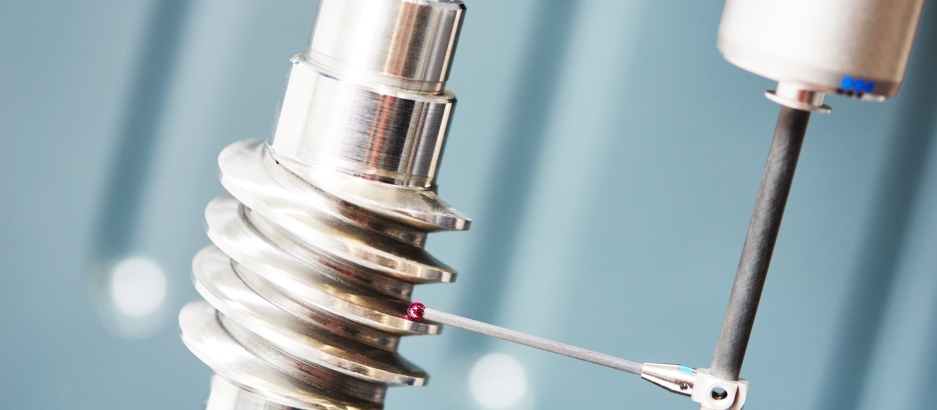

Momentan liegt ein großer Teil der medialen Aufmerksamkeit auf Transformermodellen. Dies führt dazu, dass Transformermodelle wie gpt-4, die die Basis für Anwendungen wie ChatGPT bilden, häufig mit KI gleichgesetzt werden. Tatsächlich haben viele Mitarbeiter der Qualitätssicherung aber bereits jahrelange Erfahrung mit KI-Systemen in ihrer Produktion. Ein gutes Beispiel hierfür sind automatische Kamerasysteme zur Bildklassifikation.

In vielen Firmen werden automatische Kamerasysteme als Prüfmittel eingesetzt. Kamerasysteme können sowohl messende Prüfungen vornehmen als auch attributiv eingesetzt werden. Für beide Fälle existieren gut beschriebene und etablierte Verfahren wie MSA oder der VDA Band 5 mit seinen entsprechenden Erweiterungen um die Fähigkeit solcher Systeme nachzuweisen (s. Measurement systems analysis, 4th edition 06.2010 und VDA Band 5, 3. Auflage, Juli 2021). Das bedeutet, dass für solche KI-Systeme bereits eine direkte Anwendbarkeit der Begriffe „Eignungsnachweis“ und „Messunsicherheit“ gegeben ist.

Etwas weniger offensichtlich ist die Situation bei großen Sprachmodellen, wie gpt-4. Hierbei können unterschiedliche Fälle beantwortet werden. Im ersten Fall wird das Sprachmodell eingesetzt, um einen Text durch einen Zahlenwert zu bewerten. Ein einfaches Beispiel ist die automatische Bewertung von Kundenfeedback, bei dem ein Freitext einer Sternebewertung zugeordnet wird. Um das Beispiel zu verdeutlichen wurde folgender Prompt 50 mal mit unterschiedlichen Modellgenerationen von OpenAI, der Herstellerfirma von ChatGPT, getestet:

„Ich möchte, dass du Trainingsfeedbacks auf einer Skala von 1 bis 10 bewertest. Wie würdest du folgendes Feedback bewerten: “Schönes Training, sympathischer Trainer, das Essen war für mich sehr salzig.” Bitte antworte nur mit einer Zahl.“

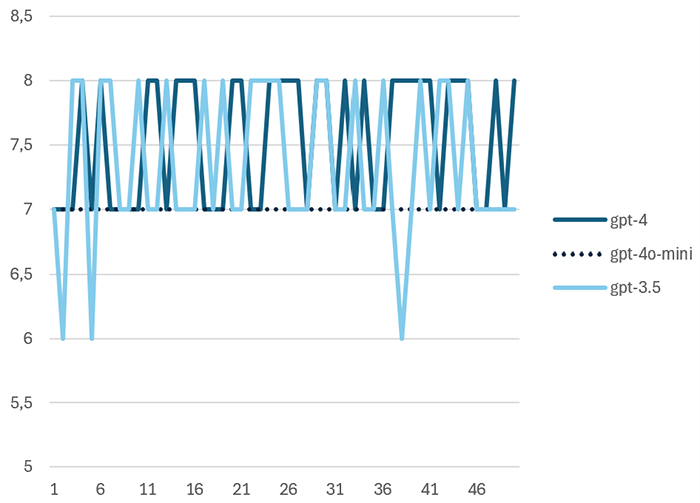

Abbildung 1 zeigt den Werteverlauf der Ergebnisse für drei unterschiedliche Modellgenerationen. Es fällt auf, dass das neuere Modell gpt-4o-mini im Vergleich zu den Vorgängermodellen gpt-3.5 und gpt-4 nicht mehr streut zur Übersetzung des folgenden Feedbacks in eine Punktebewertung.

Die Werteverläufe wurden mittels einer Messystemanalyse nach MSA und nach VDA Band 5 ausgewertet. Die Cg und Cgk-Werte wurden gemäß der VDA-Empfehlung ermittelt. Tabelle 1 zeigt die Übersicht der Ergebnisse. gpt-4o-mini hätte in diesem Fall die Fähigkeit nach VDA erreicht, scheitert allerdings an der aufgabenbedingten Auflösungsgrenze von 5 Prozent der Toleranz.

| gpt | x ̅ | s | Cg | Cgk | Qms |

|---|---|---|---|---|---|

| gpt-3.5 | 7,34 | 0,59 | 0,84 | 0,80 | 26,3% |

| gpt-4 | 7,54 | 0,50 | 0,99 | 0,74 | 23,1% |

| gpt-4o-mini | 7,00 | 0,00 | – | – | 11,5% |

Tab. 1: Ergebnisse der Fähigkeitsuntersuchungen für unterschiedliche Modellgenerationen

Ein Bereich, in dem die Bewertung von Text durch KI-Systeme eine hohe Relevanz hat, ist die Bildung. Ein gutes Beispiel hierfür ist die Firma Fobizz, die Software zur Unterstützung von Lehrkräften anbietet. Die Software von Fobizz wurde von den Bundesländern Mecklenburg-Vorpommern und Berlin lizensiert und steht dort allen Lehrkräften zur Verfügung. Pilotversuche in Bayern, Hessen und Baden-Würtemberg laufen. Ein Feature dieser Software ist die automatische Bewertung von Klassenarbeiten.

Rainer Mühlhoff und Marte Henningsen konnten in ihrem Vortrag auf dem Chaos Communications Congress 2024 zeigen, dass die Software bei mehrfacher Eingabe identischer Klausuren zu unterschiedlichen Bewertungsergebnissen kommt. Dies ist nicht überraschend, da es sich laut Auskunft der Firma um ein Webfrontend für ein großes Sprachmodell handelt. Eine Eigenschaft von Sprachmodellen ist, dass die Ausgabe üblicherweise innerhalb gewisser Grenzen zufällig variiert wird. Dies führt zu einer zufälligen Streuung in den Bewertungsergebnissen, die sich auch in Abbildung 1 gezeigt hat. Die Wissenschaftler konnten zeigen, dass die Benotung von einem Durchlauf zum nächsten um mehrere Notenschritte abweichen kann.

Ein interessanter Aspekt, der jedoch nicht untersucht wurde, ist die Frage, ob echte Lehrkräfte bei so einem Versuch besser abschneiden würden als das KI-System. Eine Auswertung nach Methode 2 mit zwei echten Lehrkräften und einem KI-System würde dies deutlich zeigen. So wäre es möglich zu entscheiden, ob das KI-System weniger streut als menschliche Lehrkräfte und ob es statistisch signifikante Abweichungen in Form von Bias zwischen dem KI-System und den Lehrern gibt. Tatsächlich fordert die KI-Verordnung genau solche Biasbewertungen als Teil der Absicherung für Hochrisiko-KI-Systeme.

Fobizz ist vorerst nicht zur Umsetzung statistischer Tests verpflichtet, weil die KI-Verordnung im Falle von Hochrisiko KI-Systemen nicht rückwirkend gilt. Voraussetzung ist dabei, dass das betroffene KI-System vor dem 02.08.2026 in Verkehr gebracht wurden und danach nicht wesentlich verändert wurden.

Die beiden obigen Beispiele zeigen, dass Prüfmittelfähigkeitsuntersuchungen für alle KI-Systeme anwendbar sind, die zur Kategorisierung oder Messung eingesetzt werden. Dies gilt selbst, wenn eine messende Bewertung eines Texts vorgenommen wird. Etwas anspruchsvoller ist der Fall der Bewertung eines reinen Chatbots. Da bei einem Chatbot sowohl Ein- als auch Ausgabe unstrukturierter Text ist, sind die statistischen Methoden der Qualitätssicherung hier nicht direkt einsetzbar. Dies ist Gegenstand aktueller Forschung. Das einfachste Vorgehen ist es Menschen einzusetzen, die bewerten, ob der Chatbot richtig reagiert hat und so den attributiven Eignungsnachweis zu führen. Als Mustereingaben können Chatverläufe genutzt werden, die in der Vergangenheit zu Auffälligkeiten geführt haben. Das Vorgehen ist dabei ähnlich wie bei Grenzmustern mit bekanntem Gut-/Schlechtentscheid in der Kameraprüfung.

Da bei diesem Vorgehen die Unsicherheit der menschlichen Einschätzung und die zufällig streuende Antwortqualität der Maschine mathematisch nicht unterscheidbar sind, kann der Eignungsnachweis hier deutlich schwieriger sein. In jedem Fall sollten statistische Methoden eingesetzt werden, um ausreichend hohe Stichprobenumfänge mit einer aussagekräftigen Anzahl an Wiederholungen festzulegen.

Zusammenfassung

Es wurde gezeigt, dass Methoden, wie die Prüfmittelfähigkeit sich in vielen Fällen direkt auf die Eignung von KI-Systemen anwenden lassen. Dies gilt auch für viele andere statistische Verfahren der Qualitätssicherung, wie zum Beispiel F- und t-Tests oder Kreuztabellenbetrachtungen. Durch den Einsatz anerkannter Bewertungsverfahren steigt das Vertrauen in das KI-System und die Genauigkeit der Systeme kann in transparenter Weise ausgewiesen werden.

Die Bedeutung von Eignungsnachweisen für KI-Systeme wird durch die Anforderungen der KI-Verordnung deutlich steigen. Es muss jedoch betont werden, dass viele Normen, die die praktische Umsetzung der KI-Verordnung beschreiben, aktuell noch in Erstellung sind. Bereits jetzt steht allerdings fest, dass die Qualitätssicherung einen wertvollen Beitrag dazu leisten kann, präzise KI-Systeme zu entwickeln und zu betreiben. Mitarbeiter der Qualitätssicherung können auf diese Weise ihre einzigartigen Fähigkeiten nutzen und neue Werte für ihr Unternehmen schaffen.

Lesen Sie mehr zum Thema “Künstliche Intelligenz in der Qualität” in den folgenden Fachbeiträgen:

- Teil 1: Künstliche Intelligenz in der Qualität – Bestehendes Know-how effektiv nutzen – zum Beitrag »

- Teil 2: Künstliche Intelligenz in der Qualität – Welche Qualifikationen werden benötigt? – zum Beitrag »

- Teil 3: Künstliche Intelligenz in der Qualität – Praktische Einführung durch iteratives Vorgehen – zum Beitrag »

Über den Autor:

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Künstliche Intelligenz. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten. Kontakt: ki@prophet-analytics.de

8D-Report – Ein Werkzeug, das sich verändern muss

8D-Report – Ein Werkzeug, das sich verändern muss

– Warum der A3 Report innerbetrieblich das bessere Instrument ist

Viele kennen die Situation: fast täglich kommt ein neuer 8D-Report ins Unternehmen, mit dem man nichts anzufangen weiß oder für den man nicht zuständig ist. Doch die häufig negative Einstellung, die mittlerweile gegenüber dem 8D-Report vorherrscht, sollte kritisch hinterfragt werden. Gerade in der jetzigen Zeit muss die Qualität als Führungsthema im Vordergrund der Unternehmen stehen. Walter Masing, der den Qualitätsbegriff entscheidend geprägt hat, hat die These aufgestellt, dass die meisten personenbedingten Fehler ihre Ursachen im System haben, für das im weitesten Sinne die Führung verantwortlich ist. (mehr …)

Warum rückgeführte Messergebnisse für Ihr Unternehmen notwendig sind

Rund um die Uhr wird gemessen. Im täglichen Leben beschäftigen wir uns eher unbewusst mit der Fragestellung, ob der Messwert überhaupt ein richtiger, gültiger Messwert ist. Vielleicht beim Kauf von hochpreisigen Lebensmitteln, bei einer gemessenen Geschwindigkeitsüberschreitung oder einer Reklamation, bewerten wir das Messergebnis auf seine Richtigkeit. In einer so schnelllebigen Zeit wie heute sind wir in einem besonderen Maß auf gültige Messergebnisse angewiesen. Aber wie kommen diese zustande, bzw. wann kann von einem gültigen Messergebnis die Rede sein?

Geeignete Mess- und Prüfmittel – das Herz jeder Produktion

Wer komplexe Produktionsprozesse oder Konformitätsbestätigungen sicher beherrschen möchte, muss auch die „Kunst des Messens“ beherrschen. Dazu gehört vor allem die Feststellung der Eignung von Mess- und Prüfmitteln. Tatsächlich geht es jedoch nicht um die Eignung von Mess- und Prüfmitteln, sondern um den Nachweis das die zur Anwendung kommenden Mess- und Prüfmittel inkl. der dazugehörigen Methoden für die jeweiligen Überwachungs- und Messtätigkeiten geeignet sind. Nur dadurch wird gewährleistet, dass die Risiken in Verbindung mit ungeeigneten Überwachungs- und Messtätigkeiten nahezu auf null reduziert werden. Zu den wesentlichen Risiken zählen:

- ungültige Konformitätsbestätigung (Auslieferung unsicherer Produkte)

- nicht wirksame Regelkreise in der Produktion (hoher Ausschuss)

- etwaiger Fehlerdurchschlupf zum Kunden (Reklamation, Kosten)

- nicht Einhaltung von gesetzlichen Forderungen (z.B. CE)

- Rückrufaktionen (erhebliche Kosten und Imageverlust)

- erhebliche Haftungsrisiken (z.B. Umweltrecht)

In allen gängigen branchenübergreifenden (z.B. ISO 9001, ISO 14001, ISO 45001, etc.) und -spezifischen (ISO 9100, HACCP, QSF, ISO 17025, DIN 27201-9, ISO 13485, IATF 16949, etc.) Standards ist das Thema „… gültige und zuverlässige Überwachungs- und Messergebnisse“ in Verbindung mit festgelegten Anforderungen“ als „muss“ Forderung enthalten. Dazu kommen dann noch die Anforderungen an die Eignung von Überwachungs- und Messtätigkeiten aus diversen Rechtsvorschriften.

Die Kernforderung von ISO 9001 ist nicht das Kleben von Plaketten an Mess- oder Prüfmitteln

Was ist die Kernforderung von ISO 9001 in Bezug auf Produktkonformität? Erinnern wir uns an die Einleitung zu ISO 9001 „Die potenziellen Vorteile für eine Organisation, die sich aus der Umsetzung eines Qualitätsmanagementsystems basierend auf dieser Internationalen Norm ergeben, sind folgende: a) die Fähigkeit, beständig Produkte und Dienstleistungen zu liefern, die die Kundenanforderungen und zutreffende gesetzliche und behördliche Anforderungen erfüllen;…“. Das heißt im Klartext, dass die definierte Produkt-/Dienstleistungsqualität abgesichert hergestellt wird.

Dazu fordert die Norm, dass die entsprechenden Ressourcen festgelegt und bereitgestellt werden müssen, um die Konformität von Produkten und Dienstleistungen durch Mess- oder Überwachungsergebnisse nachweisen zu können. Konformität wiederum bedeutet die Erfüllung von Anforderungen. Eine weitere wesentliche Anforderung von ISO 9001 ist, dass die Eignung der bereitgestellten Ressourcen für die jeweilige Mess- oder Überwachungstätigkeit gegeben ist. Der Nachweis dieser Eignung ist dann auch entsprechend zu dokumentieren. Da ISO 9001 eine sogenannte wirkzielorientierte Norm ist, sind keine Methoden zur Eignungsfeststellung festgelegt worden. Die Definition der Methoden zur Eignungsfeststellung obliegt somit dem Anwender der Norm.

Was verbirgt sich hinter der Eignungsfeststellung?

Grundlage für die Eignungsfeststellung (also den geeigneten Einsatz für den beabsichtigten Gebrauch) bilden die Spezifikationen der Merkmale des Produktes. Eine Eignung ist dann gegeben, wenn ein Mess- oder Prüfmittel die definierten Anforderungen an seine beabsichtigte Verwendung erfüllt. Die definierte Anforderung ist das erwartete Mess- oder Überwachungsergebnis, um die Konformität mit den Vorgaben bestätigen zu können. In der Regel sind diese Anforderungen in entsprechenden Prüfspezifikationen festgelegt.

Es gibt viele Möglichkeiten zur Eignungsfeststellung. Entweder über statistisch abgesicherte Verfahren oder einfach nur durch die Anwendung des technischen Verstandes in Verbindung mit umfassenden Kenntnissen der Messtechnik und der Messfehler und Fehlerursachen. Die sicherlich bekanntesten Verfahren zum Eignungsnachweis sind die Measurement System Analysis (MSA, AIAG) oder der VDA Band 5 (Prüfprozesseignung, Eignung von Messsystemen, Mess- und Prüfprozessen – bei geometrischen Merkmalen). Diese Verfahren sind jedoch nicht zwingend erforderlich, um die Eignung feststellen zu können. Eine Eignung ist auch dann gegeben, wenn der Abstand zwischen der Fehlergrenze des Mess- oder Prüfmittels wesentlich kleiner ist, als die Toleranzgrenze für die Konformitätsentscheidung. Wichtig ist, dass ein zuverlässiges und reproduzierbares Messergebnis erzeugt werden kann.

Absicherung der Eignung als Erfolgsfaktor

Nachdem einmal die Eignung eines Verfahrens zur Ermittlung gültiger und zuverlässiger Überwachungs- und Messergebnisse nachgewiesen wurde, besteht die zweite Kernaufgabe darin, die Eignung kontinuierlich sicherzustellen. Dazu zählt dann u.a. die regelmäßige Verifizierung der Überwachungs- und Messverfahren mit Hilfe geeigneter Standards oder die Kalibrierung der eingesetzten Mess- oder Prüfmittel. Nur durch diese Maßnahmen sind metrologisch rückführbare Überwachungs- und Messergebnisse zur Konformitätsbewertung darstellbar.

DIN EN ISO 9001:2015 „Qualitätsmanagementsysteme – Anforderungen“

DIN 32937:2018 „Mess- und Prüfmittelüberwachung – Planen, Verwalten und Einsetzen von Mess- und Prüfmitteln“

DIN EN ISO 10012:2004 „Messmanagementsysteme – Anforderungen an Messprozesse und Messmittel“

VDI/VDE 2600:2013 Bl. 1, „Prüfprozessmanagement – Identifizierung, Klassifizierung und Eignungsnachweise von Prüfprozessen“

IATF 16949:2016 „Qualitätsmanagement – System – Standard der Automobilindustrie“

DIN EN ISO 9001:2015 „Qualitätsmanagementsysteme – Anforderungen“

DIN EN ISO/IEC 17025:2018 Allgemeine Anforderungen an die Kompetenz von Prüf- und Kalibrierlaboratorien“

ISO/IEC-Leitfaden 99:2007 „Internationales Wörterbuch der Metrologie“

Testo Fibel – Prüfmittelmanagement und Kalibrierung / Die Forderungen der Richtlinien und deren praktische Umsetzung“

Jörg Roggensack ist von Haus aus Elektroniker und Calibration Engineer GAF sowie zertifizierter Auditor für div. Managementsysteme. Er hat umfassende Erfahrung als Managementsystemkoordinator und als Auditor für diverse Regelwerke und Managementsysteme (IMS, QM, UM, AS, GMP, GLP) sowie als LEP Assessor die er in über 27 Jahren bei der Bundeswehr, in der Industrie und bei Zertifizierungsgesellschaften sammeln konnte. Über mehrere Jahre bildete er u.a. Kalibriertechniker an der Technischen Schule der Luftwaffe in Kaufbeuren aus und begann seine industrielle Kariere als Kalibrierlaborleiter bei BEYSCHLAG. In diversen Veröffentlichungen, als Herausgeber des Weka Werkes der „Mess- und Prüfmittelbeauftragte“ und als Auditor, Trainer sowie Umsetzungsberater bei JR Management Services & Qualifizierung gibt er immer wieder Hilfestellungen zur Gestaltung wirtschaftlicher und normkonformer Mess- und Prüfmittelüberwachungssysteme.

Qualität entsteht aus der Vernetzung – neue Ansätze für die Qualitätssicherung in der Supply Chain

Die vermeintlich fragilen und linearen Lieferketten sind in Wirklichkeit robuste, verzweigte Netze. Diese Sicht auf die Liefernetze hilft, ihre moderne Rolle in der digitalen Disruption neu zu verstehen. Qualität entsteht in diesen Liefernetzen nicht als Summe der Qualitätsbeiträge der einzelnen Lieferanten, sondern aus einer aktiven Vernetzung der beteiligten Menschen heraus. Neue Organisationsformen und vernetzungsroutinierte Mitarbeiter fördern eine lieferantenübergreifende Qualitätssicherung. (mehr …)