EU KI-Gesetz: Neue Regelungen für sichere und gesetzeskonforme KI-Produkte

Von Predictive Maintenance und Kameraprüfungen bis hin zu intelligenten Konsumgütern – KI spielt eine entscheidende Rolle in der modernen Industrie. Das kürzlich verabschiedete EU KI-Gesetz bringt neue Anforderungen und Regulierungen, die erhebliche Auswirkungen auf die Entwicklung und den Einsatz von KI in Europa haben werden. Dieser Artikel erläutert grundsätzliche Begriffe der EU KI-Gesetzgebung und erklärt, worauf Unternehmen bei der Einführung neuer KI-Lösungen achten müssen.

Das KI-Gesetz definiert ein KI-System als „ein maschinengestütztes System, das für einen in unterschiedlichem Grade autonomen Betrieb ausgelegt ist und das nach seiner Betriebsaufnahme anpassungsfähig sein kann und das aus den erhaltenen Eingaben für explizite oder implizite Ziele ableitet, wie Ausgaben wie etwa Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen erstellt werden, die physische oder virtuelle Umgebungen beeinflussen können.“

Diese Definition von KI-Systemen ist deutlich breiter als der allgemeine Sprachgebrauch. Wenn heute von KI-Systemen die Rede ist, dann meist im Zusammenhang mit Chatbots wie ChatGPT oder Gemini. Tatsächlich sind in der Definition des KI-Gesetzes auch Systeme eingeschlossen, die heute bereits zum Alltag gehören, wie Empfehlungsalgorithmen bei YouTube oder Amazon. Auch Übersetzungsprogramme können in diese Kategorie fallen.

Das EU KI-Gesetz wurde entwickelt, um die sichere und ethische Nutzung von KI in Europa zu gewährleisten. Er schafft ein einheitliches Regelwerk, das Transparenz, Verantwortlichkeit und Sicherheit fördern soll. Ein gutes Beispiel für den Einsatz von KI-Systemen in der Industrie sind Predictive Maintenance-Anwendungen , zum Beispiel bei der Wartung von Windturbinen. Hierbei werden Maschinen und Anlagen kontinuierlich überwacht, um potenzielle Ausfälle frühzeitig zu erkennen und präventive Wartungsmaßnahmen durchzuführen. Diese prädiktiven Systeme nutzen große Mengen an Sensordaten und fortschrittliche Algorithmen, um Muster zu erkennen und Vorhersagen zu treffen.

Ein weiteres Beispiel sind automatische Kameraprüfungen. Klassische Kameraprüfungen arbeiten mit Helligkeits- oder Kantenerkennungen. Inzwischen setzen immer mehr Hersteller auf KI-Methoden, um Kameraprüfungen anhand von Beispielbildern zu trainieren. Auf diesem Weg lassen sich auch aufwändige Prüfungen realisieren, die ansonsten nur mit Hilfe von Werkern umsetzbar wären.

Das EU KI-Gesetz folgt einem risikobasierten Ansatz. Insbesondere wenn Sicherheitsaspekte oder die Interessen von natürlichen Personen berührt sind, müssen Anbieter von solchen KI-Systemen eine Vielzahl von Anforderungen einhalten. Solche Systeme fallen in der Regel in den Hochrisikobereich. In unserem letzten Artikel der Serie haben wir die grundsätzlichen Anforderungen an Hochrisiko-Systeme aufgelistet.

Prinzipien des KI-Gesetz zur Absicherung von KI-Systemen

Das KI-Gesetz folgt bei der Absicherung von KI-Systemen folgenden Prinzipien:

Transparenz:

KI-Systeme müssen so gestaltet sein, dass ihre Entscheidungen nachvollziehbar sind. Nutzer sollten erkennen, dass sie mit einem KI-System interagieren. Entscheidungen eines KI-Systems müssen im Zweifelsfall nachvollziehbar sein.

Sicherheit:

KI-Produkte müssen robuste Sicherheitsmaßnahmen enthalten, um Missbrauch und unerwünschte Auswirkungen zu verhindern.

Fairness und Datenschutz:

Der Schutz personenbezogener Daten muss gewährleistet sein. Entscheidungen und Empfehlungen müssen frei von ungerechtfertigter Diskriminierung sein. Diese Anforderungen sind bereits bei der Entwicklung des Systems zu berücksichtigen.

Überwachung und Verantwortlichkeit:

Es müssen Mechanismen zur kontinuierlichen Überwachung und Bewertung der KI-Systeme etabliert werden. Zudem ist klar festzulegen, wer die Verantwortung für das Funktionieren und die Entscheidungen der KI trägt.

Diese Prinzipen decken sich in großen Teilen mit denen vorangegangener Veröffentlichungen, wie dem KI-Prüfkatalog des Fraunhofer IAIS Instituts.

Herausforderungen bei der Absicherung von KI-Systemen

Eine Herausforderung bei der Absicherung von KI-Systemen besteht in der Tatsache, dass diese Systeme in der Regel lernfähig sind.

Traditionell produzierte Produkte durchlaufen in der Regel einen linearen Entwicklungsprozess: Design, Prototyping, Produktion, Qualitätskontrolle und schließlich Markteinführung. Diese traditionellen Produkte sind in ihrer Funktion festgelegt und ändern sich nicht wesentlich nach dem Verkauf. Auf lernfähige KI-Systeme trifft dies nicht zu. Sie können sich in ihrer Funktion durch das Erlernen neuer Informationen nach der Markteinführung noch verändern. Aus diesem Grund umfasst der Entwicklungsprozess von KI-Produkten nicht nur das ursprüngliche Design und die Produktion, sondern auch die Implementierung von Datenmanagementstrategien, die Entwicklung und das Training von Modellen sowie fortlaufende Überwachung und Updates nach der Markteinführung.

Für die praktische Umsetzung der gesetzlichen Vorgaben hat die EU der europäischen Normenorganisation Cen/Cenelec einen Normungsauftrag erteilt. In der Arbeitsgruppe JTC21 – Artificial Intelligence sind inzwischen 21 Normen und Richtlinen in Erstellung, die die unterschiedlichen Aspekte der EU KI-Gesetzgebung betreffen. Diese Normen regeln zum Beispiel das Qualitätsmodell für künstliche Intelligenz und beschreiben Methoden zur Vermeidung von ungewollten statistischen Verzerrungen (Bias) in Trainingsdatensätzen.

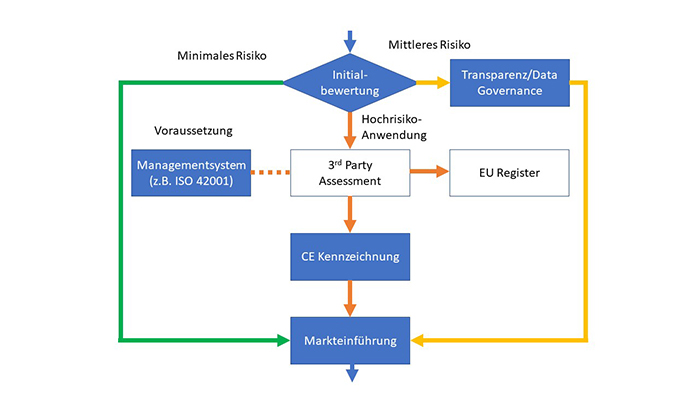

Unternehmen, die aktuell bereits KI in ihren Produkten einsetzen, sollten sich darauf einstellen, dass eine Vielzahl von Anforderungen in kurzer Zeit umgesetzt werden müssen. Ein Beispiel hierfür sind die Data Governance Anforderungen (CLC/TR 18115), die nach jetziger Planung am 29. August 2024 verabschiedet werden. Die zugehörigen gesetzlichen Anforderungen werden bereits im Mai 2025 verpflichtend für alle Systeme der mittleren und hohen Risikokategorie (siehe Abb. 1). Diese beiden Kategorien umfassen eine Vielzahl von Systemen von Chatbots über Empfehlungssysteme bis hin zu sicherheitskritischen Systemen (zum Beispiel in Medizin, Verkehr und Bildung).

Schritte zur Einführung von KI-Systemen gemäß EU-KI-Gesetzgebung

Das KI-Gesetz legt einen Großteil der Verantwortung für Absicherung zur Markteinführung und sicheren Betrieb in die Hände der Betreiber der KI-Systeme. Abbildung 1 zeigt die wichtigen Schritte zu Einführung von KI-Systemen gemäß EU KI-Gesetzgebung. Unternehmen, die KI einsetzen, müssen die eingesetzten KI-Systeme erfassen und die Risikokategorie selbstständig bestimmen. Unser KI-Selfassessment kann Sie bei dieser Aufgabe unterstützen. Eine nähere Beschreibung der Risikokategorien befindet sich im vorangegangenen Beitrag dieser Serie.

KI-Systeme, die in der EU zulässig sind, fallen in die Kategorien geringes Risiko (keine zusätzlichen gesetzlichen Anforderungen aus dem KI-Gesetz), mittleres Risiko (Transparenz- und Data-Governanceanforderungen) und Hochrisiko-Systeme.

Abb. 1: Einführung von KI-Systemen nach EU KI-Gesetz

Systeme mit mittlerem und geringem Risiko werden von den Unternehmen in Eigenregie überwacht. Für Hochrisiko-Systeme existieren weitere Anforderungen aus dem KI-Gesetz. Diese Anforderungen treten ab Mai 2026 in Kraft und werden nach Abschluss einer 12-monatigen Übergangsfrist im Mai 2027 verpflichtend. Bevor diese Hochrisiko-KI-Systeme in der EU in Verkehr gebracht werden dürfen, muss ein unabhängiges 3rd Party-Assessment durchgeführt werden. Voraussetzung für ein erfolgreiches 3rd Party-Assessment sind ein bestehendes Managementsystem und ein dazugehöriges Risikomanagement. In diesem Zusammenhang wird auch die ISO 42001:2023 als Systemnorm für künstliche Intelligenz an Bedeutung gewinnen. Sie ist zwar nicht explizit im Gesetzestext benannt, bietet aber eine gute Basis für die Entwicklung moderner KI-Systeme.

Nach bestandenem 3rd Party-Assessment muss die Hochrisiko-Anwendung in einer zentralen EU-Datenbank registriert werden. Auf dieser Basis kann das Unternehmen im Anschluss eine CE-Kennzeichnung erstellen und das Produkt in den Umlauf bringen.

Ausblick

Zusammenfassend kann gesagt werden, dass das EU KI-Gesetz einen bedeutenden Schritt zur Regulierung und Sicherstellung sicherer und ethischer KI-Systeme darstellt. Für Unternehmen bedeutet dies, dass sie ihre KI-Prozesse und -Produkte genau prüfen und an die neuen Anforderungen anpassen müssen. Der erste Schritt besteht in einer Bewertung der Risikokategorie aller bestehenden KI-Anwendungen, die bereits im Unternehmen oder in Produkten im Einsatz sind. Die Definition von KI-Systemen aus dem KI-Gesetz legt fest welche Systeme hierbei betrachtet werden müssen. Im zweiten Schritt muss die Einhaltung der relevanten Anforderungen sichergestellt werden. Hierbei sind insbesondere die Meilensteine für die Einhaltung der Transparenz- und Data Governance-Anforderungen ab Mai 2025 und das Ende der Übergangsfrist für Hochrisiko-Systeme im Mai 2027 zu beachten.

Lesen Sie mehr zum Thema “Künstliche Intelligenz in der Qualität” in den folgenden Fachbeiträgen:

- Teil 1: Künstliche Intelligenz in der Qualität – Bestehendes Know-how effektiv nutzen – zum Beitrag »

- Teil 2: Künstliche Intelligenz in der Qualität – Welche Qualifikationen werden benötigt? – zum Beitrag »

- Teil 3: Künstliche Intelligenz in der Qualität – Praktische Einführung durch iteratives Vorgehen – zum Beitrag »

Über die Autoren:

Dipl.-Ing. Waldemar Fahrenbruch ist Head of Q-Technology Division E-Mobility bei der ZF Friedrichshafen AG. Er ist verantwortlich für die Qualitätskostensenkung bei gleichzeitiger Optimierung von Qualitätskonzepten in den Werken der Division E (TCU, Power Electronics und E-Motoren Fertigung) durch Methodenkompetenz der Qualität, künstlicher Intelligenz und digitaler Transformation.

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Künstliche Intelligenz. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten. Kontakt: ki@prophet-analytics.de

Neue Anforderungen für KI in Unternehmen: Die EU-KI-Gesetzgebung und ihre Auswirkungen auf das Qualitätswesen

Künstliche Intelligenz (KI) durchdringt immer mehr Bereiche des täglichen Lebens und der Arbeit. Lange Zeit war künstliche Intelligenz nur für Entwicklungs- und Technologiebereiche interessant. In den letzten Monaten lässt sich beobachten, dass KI immer mehr auch zum Qualitätsthema wird. Überall dort, wo KI eingesetzt wird, um Kundenbedürfnisse zu erfüllen, wird sie auch Gegenstand des Qualitätsmanagements. Viele Unternehmen nutzen KI bereits in ihren Produkten, in ihren Herstellungsprozessen oder im Kundensupport. Auf diese Unternehmen kommen nun neue Anforderungen zu. Dieser Artikel ist Teil einer Serie. Der erste Teil möchte die Leser mit grundsätzlichen Qualitätsanforderungen an KI-Systeme in der aktuellen Rechtslage vertraut machen. Der Beitrag zeigt die großen Parallelen zwischen dem EU-KI-Gesetz und QM-Methoden. Folgende Artikel werden sich mit unterschiedlichen Aspekten wie KI-Absicherung und KI-Zertifizierung auseinandersetzen.

Die EU hat im Dezember 2023 das EU-KI-Gesetz verabschiedet, welches seit April 2024 in überarbeiteter Form vorliegt. Dieses Gesetz definiert Anforderungen für den Betrieb von KI-Systemen in der Europäischen Union und schafft einen einheitlichen gesetzlichen Rahmen für Hersteller und Betreiber. Die EU-KI-Gesetzgebung bewertet KI-Systeme nach einem risikobasierten Ansatz, der starke Ähnlichkeit mit bestehenden Management-Systemen wie ISO 9001 oder ISO 14001 aufweist.

KI-Anwendungen mit unzulässigen Risiken

Abbildung 1 zeigt die vier Risikokategorien für KI-Systeme gemäß EU-KI-Gesetz. Die Einstufung in eine Risikokategorie ergibt sich im Wesentlichen aus den möglichen Auswirkungen auf interessierte Parteien wie Nutzer, die Gesellschaft als Ganzes oder die Umwelt. Das KI-Gesetz verwendet den Ausdruck interessierte Partei dabei nicht. Die oberste Kategorie bezeichnet KI-Anwendungen mit unzulässigen Risiken. Beispiele hierfür sind Social-scoring-Systeme, die dazu gedacht sind, das Verhalten von Menschen zu beeinflussen. Der Betrieb solcher Systeme ist in der EU nach Ablauf einer sechsmonatigen Übergangsfrist untersagt.

Abb. 1: Risikokategorien des EU-KI-Gesetzes mit Beispielen

KI-Systeme mit hohem Risiko

Die zweithöchste Kategorie sind KI-Systeme mit hohem Risiko. Allgemein fallen in diese Kategorie Systeme, die funktionale Sicherheitsanforderungen haben (zum Beispiel in der medizinischen Diagnostik oder dem Straßenverkehr) oder die persönlichen und wirtschaftlichen Interessen von natürlichen Personen betreffen (zum Beispiel im Finanzwesen oder der Bildung). Annex III des EU-KI-Gesetzes enthält eine Auflistung von Hochrisiko-Bereichen. In der aktuellen Fassung des wurde ein neues Kapitel zu KI-Modellen mit allgemeinem Verwendungszweck aufgenommen. Für Hersteller dieser Modelle, zu denen auch große Sprachmodelle zählen, gelten besondere Anforderungen (zum Beispiel gpt4, das Modell hinter ChatGPT). Je nach Komplexität des Modells können die Anforderungen im Hochrisiko-Bereich oder sogar darüber liegen, wenn ein systemisches Risiko festgestellt wurde.

Hochrisiko-KI-Systeme müssen eine CE-Kennzeichnung aufweisen und durch eine unabhängige dritte Stelle zertifiziert werden. Alle Hochrisiko-KI-Systeme müssen in einer zentralen EU-Datenbank registriert werden. Wenn erwiesen ist, dass ein KI-System aus einem Annex III gelisteten Bereich keinen Einfluss auf Sicherheit oder Interessen natürlicher Personen hat, dann kann das System auch als System mit mittlerem oder niedrigem Risiko behandelt werden. Die Pflicht zur externen Zertifizierung entfällt in diesem Fall, aber das System muss trotzdem an die zentrale EU-Datenbank gemeldet werden. Die Erfassung in der EU-Datenbank und die Zertifizierung gelten für einzelne KI-Produkte, nicht für eine Organisation als Ganzes. Die Zertifizierung muss für alle größeren Eingriffe wiederholt werden.

Für Hochrisiko-KI-Systeme stellt das EU-KI-Gesetz eine Vielzahl von Anforderungen. Eine genauere Betrachtung der Anforderungen wird in einem separaten Artikel besprochen. An dieser Stelle sollen nur die wichtigsten Anforderungen genannt werden:

- Einhaltung von Datenschutzvorschriften und Informationssicherheit

- Vorhandensein eines Qualitätsmanagementsystems

- Risikomanagement für vorhersehbare Fehler

- Verpflichtung zu Test und Validierung des KI-Systems

- Einhaltung der branchenspezifischen Vorschriften für funktionale Sicherheit

Die oben aufgeführten Stichpunkte zeigen den starken Überlapp zwischen der neuen EU-KI-Gesetzgebung und Methoden des klassischen Qualitätsmanagements. Aus diesem Grund gehen wir davon aus, dass das Qualitätsmanagement in Zukunft eine zentrale Rolle bei der Einführung und Überwachung von KI-Systemen einnehmen wird.

KI-Systeme mit mittlerem Risiko

Neben Hochrisiko-KI-Systemen gibt es noch Systeme mit mittlerem Risiko. In diese Kategorie fallen Systeme wie Chatbots für den Kundensupport. Diese Systeme haben nur unwesentliche persönliche und keine sicherheitsrelevanten Auswirkungen für Nutzer. Für diese Systeme gelten lediglich Transparenzanforderungen. Dies bedeutet, dass für Nutzer ersichtlich sein muss, wenn er mit einem KI-System interagiert. Der Nutzer muss ferner in Verständlicher Art und Weise über die Verarbeitung seiner Daten aufgeklärt werden. KI-generierte Inhalte sollten in maschinenlesbarer Art und Weise als solche gekennzeichnet sein (zum Beispiel durch Fingerprinting). Die EU arbeitet aktuell an einem Code of Conduct, der näher erklären soll, wie diese Anforderungen umzusetzen sind. Aktuell gibt es jedoch noch kein Veröffentlichungsdatum.

Es ist wichtig zu betonen, dass die Verantwortung für die Einhaltung von Transparenzregeln und Absicherung der korrekten Funktion hauptsächlich der Organisation zufällt, die das KI-System in Umlauf bringt. Dabei handelt es sich oft nicht um den Hersteller des KI-Modells. Insbesondere bei der Verwendung großer Sprachmodelle ist diese Unterscheidung wichtig. Chatbots sind in der Regel kundenspezifisch angepasst. Hersteller großer Sprachmodelle wie openAI agieren in diesem Fall als Lieferanten für Firmen, aber übernehmen in der Regel keine Haftung für firmenspezifische Anpassungen. Dieser Artikel beschreibt einige der Risiken, die dabei entstehen. Die Verantwortung für die Validierung der korrekten Funktion und die Einhaltung von Vorschriften obliegt der Firma, die das System für den Nutzer bereitstellt. Firmen werden somit selbst Prozesse zur Validierung ihrer KI -Lösungen implementieren müssen, wenn sie KI in ihren Produkten oder Prozessen nutzen möchten.

KI-Systeme mit vernachlässigbarem Risiko

Alle KI-Systeme, die nicht in die obersten drei Risikokategorien fallen, werden als Systeme mit vernachlässigbarem Risiko eingestuft. Für Anwendungen mit vernachlässigbarem Risiko stellt das KI-Gesetz neuen Anforderungen. Bestehende Anforderungen, zum Beispiel aus der Datenschutzgrundverordnung bleiben aber weiterhin bestehen. Wir stellen dazu ein kostenloses Self-Assessment bereit, mit dem die Risikoklasse einer KI-Anwendung bestimmt werden kann.

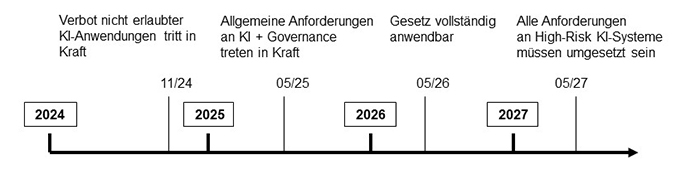

Abbildung 2 zeigt Umsetzungszeiten für die EU-KI-Gesetzgebung, wie sie zum 1. Mai 2024 bekannt waren. Das Verbot von Anwendungen mit unzulässigem Risiko wird bereits im November 2024 in Kraft treten. Die ersten Anforderungen, für Anwendungen mit mittlerem und hohem Risiko werden nach heutigem Kenntnisstand ab Mai 2025 in Kraft treten. Zu diesem Zeitpunkt greifen Verpflichtungen im Bezug auf Transparenz und Data Governance. Data Governance bedeutet, dass Trainings- und Testdatensätze alle für die Anwendung relevanten Kategorien oder Personengruppen abdecken müssen und dies auch nachvollziehbar zu dokumentieren ist.

Abb. 2: Zeitschiene der Implementierung der EU-KI-Gesetzgebung

Die Verpflichtung zur Zertifizierung von Hochrisikosystemen wird voraussichtlich ab Mai 2026 in Kraft treten, gefolgt von einem Übergangszeitraum von 12 Monaten. Spätestens im Mai 2027 müssen dann alle Anforderungen des KI-Gesetzes vollständig umgesetzt sein.

Auf Firmen, die bereits jetzt KI in ihren Produkten oder Prozessen nutzen, kommen daher in den nächsten Monaten folgende Aufgaben zu:

- Bewertung, in welche Risikokategorie die eingesetzten KI-Systeme fallen

- Zusammenstellung aller bindenden Verpflichtungen und Normenanforderungen

- Gesetze (mindestens Datenschutzgrundverordnung und KI-Gesetz)

- Managementsysteme (zum Beispiel ISO 9001:2015)

- Branchenstandards für funktionale Sicherheit (zum Beispiel ISO 26262 für Automotive)

- Erstellung der notwendigen Dokumentation (zum Beispiel für Risikomanagement)

- Test und Validierung der eingesetzten KI-Systeme

KI ist bereits heute in vielen Branchen eine zentrale Komponente der Wertschöpfungskette. Es ist davon auszugehen, dass KI-Assistenzsysteme mit mittlerem Risiko in den nächsten 24 Monaten branchenunabhängig in nahezu alle Bürotätigkeiten Einzug halten wird. Dabei werden KI-Systeme immer mehr Aufgaben übernehmen, die heute von Menschen erledigt werden. Das Qualitätsmanagement spielt eine entscheidende Rolle bei der Absicherung und gesetzeskonformen Umsetzung dieser Systeme. Es ist daher absehbar, dass in den nächsten Monaten ein erheblicher Trainingsbedarf im Bereich Qualitätsmanagement bestehen wird, um die Fachbereiche mit den neuen Anforderungen vertraut zu machen. Qualitätsverantwortliche sollten sich zeitnah mit den IT- und Rechtsbereichen ihrer Organisationen abstimmen um die Aufgabenverteilung, sowie die benötigten Ressourcen und die erforderlichen Qualifikationen zu bestimmen.

Lesen Sie mehr zum Thema “Künstliche Intelligenz in der Qualität” in den folgenden Fachbeiträgen:

- Teil 1: Künstliche Intelligenz in der Qualität – Bestehendes Know-how effektiv nutzen – zum Beitrag »

- Teil 2: Künstliche Intelligenz in der Qualität – Welche Qualifikationen werden benötigt? – zum Beitrag »

- Teil 3: Künstliche Intelligenz in der Qualität – Praktische Einführung durch iteratives Vorgehen – zum Beitrag »

Über die Autoren:

Dipl.-Ing. Waldemar Fahrenbruch ist Head of Q-Technology Division E-Mobility bei der ZF Friedrichshafen AG. Er ist verantwortlich für die Qualitätskostensenkung bei gleichzeitiger Optimierung von Qualitätskonzepten in den Werken der Division E (TCU, Power Electronics und E-Motoren Fertigung) durch Methodenkompetenz der Qualität, künstlicher Intelligenz und digitaler Transformation.

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Künstliche Intelligenz. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten. Kontakt: ki@prophet-analytics.de

Kontinuierliche Eignung von Prüfprozessen nach VDA Band 5 – Hintergrund und praktische Umsetzung

Die Neuauflage des VDA Band 5 aus dem Jahr 2021 enthält eine Vielzahl von Neuerungen, die für Unternehmen im Automobilbereich in Zukunft wichtig werden. Eine der wichtigsten Neuerungen stellt die Forderung eines fortlaufenden Eignungsnachweises für kritische Prüfprozesse dar. Dieser Fachbeitrag erklärt die technischen und normativen Hintergründe der Anforderung und stellt konkrete Umsetzungsmöglichkeiten dar.

Die ISO 9001:2015 definiert Begriffe für die korrekte Funktion von Prüfmitteln. Grundsätzlich müssen im Kontext der ISO 9001:2015 zu jedem Zeitpunkt Eignung und Rückführbarkeit von Prüfmitteln sichergestellt sein. Diese beiden Anforderungen finden sich in vergleichbarer Form in Automobilspezifischen Normen wie der IATF 16949 oder dem VDA Band 5 wieder. Der VDA Band 5 beschreibt unter anderem, wie Eignung und Rückführbarkeit statistisch nachgewiesen werden können. Die Nachweispflicht gilt für alle Sensoren, Messgeräte und sonstige Hilfsmittel, bei denen eine Kundenspezifikation abgeprüft wird.

Um zu verstehen, was der VDA Band 5 unter einem fortlaufenden Eignungsnachweis versteht, ist es hilfreich zu veranschaulichen was die beiden Begriffe Rückführbarkeit und Eignung bedeuten:

| Begriffsdefinition Rückführbarkeit Rückführbarkeit stellt sicher, dass Messungen verschiedener Messmittel untereinander vergleichbar sind. So ist z.B. sichergestellt, dass Kunden und Lieferanten bei Messungen an Produkten zu gleichen Ergebnissen kommen. Die Vergleichbarkeit wird durch regelmäßige Kalibrierung sichergestellt. Das Kalibrierergebnis setzt sich aus Kalibrierabweichung und Kalibrierunsicherheit zusammen. Aus dem Kalibrierergebnis lässt sich eine Obergrenze für den systematischen Messfehler ableiten. Kalibrierung findet in regelmäßigen Intervallen und unter kontrollierten Bedingungen außerhalb des laufenden Produktionsprozesses statt. |

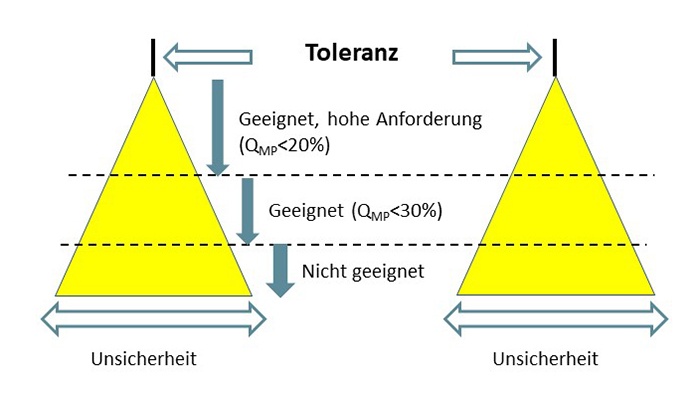

| Begriffsdefinition Eignung Eignung beschreibt die Unsicherheit einer Messung im Verhältnis zu einer gegebenen Toleranz (z.B. ein Zeichnungsmaß). Je kleiner die Unsicherheit einer Messung im Verhältnis zur Toleranz, desto höher ist die Eignung eines Messmittels für eine gegebene Prüfaufgabe. Abbildung 1 stellt den Sachverhalt grafisch dar. Wichtig ist, dass ein Eignungsnachweis immer unter Berücksichtigung der realen Anwendungsbedingungen geführt werden muss. Alle Einflussfaktoren, die im Serienprüfprozess wirksam sind, müssen auch im Eignungsnachweis berücksichtigt werden. Der systematische Messfehler aus der Kalibrierung ist somit einer von mehreren Einflussfaktoren, die zur Messunsicherheit beitragen. |

Abb. 1: Schematische Darstellung von Eignung nach VDA Band 5. Der gelb hinterlegte Bereich stellt den Unsicherheitsbereich der Messung dar.

Sicherstellung der fortlaufenden Eignung eines Prüfsystems

Bisher war es in vielen Firmen gelebte Praxis, den Eignungsnachweis einmalig bei der Inbetriebnahme oder nach größeren Änderungen durchzuführen. Die korrekte Funktion des Prüfmittels wurde lediglich über die regelmäßige Kalibrierung abgesichert. Dahinter steckt die Annahme, dass sich die Messunsicherheit eines Prüfmittels während des Betriebes nicht nennenswert verändert. Aus technischer Sicht ist dies jedoch eine gewagte Annahme. In vielen Messprozessen wird die Unsicherheit stark von äußeren Einflüssen bestimmt. Maschinen und Messaufnahmen und elektrische Kontaktierungen unterliegen beispielsweise dem Verschleiß, der über die Zeit hinweg zu einer höheren Messunsicherheit führen kann. Viele dieser äußeren Einflüsse auf die Messunsicherheit bleiben bei der regelmäßigen Kalibrierung jedoch unsichtbar.

An dieser Stelle setzt der neue VDA Band 5 an. In Kapitel 10 über die fortlaufende Eignung steht geschrieben: “Die Beurteilung der fortlaufenden Eignung, bislang oft auch als Stabilitätsüberwachung oder Messbeständigkeit genannt, hat aufgrund der Normenanforderung in der ISO 9001 an Bedeutung gewonnen.” Und weiter: “Die regelmäßige Kalibrierung der Messmittel ist im Rahmen der Prozesse zur Prüfmittelüberwachung unumgänglich (siehe Kapitel 4.5.2), reicht aber in vielen Fällen für eine umfassende Stabilitätsüberwachung nicht aus, da die Kalibrierung nicht unter tatsächlichen Einsatzgegebenheiten durchgeführt wird.”

Der VDA Band 5 stellt somit deutlich heraus, dass nicht alle Einflussfaktoren auf die Messunsicherheit durch Kalibrierung abgesichert werden können. Aus diesem Grund reicht die regemäßige Kalibrierung allein nicht aus, um fortlaufende Eignung eines Prüfsystems nachzuweisen.

Da Eignungsnachweise in der Regel mit erheblichem Aufwand verbunden sind, stellt sich die Frage, für welche Prüfprozesse ein fortlaufender Eignungsnachweis erforderlich ist. Der VDA Band 5 fordert insbesondere für sicherheitskritische und zulassungskritische Merkmale Absicherungsmaßnahmen, um die fortlaufende Eignung von Prüfprozessen sicherzustellen. In verringertem Umfang gilt diese Anforderung auch für Prüfungen von funktionswichtigen Merkmalen und Messungen, die direkten Einfluss auf die Produktqualität haben.

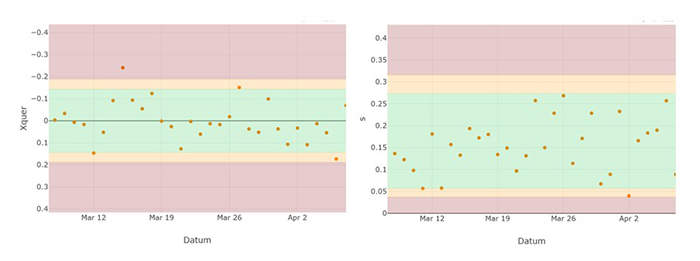

Praktische Umsetzung des kontinuierlichen Eignungsnachweises

Neben der Frage, für welche Prüfprozesse fortlaufende Eignung gefordert ist, ist die praktische Umsetzung eines solchen kontinuierlichen Eignungsnachweises besonders wichtig. Der zusätzliche Aufwand, der durch den kontinuierlichen Eignungsnachweis entsteht, sollte dabei so gering wie möglich ausfallen. Der VDA Band 5 schlägt zur praktischen Umsetzung einer fortlaufenden Eignungsprüfung den Einsatz von Regelkarten vor. Um die Daten für die Regelkarte zu erheben, werden regelmäßig ein oder mehrere Meisterteile geprüft und die Messwerte erfasst. Die Meisterteile sollten in sich stabil sein und ihre Messwerte über die Zeit hinweg möglichst wenig ändern. Auf diesem Weg kann die Stabilität eines Messprozesses in Bezug auf Lage und Streuung überwacht werden. Häufigkeit und Umfang der Prüfung werden auf Basis des Risikos festgelegt. Im VDA Band 5 werden als Beispiel klassische x ̅-s Karten mit einer Eingriffsgrenze von drei Standardabweichungen (99,73% Vertrauensniveau) oder gleitende Mittelwertkarten vorgeschlagen.

Abbildung 2 zeigt eine Regelkarte mit x ̅- und s-Spur, die zur Stabilitätsüberwachung eingesetzt werden kann. Der Nachteil der Regelkartentechnik besteht im beträchtlichen zeitlichen Aufwand. Prüfstände für komplexe Produkte wie Steuergeräte oder Getriebe haben hunderte von Prüfungen. Selbst wenn nur ein Teil der Messungen für die fortlaufende Eignung ausgewählt wird, kommen auf diese Art schnell dutzende Regelkarten zusammen.

Abb. 2: Zweispurige Stabilitätskarte zur Überwachung von Lage und Streuung eines Messprozesses. Die Eingriffsgrenzen sind rot gekennzeichnet. Zur besseren Orientierung wurden zusätzlich auch die Warngrenzen in Gelb dargestellt.

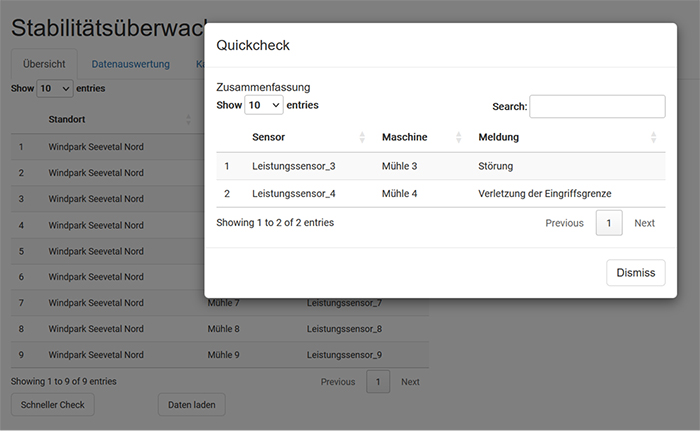

Automatische Überwachung von Prüfprozessen mittels Softwarelösung

Eine digitale Auswertung von Messdaten kann den zeitlichen Aufwand für den kontinuierlichen Eignungsnachweis erheblich reduzieren. Prophet Analytics bietet eine Softwarelösung, die Prüfprozesse automatisch überwacht und bei Abweichungen Benachrichtigungen erzeugt. So ist es nicht länger notwendig, jede Regelkarte manuell zu führen und zu bewerten. Verletzungen von Eingriffs- und Warngrenzen können über automatische Benachrichtigungen gelenkt werden.

Obwohl die Regelkartentechnik das Risiko fehlerhafter Messungen deutlich verringert, erlaubt dieser Ansatz streng genommen keine fortlaufende Eignungsprüfung. Regelkarten basieren grundsätzlich auf Stichprobenprüfungen und geben somit immer nur eine Momentaufnahme wieder. Einflussfaktoren, die nur sporadisch wirksam sind, können durch Regelkarten nicht zuverlässig überwacht werden. Ein zweiter Nachteil der Regelkartentechnik ist die Tatsache, dass das Einlegen der Meisterteile in der Regel einen Eingriff in den normalen Produktionsprozess bedeutet. In Produktionsanlagen und Maschinen, die auf eine kontinuierliche Fertigung ausgelegt sind, ist so ein Eingriff nicht möglich. Beispiele hierfür sind chemische Prozesse oder die Herstellung von Blechen oder Folien.

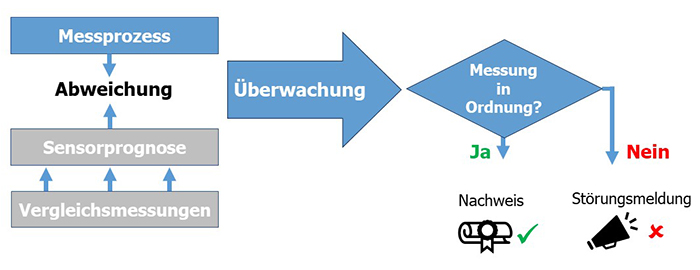

Prophet Analytics bietet auch eine Lösung zur Stabilitätsüberwachung für Maschinen, bei denen keine Meisterteile verwendet werden können. Eine Überwachung von einzelnen Prüfmitteln ist dann möglich, wenn weitere Daten aus unterschiedlichen Quellen verfügbar sind. Abbildung 3 zeigt eine schematische Darstellung des Verfahrens. Das Verfahren nutzt Daten aus Messungen, die von anderen Prüfeinrichtungen erhoben wurden und mit dem zu überwachenden Prüfmittel korreliert sind.

Abb. 3: Schematische Darstellung des Korrelationsverfahrens zur Stabilitätsüberwachung von Messprozessen.

Anwendung des Korrelationsverfahren in der Automobilindustrie

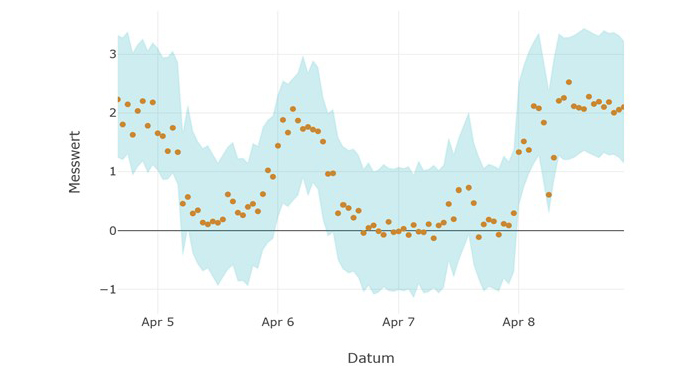

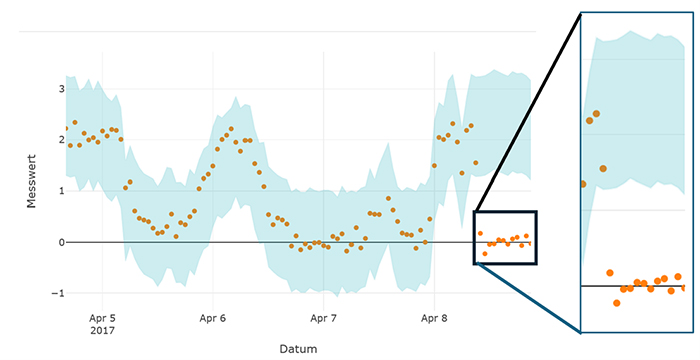

Ein Anwendungsbeispiel für das Korrelationsverfahren ist die Fertigung von Steuergeräten in der Automobilindustrie. Steuergeräte werden häufig mehrfach bei unterschiedlichen Temperaturen geprüft. Die Messwerte an den unterschiedlichen Prüfstationen sind korreliert. Durch Vergleich der Messwerte an den unterschiedlichen Prüfstationen kann eine Prognose für den erwarteten Messwert und ein plausibler Streubereich ermittelt werden. Abbildung 4 zeigt Messungen eines Prüfprozesses und den Zufallsstreubereich der Messung, der mit Hilfe des Korrelationsverfahrens ermittelt wurde. Messwerte außerhalb des blauen Zufallsstreubereichs würden auf eine Fehlfunktion des Messgeräts hindeuten.

Abb. 4: Daten eines Messgeräts (Punkte). Die blau hinterlegte Fläche zeigt Zufallsstreubereich an.

Das Korrelations-Verfahren hat zwei entscheidende Vorteile gegenüber der Regelkartentechnik: Es basiert nicht auf Stichproben und ermöglicht daher je nach Anlagenaufbau bis zu 100 Prozent Überwachung. Außerdem ist das Korrelationsverfahren aufwandsneutral, weil bestehende Daten aus dem laufenden Prozess verwendet werden und kein händischer Prozesseingriff mehr erforderlich ist. Das Korrelationsverfahren und das Regelkartenverfahren lassen sich unabhängig voneinander oder in Kombination anwenden (siehe Beispielanwendung einer Stabilitätsüberwachung).

Fazit

Auf den ersten Blick bedeutet ein kontinuierlicher Eignungsnachweis für Unternehmen mehr Aufwand und mehr Kosten. Diesem Aufwand stehen aber auch Einsparungen gegenüber. Die bessere Absicherung der Prüfprozesse beugt Reklamationen vor. Da die Lage und Streuung von Prüfprozessen mit kontinuierlichem Eignungsnachweis bekannt sind, besteht auch die Möglichkeit Kalibrierintervalle neu zu bewerten und gegebenenfalls zu verlängern. Viele Unternehmen nutzen heute schon eine Kombination aus Stabilitätsüberwachung und Kalibrierung, um Kosten bei der Kalibrierung einzusparen und gleichzeitig ein hohes Maß an Absicherung zu erreichen.

Zusammenfassend kann gesagt werden, dass die Anforderung nach einem kontinuierlichen Eignungsnachweis im neuen VDA Band 5 technisch sinnvoll ist. Die Forderung kann auf grundlegende Anforderungen der ISO 9001:2015 zurückgeführt werden und verbessert die Absicherung von kritischen Prüfprozessen. Der Einsatz moderner Softwarelösungen kann helfen, ein hohes Maß an Absicherung zu erreichen, ohne unnötige händische Eingriffe in den Produktionsprozess vornehmen zu müssen. Der kontinuierliche Eignungsnachweis kann auf diesem Wege nahezu aufwandsneutral gestaltet werden.

Über den Autor:

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Prüfmittel. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten.

Lean Management ist mehr als Aufräumen – die Bedeutung und Prinzipien

Lean Management hat in den letzten Jahrzehnten einen bemerkenswerten Aufschwung erlebt und ist zu einem integralen Bestandteil zahlreicher Unternehmensstrategien geworden. Doch oft wird Lean Management fälschlicherweise auf die schlichte Organisation und Sauberkeit am Arbeitsplatz reduziert. In Wahrheit ist Lean weit mehr als nur das.

Lean Management ist ein ganzheitlicher Ansatz zur Steigerung der Effizienz und Wertschöpfung in Unternehmen. Es geht dabei nicht nur um die Reduzierung von Verschwendung und die Schaffung von Ordnung am Arbeitsplatz, sondern um eine tiefgreifende Transformation der Unternehmenskultur und -prozesse.

Die Lean Prinzipien: Grundlagen einer schlanken Organisation

Die Prinzipien des Lean Management bilden das Fundament für eine effektive Umsetzung. Die Kernprinzipien lauten:

- Wertschöpfung aus Sicht des Kunden:

Das Hauptaugenmerk liegt darauf, den Wert aus Sicht des Kunden zu definieren und alle Aktivitäten darauf auszurichten, diesen Wert zu maximieren und Verschwendung zu minimieren. - Identifikation und Eliminierung von Verschwendung:

Wertstrom identifizieren. Der Ansatz zielt darauf ab, alle Arten von Verschwendung zu erkennen und zu beseitigen, sei es in Form von Überproduktion, Wartezeiten, unnötigen Bewegungen, Lagerbeständen oder Fehlern. - Schaffung von Fluss:

Die reibungslose Durchführung von Prozessen wird durch die Schaffung eines kontinuierlichen Flusses von Materialien, Informationen und Aktivitäten angestrebt, um Verzögerungen und Engpässe zu minimieren. - Pull-Prinzip:

Die Produktion wird durch die tatsächliche Nachfrage gesteuert, wodurch Überproduktion vermieden und eine Just-in-Time-Produktion ermöglicht wird. - Streben nach Perfektion:

Lean Management ist ein kontinuierlicher Verbesserungsprozess, bei dem ständig nach Möglichkeiten gesucht wird, Prozesse effizienter zu gestalten und die Qualität zu verbessern.

Sieben Arten der Verschwendung

Die sieben Arten der Verschwendung (Akronym TIMWOOD), auch bekannt als die “7 Muda” im Lean Management, sind grundlegende Kategorien von nicht-wertschöpfenden Aktivitäten oder Ressourcen, die die Effizienz von Prozessen verringern. Diese Konzepte wurden von Taiichi Ohno, einem Pionier des Toyota Production Systems, entwickelt.

Die sieben Arten der Verschwendung lassen sie wie folgt beschreiben:

- Überflüssige Transporte (Transportation):

Überflüssige Transporte beziehen sich auf unnötige Bewegungen von Materialien oder Produkten innerhalb eines Produktionsprozesses oder zwischen verschiedenen Standorten. Dies kann zu zusätzlichen Kosten, Zeitverlusten und Beschädigungen führen. - Bestände (Inventory):

Bestände entstehen, wenn mehr Materialien oder Produkte vorhanden sind als unmittelbar benötigt werden. Dies führt zu erhöhten Lagerkosten, versteckten Qualitätsproblemen und einem erhöhten Risiko für Überproduktion und Verschwendung. - Bewegung (Motion):

Verschwendung tritt auf, wenn Mitarbeitende unnötige Bewegungen ausführen, um eine Aufgabe abzuschließen, zum Beispiel längere Laufwege, unergonomische Arbeitsplatzgestaltung oder unnötige Auspack- oder Umräumvorgänge. Dies kann zu Ermüdung, Verletzungen und einer Verringerung der Effizienz führen. - Wartezeiten (Waiting):

Wartezeiten entstehen, wenn Produkte oder Mitarbeitende auf den Beginn einer nächsten Aktivität warten müssen. Dies kann durch ineffiziente Prozesse, unzureichende Ressourcenauslastung oder Engpässe in der Produktion verursacht werden. - Überproduktion (Overproduction):

Überproduktion tritt auf, wenn mehr produziert wird, als tatsächlich benötigt wird. Dies führt zu unnötigen Lagerbeständen, erhöhten Lagerkosten und verdeckt oft andere Probleme in der Produktion, wie Engpässe und Qualitätsprobleme. Zudem sind Überproduktionen die Ursache für zwei bereits genannte Lean Verschwendungsarten, nämlich Transport und Bestände. - Überbearbeitung (Overprocessing):

Overprocessing oder auch overengineering bezieht sich auf unnötige oder übermäßige Arbeitsschritte oder Aktivitäten, die über die Anforderungen des Kunden hinausgehen oder keinen zusätzlichen Wert für das Endprodukt oder die Dienstleistung bieten. Dies führt zu einer ineffizienten Nutzung von Ressourcen und erhöhten Kosten, ohne einen entsprechenden Nutzen zu erzielen. - Defekte (Defects):

Defekte oder Ausschuss bezieht sich auf fehlerhafte Produkte oder Dienstleistungen, die nicht den Qualitätsstandards entsprechen und daher nachgearbeitet oder aussortiert werden müssen.

Ergänzend wird häufig noch das ungenutzte Talent beziehungsweise die ungenutzte Kreativität der Mitarbeiter sowie das Ungleichgewicht („Mura“) und die Überbeanspruchung („Muri“) aufgenommen. Diese beiden Begriffen lassen sich wie folgt beschreiben:

| Begriffsdefinition Muri Muri bezeichnet Überlastung oder Überbeanspruchung. Es tritt auf, wenn Mitarbeiter, Maschinen oder Prozesse über ihre Kapazitätsgrenzen hinaus belastet werden. Dies kann zu übermäßiger Anstrengung, Erschöpfung, Qualitätsproblemen und ineffizienten Abläufen führen. Beispiele für Muri sind übermäßige Arbeitsbelastung für Mitarbeiter, unzureichende Kapazität von Maschinen oder unnötig komplexe Arbeitsabläufe. |

| Begriffsdefinition Mura Mura bezeichnet Ungleichgewicht oder Unausgeglichenheit. Es tritt auf, wenn es Unregelmäßigkeiten oder Schwankungen in einem Prozess gibt, die zu Instabilität und Ineffizienz führen. Dies kann zu Engpässen, Wartezeiten, Überproduktion oder unvorhersehbaren Ergebnissen führen. Beispiele für Mura sind ungleichmäßige Arbeitsbelastung, unregelmäßige Produktionsplanung oder unvorhersehbare Schwankungen in der Nachfrage. |

In einem Lean-Produktionssystem strebt man danach, Muri und Mura zu reduzieren oder zu beseitigen, um einen gleichmäßigen, stabilen und effizienten Produktionsfluss zu erreichen. Durch die Eliminierung von Muri und Mura kann die Produktivität gesteigert, die Qualität verbessert und die Verschwendung reduziert werden.

Die sieben Verschwendungsarten werden besonders interessant, wenn man sie genauer analysiert und dabei möglicherweise feststellt, dass eine Verschwendung nur durch eine andere vermieden werden kann. Dadurch entwickeln sich die sieben Muda, insbesondere im Zusammenspiel mit Mura und Muri, zu einem umfassenden Denkmodell, das bei der Gestaltung von Organisationen, der Prozessoptimierung und der Digitalisierung äußerst nützlich ist.

Grundlegende Philosophie für mehr Wettbewerbsfähigkeit

Die Prinzipien des Lean, wenn sie konsequent angewendet werden, führen zu einer schlanken Organisation, die in der Lage ist, sich schnell an Veränderungen anzupassen, Verschwendung zu minimieren und höchste Qualität zu liefern. Es ist eine Philosophie, die die gesamte Organisation durchdringt und einen nachhaltigen Wettbewerbsvorteil schafft.

In der heutigen schnelllebigen Geschäftswelt ist es entscheidend, dass Unternehmen über die traditionellen Grenzen des Lean Managements hinausblicken und die tieferen Prinzipien verstehen, um ihre Wettbewerbsfähigkeit zu erhalten und zu verbessern. Lean Management zielt auf eine grundlegende Veränderung der Art und Weise ab, wie Unternehmen betrieben werden.

Mehr Prozesseffizienz durch Lean-Management-Methoden

Lean Management-Methoden können im Qualitätsmanagement dazu beitragen, Prozesse effizienter zu gestalten, indem sie Verschwendung reduzieren, kontinuierliche Verbesserungen fördern und eine stärkere Kundenorientierung ermöglichen. Hier sind einige Beispiele aus der Praxis:

Identifizierung und Eliminierung von Verschwendung:

Lean-Methoden wie Value Stream Mapping helfen dabei, den Fluss von Materialien und Informationen durch den gesamten Produktions- oder Dienstleistungsprozess zu visualisieren. Durch die Analyse dieses Flusses können Unternehmen nicht wertschöpfende Aktivitäten identifizieren und eliminieren, die die Qualität beeinträchtigen könnten.

Kontinuierliche Verbesserung:

Durch die Einführung von Methoden wie Kaizen-Veranstaltungen oder PDCA-Zyklen (Plan-Do-Check-Act) können Organisationen kontinuierlich nach Möglichkeiten zur Verbesserung ihrer Qualitätsprozesse suchen. Zum Beispiel könnte ein Unternehmen regelmäßige Kaizen-Veranstaltungen durchführen, um potenzielle Qualitätsprobleme zu identifizieren und zu lösen, bevor sie sich auf die Endprodukte auswirken.

Kundenorientierung:

Durch die Anwendung von Methoden wie Kundenfeedback-Analysen oder Voice of Customer (VOC)-Studien können Unternehmen ein besseres Verständnis für die Anforderungen ihrer Kunden entwickeln und sicherstellen, dass ihre Qualitätsprozesse diese Anforderungen erfüllen. Zum Beispiel könnte ein Unternehmen VOC-Studien verwenden, um direktes Feedback von Kunden über die Qualität seiner Produkte oder Dienstleistungen zu erhalten und Verbesserungen vorzunehmen, um ihre Zufriedenheit zu steigern.

Just-in-Time-Produktion:

Durch die Implementierung von Just-in-Time-Prinzipien können Unternehmen die Effizienz ihrer Produktionsprozesse steigern und gleichzeitig die Qualität verbessern. Indem Materialien und Ressourcen nur dann bereitgestellt werden, wenn sie benötigt werden, können Unternehmen Überproduktion und Lagerbestände reduzieren, die die Qualität beeinträchtigen könnten. Zum Beispiel könnte ein Unternehmen Kanban-Systeme verwenden, um den Materialfluss zu steuern und sicherzustellen, dass Materialien nur dann nachgeliefert werden, wenn sie tatsächlich benötigt werden.

Auch wenn der Ursprung aus dem produzierenden Umfeld stammt, ist die die Anwendung von Lean Management auch bei Dienstleistungen problemlos möglich:

Ein Callcenter analysiert beispielsweise gezielt Kundenfeedback, um die wichtigsten Bedürfnisse und Erwartungen der Kunden zu identifizieren. Dabei stellt sich heraus, dass die Kunden vor allem schnelle und präzise Antworten auf ihre Fragen erwarten und keinen Wechsel der Ansprechpersonen wünschen.

Durch die Anwendung von Lean-Tools wie Value Stream Mapping wird der Kundenserviceprozess visualisiert, von der Annahme des Anrufs bis zur Lösung des Kundenproblems. Dabei werden nicht-wertschöpfende Aktivitäten wie unnötige Übertragungen zwischen Abteilungen oder wiederholte Dateneingaben identifiziert und beseitigt.

Über den Autor:

Oliver Schneider studierte Ernährungswissenschaften (M.Sc.) in Gießen und war danach als wissenschaftlicher Mitarbeiter und Projektassistent tätig. Seit 2015 ist er als Produktmanager bei der DGQ und verantwortet aktuell das Weiterbildungsportfolio zum Thema Qualitätsmanagement und Lean Six Sigma. Seine Qualifizierungen zum Qualitätsmanager und Lean Six Sigma Green Belt helfen ihm bei der Weiterentwicklung und Beratung seiner Themenbereiche.

Künstliche Intelligenz in der Qualität – Praktische Einführung durch iteratives Vorgehen

In den vergangenen Jahren sind eine Reihe von einfach zu bedienenden künstliche Intelligenz (KI) Werkzeugen entstanden, die sich problemlos in bestehende Arbeitsabläufe integrieren lassen. Chatbots wie ChatGPT und Low-Code/No-Code- Lösungen sind Beispiele hierfür. Diese Entwicklung hat die Einstiegsschwelle für Mitarbeiter, die mit KI arbeiten möchten, deutlich reduziert. Im zweiten Teil der Fachbeitragsreihe haben wir die notwendigen Qualifikationen behandelt, die Mitarbeiter in Zukunft mitbringen sollten. In diesem Fachbeitrag wird anhand eines konkreten Beispiels gezeigt, wie eine Einbindung von einfachen KI-Werkzeugen einen Mehrwert im Unternehmen schaffen kann.

Die Anwendungsfälle für KI entstehen im besten Fall aus der Kreativität der Mitarbeiter und nicht aus einer übergeordneten Firmenstrategie. Das bedeutet: Reale Probleme lösen und nicht Probleme für bestehende (IT-)Lösungen suchen. Der Vorteil hierbei ist, dass zum frühestmöglichen Zeitpunkt ein Mehrwert für das Unternehmen entsteht, ohne dass große Projektbudgets ausgelobt werden müssen.

Einsatz von Methoden aus dem agilen Projektmanagement

Insbesondere durch den Einsatz der Methoden des agilen Projektmanagements (SCRUM, KANBAN) lassen sich Projekte in eigenständige Teillösungen, sogenannte Minimal Viable Products (MVP) planen. Dies hat zur Folge, dass man Produkte beziehungsweise Lösungen in einem Baukastensystem aufbaut und immer wieder verbessert und erweitert. Gleichzeitig lässt sich die hergestellte Teillösung nutzen, ohne das Gesamtergebnis abwarten zu müssen. Dieser Ansatz fügt sich nahtlos in bestehende Programme zur kontinuierlichen Verbesserung (zum Beispiel Kaizen) ein.

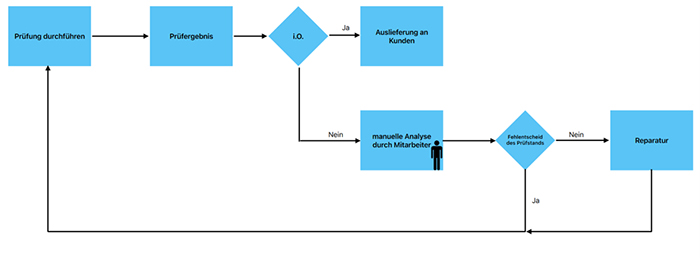

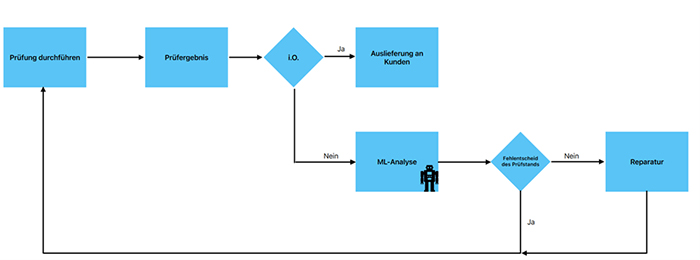

Hierfür ein Beispiel: In einer Produktionslinie werden Produkte durch das Prüfgerät fälschlicherweise als nicht in Ordnung (n.i.O.) eingestuft. Nach einer manuellen Analyse und dem Erstellen eines Analyseberichts des Mitarbeiters, wird das Produkt erneut getestet und durch das Prüfergebnis als in Ordnung (i.O.) eingestuft (siehe Abbildungen 1 und 2). Diese Fehlentscheidungen führen zu Verschwendungsformen wie: Fehlerkorrekturen, Lagerbestände, Wartezeiten und nicht genutztes Mitarbeiterpotential (s. sieben Arten der Verschwendung des Toyota Produktionssystems).

Abb. 1: Ablauf einer Prüfausfallanalyse mit manuellem Prozess

Abb. 12 Ablauf einer Prüfausfallanalyse mit maschinengestütztem Prozess

In der klassischen Qualitätssicherung ergreift man in erster Linie Maßnahmen, um das Prüfgerät und den Prüfprozess zu optimieren, zum Beispiel durch die klassische Six-Sigma-DMAIC-Methode. Gerade bei technisch anspruchsvollen Prüfungen muss jedoch häufig ein Kompromiss zwischen Fehlalarmen und der Gefahr eines Durchschlupfes gefunden werden, der sich mit klassischen Statistikwerkzeugen nur schwer auflösen lässt.

Machine-Learning-Methoden (ML) wie supervised learning können die bereits vorhandene Expertise des Mitarbeiters in Form eines Modells nachbilden und so offensichtliche Fehlalarme von vornherein zur Nachprüfung vorsehen. Das Modell wird dabei auf Basis bereits vorhandener Analyseberichte der Mitarbeiter trainiert.

Das Ergebnis des Pilotprojekts könnte wie folgt aussehen: Der Mitarbeiter liest die Prüfberichte des Prüfgeräts im erstellten ML-Programm ein. Algorithmen wie lineare Regression oder Entscheidungsbäume erlauben es mit wenig Aufwand die Wahrscheinlichkeit für eine Fehlmessung des Prüfgeräts zu ermitteln. Abbildung 3 zeigt ein Visualisierungsbeispiel. Der Mitarbeiter kann nun alle offensichtlichen Fehlentscheide einer Wiederholungsprüfung unterziehen, ohne diese vorher im Detail zu analysieren. Alle weiteren Prüfstandsausfälle, die nicht als klare Fehlmessung klassifiziert wurden, werden zur internen Analyse weitergeleitet.

Abb. 3: Beispielhafte Darstellung einer Messdatenbewertung mit Hilfe von Machine Learning. Werte außerhalb des blauen Stabilitätsbereichs sind mit hoher Wahrscheinlichkeit auf eine Fehlfunktion am Prüfgerät zurückzuführen. ©Prophet Analytics GmbH

Durch dieses Pilotprojekt lassen sich nicht wertschöpfende Aufgaben des Mitarbeiters reduzieren und der Fokus liegt auf den tatsächlich fehlerhaften Produkten. Nun hat man einen MVP, der sofort einsatzfähig ist. Allerdings muss dieser MVP offline am (Prüf-) Rechner des Mitarbeiters bedient werden. Nicht alle Verschwendungsarten lassen sich so vollständig eliminieren.

Integration von Machine Learning basierten Lösungen in den Produktionsprozess

Eine weitere Reduzierung von Verschwendung ist möglich, wenn das Machine-Learning-Modell in die Maschinensteuerung integriert wird. So können beispielsweise Transportkosten eliminiert und die Linienauslastung verbessert werden. Für eine Linienintegration benötigt man in der Regel weitere Ressourcen, zum Beispiel aus der IT -und Prozessplanungsabteilung. Diese würde man im Rahmen der weiteren Projektarbeit und weitere MVPs planen. Der erste MVP bleibt über die gesamte Projektdauer nutzbar und erzielt Einsparungen. Wichtig ist auch, dass das Projekt erst aufgesetzt wird, wenn die technische Umsetzbarkeit der Lösung schon nachgewiesen ist und Projektrisiken so auf ein Minimum reduziert werden.

Die Firma Prophet Analytics hat diesen Ansatz zur Reduzierung von Prüfstandsfehlern noch weiter ausgebaut. Die Machine Learning basierte Lösung erkennt und lokalisiert Ursachen für Prüfstandsfehler im laufenden Betrieb (siehe Abbildung 4). Die Überwachung von Messprozessen auf Basis von Daten eliminiert unnötige Eingriffe in den Produktionsprozess. Im Gegensatz zu Stichprobenverfahren wie der statistischen Prozesskontrolle (SPC) werden die Prüfprozesse durchgehend überwacht. Verschwendung durch Fehlentscheide können so von Vornherein vermieden werden und die Gefahr von Durchschlupf und Kundenreklamationen wird gebannt.

Abb. 4: Darstellung einer automatischen Überwachung von Messprozessen mit Hilfe von Machine Learning

Das Beispiel soll zeigen, wie die einzelnen Teilprojekte logisch auf einander aufbauen. Jeder weitere MVP hebt für zusätzliche Einsparpotentiale, aber erfordert auch mehr technisches Verständnis und eine höhere Qualifikation der Mitarbeiter.

Entwicklung neuer Berufsqualifikationen

Das bemerkenswerte an dem vorgestellten Ansatz für die Einführung von KI ist, dass interessierte Mitarbeiter automatisch höhere Qualifikationen erwerben, während sie an ihren eigenen Lösungen arbeiten. Das Ergebnis der Projekte kommt direkt ihrer eigenen täglichen Arbeit zugute und es werden nur Fähigkeiten aufgebaut, die relevant und zielführend sind. Mitarbeiter, die auf diesem Wege ein hohes Qualifikationsniveau erreicht haben, werden in der Fachwelt auch Citizen Data Scientists genannt. Diese Mitarbeiter wenden regelmäßig Methoden der KI und des Machine Learning zur Unterstützung ihrer eigentlichen Tätigkeit an, sind aber keine hauptberuflichen Data Science Experten.

Zusammenfassend kann gesagt werden, dass der Fokus auf einfache Anwendungsfälle für KI sich direkt aus dem kontinuierlichen Verbesserungsgedanken ergibt. Das Beispiel hat gezeigt, wie sich selbst bei einfachen KI Anwendungsfällen durch mehrfache Erweiterung immer höhere Einsparpotentiale heben lassen. Das iterative Vorgehen stellt dabei sicher, dass Einsparungen zeitnah wirksam werden und Finanzierungskosten für Projekte gering bleiben. Die Qualifikation der Mitarbeiter wächst parallel zur Umsetzung mit jedem KI-Anwendungsfall. Das natürliche Ende dieses iterativen Aufbaus von Qualifikationen ist der Citizen Data Scientist. Der Citizen Data Scientist kann KI-Methoden einsetzen und bringt ein hohes Maß an anwendungsspezifischen Kenntnissen mit.

Lesen Sie auch die ersten beiden Teile der Reihe “Künstliche Intelligenz in der Qualität“:

- Teil 1: Künstliche Intelligenz in der Qualität – Bestehendes Know-how effektiv nutzen – zum Beitrag »

- Teil 2: Künstliche Intelligenz in der Qualität – Welche Qualifikationen werden benötigt? – zum Beitrag »

Über die Autoren:

Dipl.-Ing. Waldemar Fahrenbruch ist Head of Q-Technology Division E-Mobility bei der ZF Friedrichshafen AG. Er ist verantwortlich für die Qualitätskostensenkung bei gleichzeitiger Optimierung von Qualitätskonzepten in den Werken der Division E (TCU, Power Electronics und E-Motoren Fertigung) durch Methodenkompetenz der Qualität, künstlicher Intelligenz und digitaler Transformation.

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Künstliche Intelligenz. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten. Kontakt: ki@prophet-analytics.de

Künstliche Intelligenz in der Qualität – Welche Qualifikationen werden benötigt?

Künstliche Intelligenz (KI) in ihrer aktuellen Form hat eine hohe Aufmerksamkeit auf sich gezogen. Viele Firmen stellen sich die Frage, wie sie sich am besten auf die neuen Entwicklungen vorbereiten können. Einer der wichtigsten Erfolgsfaktoren ist dabei die Qualifikation der Mitarbeiter. Im ersten Teil dieser Serie wurde gezeigt, dass das Qualitätswesen eine vergleichsweise kleine Einstiegsschwelle in diese neuen KI-Technologien hat. Die Aufgabe des Qualitätswesens war es seit jeher, mit Hilfe von Daten und Statistik Transparenz zu schaffen und Verbesserungspotentiale zu heben. KI stellt somit in vielerlei Hinsicht eine Erweiterung des bestehenden Methodenkoffers dar. Auch für das Qualitätswesen stellt sich jedoch die Frage, wie Mitarbeiter am besten für den Einsatz neuer Methoden qualifiziert werden können.

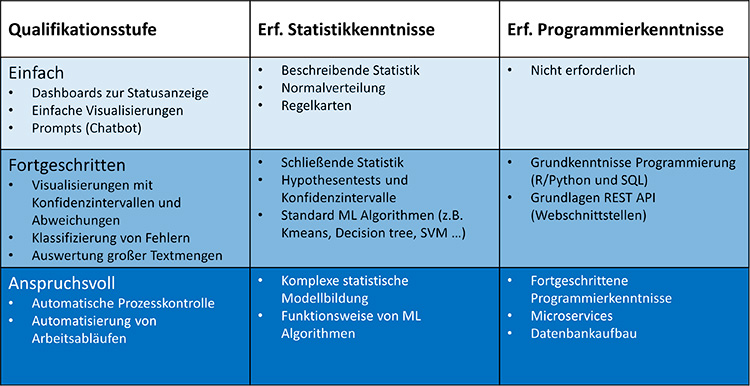

In diesem Beitrag beschreiben wir drei Stufen der Qualifikation mit Mindestanforderungen. Die niedrigste Qualifikationsstufe ist dabei in der Regel für alle Qualitätsmitarbeiter ohne erweiterte Trainingsmaßnahmen erreichbar. Es wird gezeigt, dass sich mit jeder Qualifikationsstufe neue Anwendungsfälle erschließen lassen, die weitere Einsparpotenziale bieten. Welche Methoden für den einzelnen Mitarbeiter relevant sind, hängt vom Einsatzbereich innerhalb der Qualität ab. Es wird daher gezeigt, in welchem Bereich welche Technologie am besten einsetzbar ist und wie hoch die Einsparpotenziale typischerweise sind.

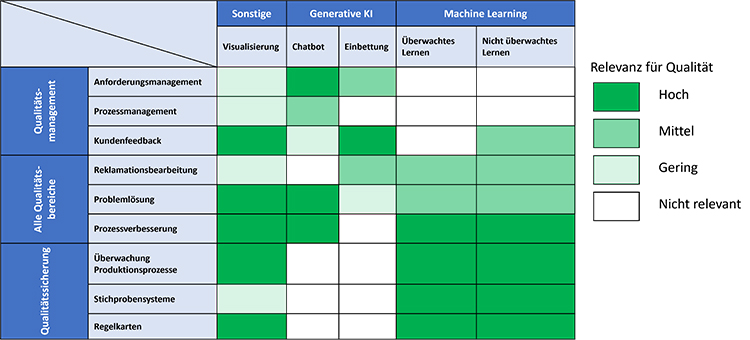

Methoden der künstlichen Intelligenz und ihre Anwendungsgebiete innerhalb des Qualitätswesens

Tabelle 1 zeigt eine Übersicht, welche Methoden für das Qualitätsmanagement und die Qualitätssicherung relevant sind. Die Methoden fallen in zwei große Bereiche der künstlichen Intelligenz: Machine Learning und generative KI. Machine Learning beinhaltet sowohl erweiterte statistische Verfahren als auch Bilderkennung. Generative KI wurde durch den Chatbot ChatGPT und die Bildverarbeitungsmodelle Midjourney und Stable Diffusion bekannt. Chatbots eignen sich zur Verarbeitung großer Textmengen (z.B. Normentexten oder Kundenanforderungen). Bildverarbeitungsmodelle sind im Qualitätsbereich weniger von Interesse.

Eine weniger bekannte Anwendung generativer KI ist die Einbettung (embedding). Einbettung erlaubt Texte zu gruppieren oder auf Ähnlichkeit zu prüfen. So können beispielsweise Kundenbewertungen zusammengefasst werden oder 8D Berichte nach ähnlichen Fehlerbildern durchsucht werden. Einbettung kann als eine Art erweiterte Schlagwortsuche verstanden werden, bei der nicht mehr nach exakten Übereinstimmungen, sondern nach ähnlichen Sinnzusammenhängen gesucht wird.

Eine weitere wichtige Disziplin stellt die Visualisierung von Daten dar. Visualisierung ist kein Teilgebiet der künstlichen Intelligenz, aber sie spielt eine wichtige Rolle in der Vermittlung von Ergebnissen. Insbesondere bei komplexeren Methoden des Machine Learnings ist eine gute Visualisierung unabdingbar.

Tab. 1: Methoden der künstlichen Intelligenz und ihre Anwendungsgebiete innerhalb des Qualitätswesens.

Tabelle 1 kann in drei Anwendungsgruppen unterteilt werden. Visualisierung spielt überall dort eine große Rolle, wo aus Daten Korrekturmaßnahmen abgeleitet werden. Dies ist in der Problemlösung und Prozessverbesserung (KVP/Kaizen) der Fall. Auch in der Fertigung findet man solche Anwendungsfälle (z.B. Shopfloorvisualisierungen). Diese Anwendungsfälle lassen sich häufig mit geringem Aufwand und No-Code-Werkzeugen umsetzen.

Die zweite Anwendungsgruppe Generative KI beinhaltet Anwendungsfälle, bei denen große Mengen an Text analysiert und verarbeitet werden müssen. Das Qualitätsmanagement hat einen starken Bezug zu Normen, Richtlinien und Kundenvorgaben. Generative KI können in Form von Chat Bots viele Aufgaben vereinfachen (z.B. der Vergleich unterschiedlicher Normen oder das Erstellen von Gap-Listen bei Normänderungen). Außerdem können Chatbots mit geeigneten Prompts Problemlösungsprozesse unterstützen.

Die dritte Anwendungsgruppe umfasst das Machine Learning. Machine Learning hat eine große Überschneidung mit klassischer Statistik. Statistikwerkzeuge sind in der Qualitätssicherung weit verbreitet. Machine Learning bietet Methoden zum Klassifizieren und Clustern von Daten. Es können auch Modelle und Prognosen über zukünftige Verläufe erstellt werden. Diese Methoden eignen sich auch hervorragend zur Analyse großer Datensätze, die in modernen Produktionsprozessen entstehen.

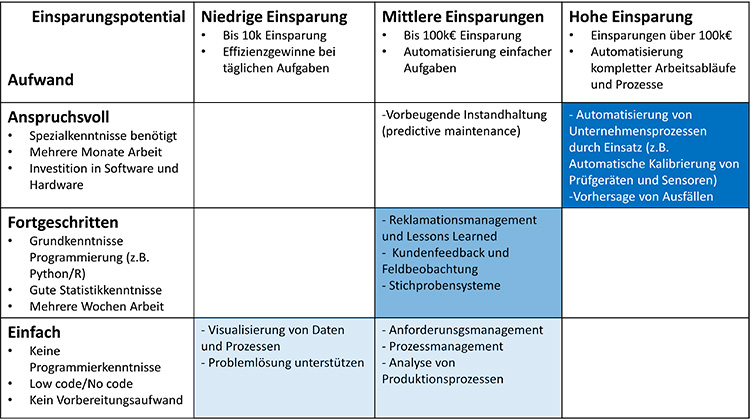

Die Frage, die sich Mitarbeitern und Führungskräften gleichermaßen stellt ist: Welche Anwendungsfälle können mit den zur Verfügung stehenden Zeitressourcen bearbeitet werden und wie hoch sind die zu erwartenden Einsparungen. Tabelle 2 soll hierzu eine Hilfestellung geben. Auf der horizontalen Achse sind die zu erwartenden Einsparsummen und auf der vertikalen Achse sind die benötigten Ressourcen abgetragen. Es zeigt sich, dass mit höheren Qualifikationen und größerem Zeiteinsatz auch Anwendungen erschlossen werden können, die größere Einsparungen hervorbringen. Mit Hilfe der Tabelle können Qualifikationsmaßnahmen und Einsparziele zu einer Strategie mit Zielvorgaben verzahnt werden. Es ist wichtig zu betonen, dass es sich bei der Einteilung um Erfahrungswerte handelt, die je nach Anwendung abweichen können.

Tab. 2: Gegenüberstellung von typischen Einsparpotenzialen und notwendiger Qualifikation für typische Anwendungsfälle.

Als Pilotprojekte für künstliche Intelligenz eignen sich Anwendungsfälle der einfachen Kategorie. Diese Projekte können in der Regel ohne Einsatz von Programmierung erstellt werden und nutzen entweder vorgefertigte Lösungen wie ChatGPT oder Low-code-/No-Code-Software wie PowerBI oder KNIME. Das Ergebnis solcher Projekte sind häufig Dashboard-Lösungen oder kleine Werkzeuge. Sie können elegant in bestehende Prozesse eingebunden werden und reduzieren den Arbeitsaufwand bei wiederkehrenden Tätigkeiten. Der Fokus auf einfache Pilotprojekte erzeugt schnellen Mehrwert und Motivation.

Es ist nicht ungewöhnlich, dass einfache Projekte, wenn sie erfolgreich sind, immer wieder erweitert werden und von der einfachen auf die fortgeschrittene oder sogar anspruchsvolle Stufe gelangen. Ähnlich wie beim agilen Projektmanagement entsteht auf jeder Stufe neuer Mehrwert.

Typische Anforderungsprofile für Mitarbeiter der unterschiedlichen Qualifikationsniveaus

Ein Beispiel soll dies verdeutlichen: Viele Firmen nutzen automatische Prüfsysteme. Bei schwierigen Prüfaufgaben muss oft ein gewisses Maß an Fehlentscheidungen in Kauf genommen werden. Die Fehlerteile müssen dann händisch nachkontrolliert und gegebenenfalls nachgeprüft werden. Die Nachprüfentscheidung basiert oft auf einfachen Regeln. Diese Regeln lassen sich leicht mit Hilfe von Machine Learning auf Software übertragen, wenn eine ausreichende Anzahl von Beispielen vorhanden sind.

Das Ergebnis eines einfachen Pilotprojekts könnte wie folgt aussehen: Der Mitarbeiter liest die n.i.O.-Prüfberichte im erstellten ML-Programm ein. Das Programm gibt als Ergebnis alle Fehlentscheide mit einem zugehörigen Vertrauensniveau aus. Der Mitarbeiter kann alle offensichtlichen Fehlentscheide einer Wiederholungsprüfung unterziehen, ohne die Ausfälle im Detail zu analysieren. Durch das Pilotprojekt lassen sich repetitiven Aufgaben des Mitarbeiters reduzieren und er kann seinen Fokus den Echtfehlern widmen.

Das Pilotprojekt lässt sich in die fortgeschrittene Stufe erweitern, wenn die Software in die Produktionslinie integriert wird. Die benötigten Ressourcen steigen und es werden mehr Kenntnisse aus der IT und den technischen Abteilungen benötigt, aber die Einsparung ist ungleich größer. Da die Entscheidung nun innerhalb der Produktionsmaschine erfolgt, fallen Transportschritte und händische Teileerfassung in der Analyse weg. Dieses iterative Vorgehen minimiert Umsetzungsrisiken und erzeugt zählbaren Mehrwert bei jeder Erweiterung.

Die fortgeschrittene Aufwandskategorie benötigt bereits Grundkenntnisse in der Programmierung. R und Python sind hier die am weitesten verbreiteten Programmiersprachen [5]. Diese Programmiersprachen sind in vielen anderen Werkzeugen integriert, so dass beispielsweise ein Knime- oder PowerBI-Dashboard verwendet werden kann, um die Ergebnisse zu visualisieren, die mit einem Python Skript berechnet wurden. Mitarbeiter mit fortgeschrittener Qualifikation können Projekte mit erheblichen Einsparpotentialen umsetzen. Gleichzeitig sind die Projekte meist noch klein genug, um als Abschlussarbeit oder als Sonderaufgabe neben dem Tagesgeschäft bearbeitet zu werden.

In die anspruchsvolle Kategorie fallen Projekte, die von hochqualifizierten Mitarbeitern bearbeitet werden müssen. Die Einsparpotenziale sind hier nach oben offen, aber in der Regel sind diese Projekte so groß und komplex, dass Mitarbeiter mehrer Fachabteilungen zusammenarbeiten müssen. Oft werden bei solchen Projekten auch externe Experten hinzugezogen, um Qualifikationslücken innerhalb des Teams zu kompensieren. Anspruchsvolle Projekte zielen oft darauf ab, komplette Arbeitsabläufe zu komplett zu automatisieren. Ein Anwendungsbeispiel hierfür ist die Automatisierung der Überwachung von Prüfmitteln, die heute in der Regel händisch und unter hohem Aufwand erfolgt.

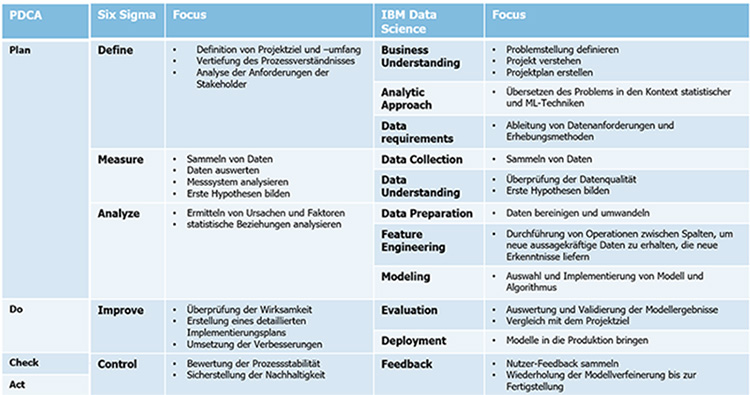

Mitarbeiter, die das höchste Qualifikationsniveau erreichen, sind Spezialisten. Im letzten Beitrag wurde die große Ähnlichkeit zwischen dem IBM Data Science Modell und Six Sigma dargestellt. Ähnlich wie ein Six Sigma Black Belt haben diese Spezialisten oft die Aufgabe, weniger qualifizierte Mitarbeiter anzuleiten und zu unterstützen.

Tabelle 3 zeigt Mindestqualifikationen für die Aufgabenkategorien aus Tabelle 2. Die erforderlichen Qualifikationen fallen in zwei Kategorien: Statistikkenntnisse, die benötigt werden, um die Korrektheit der Auswertungen bewerten zu können und Programmierkenntnisse, die für anspruchsvolle Anwendungen erforderlich sind. Auch hier handelt es sich um Erfahrungswerte. Im Einzelfall können die notwendigen Qualifikationen abweichen.

Die Tabelle 3 soll eine Richtschnur darstellen, was Mitarbeiter üblicherweise benötigen, um KI Aufgabenstellungen zu bearbeiten. Die Richtschnur ermöglicht Führungskräften, ihre Qualifikationsmaßnahmen auf ihre eigenen Anwendungen abzustimmen. Sie stellt außerdem sicher, dass Mitarbeiter mit Aufgaben betraut werden, die zu ihrem Qualifikationsprofil passen und so weder über- noch unterfordert sind. Wenn die Möglichkeit besteht, ist interne Qualifikation externer Unterstützung vorzuziehen. Der entscheidende Vorteil liegt darin, dass die Mitarbeiter aus der eigenen Domäne die Daten, Prozesse und Produkte des Unternehmens bereits kennen. Externe Experten müssen sich dieses Wissen erst erarbeiten.

Zusammenfassend kann gesagt werden, dass die Qualifikation der Mitarbeiter eine Schlüsselrolle bei der Einführung von KI im Qualiätsbereich darstellt. Die Qualifikation der Mitarbeiter bestimmt die Anwendungsfälle, die bearbeitet werden können. Aus diesem Grund müssen Qualifikationsmaßnahmen und die Projektplanung für den Einsatz von KI auf einander abgestimmt sein. Die beigestellten Tabellen liefern Richtwerte für gängige Anwendungsfälle und erlauben es Führungskräften, die richtigen Prioritäten bei der Einführung von KI zu setzen.

Lesen Sie auch die beiden anderen Teile der Reihe “Künstliche Intelligenz in der Qualität“:

- Teil 1: Künstliche Intelligenz in der Qualität – Bestehendes Know-how effektiv nutzen – zum Beitrag »

- Teil 3: Künstliche Intelligenz in der Qualität – Praktische Einführung durch iteratives Vorgehen – zum Beitrag »

Über die Autoren:

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Künstliche Intelligenz. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten. Kontakt: ki@prophet-analytics.de

Dipl.-Ing. Waldemar Fahrenbruch ist Head of Q-Technology Division E-Mobility bei der ZF Friedrichshafen AG. Er ist verantwortlich für die Qualitätskostensenkung bei gleichzeitiger Optimierung von Qualitätskonzepten in den Werken der Division E (TCU, Power Electronics und E-Motoren Fertigung) durch Methodenkompetenz der Qualität, künstlicher Intelligenz und digitaler Transformation.

Fahrenbruch, Waldemar, Prorok Stefan. „Künstliche Intelligenz in der Qualität – Bestehendes Know-how effektiv nutzen“ https://www.dgq.de/fachbeitraege/kuenstliche-intelligenz-in-der-qualitaet-bestehendes-know-how-effektiv-nutzen/

Mumtarin, Maroa, Md Samiullah Chowdhury, and Jonathan Wood. “Large Language Models in Analyzing Crash Narratives–A Comparative Study of ChatGPT, BARD and GPT-4.” arXiv preprint arXiv:2308.13563 (2023).

Zhang, Yongfeng, et al. “Learning over knowledge-base embeddings for recommendation.” arXiv preprint arXiv:1803.06540 (2018).

Bach, Benjamin, et al. “Challenges and opportunities in data visualization education: A call to action.” IEEE Transactions on visualization and computer graphics (2023).

Agresti, Alan, and Maria Kateri. Foundations of statistics for data scientists: with R and Python. CRC Press, 2021.

Prorok, Stefan „Machine Learning in der Produktion – Warum die digitale Revolution anders aussieht, als gedacht.“ https://prophet-analytics.de/whitepapers/stat_models.pdf

Künstliche Intelligenz in der Qualität – Bestehendes Know-how effektiv nutzen

Viele Branchen sind heute mit stetig steigenden Qualitätsanforderungen konfrontiert. Zusätzlich erfordern komplexere Produkte erweiterte Absicherungen im Herstellungsprozess. Gleichzeitig stehen viele Hersteller vor der Herausforderung, Kostenoptimierungen umzusetzen, um langfristig wirtschaftlich zu bleiben. Wie kann Qualität diesen Spagat schaffen?

Neue Methoden im Bereich der künstlichen Intelligenz (KI), insbesondere des Machine Learnings bieten Möglichkeiten, um Verbesserungspotenziale auf Basis bestehender Daten zu heben. Besonders bei komplexen Produktionsabläufen kann Machine Learning zu neuen Erkenntnissen führen. Für Praktiker stellt sich allerdings die Frage, wie sich neue Methoden sinnvoll in bestehende Arbeitsabläufe integrieren lassen.

Dieser Beitrag zeigt auf, dass es große Überschneidungen zwischen klassischen Q-Werkzeugen und modernen KI Methoden gibt. Machine Learning, als Unterdisziplin der KI, wird den Methodenkoffer der Qualität langfristig erweitern. Der Beitrag nennt darüber hinaus Erfolgsfaktoren für Mitarbeiter und Führungskräfte, die Machine Learning in ihrer Firma einsetzen wollen, um ihre Prozesse effizienter zu gestalten.

Machine Learning als Prozess und Methode

Der Einstieg in den Bereich des Machine Learnings gestaltet sich in der Qualität wesentlich einfacher als in anderen Ressorts. In Abbildung 1 ist ein Vergleich der Methoden des PDCA-Zyklus, der Six Sigma DMAIC Methode und der IBM Data Science Methode dargestellt. Die Abbildung zeigt die Parallelen der Ansätze.

Alle drei Methoden verfolgen das gleiche Ziel: Nachhaltige Lösung eines bestimmten Problems.

Machine Learning und klassische Qualitätswerkzeuge basieren grundsätzlich auf Methoden der Statistik (induktive, deskriptive und explorative Statistik). Hier zeigen sich ebenfalls große Überschneidungen zwischen den beiden Ansätzen. Somit ist das Grundwissen für Machine Learning in vielen Qualitätsbereichen bereits vorhanden.

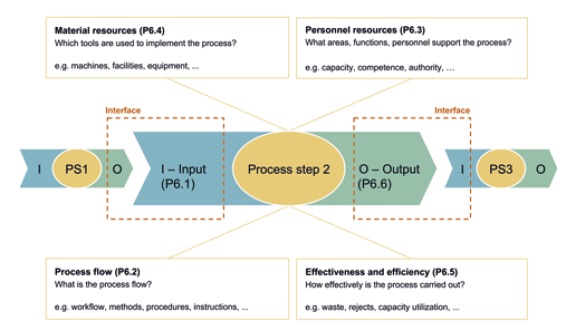

Auch prozessseitig gibt es große Parallelen zwischen KI-Projekten und dem klassischen Qualitätswesen. KI-Anwendungen lassen sich durch das Turtle Modell beschreiben (vergleiche Abbildung 2). In diesem Fall liegt der Fokus auf Dateneingabe, Verarbeitung mit Generierung der wertschöpfenden Informationen und Datenausgabe. Der Ansatz ist jedoch gleich.

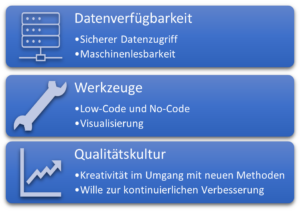

Was bleibt ist die Frage, wie eine gute Umsetzungsstrategie aussehen kann, um die neuen Machine Learning Werkzeuge im Unternehmen einzuführen. Eine der größten Hürden bei der Nutzung von Machine Learning besteht darin, Daten in geeigneter Art und Weise für die Mitarbeiter bereitzustellen. Hierbei kommt den Führungskräften eine Schlüsselrolle zu.

Datenverfügbarkeit und Dokumentation

Führungskräfte haben großen Einfluss darauf, wie und in welcher Form Daten abgelegt werden. Es gilt darauf achten, dass von vornherein möglichst nur maschinenlesbare Daten erzeugt werden.

Folgende Prinzipien helfen dabei, dieses Ziel zu erreichen:

- Standardisierung der Daten mit einem einheitlichen Datenmodell

- Nutzung von Datenbanken als Datenablage

- Wenn keine Datenbank verwendet werden, sind einfach interpretierbare Dateiformate (z.B. csv oder xml) sinnvoll

- Für Prozessdokumentation sollten feste Formulare mit möglichst wenig Freitext gewählt werden.

Die zweite Aufgabe für Führungskräfte besteht darin die Daten verfügbar zu machen. Es müssen Schnittstellen geschaffen werden, über die die Mitarbeiter sicher auf Daten zugreifen können. Dabei muss sichergestellt sein, dass eine fehlerhafte Abfrage nicht zu ungewolltem Datenverlust führen kann. Dies ermöglicht einen spielerischen Umgang mit Daten ohne Risiko. Anschließend sind die Mitarbeiter an der Reihe diese Daten gewinnbringend zu nutzen.

Auswahl geeigneter Anwendungen

Eine wichtige Aufgabe der Qualität war es seit jeher Transparenz zu schaffen und Optimierungspotenziale aufzudecken. Diese Aufgabe wird im Datenzeitalter noch wichtiger. Der Umgang mit Daten wird in Zukunft eine grundlegende Anforderung an Mitarbeiter im Qualitätswesen sein. Es ist jedoch nicht realistisch, alle Qualitätsmitarbeiter auf das Qualifikationsniveau von Datenspezialisten zu heben. Dies ist aber auch nicht nötig. Der Schlüssel zum Erfolg liegt in einer geeigneten Auswahl von Softwarewerkzeugen.

No-Code/Low-Code Lösungen, wie KNIME oder Tableau, bieten einfache Möglichkeiten, die Einstiegsschwelle für Mitarbeiter zu senken und schnellen Mehrwert zu schaffen. Grafische Visualisierungen und Dashboards stellen dabei einen guten Einstieg in die Welt des Machine Learnings dar. Dashboards können beispielswese gleichzeitig Auskunft über verschiedene Kennzahlen (z.B. Stillstandszeiten, OEE oder Ausschuss) geben und lassen sich gut in tägliche Shopfloormeetings einbinden. Es werden keine Programmierkenntnisse benötigt, um einfache Dashboards zu erstellen. Die Anleitungen sind meist frei im Internet verfügbar und viele Werkzeuge können kostenlos verwendet werden. Entscheidend für den erfolgreichen Einsatz von Dashboards ist, dass die Daten nicht mehr von Hand eingepflegt werden. So können die Mitarbeiter sich auf die Lösung der Probleme konzentrieren. Dies erhöht die Akzeptanz und motiviert die Mitarbeiter nach weiteren Anwendungen zu suchen. Der Übergang zum tatsächlichen Machine Learning (zum Beispiel durch Erweiterung von Dashboards für Klassifikation und Prognosen) ist fließend.

Ein weiteres Themenfeld für einen einfachen Einstieg sind Sprachmodelle. KI-Werkzeuge wie ChatGPT können Daten und Texte schnell zusammenfassen oder Fragen zu den Eingangsdaten beantworten. Sprachmodelle benötigen ebenfalls keine Programmiererfahrung und eignen sich hervorragend für Einsteiger. Interessant sind Sprachmodelle auch deshalb, weil sie sich einfach anpassen und mit anderen Systemen verknüpfen lassen (zum Beispiel automatische Terminbuchungen im Kalender oder Erfassung von Kundenreklamationen). Folgender Link zeigt ein angepasstes Sprachmodell, welches Fragen zu ISO 9001 oder IATF 16949 beantwortet. Sprachmodelle und Datenverarbeitung werden in den nächsten Jahren noch sehr viel enger zusammenwachsen. Beispiele hierfür sind Copilotfunktionen, die den Benutzer bei seiner Arbeit unterstützen und für Microsoft Windows und Office bereits erprobt werden.

Was die Zukunft bringt

Wir gehen davon aus, dass Programmierkenntnisse durch weitere Verbreitung von Copiloten und Low-Code/No-Code Werkzeugen an Bedeutung verlieren werden. Machine Learning wird damit für mehr Mitarbeiter ohne Programmierkenntnisse einsetzbar.

Im Zuge dieser Entwicklung werden immer mehr Methoden des Machine Learnings (Clustern, Klassifikation, Regression oder Prognosen auf Basis von Modellen) in den Methodenkoffer des Qualitätswesens integriert werden. Die grundlegende Arbeitsweise des Qualiätswesens nach PDCA und DMAIC bleibt dabei erhalten. Die neuen Werkzeuge aus dem Bereich Machine Learning versprechen schnellere Problemlösung und hohe Transparenz. Mitarbeiter, die heute noch händisch Daten erfassen und verarbeiten, werden entlastet und können so weitere Verbesserungen für das Unternehmen erzielen.

Unternehmen können diese Entwicklung aktiv fördern, indem sie die Datenqualität und Datenverfügbarkeit verbessern (siehe Abbildung 3). Mitarbeiter sollten spielerisch an Datenverarbeitung und Machine Learning herangeführt werden und ihre intrinsische Motivation sollte durch geeignete Schulungen aktiv unterstützt werden. Der Fokus für Qualifikation sollte dabei darauf liegen die Methoden des Machine Learnings zu kennen und diese Methoden mittels Low Code / No Code Lösungen im Unternehmenskontext einzusetzen.

Lesen Sie auch die beiden anderen Teile der Reihe “Künstliche Intelligenz in der Qualität“:

- Teil 2: Künstliche Intelligenz in der Qualität – Welche Qualifikationen werden benötigt? – zum Beitrag »

- Teil 3: Künstliche Intelligenz in der Qualität – Praktische Einführung durch iteratives Vorgehen – zum Beitrag »

Über die Autoren:

Dipl.-Ing. Waldemar Fahrenbruch ist Head of Q-Technology Division E-Mobility bei der ZF Friedrichshafen AG. Er ist verantwortlich für die Qualitätskostensenkung bei gleichzeitiger Optimierung von Qualitätskonzepten in den Werken der Division E (TCU, Power Electronics und E-Motoren Fertigung) durch Methodenkompetenz der Qualität, künstlicher Intelligenz und digitaler Transformation.

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Künstliche Intelligenz. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten. Kontakt: ki@prophet-analytics.de

Rollins, John. “Why we need a methodology for data science.”, IBM Analytics Whitepaper (2015). https://tdwi.org/~/media/64511A895D86457E964174EDC5C4C7B1.PDF

Al-Sai, Zaher Ali, Rosni Abdullah, and Mohd Heikal Husin. “Critical success factors for big data: a systematic literature review.” IEEE Access 8 (2020): 118940-118956.

Ahmad, Norita, and Areeba Hamid. “Will Data Science Outrun the Data Scientist?.” Computer 56.2 (2023): 121-128.

https://www.knime.com/blog/anomaly-detection-predictive-maintenance-control-chart

https://prophet-analytics.de/norma_ai/

Wertstromanalyse: Ein effizientes Instrument zur Prozessoptimierung

Die Wertstromanalyse, ein beeindruckendes Werkzeug aus dem Repertoire des Lean Managements, hat ihre Wurzeln in der Automobilindustrie. Ihr Hauptzweck besteht darin, Material- und Informationsflüsse in komplexen Produktionsprozessen sichtbar und begreiflich zu machen.

Das Potenzial der Wertstromanalyse reicht jedoch weit darüber hinaus. Sie visualisiert die einzelnen Phasen eines Produktionsprozesses und verdeutlicht somit Interaktionen, Abhängigkeiten und Flussdynamiken. Dadurch können Anwender Verschwendung, Engpässe und ineffiziente Abläufe aufspüren. Durch die konsequente Ausrichtung auf Verschwendungsminimierung, einen Grundpfeiler des Lean Managements, ermöglicht sie eine systematische und datengetriebene Basis für fortlaufende Verbesserungen und Effizienzsteigerungen. Daher kann die Wertstromanalyse dazu beitragen, die Leistung zu erhöhen, Kosten zu reduzieren und die Zufriedenheit von Kunden und Mitarbeitern zu verbessern.

Dieser Fachbeitrag soll das Verständnis von dieser Methode vertiefen. Er beleuchtet die Anwendung und Vorteile der Wertstromanalyse und gibt wertvolle Hinweise für ihren Einsatz. Ziel ist es, aufzuzeigen, wie Qualitätsmanager und Co. dieses Werkzeug nutzen können, um ihre Prozesseffizienz zu erhöhen.

Wie läuft eine Wertstromanalyse ab?

Die Wertstromanalyse ist ein hilfreiches Mittel, um den komplexen Produktionsprozess innerhalb eines Unternehmens umfassend darzustellen. Sie verfolgt Material und Informationen auf ihrem Weg durch den Produktionsprozess und visualisiert dabei alle Aktivitäten – wertschöpfende und nicht-wertschöpfende. Dabei wird der ‘Wertstrom’ auf zwei Ebenen betrachtet: der steuernde Informationsfluss und der Materialfluss selbst.

Kernkonzepte und verwendete Symbole

Zu den Hauptelementen der Wertstromanalyse gehören die Erkennung wertschöpfender und nicht-wertschöpfender Aktivitäten, die Analyse der Durchlaufzeit und die Identifizierung von Produktionsengpässen.

Wie vorgehen?

Die Durchführung der Wertstromanalyse folgt mehreren hilfreichen Schritten. Diese Schritte unterstützen das Verständnis der Prozesse und Produktion und helfen bei der Identifizierung von Verbesserungsmöglichkeiten. Hier sind die grundlegenden Schritte:

- Auswahl des Produkts oder der Produktfamilie:

Die Wertstromanalyse konzentriert sich oft auf eine spezifische Produktfamilie oder einen Prozess. - Bestimmung des Anfangs- und Endpunkts des Wertstroms:

Dies könnte etwa den gesamten Prozess von der Materialbeschaffung bis zum Versand des Endprodukts umfassen. - Erstellung des Ist-Zustands:

Dokumentieren Sie den aktuellen Prozess mit allen relevanten Aktivitäten, Durchlaufzeiten, Wartezeiten und Lagerbeständen. - Identifizierung von Verschwendung:

Suchen Sie nach Aktivitäten, die keinen Wert hinzufügen, zum Beispiel Wartezeiten, Überproduktion, übermäßige Bewegungen usw. - Entwicklung des Soll-Zustands:

Entwerfen Sie einen idealen Zustand, in dem Verschwendung minimiert wird. - Erstellung eines Maßnahmenplans:

Bestimmen Sie die Schritte, die notwendig sind, um vom Ist- zum Soll-Zustand zu gelangen.

Welche Vor- und Nachteile bietet die Wertstromanalyse?

Vorteile:

- Transparenz:

Die Wertstromanalyse visualisiert den Material- und Informationsfluss und schafft damit Transparenz in den Prozessen. - Identifizierung von Verschwendung:

Durch die transparente Darstellung werden Engpässe, Verschwendung und Ineffizienzen sichtbar und können gezielt angegangen werden. - Strukturierte Herangehensweise:

Die Methode bietet einen systematischen Ansatz zur Prozessverbesserung, der von der Identifikation des Ist-Zustands über die Entwicklung des Soll-Zustands bis zur Umsetzung reicht. - Steigerung der Produktivität:

Die Identifikation und Reduzierung von Verschwendung führt zu einer erhöhten Produktivität. - Kostenreduktion:

Durch die Optimierung der Prozesse können Kosten gesenkt werden. - Verkürzung der Durchlaufzeiten:

Effizientere Prozesse führen in der Regel zu kürzeren Durchlaufzeiten.

Nachteile:

- Komplexität:

Komplexe Prozesse mit vielen Abhängigkeiten können schwer darzustellen und zu analysieren sein. - Zeitaufwändig: