Der neue VDA 6.3:2023 Fragenkatalog – praktische Betrachtungsweise

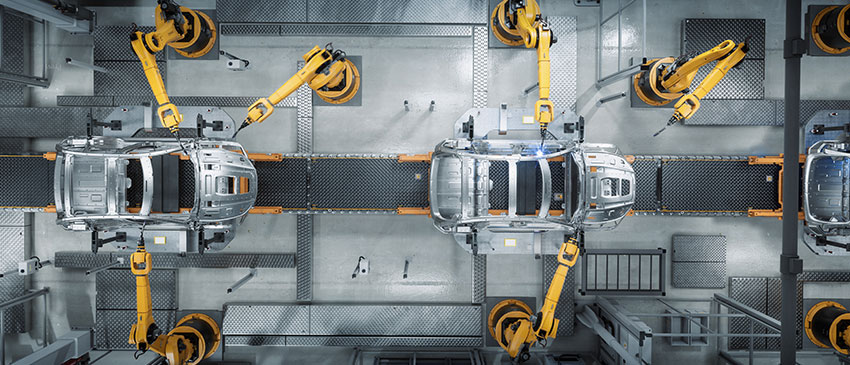

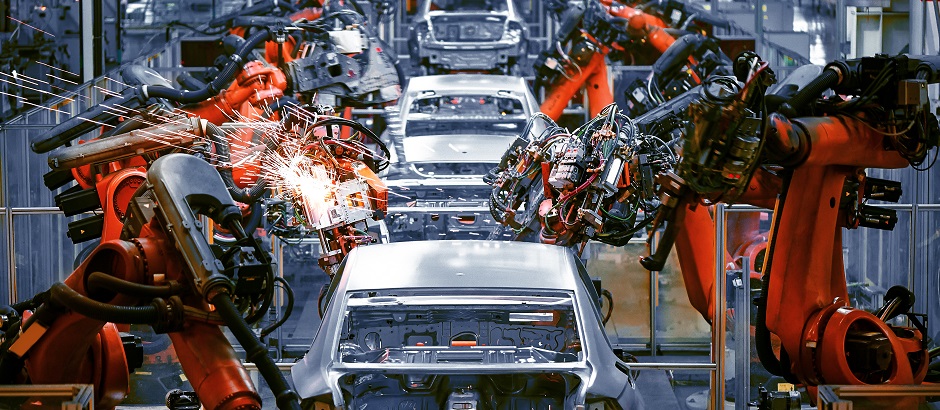

In einer zunehmend globalisierten Welt ist die Effizienz und Zuverlässigkeit der Lieferkette für Unternehmen von entscheidender Bedeutung. Angesichts der wachsenden Unsicherheit und der Vielzahl von Risiken, denen das produzierende Gewerbe ausgesetzt ist, gewinnen Prozessaudits hauptsächlich in der Lieferantenentwicklung eine immer größere Bedeutung.

In diesem Artikel diskutieren wir über die Neuerungen und praktischen Erfahrungen des neuen VDA 6.3: 2023 Fragenkataloges für Prozessaudits, des VDA QMC, der als einer der wichtigsten Standards für die Auditierung von Prozessen in der Automobilindustrie gilt.

Hintergrund und aktuelle Situation

Mit dem neuen Fragenkatalog für Prozessauditoren hat es der VDA QMC geschafft, dass Prozessaudits den aktuellen Anforderungen und Entwicklungen in der Industrie gerecht werden. Durch die Berücksichtigung von Aspekten wie dem Stand der Technik in der Produktionstechnologie, der gestiegenen Softwareanforderungen in Produkten und Prozessen und der immer wichtiger werdenden Stabilität in der Lieferkette wird der Fragenkatalog relevanter und effektiver für Unternehmen aller Branchen.

Hauptunterschiede zum VDA 6.3:2016

Der neue Fragenkatalog zeichnet sich durch einige wesentliche Änderungen gegenüber der Version 2016 aus:

- Stärkerer Fokus auf Risikomanagement:

Der Katalog legt nun ein höheres Augenmerk auf die Implementierung eines effektiven Risikomanagementsystems. - Einbeziehung von Softwareaspekten:

Software-bezogene Fragestellungen wurden in den Katalog integriert, um die Bedeutung von Software in der Automobilindustrie widerzuspiegeln. - Fokus auf Beschaffungsaktivitäten:

Die Aktivitäten aus der Beschaffung finden jetzt einen erhöhten Fokus bereits in der Planungsphase des Projektes. - Anpassung der Bewertung der Potenzialanalyse:

Die Bewertungssystematik der Potenzialanalyse wurde verschärft und die Fragen teilweise neu strukturiert, um eine klarere Bewertung der Verbesserungspotenziale zu ermöglichen. - Neuzuordnung der Stern-Fragen:

Die Stern-Fragen (mit “*”, gekennzeichnet) wurden teilweise neu zugeordnet, um die Relevanz für verschiedene Unternehmensbereiche zu verbessern.

Auswirkungen auf die Auditpraxis

Die Einführung des neuen VDA 6.3:2023-Fragenkatalogs markiert einen bedeutenden Wendepunkt in der Auditpraxis, der sich in vielfältigen Veränderungen niederschlägt. Diejenigen, die täglich mit Audits zu tun haben, werden diese Veränderungen spüren.

Ein erhöhter Zeitaufwand für die Vorbereitung ist eine der ersten sichtbaren Auswirkungen. Auditoren sind nun gefordert, sich intensiv mit den neuen Inhalten und der veränderten Struktur des Katalogs auseinanderzusetzen. Eine gründliche Einarbeitung ist unerlässlich und führt zwangsläufig zu einem gesteigerten Zeitaufwand für die Vorbereitung auf ein Audit. Zumindest in der ersten Zeit der Anwendung des neuen Kataloges.

Die Anpassung der Auditmethoden ist eine weitere Herausforderung, der sich Auditoren stellen müssen. Die neuen Fragestellungen im Katalog erfordern teilweise eine Überarbeitung der bisherigen Methoden und Werkzeuge. Themen wie Risikomanagement und Softwareentwicklung rücken verstärkt in den Fokus und verlangen nach entsprechenden Anpassungen, um die geforderten Inhalte umfassend abdecken zu können.

Besonders hervorzuheben ist die Notwendigkeit tieferer Kenntnisse im Bereich Software. Der neue Katalog integriert nun auch softwarebezogene Fragestellungen, die von den Auditoren ein grundlegendes Verständnis von Softwareentwicklungsprozessen und -risiken erfordern. Dies stellt für einige Auditoren eine neue Herausforderung dar. Sie müssen sich in diesem Bereich weiterbilden, um die Fragen kompetent beantworten zu können.

Erste Erfahrungen mit dem neuen Katalog

Aus den ersten Erfahrungen, die mit dem neuen VDA 6.3 Katalog gemacht wurden, lassen sich folgende Beobachtungen festhalten:

Das Feedback der auditierten Unternehmen ist größtenteils positiv. Sie erkennen den Wert der vertieften Betrachtung der bereits erwähnten Themen im neuen Katalog. Diese Erweiterungen werden als bedeutender Schritt zur ganzheitlicheren Bewertung der Unternehmensprozesse wahrgenommen.

Allerdings gibt es auch Herausforderungen, insbesondere im Bereich der Software-Thematik. Für einige Unternehmen stellen die softwarebezogenen Fragen noch eine Hürde dar, da hier oft ein ausreichendes Know-how fehlt. Dies unterstreicht die Notwendigkeit, verstärkt in die Weiterbildung auf diesem Gebiet zu investieren, um den neuen Anforderungen gerecht zu werden.

Positive Rückmeldung erhielt ich zur verstärkten Betrachtungsweise im Bereich Beschaffung. Anstatt erst auf eingetretene Probleme zu reagieren, liegt der Fokus im Fragenkatalog beim proaktiven Risikomanagement auf der Identifizierung und Bewertung potenzieller Risiken bei Lieferanten und Unterlieferanten bereits in der Frühphase eines Projekts. Dies ermöglicht es, präventive Maßnahmen zu ergreifen und so die negativen Auswirkungen von Lieferkettenunterbrechungen, Verzögerungen oder Qualitätsmängeln zu minimieren.

Insgesamt spiegeln die ersten Erfahrungen mit dem neuen Katalog eine Mischung aus Anerkennung für die Weiterentwicklung und Bereitschaft zur Überwindung von Herausforderungen wider. Die Erkenntnisse aus diesen ersten Audits dienen als wichtige Grundlage für die Optimierung und Feinabstimmung des Katalogs in der Zukunft.

Fazit

Der neue VDA 6.3:2023 Fragenkatalog stellt eine sinnvolle Weiterentwicklung des bewährten Standards dar. Die stärkere Fokussierung auf Risikomanagement, die Einbeziehung von Softwareaspekten und Beschaffungsaktivitäten und die verschärfte Bewertungssystematik der Potenzialanalyse tragen zu einer umfassenderen und zielgerichteteren Bewertung von Unternehmensprozessen in der Gegenwart und Zukunft bei.

Über den Autor:

Stefan Peintner ist ein international erfahrener Berater und betreut weltweit strategisch relevante Start-Up-Projekte im Bereich der Elektromobilität. Darüber hinaus unterstützt er als Executive Coach mittelständische Organisationen in Organisationsentwicklungsprojekten und begleitet diese im nationalen und internationalen Standortaufbau.

Kontinuierliche Eignung von Prüfprozessen nach VDA Band 5 – Hintergrund und praktische Umsetzung

Die Neuauflage des VDA Band 5 aus dem Jahr 2021 enthält eine Vielzahl von Neuerungen, die für Unternehmen im Automobilbereich in Zukunft wichtig werden. Eine der wichtigsten Neuerungen stellt die Forderung eines fortlaufenden Eignungsnachweises für kritische Prüfprozesse dar. Dieser Fachbeitrag erklärt die technischen und normativen Hintergründe der Anforderung und stellt konkrete Umsetzungsmöglichkeiten dar.

Die ISO 9001:2015 definiert Begriffe für die korrekte Funktion von Prüfmitteln. Grundsätzlich müssen im Kontext der ISO 9001:2015 zu jedem Zeitpunkt Eignung und Rückführbarkeit von Prüfmitteln sichergestellt sein. Diese beiden Anforderungen finden sich in vergleichbarer Form in Automobilspezifischen Normen wie der IATF 16949 oder dem VDA Band 5 wieder. Der VDA Band 5 beschreibt unter anderem, wie Eignung und Rückführbarkeit statistisch nachgewiesen werden können. Die Nachweispflicht gilt für alle Sensoren, Messgeräte und sonstige Hilfsmittel, bei denen eine Kundenspezifikation abgeprüft wird.

Um zu verstehen, was der VDA Band 5 unter einem fortlaufenden Eignungsnachweis versteht, ist es hilfreich zu veranschaulichen was die beiden Begriffe Rückführbarkeit und Eignung bedeuten:

| Begriffsdefinition Rückführbarkeit Rückführbarkeit stellt sicher, dass Messungen verschiedener Messmittel untereinander vergleichbar sind. So ist z.B. sichergestellt, dass Kunden und Lieferanten bei Messungen an Produkten zu gleichen Ergebnissen kommen. Die Vergleichbarkeit wird durch regelmäßige Kalibrierung sichergestellt. Das Kalibrierergebnis setzt sich aus Kalibrierabweichung und Kalibrierunsicherheit zusammen. Aus dem Kalibrierergebnis lässt sich eine Obergrenze für den systematischen Messfehler ableiten. Kalibrierung findet in regelmäßigen Intervallen und unter kontrollierten Bedingungen außerhalb des laufenden Produktionsprozesses statt. |

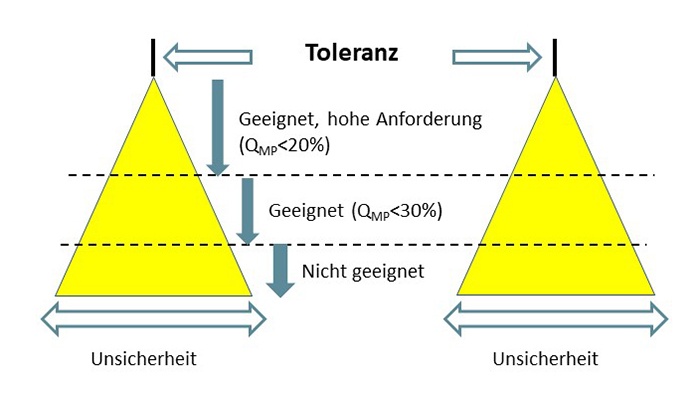

| Begriffsdefinition Eignung Eignung beschreibt die Unsicherheit einer Messung im Verhältnis zu einer gegebenen Toleranz (z.B. ein Zeichnungsmaß). Je kleiner die Unsicherheit einer Messung im Verhältnis zur Toleranz, desto höher ist die Eignung eines Messmittels für eine gegebene Prüfaufgabe. Abbildung 1 stellt den Sachverhalt grafisch dar. Wichtig ist, dass ein Eignungsnachweis immer unter Berücksichtigung der realen Anwendungsbedingungen geführt werden muss. Alle Einflussfaktoren, die im Serienprüfprozess wirksam sind, müssen auch im Eignungsnachweis berücksichtigt werden. Der systematische Messfehler aus der Kalibrierung ist somit einer von mehreren Einflussfaktoren, die zur Messunsicherheit beitragen. |

Abb. 1: Schematische Darstellung von Eignung nach VDA Band 5. Der gelb hinterlegte Bereich stellt den Unsicherheitsbereich der Messung dar.

Sicherstellung der fortlaufenden Eignung eines Prüfsystems

Bisher war es in vielen Firmen gelebte Praxis, den Eignungsnachweis einmalig bei der Inbetriebnahme oder nach größeren Änderungen durchzuführen. Die korrekte Funktion des Prüfmittels wurde lediglich über die regelmäßige Kalibrierung abgesichert. Dahinter steckt die Annahme, dass sich die Messunsicherheit eines Prüfmittels während des Betriebes nicht nennenswert verändert. Aus technischer Sicht ist dies jedoch eine gewagte Annahme. In vielen Messprozessen wird die Unsicherheit stark von äußeren Einflüssen bestimmt. Maschinen und Messaufnahmen und elektrische Kontaktierungen unterliegen beispielsweise dem Verschleiß, der über die Zeit hinweg zu einer höheren Messunsicherheit führen kann. Viele dieser äußeren Einflüsse auf die Messunsicherheit bleiben bei der regelmäßigen Kalibrierung jedoch unsichtbar.

An dieser Stelle setzt der neue VDA Band 5 an. In Kapitel 10 über die fortlaufende Eignung steht geschrieben: “Die Beurteilung der fortlaufenden Eignung, bislang oft auch als Stabilitätsüberwachung oder Messbeständigkeit genannt, hat aufgrund der Normenanforderung in der ISO 9001 an Bedeutung gewonnen.” Und weiter: “Die regelmäßige Kalibrierung der Messmittel ist im Rahmen der Prozesse zur Prüfmittelüberwachung unumgänglich (siehe Kapitel 4.5.2), reicht aber in vielen Fällen für eine umfassende Stabilitätsüberwachung nicht aus, da die Kalibrierung nicht unter tatsächlichen Einsatzgegebenheiten durchgeführt wird.”

Der VDA Band 5 stellt somit deutlich heraus, dass nicht alle Einflussfaktoren auf die Messunsicherheit durch Kalibrierung abgesichert werden können. Aus diesem Grund reicht die regemäßige Kalibrierung allein nicht aus, um fortlaufende Eignung eines Prüfsystems nachzuweisen.

Da Eignungsnachweise in der Regel mit erheblichem Aufwand verbunden sind, stellt sich die Frage, für welche Prüfprozesse ein fortlaufender Eignungsnachweis erforderlich ist. Der VDA Band 5 fordert insbesondere für sicherheitskritische und zulassungskritische Merkmale Absicherungsmaßnahmen, um die fortlaufende Eignung von Prüfprozessen sicherzustellen. In verringertem Umfang gilt diese Anforderung auch für Prüfungen von funktionswichtigen Merkmalen und Messungen, die direkten Einfluss auf die Produktqualität haben.

Praktische Umsetzung des kontinuierlichen Eignungsnachweises

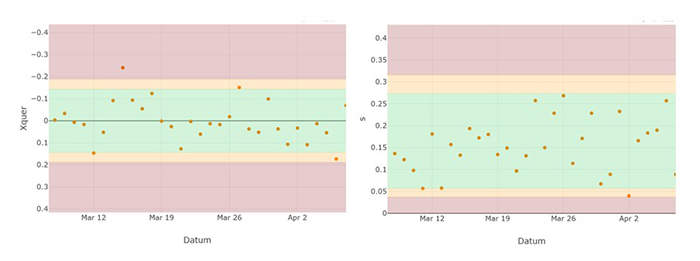

Neben der Frage, für welche Prüfprozesse fortlaufende Eignung gefordert ist, ist die praktische Umsetzung eines solchen kontinuierlichen Eignungsnachweises besonders wichtig. Der zusätzliche Aufwand, der durch den kontinuierlichen Eignungsnachweis entsteht, sollte dabei so gering wie möglich ausfallen. Der VDA Band 5 schlägt zur praktischen Umsetzung einer fortlaufenden Eignungsprüfung den Einsatz von Regelkarten vor. Um die Daten für die Regelkarte zu erheben, werden regelmäßig ein oder mehrere Meisterteile geprüft und die Messwerte erfasst. Die Meisterteile sollten in sich stabil sein und ihre Messwerte über die Zeit hinweg möglichst wenig ändern. Auf diesem Weg kann die Stabilität eines Messprozesses in Bezug auf Lage und Streuung überwacht werden. Häufigkeit und Umfang der Prüfung werden auf Basis des Risikos festgelegt. Im VDA Band 5 werden als Beispiel klassische x ̅-s Karten mit einer Eingriffsgrenze von drei Standardabweichungen (99,73% Vertrauensniveau) oder gleitende Mittelwertkarten vorgeschlagen.

Abbildung 2 zeigt eine Regelkarte mit x ̅- und s-Spur, die zur Stabilitätsüberwachung eingesetzt werden kann. Der Nachteil der Regelkartentechnik besteht im beträchtlichen zeitlichen Aufwand. Prüfstände für komplexe Produkte wie Steuergeräte oder Getriebe haben hunderte von Prüfungen. Selbst wenn nur ein Teil der Messungen für die fortlaufende Eignung ausgewählt wird, kommen auf diese Art schnell dutzende Regelkarten zusammen.

Abb. 2: Zweispurige Stabilitätskarte zur Überwachung von Lage und Streuung eines Messprozesses. Die Eingriffsgrenzen sind rot gekennzeichnet. Zur besseren Orientierung wurden zusätzlich auch die Warngrenzen in Gelb dargestellt.

Automatische Überwachung von Prüfprozessen mittels Softwarelösung

Eine digitale Auswertung von Messdaten kann den zeitlichen Aufwand für den kontinuierlichen Eignungsnachweis erheblich reduzieren. Prophet Analytics bietet eine Softwarelösung, die Prüfprozesse automatisch überwacht und bei Abweichungen Benachrichtigungen erzeugt. So ist es nicht länger notwendig, jede Regelkarte manuell zu führen und zu bewerten. Verletzungen von Eingriffs- und Warngrenzen können über automatische Benachrichtigungen gelenkt werden.

Obwohl die Regelkartentechnik das Risiko fehlerhafter Messungen deutlich verringert, erlaubt dieser Ansatz streng genommen keine fortlaufende Eignungsprüfung. Regelkarten basieren grundsätzlich auf Stichprobenprüfungen und geben somit immer nur eine Momentaufnahme wieder. Einflussfaktoren, die nur sporadisch wirksam sind, können durch Regelkarten nicht zuverlässig überwacht werden. Ein zweiter Nachteil der Regelkartentechnik ist die Tatsache, dass das Einlegen der Meisterteile in der Regel einen Eingriff in den normalen Produktionsprozess bedeutet. In Produktionsanlagen und Maschinen, die auf eine kontinuierliche Fertigung ausgelegt sind, ist so ein Eingriff nicht möglich. Beispiele hierfür sind chemische Prozesse oder die Herstellung von Blechen oder Folien.

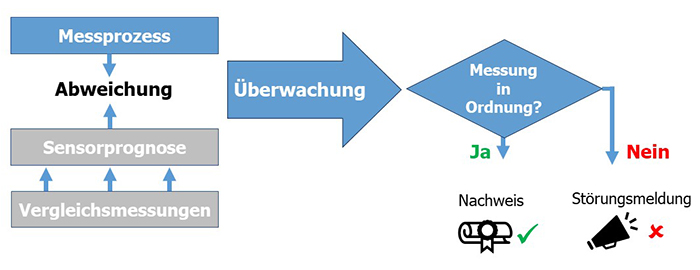

Prophet Analytics bietet auch eine Lösung zur Stabilitätsüberwachung für Maschinen, bei denen keine Meisterteile verwendet werden können. Eine Überwachung von einzelnen Prüfmitteln ist dann möglich, wenn weitere Daten aus unterschiedlichen Quellen verfügbar sind. Abbildung 3 zeigt eine schematische Darstellung des Verfahrens. Das Verfahren nutzt Daten aus Messungen, die von anderen Prüfeinrichtungen erhoben wurden und mit dem zu überwachenden Prüfmittel korreliert sind.

Abb. 3: Schematische Darstellung des Korrelationsverfahrens zur Stabilitätsüberwachung von Messprozessen.

Anwendung des Korrelationsverfahren in der Automobilindustrie

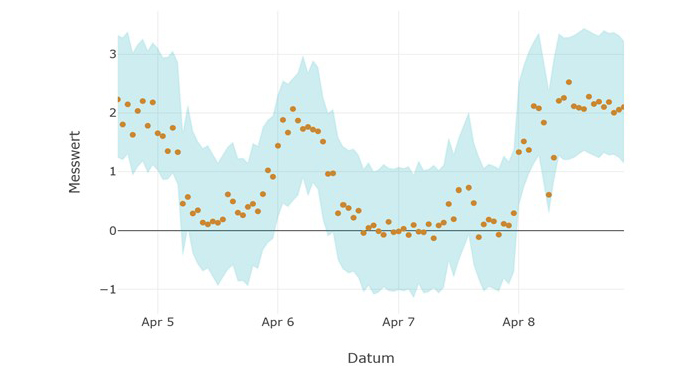

Ein Anwendungsbeispiel für das Korrelationsverfahren ist die Fertigung von Steuergeräten in der Automobilindustrie. Steuergeräte werden häufig mehrfach bei unterschiedlichen Temperaturen geprüft. Die Messwerte an den unterschiedlichen Prüfstationen sind korreliert. Durch Vergleich der Messwerte an den unterschiedlichen Prüfstationen kann eine Prognose für den erwarteten Messwert und ein plausibler Streubereich ermittelt werden. Abbildung 4 zeigt Messungen eines Prüfprozesses und den Zufallsstreubereich der Messung, der mit Hilfe des Korrelationsverfahrens ermittelt wurde. Messwerte außerhalb des blauen Zufallsstreubereichs würden auf eine Fehlfunktion des Messgeräts hindeuten.

Abb. 4: Daten eines Messgeräts (Punkte). Die blau hinterlegte Fläche zeigt Zufallsstreubereich an.

Das Korrelations-Verfahren hat zwei entscheidende Vorteile gegenüber der Regelkartentechnik: Es basiert nicht auf Stichproben und ermöglicht daher je nach Anlagenaufbau bis zu 100 Prozent Überwachung. Außerdem ist das Korrelationsverfahren aufwandsneutral, weil bestehende Daten aus dem laufenden Prozess verwendet werden und kein händischer Prozesseingriff mehr erforderlich ist. Das Korrelationsverfahren und das Regelkartenverfahren lassen sich unabhängig voneinander oder in Kombination anwenden (siehe Beispielanwendung einer Stabilitätsüberwachung).

Fazit

Auf den ersten Blick bedeutet ein kontinuierlicher Eignungsnachweis für Unternehmen mehr Aufwand und mehr Kosten. Diesem Aufwand stehen aber auch Einsparungen gegenüber. Die bessere Absicherung der Prüfprozesse beugt Reklamationen vor. Da die Lage und Streuung von Prüfprozessen mit kontinuierlichem Eignungsnachweis bekannt sind, besteht auch die Möglichkeit Kalibrierintervalle neu zu bewerten und gegebenenfalls zu verlängern. Viele Unternehmen nutzen heute schon eine Kombination aus Stabilitätsüberwachung und Kalibrierung, um Kosten bei der Kalibrierung einzusparen und gleichzeitig ein hohes Maß an Absicherung zu erreichen.

Zusammenfassend kann gesagt werden, dass die Anforderung nach einem kontinuierlichen Eignungsnachweis im neuen VDA Band 5 technisch sinnvoll ist. Die Forderung kann auf grundlegende Anforderungen der ISO 9001:2015 zurückgeführt werden und verbessert die Absicherung von kritischen Prüfprozessen. Der Einsatz moderner Softwarelösungen kann helfen, ein hohes Maß an Absicherung zu erreichen, ohne unnötige händische Eingriffe in den Produktionsprozess vornehmen zu müssen. Der kontinuierliche Eignungsnachweis kann auf diesem Wege nahezu aufwandsneutral gestaltet werden.

Über den Autor:

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Prüfmittel. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten.

Wertstromanalyse: Ein effizientes Instrument zur Prozessoptimierung

Die Wertstromanalyse, ein beeindruckendes Werkzeug aus dem Repertoire des Lean Managements, hat ihre Wurzeln in der Automobilindustrie. Ihr Hauptzweck besteht darin, Material- und Informationsflüsse in komplexen Produktionsprozessen sichtbar und begreiflich zu machen.

Das Potenzial der Wertstromanalyse reicht jedoch weit darüber hinaus. Sie visualisiert die einzelnen Phasen eines Produktionsprozesses und verdeutlicht somit Interaktionen, Abhängigkeiten und Flussdynamiken. Dadurch können Anwender Verschwendung, Engpässe und ineffiziente Abläufe aufspüren. Durch die konsequente Ausrichtung auf Verschwendungsminimierung, einen Grundpfeiler des Lean Managements, ermöglicht sie eine systematische und datengetriebene Basis für fortlaufende Verbesserungen und Effizienzsteigerungen. Daher kann die Wertstromanalyse dazu beitragen, die Leistung zu erhöhen, Kosten zu reduzieren und die Zufriedenheit von Kunden und Mitarbeitern zu verbessern.

Dieser Fachbeitrag soll das Verständnis von dieser Methode vertiefen. Er beleuchtet die Anwendung und Vorteile der Wertstromanalyse und gibt wertvolle Hinweise für ihren Einsatz. Ziel ist es, aufzuzeigen, wie Qualitätsmanager und Co. dieses Werkzeug nutzen können, um ihre Prozesseffizienz zu erhöhen.

Wie läuft eine Wertstromanalyse ab?

Die Wertstromanalyse ist ein hilfreiches Mittel, um den komplexen Produktionsprozess innerhalb eines Unternehmens umfassend darzustellen. Sie verfolgt Material und Informationen auf ihrem Weg durch den Produktionsprozess und visualisiert dabei alle Aktivitäten – wertschöpfende und nicht-wertschöpfende. Dabei wird der ‘Wertstrom’ auf zwei Ebenen betrachtet: der steuernde Informationsfluss und der Materialfluss selbst.

Kernkonzepte und verwendete Symbole

Zu den Hauptelementen der Wertstromanalyse gehören die Erkennung wertschöpfender und nicht-wertschöpfender Aktivitäten, die Analyse der Durchlaufzeit und die Identifizierung von Produktionsengpässen.

Wie vorgehen?

Die Durchführung der Wertstromanalyse folgt mehreren hilfreichen Schritten. Diese Schritte unterstützen das Verständnis der Prozesse und Produktion und helfen bei der Identifizierung von Verbesserungsmöglichkeiten. Hier sind die grundlegenden Schritte:

- Auswahl des Produkts oder der Produktfamilie:

Die Wertstromanalyse konzentriert sich oft auf eine spezifische Produktfamilie oder einen Prozess. - Bestimmung des Anfangs- und Endpunkts des Wertstroms:

Dies könnte etwa den gesamten Prozess von der Materialbeschaffung bis zum Versand des Endprodukts umfassen. - Erstellung des Ist-Zustands:

Dokumentieren Sie den aktuellen Prozess mit allen relevanten Aktivitäten, Durchlaufzeiten, Wartezeiten und Lagerbeständen. - Identifizierung von Verschwendung:

Suchen Sie nach Aktivitäten, die keinen Wert hinzufügen, zum Beispiel Wartezeiten, Überproduktion, übermäßige Bewegungen usw. - Entwicklung des Soll-Zustands:

Entwerfen Sie einen idealen Zustand, in dem Verschwendung minimiert wird. - Erstellung eines Maßnahmenplans:

Bestimmen Sie die Schritte, die notwendig sind, um vom Ist- zum Soll-Zustand zu gelangen.

Welche Vor- und Nachteile bietet die Wertstromanalyse?

Vorteile:

- Transparenz:

Die Wertstromanalyse visualisiert den Material- und Informationsfluss und schafft damit Transparenz in den Prozessen. - Identifizierung von Verschwendung:

Durch die transparente Darstellung werden Engpässe, Verschwendung und Ineffizienzen sichtbar und können gezielt angegangen werden. - Strukturierte Herangehensweise:

Die Methode bietet einen systematischen Ansatz zur Prozessverbesserung, der von der Identifikation des Ist-Zustands über die Entwicklung des Soll-Zustands bis zur Umsetzung reicht. - Steigerung der Produktivität:

Die Identifikation und Reduzierung von Verschwendung führt zu einer erhöhten Produktivität. - Kostenreduktion:

Durch die Optimierung der Prozesse können Kosten gesenkt werden. - Verkürzung der Durchlaufzeiten:

Effizientere Prozesse führen in der Regel zu kürzeren Durchlaufzeiten.

Nachteile:

- Komplexität:

Komplexe Prozesse mit vielen Abhängigkeiten können schwer darzustellen und zu analysieren sein. - Zeitaufwändig:

Eine gründliche Wertstromanalyse erfordert Zeit und Ressourcen, was in einigen Organisationen schwierig umzusetzen sein könnte. - Qualifiziertes Personal:

Es ist notwendig, Mitarbeiter zu haben, die in der Anwendung der Wertstromanalyse geschult sind. - Fehlerhafte Daten:

Die Qualität der Wertstromanalyse ist stark abhängig von der Genauigkeit der verwendeten Daten. - Fehlende Einbindung:

Ohne die aktive Beteiligung aller beteiligten Mitarbeiter kann die Umsetzung der Erkenntnisse aus der Wertstromanalyse schwierig sein. - Fokussiert auf physische Produktion:

Ursprünglich wurde die Methode für die Anwendung in der Fertigung entwickelt. In Bereichen wie der Dienstleistung oder der Softwareentwicklung können Anpassungen notwendig sein. - Gefahr von Oberflächlichkeit:

Ohne ausreichende Tiefe bei der Untersuchung können grundlegende Probleme übersehen werden.

Gibt es praktische Tipps zur Durchführung?

Erfolgreiche Wertstromanalysen hängen nicht nur vom theoretischen Verständnis ab, sondern auch von der Anwendung bewährter Praktiken und Tools. Hier sind einige hilfreiche Tipps:

- Teamarbeit ist entscheidend:

Eine Wertstromanalyse ist eine teambasierte Aufgabe. Die Einbeziehung aller Stakeholder, einschließlich der direkt involvierten Mitarbeiter, ist für den Erfolg unabdingbar. - Fokus auf den Kunden:

Bewahren Sie stets das Ziel der Wertschöpfung für den Kunden im Blick. Jeder Prozessschritt sollte daraufhin geprüft werden, ob er Kundennutzen schafft. - Nicht nur offensichtliche Aspekte berücksichtigen:

Beziehen Sie neben den Hauptprozessen auch unterstützende Prozesse und indirekte Aktivitäten in die Wertstromanalyse ein. - Schritt für Schritt vorgehen:

Starten Sie mit einer groben Analyse und vertiefen Sie in weiteren Iterationen die Details. So behalten Sie den Überblick, ohne sich in Einzelheiten zu verlieren. - Kontinuierliche Verbesserung:

Eine Wertstromanalyse ist nicht nur einmalig hilfreich. Der wahre Wert entsteht durch kontinuierliche Anwendung und Optimierung.

Was bleibt?

In der Rückblende hat sich die Wertstromanalyse als ein essenzielles Werkzeug im Lean-Management erwiesen. Sie hat Unternehmen dabei unterstützt, Material- und Informationsflüsse zu visualisieren, Verschwendung zu identifizieren und die Effizienz zu verbessern. Sie hat sich als flexibel und anpassungsfähig in einer Vielzahl von Umgebungen bewährt, von der Fertigung bis hin zu Dienstleistungen. Dennoch ist ihre effektive Anwendung nicht ohne Herausforderungen, darunter der notwendige Aufwand für die Durchführung der Analyse und die Notwendigkeit einer umfassenden Teamintegration.

Blickt man in die Zukunft, ist die Rolle der Wertstromanalyse noch bedeutsamer. Immer mehr Unternehmen erkennen ihre Vorteile und beginnen, ihre Methoden zu nutzen. Es wird erwartet, dass ihre Relevanz weiter zunehmen wird, da Unternehmen in immer komplexeren und wettbewerbsintensiven Umgebungen agieren müssen. Mit dem richtigen Engagement, effektiver Teamarbeit und einer Mentalität der kontinuierlichen Verbesserung kann die Wertstromanalyse einen entscheidenden Beitrag zur Steigerung der Wettbewerbsfähigkeit von Unternehmen und zur Optimierung ihrer Geschäftsprozesse leisten. Die Zukunft verspricht spannende Entwicklungen für die Wertstromanalyse und ihre Anwendung in der Geschäftswelt.

Autor:

Julian Steiger verfügt über sechs Jahre Erfahrung im Qualitätsmanagement. Bei der DGQ ist er sowohl als Teil des Leitungsteams des Regionalkreises Köln-Bonn als auch im Leitungsteam der QM-Youngsters ehrenamtlich tätig. Zu seinen Schwerpunkten zählt, gemeinsam im Team neue Prozesse zu gestalten und Workshops zu moderieren. An der Hochschule Wismar absolvierte Julian Steiger das Masterstudium Quality Management.

Einführung eines standardisierten Prozessaudits zur Überprüfung der Wirksamkeit von Quality Core Tools

Notwendigkeit des Einsatzes von Quality Core Tools

Um den hohen Qualitätsstandards der Branche gerecht zu werden, hat die Automobilindustrie eine Reihe von Werkzeugen und Methoden entwickelt, welche unter dem Begriff „Automotive Core Tools“ zusammengefasst werden. Die Automotive Core Tools sind heute ein erfolgreicher und etablierter Standard im Qualitätsmanagement der Automotiv-Unternehmen und so ist es nicht verwunderlich, dass diese immer häufiger von Non-Automotive-Branchen adaptiert und dort unter dem Begriff „Quality Core Tools“ im Qualitätsmanagement eingesetzt werden.

Auch die BSH Hausgeräte GmbH hat sich bereits vor vielen Jahren entschieden, die Quality Core Tools zu adaptieren, um die Prozesse von der Produktentwicklung, über das gesamte Projektmanagement bis zum Produktionsstart (SOP) zu optimieren. Damit können potenzielle Fehlerquellen frühzeitiger erkannt und behoben, sowie Kosten von Ausschuss und Reklamationen gesenkt werden. Zudem ermöglichen die eingesetzten Methoden eine bessere Steuerung und Überwachung der Prozesse, was zu einer Steigerung der Effizienz und Produktivität führen kann.

Erfordernis identischer Auditorenkompetenzen

Die DIN EN ISO 9001 sieht regelmäßige interne Systemaudits vor, um sicherzustellen, dass das Qualitätsmanagementsystem den Anforderungen der Norm entspricht und Abweichungen, Nichtkonformitäten oder Kundenbeschwerden überprüft und bewertet werden. Diese Systemaudits werden von internen Auditoren durchgeführt, die unabhängig von den auditierten Bereichen sind.

Der PDCA-Zyklus hilft dabei, kontinuierliche Verbesserung in Organisationen zu fördern.

Solche Systemaudits werden in der ISO 9001-zertifizierten BSH Hausgeräte GmbH regelmäßig durchgeführt und auch die Wirksamkeit der eingeführten Quality Core Tools wird dabei überprüft und bewertet.

Da die eingeführten Maßnahmen dabei bisher nur bezogen auf den Produktionsstandort betrachtet wurden, fiel erst bei der ganzheitlichen Auditierung der eingesetzten Quality Core Tools über alle Produktionsstandorte auf, dass die Methoden unterschiedlich umgesetzt und gelebt wurden.

Um die Standorte dabei zu unterstützen, ihre kritischen Prozesse regelmäßig zu überprüfen, ist nicht nur die standardisierte Durchführung von Systemaudits erforderlich. Durch die Einführung von Prozessaudits soll den Standorten auch ein Werkzeug an die Hand gegeben werden, mit dem sie ihre eigenen Prozesse analysieren und verbessern können.

Um ein hohes und vergleichbares Level der Prozessauditaktivitäten über alle Standorte sicherzustellen, müssen die eingesetzten lokalen Auditoren über identische Kompetenzen zu den jeweiligen Methoden verfügen. Sie sollen befähigt sein, die fachlich korrekte Anwendung der Quality Core Tools zu bewerten. Dabei ist die effiziente Herangehensweise während der Audits ein wichtiger Erfolgsfaktor. Dies gewährleistet in unterschiedlichen Auditsituationen eine Vergleichbarkeit der Bewertungen mit dem notwendigen Tiefgang und schafft einen echten Mehrwert für die Organisation.

| Berufsbild Auditor Für die Integrität und Zuverlässigkeit von Unternehmen ist das Einhalten von gesetzlichen, behördlichen und normativen Vorgaben und Anforderungen essenziell. Neben dem Feststellen der Konformität können im Rahmen eines Audits unter anderem bewährte Praktiken erkannt, Lücken identifiziert und Optimierungspotenziale aufgedeckt werden. Auditoren können so einen entscheidenden Beitrag für das Unternehmen leisten und haben gute Karriereaussichten in den verschiedensten Branchen. Antworten auf die wichtigsten Fragen finden Sie in unserem Berufsbild zum Auditor:

|

Praktische Umsetzung

Damit zukünftige interne Prozessaudits (basierend auf VDA 6.3) von den lokalen Auditoren an 28 Produktionsstandorten durchgeführt werden können, initiierte die BSH Hausgeräte GmbH ein Ausbildungsprojekt für interne Prozessauditoren.

Dabei wurden folgende Kompetenzen geschult und gecoacht:

- Quality Core Tools

- Interner Auditor nach ISO 19011

- Prozessauditor nach VDA 6.3

- Audit Software Training

- Konfliktmanagement in kritischen Auditsituationen

- Coaching und Witness bei einem realen Audit

Das gesamte Projekt untergliederte sich in folgende Abschnitte:

Vorbereitungsphase:

Nach Erstellung eines Projekt- und Budgetplans, dem Einholen des Projektauftrags durch das Top-Management und der Einrichtung eines Steuerkreises wurden die zukünftigen Prozessauditoren nominiert und ausgewählt. Für diese galten klar definierte Teilnahmevoraussetzungen, wie zum Beispiel eine mehrjährige Berufserfahrung im Qualitätsmanagement und praktische Erfahrungen bei der Anwendung von Qualitätsmethoden.

Rollout Phase:

Die nominierten Mitarbeiter der jeweiligen Standorte wurden in den oben genannten unterschiedlichen Fach- und Methodentrainings qualifiziert. Anschließend erhielten sie in einem Praxiseinsatz an einem Pilotstandort vor Ort ein Coaching und wurden in einem Witness-Audit bewertet.

Operative Phase:

Die operative Umsetzung der regelmäßigen Auditierung der kritischen Prozesse findet an den jeweiligen Standorten in einem Dreijahreszyklus statt. Dazu erfolgten im Vorfeld mehrere Coachings, damit die Standorte ihre kritischen Prozesse nach einer einheitlichen Systematik identifizieren und mit gleichen Kriterien bewerten.

Abschluss des Projekts

Ein zentraler Fachexperte (Projektleitung und Koordinator) begleitete das Projekt permanent. Darüber hinaus unterstützten externe Trainer der DGQ und ein Veränderungsmanager das Vorhaben. Der Veränderungsmanager hatte dabei die Aufgabe, die erforderlichen Change Prozesse an den lokalen Standorten zu begleiten, die lokalen Prozessauditoren auf die Auditsituation vorzubereiten und ihnen nach dem Witness-Audit ein Feedback hinsichtlich der fachlichen Auditdurchführung sowie der Umsetzung der Rolle als Auditor (soziale Kompetenz) zu geben.

Nach Projektabschluss übernahm der Projektleiter, die Governance für die Prozessaudits im Unternehmen und verantwortet somit die Aufrechterhaltung und Weiterentwicklung einer globalen Prozessbeschreibung mit Rollen und Verantwortlichkeiten in der BSH Hausgeräte GmbH. Damit das erreichte Kompetenzlevel weiterhin erhalten bleibt, werden regelmäßig Netzwerktreffen mit den lokalen Prozessauditoren organisiert und für neue Auditoren Trainings- und Witness-Audits koordiniert.

Fazit

Die Prozessaudits im Rahmen der Ausbildung an den jeweiligen Pilotstandorten haben verdeutlicht, wie wichtig es ist, die Kompetenz der eingesetzten Auditoren auf einem hohen Niveau zu halten, damit die Prozessaudits professionell ablaufen. Der Vorteil dieser neu eingeführten Auditart (Prozessaudit) und der umfassenden Qualifizierungsmaßnahmen zeigt sich in der erhöhten Transparenz der kritischen Prozesse und der Identifikation zahlreicher Verbesserungspotenziale. Daher wird das interne Prozessaudit zukünftig die bereits bestehenden internen Systemaudits (ISO 9001, ISO 14001, ISO 50001, ISO 45001) ergänzen.

Ausgehend von der Unterstützung durch das Top-Management als Projektsponsor, war es von wesentlicher Bedeutung, dass die relevanten Führungskräfte von Anfang an in das Projekt integriert und deren Akzeptanz für das Prozessaudit durch regelmäßige Informationen und Schulungen geschaffen wurde.

Die Prozessoptimierung in der Produktentstehung und der Serienproduktion haben einen wichtigen Wertbeitrag zur Wettbewerbsfähigkeit des Unternehmens geleistet.

Autor:

Dipl.-Ing. (FH) Matthias Kohl, MBA ist Leiter der Integrierten Managementsystem Audits in der Konzernzentrale der BSH Hausgeräte GmbH in München und Six Sigma Master Black Belt. Zuvor war er in verschiedenen Qualitäts- und Projektmanagement Funktionen bei der Robert Bosch GmbH und Daimler Trucks AG tätig. In seiner nebenberuflichen Tätigkeit (KOHL Quality Training & Consulting) bietet er Trainings und Coachings im Bereich Qualitätsmanagement, Integrierter Managementsysteme und technischer Problemlösung an.

Die Automotive Core Tools in der IATF 16949

Qualitätsmanagement in der Automobilindustrie: Warum? Wie? Was?

Die automobile Welt von heute befindet sich im Wandel. Die Maßstäbe zur Bewertung sind nicht länger Hubraum, Anzahl der Zylinder und Kraftstoffverbrauch- Vielmehr geht es mittlerweile um Batteriekapazität, die damit verbundene Reichweite, Ladegeschwindigkeit und die Fahrzeugsoftware, welche alle möglichen Features abbilden soll. Wer vorn mitspielen will, muss höchsten Ansprüchen genügen, sonst fällt er im globalen Wettbewerb zurück. Das ist keine neue Erkenntnis. Doch Zeiten des Wandels geben immer auch Anlass, Fragen zu stellen. Warum sollten wir uns weiterhin mit Qualitätsmanagement befassen? Wie lassen sich wirksam die Anforderungen eines solchen QM-Systems umsetzen und was ist konkret gefordert?

Normbasierte QM-Systeme wie jene nach ISO 9001 und IATF 16949 haben zum Ziel, einen systematischen Ansatz zur Steuerung der Erfüllung von Anforderungen über die gesamte Lieferkette bereitzustellen. Liefern bedeutet nichts anderes als die Erfüllung von Kunden-, gesetzlichen und behördlichen sowie internen Anforderungen. Dies ist zugleich die Basis für Qualität. Somit ist die Begründung für den Einsatz von QM-Systemen – das Warum? – unverändert aktuell.

Zwischen universellem Anspruch und individueller Flexibilität

Die Entwicklung der QM-Systeme nahm spätestens 1987 ihren Lauf, als die erste Ausgabe der ISO 9001 herausgegeben wurde. Sie setzt sich auch in der Automobilindustrie fort, deren aktuelle Anforderungen an ein QM-System in der IATF 16949 beschrieben sind. Die definierten Anforderungen geben vor, was zu tun ist, um erfolgreich agieren zu können.

Eine weitere Herausforderung stellt der Anspruch auf universelle Anwendbarkeit der Anforderungen in den einzelnen Produktgruppen der Automobilindustrie dar. Vom Airbag bis hin zum Zahnrad müssen alle implementierten Systeme die Anforderungen erfüllen. Das Motto „One fits all“ funktioniert auf Grund der unterschiedlichen Anforderungen und Risiken in den jeweiligen Produktgruppen jedoch nicht. Das führt zur Frage des „Wie werden die Anforderungen effektiv umgesetzt?“ Antworten dazu finden sich in den Automotive Core Tools.

Es besteht ebenfalls der Anspruch auf universelle Anwendbarkeit in den Produktgruppen. So beschreibt APQP (Advanced Product Quality Planning) im Vorwort, dass es sich dabei um allgemeine Leitlinien zur Erfüllung der Anforderungen und nicht um spezifische Anweisungen zur Umsetzung des Regelwerkes handelt. Das sei Aufgabe jeder Organisation selbst, diese gemäß ihrer Ausrichtung und deren Bedürfnissen zu definieren.

Aus dieser Konstellation heraus ergeben sich Chancen für jedes einzelne Unternehmen, durch die Anwendung der Core Tools erfolgreich am Markt zu agieren. Die Core Tools versetzen die Organisation in die Lage, das zur jeweiligen Organisation passende „Wie“ zu bestimmen und umzusetzen.

Q-Methoden (Automotive Core Tools): Das „Wie“ legt die jeweilige Organisation fest

Advanced Product Quality Planning und Reifegradabsicherung

Die Qualitätsplanungsmethoden Advanced Product Quality Planning (APQP) und die Reifegradabsicherung (RGA) verwenden teils unterschiedliche Ansätze, verfolgen aber ein gemeinsames Ziel: die Erfüllung der Anforderungen ab dem Start of Production (SOP) durch ein robustes und kundentaugliches Produkt, welches mittels eines beherrschten und fähigen Produktionsprozesses hergestellt wurde. Ein Anlauf ohne größere Probleme hilft, zusätzliche Kosten zu vermeiden und stellt somit einen unmittelbaren Beitrag zum Betriebsergebnis dar. Der Bezug zum QM-System (Was ist konkret gefordert?) ist die Erfüllung der Anforderungen nach einer Projektplanung aus dem Abschnitt 8.1.1 d) der IATF 16949.

Risikoanalysen mittels FMEA

Bei der Projektrealisierung kommen weitere Core Tools zur Anwendung. Risikoanalysen mittels FMEA helfen dabei, potenzielle Fehler und deren Folgen im Produkt- und Prozessdesign zu erkennen und durch geeignete Maßnahmen rechtzeitig zu minimieren, bevor durch die Fehlerfolgen größerer Schaden entsteht. Die daraus abgeleiteten Lenkungsmaßnahmen sind Eingaben in den Produktionslenkungsplan (PLP) und helfen dem Unternehmen dabei, seine Produktionsprozesse und Abläufe zu optimieren und sicher zu gestalten. Der vermiedene Ausschuss und vermiedene Nacharbeit dienen nicht nur dazu, das Betriebsergebnis zu verbessern. Sie unterstützen die Mitarbeiter durch klare Vorgaben für den Prozessablauf und bei der Zielerreichung. Mehrere Anforderungen aus dem Abschnitt 8.3 ff. der IATF 16949 werden hier unterstützt.

Messsystemanalyse zur Beurteilung von Prüfprozessen

Ein weiteres Core Tool ist die Messsystemanalyse (MSA) zur Beurteilung und zum Nachweis der Fähigkeit von Prüfprozessen, gefordert im Abschnitt 7.1.5.1.1 – Beurteilung von Messsystemen. Die Vorgehensweise ist beschrieben in den Regelwerken MSA 4th Edition beziehungsweise VDA Band 5 sowie firmenspezifischen Richtlinien. Erst wenn der Nachweis erbracht ist, dass der angewandte Prüfprozess und die dabei verwendeten Prüf- und Messsysteme fähig sind sowie die Ergebnisse reproduziert werden können, sind die ermittelten Messergebnisse vertrauenswürdig. Die Organisation wird damit in die Lage versetzt, die Ergebnisse des Herstellprozesses sicher zu belegen. Der Beitrag zum Betriebsergebnis ist die Vermeidung von Pseudoausschuss. Es wird verhindert, dass spezifikationskonforme Produkte und Teile als nicht konform deklariert werden. Im umgekehrten Fall wird verhindert, dass man nicht konforme Produkte und Teile als spezifikationskonform deklariert und an den Kunden ausliefert. Die daraus resultierenden Folgen sind oft mit deutlich mehr Aufwand verbunden als jede Vermeidungsmaßnahme.

Statistical Process Control

Die MSA bildet die Grundlage zur Ermittlung der Maschinen- und Prozessfähigkeit wie im Abschnitt 8.3.5.2 d) der IATF 16949:2016 gefordert. Im Ergebnis kann die Entscheidung zum Einsatz des Core Tools Statistical Process Control (SPC) getroffen werden. Damit kann die Überwachung des Herstellprozesses und der resultierenden Ergebnisse mittels Stichprobe (Größe und Frequenz) erfolgen. Eine im Vergleich zu SPC aufwendigere 100%-Prüfung der Merkmalswerte wird vermieden. Dies liefert einen weiteren Beitrag zum Erreichen des gewünschten Betriebsergebnisses.

Produktionsprozess- und Produktfreigabe

Die Anforderungen aus dem Abschnitt 8.3.4.4 zu einem geforderten Produktions- und Produktfreigabeprozess werden mit den Methoden zur Bemusterung Production Part Approval Process (PPAP) beziehungsweise Produktionsprozess- und Produktfreigabe (PPF) umgesetzt. Hier erbringt der Lieferant gegenüber seinem Kunden den Nachweis, dass er die vertraglich vereinbarten Anforderungen an Produkt und Prozess erfüllt. Der Kunde bestätigt dies durch Erteilung einer Serienlieferfreigabe. An dieser Stelle zeigt sich dann wie gut und konsequent APQP/ RGA durchgeführt wurden. Die Vermeidung von zusätzlichen, nicht geplanten Aktivitäten zur Absicherung des Anlaufs helfen dabei, das gewünschte Betriebsergebnis zu erzielen.

8D Methode

Nach dem SOP kann es zu Reklamationen kommen, die auf verschiedenste Grundursachen zurückzuführen sind. Zur Erfüllung der Anforderungen aus dem Abschnitt 10.2.3 der IATF 16949 trägt ein weiteres Core Tool, die 8D Methode – Problemlösung in acht Disziplinen, bei. Eine schnelle Identifikation und Abstellung der Grundursache hilft dabei, dass Wiederauftreten des Fehlers oder Problems zu verhindern und die Reklamationskosten zu senken. Auch dieses und alle weiteren Core Tools leisten ihren Beitrag dazu, die gewünschten Ergebnisse zu erzielen und den Kunden zufriedenzustellen.

Neue Risiken im Spannungsfeld vor Qualität und Wirtschaftlichkeit

Diese kurze Zusammenstellung verdeutlicht das Zusammenwirken von Anforderungen eines QM-Systems und Q-Methoden am Beispiel der Automobilindustrie. Es zeigt zudem, dass durch die ergänzenden und zusätzlichen Anforderungen der IATF 16949 die Freiräume für Lieferanten im Vergleich zur ISO 9001 geringer sind, was die Wahl der Methoden betrifft. Jedoch haben die Organisationen in der Anwendung und Ausgestaltung der Methoden nach wie vor die Flexibilität, die geforderte Qualität und Wirtschaftlichkeit übereinzubringen. Das setzt aber verlässliche Abnahmevolumen für den Lieferanten und ein faires Teilen von Risiken in der Lieferkette voraus. Anderenfalls lassen sich die Steuerungsmöglichkeiten, die Q-Methoden den Organisationen bieten, nicht zielführend umsetzen und anwenden.

Über den Autor:

Thomas Birke ist seit 2018 freiberuflich als Trainer, Berater und Zertifizierungsauditor tätig. Er ist unter anderem für die DGQ als Ausbilder von „Prozessauditoren VDA 6.3“ und „1st and 2nd party Auditoren“ im Einsatz und berät mit seiner Firma Entwickelte Qualität (www.en-qu.de) Unternehmen zu Themen des Qualitäts- und Change-Managements. Vor seinem Wechsel in die Selbstständigkeit war Thomas Birke in leitender Funktion im Qualitätsmanagement bei einem führenden Automobilzulieferer angestellt. Als gelernter Kfz-Mechaniker sammelte er zudem Erfahrung im Entwicklungsbereich bei einem weltweit führenden Automobilhersteller, ehe es ihn 2007 ins Qualitätsmanagement verschlug.

Weiterbildungsangebote rund um das Thema „Automotive Core Tools“

Sie suchen Trainings, um sich einen Überblick über die in der Automobilindustrie geforderten Methoden der Qualitätssicherung zu verschaffen? Die DGQ bietet Ihnen Trainings zu den wichtigsten Automotive Core Tools an. Verschaffen Sie sich einen vertieften Überblick zu Standards und Methoden der Automotive Core Tools oder lernen Sie die Bewertung von Automotive Core Tools in System- oder Prozessaudits:

Informationssicherheit und die Norm ISO/IEC 27001 – ein Blick auf die Normentwicklung und branchenspezifische Standards

Ein Blick zurück auf die Entwicklung der Informationssicherheit zeigt: Das Thema „Sicherheit“ im Sinne des Schutzes von Informationen oder Daten ist grundsätzlich nicht neu. Es ist jedoch traditionell stark mit dem Vorhandensein physischer Informationsträger – also technischer Geräte, Patente, Prototypen, Pläne, Aktenordner, Verträge – verbunden. Mit der Digitalisierung hat die Herausforderung dann eine neue Dimension erreicht. Im Fokus stehen damals wie heute die zentralen Schutzziele Verfügbarkeit, Vertraulichkeit und Integrität.

Bereits im vordigitalen Zeitalter bestand die Frage, was auf Basis der Schutzwürdigkeit (Abwägung des schutzwürdigen Werts gegenüber Sicherheitsrisiken) letztlich wie zu schützen ist. Vergitterte Türen, ein Schloss an einer Tür, massive Wände, abschließbare Aktenschränke, Zutrittskontrollen bis hin zu begehbaren Tresoren im Keller von Banken mit Schließfächern für Dokumente etc. waren die Folge des Schutzbedarfes.

Mit dem Aufkommen der Informationstechnik und dem Vorhandensein portabler Speichermedien boten sich für Kriminelle völlig neue Optionen, wichtige Informationen stehlen zu können. Nun konnten Wechselfestplatten, Floppy Disks etc. mit einem – im Vergleich zu papiergebundenen Ordnern – Vielfachen an Daten beschrieben sein und dennoch problemlos physisch aus den Unternehmen herausgetragen werden. Die nachfolgende Vernetzung ermöglichte Datenübertragungen und eröffnete wiederum neuen Spielraum. Noch kritischer wurde die Sicherheitslage im Zeitalter des Internets mit dessen weltweiten Verfügbarkeit, in dem alles mit allem vernetzt sein kann. Auch hier ergibt sich die Möglichkeit des „Einbruchs“ und Viren, Trojaner oder Ransomware finden Zugang über E-Mails. Zudem gibt es Smartphones, die per Mobilfunk Fotos und Filme in Sekundenschnelle ablichten und verteilen können. Tragbare kleine USB-Speicher mit Terabytes von Daten auf der Größe einer Streichholzschachtel ergänzen die Vielfalt an Optionen.

Von der Informationssicherheit zur Cybersicherheit

Natürlich wurde die Sicherheit in der Informationstechnik schon länger in der Forschung thematisiert, von Herstellern gefördert, an Hochschulen gelehrt und hat sich entsprechend weiterentwickelt. Gleichwohl ist die Entwicklung der Technologie so dynamisch, dass man den Eindruck hat, dass die Sicherheit immer ein bisschen hinterherläuft. Das gilt insbesondere, wenn bei neuen Features die Frage der Priorität gestellt wird: Was ist wichtiger, Funktion oder Sicherheit?

Wir dürfen nicht vergessen, dass das Internet sich von militärischen Wurzeln in den 1960er Jahren hin zu einer akademischen Welt mit Forschergeist und freiem Wissenstransfer bewegt hat. Die heutige Qualitäts- und Kommerzialisierungsstufe stellt einen Quantensprung gegenüber den Anfängen dar. Für manchen Regierungsvertreter war das Ganze dennoch im Jahr 2013 noch „Neuland“. Auch in den nationalen und internationalen Regulierungsstellen tat man sich angesichts der Dynamik schwer – oder versäumte es gar, für mehr Sicherheit zu sorgen.

Der Informationssicherheit in Form der klassischen „Sicherheit“ von physikalischen Aspekten gesellte sich die Cybersicherheit hinzu, die sich um den Schutz von digitalisierter Information kümmert und somit den Begriff erweitert hat. Allerdings sind die zentralen Schutzziele Verfügbarkeit, Vertraulichkeit und Integrität nach wie vor unverändert, unabhängig davon, ob es sich um papiergebundene Verträge, Daten auf einem Firmenserver im Rechenzentrum oder in der externen Cloud handelt. Der Zugriff auf diese sollte beschränkt und kontrolliert sein. Nur autorisierte Benutzer oder Programme dürfen auf die Information zugreifen, die Prinzipien des „need to know“ sind überall anzuwenden. Denn die Bedrohung kommt nicht nur von außen, auch der Schutz vor einem möglicherweise internen, kriminellen Kollegen ist zu bedenken.

Normentwicklung in der Informationssicherheit

Betrachtet man die Entwicklung gesamtheitlich anhand der Kondratieff-Zyklen, die einen wellenförmigen Verlauf der Wirtschaft beschreiben, befinden wir uns seit den 1950er Jahren im „fünften Kondratieff“. Seine Antriebsenergie kam aus der computerbasierten Informationstechnik. Mit ständig zunehmender Geschwindigkeit durchdrang die Informationstechnik sowohl Produkte als auch alle Bereiche der Gesellschaft und verwandelte die Welt in eine Informationsgesellschaft. Diese Technologie und deren Anwendung entwickelt sich weiter, wodurch auch eine Weiterentwicklung der Informationssicherheitsnorm ISO/IEC 27001 notwendig wurde.

Doch blicken wir erst einmal zurück: Der Vorläufer des Standards, in dem die heutigen Anforderungen an Informationssicherheitsmanagementsysteme geregelt sind, erschien Ende der 1980er Jahre in Großbritannien als Veröffentlichung des Departement of Trade and Industry. Er enthielt Bewertungsrahmen für Sicherheitsprodukte und ein darauf basierendes Evaluierungs- und Zertifizierungsschema, zudem eine „Code of good security practice“. Diese Publikation wurde weiterentwickelt und 1995 vom „British Standard Institute“ als nationale Norm BS 7799 veröffentlicht. Später ging diese in der internationalen ISO/IEC 17799:2000 auf, die einen Leitfaden für die Implementierung eines Informationssicherheitsmanagementsystems darstellt. Über weitere Verbesserungen, Harmonisierungen und Aktualisierungen gelangte die Norm schließlich in den Kanon der ISO/IEC 27000er Familie und ist heute als ISO/IEC 27001:2022 die wichtigste internationale, anerkannte und zertifizierbare Norm für Informationssicherheit. Im weitgehenden Konsens der Fachleute ist die ISO/IEC 27001 ein angemessener und umfassender Ansatz, um die Ziele der Sicherheit zu unterstützen und greifbarer zu machen.

| Berufsbild Informationssicherheitsbeauftragter Informationen und Daten haben einen sehr großen Wert und bilden die Grundlage für Unternehmen und deren Geschäftsprozesse. Umso wichtiger ist es, diese vor Diebstahl, Missbrauch oder Verlust zu schützen. Informationssicherheit und der Job als Informationssicherheitsbeauftragter spielen dabei eine wesentliche Rolle. Sie wollen Unternehmen bei dem Schutz ihrer Daten unterstützen und finden einen Job als Informationssicherheitsbeauftragter spannend? Antworten auf die wichtigsten Fragen finden Sie in unserem Berufsbild zum Informationssicherheitsbeauftragten:

|

Branchenspezifische Normen in der Informationssicherheit

Im Bereich der Informationssicherheit gibt es neben der ISO/IEC-27000er-Reihe auch branchenspezifische Normen, auf die im Rahmen einer Auswahl hier näher eingegangen werden soll. Hervorzuheben sei hier zudem die Verbindung zwischen Informationssicherheit und Cybersicherheit. Cybersicherheit dient konkret dem Schutz von digitalen Systemen, Netzwerken und Daten vor böswilligen Angriffen oder anderen Risiken. Informationssicherheit ist der Oberbegriff, da sowohl physische Informationen und Infrastruktur als auch digitalisierte Informationen betrachtet werden. Die Ziele der Cybersicherheit sind identisch mit denen in der Informationssicherheit (Verfügbarkeit, Vertraulichkeit, Integrität) und unabhängig davon, ob Daten auf privaten Devices wie Smartphone oder Laptop gespeichert oder in einer Cloud bzw. bei einem genutzten Service hinterlegt sind.

Automotive

Für die Automotive-Branche kann der „TISAX®“-Standard herangezogen werden. Er baut auf der ISO/IEC 27001 auf und ergänzt die Norm mit Branchenspezifika wie zum Beispiel den Aspekten Lieferketten und Prototypensicherheit.

Nicht unerwähnt bleiben sollte zudem die ISO/IEC/SAE 21434 „Road vehicles – Cybersecurity engineering“. Die Norm behandelt das Thema Cyber-Security in Kraftfahrzeugen und gilt für Komponenten (elektronische Bauteile und Software), sie umfasst die Phasen der Entwicklung, Produktion, Betrieb, Wartung und Recycling im Lebenszyklus eines Fahrzeuges. Aufgrund der zunehmenden Risiken durch Cyber-Angriffe auf Fahrzeuge soll die Norm Maßnahmen für die Entwicklung vorschlagen. Das wird unter anderem deshalb immer wichtiger, weil die digitale Infrastruktur im Hinblick auf Online-Updates von Fahrzeugen (OTA), das Flottenmanagement und die Kommunikation zwischen Fahrzeugen (Car2x/V2X) neue Angriffsflächen bietet. Die Anwendung der Norm ist wichtig im Rahmen der umfangreichen Zulassungsverfahren für Typgenehmigungen.

Medizin

Mit Blick auf die Medizin ist unter anderem die ISO 27799 relevant. Sie adressiert die Medizinische Informatik und spezifiziert die Anforderungen an ein Informationssicherheits-Managementsystem im Gesundheitswesen unter Anwendung der ISO/IEC 27002.

Kritische Infrastrukturen (Energieversorgung, Telekommunikation)

Für die Sicherheit Kritischer Infrastrukturen (KRITIS) wie Energie- und Wasserversorgung oder auch Telekommunikation kommen gesetzliche Rahmenwerke (z. B. IT-SiG 2.0, BSIG, BSI-KritisV) zum Einsatz. Sie definieren Anlagen, Betriebsstätten und weitere ortsfeste Einrichtungen sowie Maschinen, Geräte und sonstige ortsveränderliche Einrichtungen, außerdem Software und IT-Dienste, die für die Erbringung einer kritischen Dienstleistung notwendig sind. In Deutschland existiert mit dem IT-Sicherheitsgesetz bereits seit Juli 2015 ein einheitlicher Rechtsrahmen für die Zusammenarbeit von Staat und Unternehmen, um die Cyber-Sicherheit bei den Kritischen Infrastrukturen zu erhöhen. Dieser schreibt KRITIS-Betreibern vor, IT-Sicherheit nach dem “Stand der Technik” umzusetzen. Weitere Dynamik bekommt das Thema aus der europäischen Richtlinie zur Netz- und Informationssicherheit (NIS-Richtlinie), die im August 2016 in Kraft getreten ist. Diese definiert Maßnahmen zur Gewährleistung eines hohen gemeinsamen Sicherheitsniveaus von Netz- und Informationssystemen in der europäischen Union.

Über dieses Ziel hinaus geht die neue EU-Richtlinie vom November 2022 mit der Bezeichnung „NIS 2“. Diese wird die derzeit geltende NIS-Richtlinie ersetzen und legt für Unternehmen ab einer definierten Größenordnung Berichtspflichten und Standards fest, beispielsweise zu getroffenen Cybersicherheitsmaßnahmen. Vor allem erweitert sie die zuvor engere Definition (z. B. Energie, Wasser) auf weitere Sektoren. So sind nunmehr 18 Zielbranchen genannt: Die Lebensmittelbranche, IT-Unternehmen, Hersteller von Chemikalien, Maschinen und Fahrzeugen sind dann ebenfalls betroffen. In Branchenkreisen wird das neue Gesetz auch als Quantensprung gesehen, da von bis zu 40.000 Unternehmen ausgegangen wird, die Cybersecurity-Maßnahmen ergreifen müssen, was als echter Fortschritt auf breiter Front zu sehen ist. Auch der Rahmen für Strafzahlungen wurde signifikant angehoben – auf das Niveau der europäischen Datenschutz-Regulierung EU-DSGVO. Bußgelder belaufen sich auf bis zu 10 Millionen Euro beziehungsweise 2 Prozent des globalen Jahresumsatzes.

Finanz- und Bankwesen

Als weiterer Branchenstandard können die im Finanzbereich üblichen „Bankaufsichtlichen Anforderungen an die IT“ (BAIT, analog VAIT, die versicherungsaufsichtlichen Anforderungen an die IT) der Bundesanstalt für Finanzdienstleistungsaufsicht (BaFin) gelten, die sich primär an die Finanzbranche richten. Sie sollen die Erwartungshaltung der Aufsicht in Bezug auf die IT-Sicherheit transparent machen. Speziell die große Finanzbranche mit Banken, Versicherungen, Maklern, Fondsgesellschaften usw. hat darüber hinaus noch eine weitere Neuerung umzusetzen: Die neue Verordnung der EU, der „Digital Operational Resilience Act“ (DORA), ist ein Gesetzesvorschlag, der darauf zielt, die Widerstandsfähigkeit im Finanzsektor gegen betriebliche Störungen auf der IT-Ebene zu verbessern. Dabei geht es sowohl um gezielte Angriffe als auch um eine Reihe anderer, nicht böswillig verursachter, schwerwiegender IT-Probleme. So müssen Unternehmen in Zukunft beispielsweise auch Risiken durch Leistungen von Drittanbietern in ihren Analysen berücksichtigen, etwa solche von Cloud-Dienstleistern.

In unserer Blogreihe befassen wir uns mit verschiedenen Aspekten der Informationssicherheit sowie der Zertifizierung nach der Norm ISO/IEC 27001. Verstehen Sie die Notwendigkeit der Normanpassung und den Weg hin zur Zertifizierung. Zur Blogreihe »

Über den Autor:

Klaus Kilvinger ist Geschäftsführender Gesellschafter der Opexa Advisory GmbH, einer auf die Themen Digitalisierung, Cyber- und Informationssicherheit, sowie deren Integration in Geschäftsprozesse spezialisiertes Beratungsunternehmen mit Hauptsitz in München. Er ist seit über 30 Jahren in der IT-Branche aktiv und verfügt über ein breites anwendungsbezogenes Erfahrungswissen, verfügt ferner über umfassende Kenntnisse und Erfahrungen im IT-Projektgeschäft sowie Fachwissen in der Software-Qualitätssicherung. Die Informationssicherheit im nationalen und internationalen Umfeld ist sein Zuhause. Als zertifizierter IT-Security Manager, IT-Security Beauftragter sowie Datenschutzbeauftragter verfügt er über breite Branchenkenntnisse, über die Fertigungs-, Automobilindustrie, den öffentlichen Sektor bis hin zur Wirtschaftsprüfung.

VDA Band 2:2020 – Gut Ding braucht Weile

Mit erheblicher Verzögerung ist Ende Mai 2020 die lange angekündigte sechste überarbeitete Auflage des VDA Band 2 – Produktionsprozess- und Produktfreigabe (PPF) als „Rotband“ erschienen.

Das im VDA Band 2 beschriebene Verfahren zur Produktionsprozess- und Produktfreigabe gehört zu den wichtigsten kundenspezifischen Anforderungen der deutschen Automobilhersteller und deren Zulieferer und verfügt über eine hohe vertragsrechtliche Relevanz in der gesamten Lieferkette.

Die konforme Umsetzung des im VDA Band 2 beschriebenen Prozesses zur Produktionsprozess- und Produktfreigabe ist ein wesentlicher Baustein zur Minimierung der Haftungsrisiken im Rahmen des strategischen Risikomanagements – unabhängig von der Art der QM-Zertifizierung des Lieferanten. (mehr …)

VDA Band Schadteilanalyse Feld und Auditstandard – die wichtigsten Änderungen der Revision 2018

„Talk to the parts; they are smarter than the engineers.”

Dieser Satz von Dorian Shainin (1914-2000) könnte das Motto des Prozesses Schadteilanalyse Feld (SAF) sein. Shainin darf durchaus als einer der Vordenker zu diesem Ansatz gelten. Zu den zentralen Elementen seines Tuns gehörten diverse statistische Verfahren zur Qualitätsverbesserung. Als Besonderheit, die seinen Ansatz auszeichnet, gilt der Einsatz von Versuchstechniken mit statistischer Auswertung. Das Ziel dieser Versuche ist es, den Fehler so schnell und einfach wie möglich einzugrenzen. Dieses „Sprechen mit den Teilen“ findet sich auch im Konzept des Prozesses Schadteilanalyse Feld wieder.

(mehr …)

Der TISAX-Prozess: Informationssicherheit in der Automobilindustrie

Die Informatik hat den klassischen Ingenieurssektor Automobilindustrie eingeholt. Mittlerweile sind Informatiker in Teilen der Branche mehr gefragt als Ingenieure. Das hat seine Gründe: Industrie 4.0 in der Produktion, Vernetzung des Automobils und autonomes Fahren sowie die neue EU-Datenschutzgrundverordnung. Bei diesen Entwicklungen nimmt das Thema Daten und der richtige Umgang damit einen besonders hohen Stellenwert ein. Die Informationssicherheit steht dabei aus unterschiedlichen Gründen besonders im Fokus. Einerseits haben die Hersteller selbst ein Interesse daran, ihre Daten und Informationen zu schützen, die sie für Produkt- und Prozessentwicklung in ihrer Lieferkette bereitstellen. Gleiches gilt für Daten, die Dienstleistern wie beispielsweise Beratungs- oder Werbeagenturen zur Verfügung gestellt werden. Ein weiterer besonders wichtiger Aspekt ist der Schutz der Daten, die durch die Nutzung von Autos entstehen. Viele moderne Autos senden regelmäßig Daten über den aktuellen Status an den Hersteller – Digitalisierung à la Silicon Valley lässt grüßen. Damit hängt ein weiter „Antreiber“ für das Thema Informationssicherheit in der Automobilindustrie zusammen: die neue EU-Datenschutzgrundverordnung.

Auch der Verband der Automobilindustrie (VDA) befasst sich seit mehr als zehn Jahren in einem Arbeitskreis mit dem Thema Informationssicherheit. Das jüngste und wichtigste Ergebnis dieses Arbeitskreises: Ein neues Prüfverfahren basierend auf dem Fragenkatalog (ISA – Information Security Assessment). Grundlage dieses Assessments ist die Internationale Norm ISO/IEC 27001. Der Fragenkatalog besteht aktuell aus einem Basismodul, sowie jeweils einem Modul zu den Themen Prototypenschutz, Anbindung Dritter und Datenschutz.

Anwendung findet er sowohl bei den Herstellern für interne Zwecke, als auch in der Lieferkette und bei Dienstleistern der Automobilindustrie. Die Prüfungen insbesondere bei Lieferanten und Dienstleistern haben die Automobilhersteller in der Vergangenheit unabhängig voneinander und somit unkoordiniert durchgeführt. TISAX ist nun ein gemeinsamer Prüf- und Austauschmechanismus, der die Erkenntnisse aus den Information Security Assessments für alle Hersteller zugänglich macht. Die Ergebnisse der Prüfungen werden in einem Reifegradmodell abgebildet. Eine Rezertifizierung erfolgt grundlegend alle drei Jahre oder beispielsweise wenn das teilnehmende Unternehmen ein höheres Reifegrad-Level nachweisen möchte.

Eine Vereinigung aus Unternehmen und Verbänden, die ENX Association, fungiert als Governance-Organisation. Sie akkreditiert die Prüfdienstleister und kontrolliert die Qualität der Prüfungen. Die am TISAX-Verfahren teilnehmenden Unternehmen wenden sich ebenfalls mit ihrem Anliegen zuerst an die ENX Association. Diese stellt dann den Kontakt zum Prüfdienstleister her. Alle drei Parteien: ENX Association, Prüfdienstleister und teilnehmendes Unternehmen sind durch ein Vertragsdreieck rechtlich verbunden.

Seit Anfang des Jahres hat die DGQ das Training für TISAX – Foundation Level im Programm. In diesem Training machen sich Teilnehmer mit den Grundlagen des TISAX-Standards vertraut und erfahren alles, was für eine Begutachtung ihres Unternehmens nötig ist. Praktische Übungen und Diskussionen stehen dabei besonders im Fokus.