Interview zum FQS-Forschungsprojekt AIDpro: Datenvalidierung für Produktionsprozesse

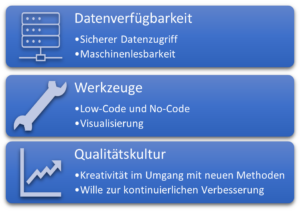

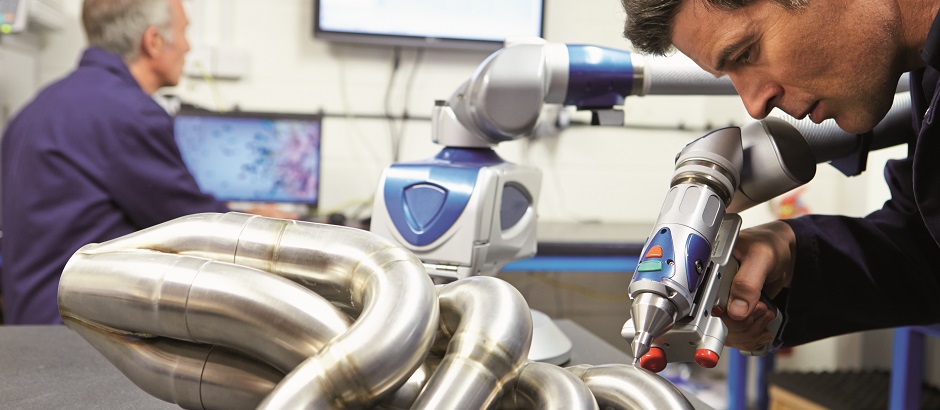

Angesichts wachsender ökologischer und wirtschaftlicher Herausforderungen müssen nicht zuletzt kleine und mittelständische Unternehmen (KMU) ihre Produktionseffizienz absichern und idealerweise steigern, um wettbewerbsfähig zu bleiben. Durch die Digitalisierung und die Nutzung einer datenbasierten Wertschöpfung mittels künstlicher Intelligenz (KI) kann die Produktivität und Flexibilität der Fertigungsprozesse in Industrie-4.0-Umgebungen gesteigert werden. Allerdings stellen die Implementierung und das Training serienreifer KI-Lösungen sowie ihre sichere Anwendung eine komplexe Herausforderung dar.

Oft sind die Prozessdaten, die die KI-Modelle im laufenden Betrieb verarbeiten, nicht vollständig durch die zuvor verwendeten Trainingsdaten repräsentiert. So weisen Sensordaten im Betrieb häufig Abnormalitäten oder Fehler auf, die durch externe Störungen, Übertragungsfehler oder defekte Sensoren verursacht werden. Zudem können Faktoren wie Saisonalität, Verschleiß und Verschmutzung dazu führen, dass sich Prozessdaten im Laufe der Zeit dynamisch ändern. Folglich können eingesetzte KI-Modelle unvorhersehbare Entscheidungen treffen, wenn aktuelle Anwendungsdaten stark von den Trainingsdaten abweichen. Um zu verhindern, dass Datenfehler die Entscheidungsfindung beeinträchtigen, müssen diese Anomalien mit höchstmöglicher Zuverlässigkeit erkannt werden, damit entsprechend gegengesteuert werden kann.

Im Rahmen des über die FQS – Forschungsgemeinschaft Qualität e.V. geförderten Forschungsprojekts AIDpro entwickeln das Fraunhofer-Institut für Produktionstechnologie IPT und das Fraunhofer-Institut für Angewandte und Integrierte Sicherheit AISEC über einen Zeitraum von zwei Jahren ein System zur automatisierten Datenvalidierung und Überwachung der Anwendungsphase von KI-Lösungen. Die Forschungsarbeiten werden von acht Unternehmen im Projektbegleitenden Ausschuss unterstützt.

Im Interview geben Jana Hüls (Fraunhofer IPT) und Wei-Herng Choong (Fraunhofer AISEC) einen Ausblick auf das Projekt und erläutern, wie Unternehmen von den Forschungsergebnissen profitieren können.

Aus welcher Problemstellung heraus ist das Forschungsprojekt entstanden?

Hüls: Die Entwicklung von serienreifen KI-Lösungen gliedert sich in zwei Phasen: die Modellbildungsphase und die Anwendungsphase. In der Modellbildungsphase erfolgen die Datenauswahl, Datenvorverarbeitung, Algorithmenauswahl sowie das Training und die Validierung des Modells. Während diese Schritte traditionell von Expertinnen und Experten übernommen werden, ermöglichen neue Ansätze im Forschungsgebiet des Automated-Machine-Learning (AutoML) eine teilweise Automatisierung bestimmter Schritte. Dadurch können KI-Lösungen auch für KMU ohne spezifische Fachkenntnisse interessanter werden.

In den cyber-physischen Produktionssystemen der Fertigungsindustrie liegen die Herausforderungen neben der Modellbildung allerdings vor allem in der Anwendungsphase von KI-Modellen. Diese Herausforderungen resultieren aus geringer Datenqualität, verursacht durch Sensorfehler und zeitlich variierende Abweichungen, den hohen Effizienzansprüchen der Branche sowie wirtschaftlichen Risiken und komplexen, oft intransparenten Systemfunktionen von KI. Besonders relevant sind die Anfälligkeit für fehlerhafte sowie sich dynamisch ändernde Daten und die wirtschaftlichen Risiken, die mit KI-Fehlentscheidungen verbunden sind. Im Betrieb leiten KI-Modelle aus Prozessdaten Informationen ab, die entweder zur Entscheidungsunterstützung oder zur autonomen Befehlsausführung genutzt werden. Dabei errechnen sich die Modellausgaben aus den im Training identifizierten Modellparametern und den momentanen Eingangsdaten. Weicht die Eingabe an die KI signifikant von den prinzipiell erlernten Strukturen der Trainingsdaten ab, können unvorhergesehene Entscheidungen durch die KI getroffen werden.

Choong: Da KI-Systeme perspektivisch auch in KMU zum Einsatz kommen müssen, um den Effizienzanforderungen gerecht zu werden, ist es entscheidend, das Risiko unvorhersehbarer KI-Entscheidungen zu minimieren. KI-Entscheidungen, die auf unzuverlässigen Daten basieren, bergen erhebliche Risiken für Produkte, Maschinen und Mitarbeiter. Für viele produzierende KMU ist die fehlende Qualität ihrer Prozessdaten und das damit verbundene Risiko ein Hemmnis beim Einsatz von KI-Modellen. An dieser Stelle soll das Forschungsprojekt AIDpro ansetzen und durch automatisierte Datenvalidierung und Überwachung der Anwendungsphase der KI-Lösungen die Grundlage für den sicheren Einsatz von KI in der Produktion ermöglichen. Dies gilt es durch geeignete, automatisierte Ansätze zur Anomalieerkennung zu adressieren.

Welches Know-how wird im Rahmen des Forschungsprojekts AIDpro entwickelt und wie kann es zur Lösung der geschilderten Problemstellung beitragen?

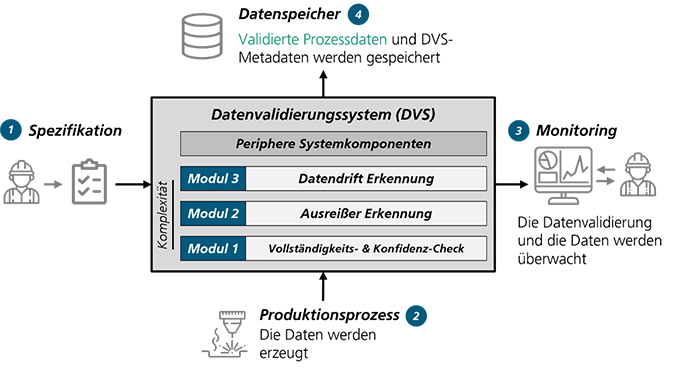

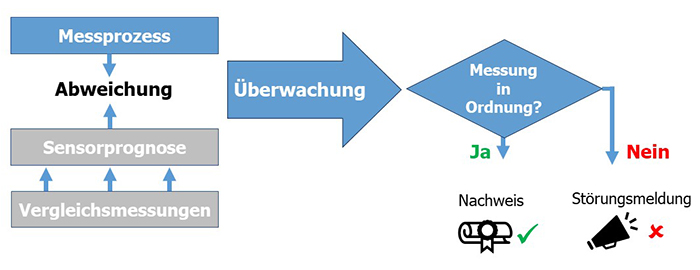

Hüls: Das Ziel von AIDpro ist die Entwicklung eines Datenvalidierungssystems (DVS) für eine automatisierte Prüfung und Sicherstellung der Datenqualität und eine Überwachung der Anwendungsphase von KI-Lösungen. Dabei wird das System speziell für den Einsatz in produktionstechnischen Systemen anhand konkreter Anwendungsfälle aus dem Projektbegleitenden Ausschuss entwickelt. Das DVS soll keine bloße Software-Bibliothek darstellen, sondern ein umfassender praxisnaher Leitfaden samt anwendungsbezogenem Software-Demonstrator sein. Der Leitfaden wird dazu dienen, KMU zu befähigen, selbstständig erste Schritte im Bereich Machine Learning zu gehen, indem eine validierte Datengrundlage aufgebaut wird.

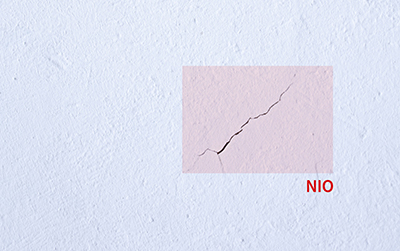

Abb. 1: Darstellung des geplanten Datenvalidierungssystems (DVS) ©Fraunhofer IPT

Choong: Das DVS soll modular aufgebaut sein und eine direkte Schnittstelle zu den Daten aus den Produktionsprozessen haben. Zunächst werden Vollständigkeits- und Konfidenz-Checks durchgeführt, die regelbasiert überprüfen, ob alle Daten vollständig und innerhalb der von Experten vordefinierten Wertebereiche liegen. Ergänzend wird eine Erkennung von Ausreißern durchgeführt. Dafür werden insbesondere neuartige, KI-basierte Erkennungsmethoden verwendet. Des Weiteren wird das System zeitliche Veränderungen in den Daten, sogenannte Datendrifts, überprüfen. Diese Information kann Aufschluss über veränderte Produktionsbedingungen geben und dazu genutzt werden, das KI-Modell mit den veränderten Bedingungen neu zu trainieren.

Die validierten Daten inklusive der Metadaten werden anschließend gespeichert, um sie zum Beispiel für das Training von KI-Modellen für Einsätze wie intelligente Qualitätskontrolle zu nutzen. Daneben wird auch ein Data-Monitoring-Ansatz entwickelt, der die Datenvalidierung und die Daten überwacht. Das übergeordnete Ziel des DVS ist es demnach, Datenfehler, Anomalien und Datendrifts zu erkennen, zu visualisieren beziehungsweise zu alarmieren und diese – in Zusammenwirkung mit Anwendenden – zu handhaben.

Wer soll von den Ergebnissen profitieren und welcher konkrete Nutzen ergibt sich für Unternehmen?

Hüls: Von den Ergebnissen sollen insbesondere produzierende KMU profitieren. Die validierten Prozessdaten, die das DVS bereitstellt, schaffen die Voraussetzung für den industriellen Einsatz von KI. Die Überwachung der Daten während der Anwendungsphase von KI schützt zudem vor den Risiken von Fehlentscheidungen durch fehlerhafte Datenpunkte. Der praxisnahe Leitfaden unterstützt Unternehmen zusätzlich, um – aufbauend auf den validierten Daten – KI-Potenziale zu erschließen, die sich zum Beispiel in der Qualitätskontrolle, der intelligenten Wartung, oder der Identifizierung ressourceneffizienter Betriebspunkte und Qualitätsvorhersagen ergeben. Außerdem können die Unternehmen durch das DVS und das transparente Data Monitoring eine unternehmensinterne Datenkompetenz aufbauen.

Wie sieht das weitere Vorgehen im Forschungsprojekt aus?

Choong: Zunächst werden wir eng mit dem Projektbegleitenden Ausschuss zur Identifizierung und Definition relevanter Anwendungsfälle zusammenarbeiten. Unser Ziel ist es, eine vielfältige Sammlung von praxisnahen und relevanten Anwendungsfällen und Datensätzen zu erstellen, um ein allgemeines DVS entwickeln zu können. Basierend auf diesen Anwendungsfällen leiten wir die Spezifikationen und Anforderungen an das DVS ab, die uns bei der Entwicklung und Implementierung des Gesamtkonzepts leiten. Nach der erfolgreichen Implementierung des DVS führen wir mit den Industriepartnern die Validierung und Evaluierung des DVS in einer realen Fertigungsumgebung zusammen durch. Das Feedback der Unternehmen wird in eine weitere Entwicklungsiteration einfließen. Anschließend werden wir weiterführende Anwendungsszenarien für das DVS identifizieren und bewerten, wobei der Schwerpunkt auf Themen wie Predictive Maintenance und Qualitätssicherung liegt.

Stimmen aus dem Projektbegleitenden Ausschuss:

André Heinke, Leiter Vertrieb und Marketing, Bitmotec GmbH:

Als Partner im Projektbegleitenden Ausschuss des Forschungsprojekts AIDpro engagiert sich die Bitmotec GmbH für die Entwicklung standardisierter Methoden zur Sicherung der Datenqualität in Produktionsprozessen. Mit unserer Industriellen Datenplattform BITMOTECOsystem verbinden wir Maschinen und Sensoren in produzierenden Unternehmen, um beispielsweise OEE-Lösungen umzusetzen. Aus unserer langjährigen Erfahrung mit KI-Technologien in der Industrie wissen wir, dass die Qualität und Integrität der erfassten Daten eine zentrale Rolle spielen. Nur wenn Industrieunternehmen ihren Daten vertrauen, sind sie bereit, den Ergebnissen zukünftiger KI-Technologien zu glauben und diese gewinnbringend einzusetzen.

Durch die Teilnahme an AIDpro wollen wir innovative Ansätze zur kontinuierlichen Überwachung und Validierung von Prozessdaten erarbeiten. Die Identifikation von Ausreißern und Datendrifts – etwa durch Verschleiß oder Messfehler – ist essenziell, um verlässliche Entscheidungsgrundlagen für KI-gestützte Optimierungen zu schaffen. Die Erkenntnisse aus dem Forschungsprojekt helfen uns, unsere Lösungen für die digitale Produktion weiterzuentwickeln und unseren Kunden eine noch höhere Datenqualität sowie Prozesssicherheit zu bieten. So schaffen wir eine stabile Basis für den erfolgreichen Einsatz von KI in der industriellen Praxis.

Daniel Narberhaus, Research & Development, Aventus GmbH & Co. KG:

Unsere Motivation für die Teilnahme am Forschungsprojekt AIDpro ist klar: Wir wollen KI nicht nur anwenden, sondern verstehen – und vor allem auf einer qualitativ hochwertigen Datenbasis weiterentwickeln. Statt auf bloße Datenmengen zu setzen, legen wir den Fokus auf plausible, nachvollziehbare Daten. Nur so können wir KI-Lösungen schaffen, die nicht nur leistungsfähig, sondern auch vertrauenswürdig und praxisnah zum Nutzen unserer Kunden sind. Die im Projekt gewonnenen Erkenntnisse fließen direkt in die Neu- und Weiterentwicklung unserer digitalen AVENTUS-Produkte ein – mit dem Ziel, für unsere Kunden noch intelligentere und verlässlichere Lösungen für eine leistungsstarke Produktion zu entwickeln.

Über die Interviewpartner:

Jana Hüls, Wissenschaftliche Mitarbeiterin, Production Quality, Fraunhofer-Institut für Produktionstechnologie IPT

Wei Herng Choong, Department Cognitive Security Technologies, Fraunhofer-Institut für Angewandte und Integrierte Sicherheit AISEC

Über das Forschungsprojekt:

Das Projekt wird im Rahmen des Programms „Industrielle Gemeinschaftsforschung” durch das Bundesministerium für Wirtschaft und Klimaschutz aufgrund eines Beschlusses des Deutschen Bundestages gefördert (Förderkennzeichen: 01IF23103N; Forschungsvereinigung: FQS – Forschungsgemeinschaft Qualität e.V.) Weitere Informationen zum Projekt und zu Beteiligungsmöglichkeiten können über die Geschäftsstelle der FQS bezogen werden. Eine Mitarbeit im Projekt ist auch nach Laufzeitbeginn noch möglich.

Weitere Informationen finden Sie auf der Website des Fraunhofer IPT »

Über die FQS:

Die FQS – Forschungsgemeinschaft Qualität e. V. (FQS) unterstützt seit 1989 die anwendungsorientierte Forschung rund um das Thema Qualität in Deutschland. Sie versteht sich selbst als Forschungsbereich der Deutschen Gesellschaft für Qualität e. V. (DGQ) und wird von ihr getragen. Die FQS fördert innovative Forschungsideen über das Instrument der Industriellen Gemeinschaftsforschung (IGF) und des Forschungsnetzwerks CORNET des Bundesministeriums für Wirtschaft und Klimaschutz (BMWK). Ziele der Förderung sind möglichst anwendungsnahe Forschungsideen, die einen unmittelbaren Nutzen für die Wirtschaft, insbesondere für kleine und mittelständische Unternehmen (KMU), erbringen.

Vorstellung der FQS Forschungsgemeinschaft Qualität e.V.

Wer ist die FQS Forschungsgemeinschaft Qualität e.V. und was tut sie? Lernen Sie im Video den Forschungsbereich der DGQ kennen und erfahren Sie von Dr. Christian Kellermann-Langhagen, wissenschaftlicher Geschäftsführer der FQS, wie die FQS arbeitet, welche Themen beforscht werden und wie sich Unternehmen in der FQS beteiligen und von den eingesetzten Förderprogrammen profitieren können.

Kontakt:

FQS – Forschungsgemeinschaft Qualität e. V.

August-Schanz-Straße 21A

60433 Frankfurt am Main

infofqs@dgq.de

Einsatz der Messmittelfähigkeit zur Absicherung von künstlicher Intelligenz

Künstliche Intelligenz hat sich in rasender Geschwindigkeit in vielen Bereichen der Wirtschaft durchgesetzt. Insbesondere große Sprachmodelle werden dabei in immer mehr Anwendungen integriert. Die Frage, die sich dabei stellt, ist: Wie können diese Systeme sinnvoll abgesichert werden? In diesem Fachbeitrag soll gezeigt werden, dass etablierte Fähigkeitsanalysen, wie MSA oder VDA Band 5 auf ein breites Spektrum von KI-Systemen anwendbar sind.

Ein Blick in die KI-Verordnung aus dem Jahr 2024 zeigt, dass für KI-Systeme im Hochrisikobereich (zum Beispiel bei Sicherheitsbauteilen oder in der Bildung) ein Nachweis über die Genauigkeit vorgeschrieben ist (siehe Art. 15 (2) KI-Verordnung). Dabei wird explizit die Zusammenarbeit mit „Metrologischen Behörden“ seitens der EU-Kommission herausgestellt. Momentan ist noch unklar, wie genau diese Zusammenarbeit aussehen wird. Es kann davon ausgegangen werden, dass sich Behörden, wie die Deutsche Akkreditierungsstelle für eine einheitliche Begriffsdefinition mit bestehenden Normenwerken stark machen werden. Von zentraler Bedeutung ist dabei eine einheitliche Definition von Messunsicherheit und die Eignung eines KI-Systems für eine gegebene Anwendung.

Momentan liegt ein großer Teil der medialen Aufmerksamkeit auf Transformermodellen. Dies führt dazu, dass Transformermodelle wie gpt-4, die die Basis für Anwendungen wie ChatGPT bilden, häufig mit KI gleichgesetzt werden. Tatsächlich haben viele Mitarbeiter der Qualitätssicherung aber bereits jahrelange Erfahrung mit KI-Systemen in ihrer Produktion. Ein gutes Beispiel hierfür sind automatische Kamerasysteme zur Bildklassifikation.

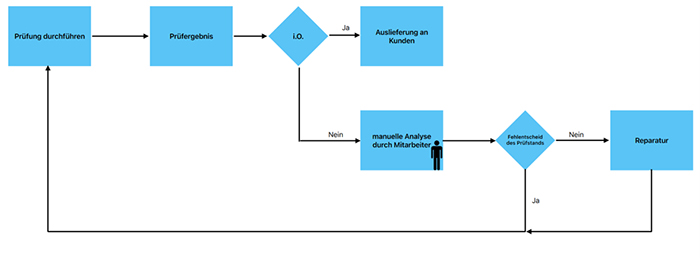

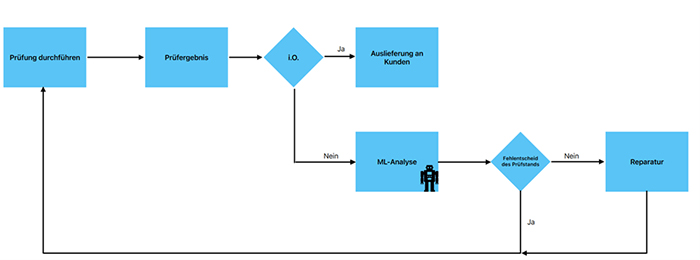

In vielen Firmen werden automatische Kamerasysteme als Prüfmittel eingesetzt. Kamerasysteme können sowohl messende Prüfungen vornehmen als auch attributiv eingesetzt werden. Für beide Fälle existieren gut beschriebene und etablierte Verfahren wie MSA oder der VDA Band 5 mit seinen entsprechenden Erweiterungen um die Fähigkeit solcher Systeme nachzuweisen (s. Measurement systems analysis, 4th edition 06.2010 und VDA Band 5, 3. Auflage, Juli 2021). Das bedeutet, dass für solche KI-Systeme bereits eine direkte Anwendbarkeit der Begriffe „Eignungsnachweis“ und „Messunsicherheit“ gegeben ist.

Etwas weniger offensichtlich ist die Situation bei großen Sprachmodellen, wie gpt-4. Hierbei können unterschiedliche Fälle beantwortet werden. Im ersten Fall wird das Sprachmodell eingesetzt, um einen Text durch einen Zahlenwert zu bewerten. Ein einfaches Beispiel ist die automatische Bewertung von Kundenfeedback, bei dem ein Freitext einer Sternebewertung zugeordnet wird. Um das Beispiel zu verdeutlichen wurde folgender Prompt 50 mal mit unterschiedlichen Modellgenerationen von OpenAI, der Herstellerfirma von ChatGPT, getestet:

„Ich möchte, dass du Trainingsfeedbacks auf einer Skala von 1 bis 10 bewertest. Wie würdest du folgendes Feedback bewerten: “Schönes Training, sympathischer Trainer, das Essen war für mich sehr salzig.” Bitte antworte nur mit einer Zahl.“

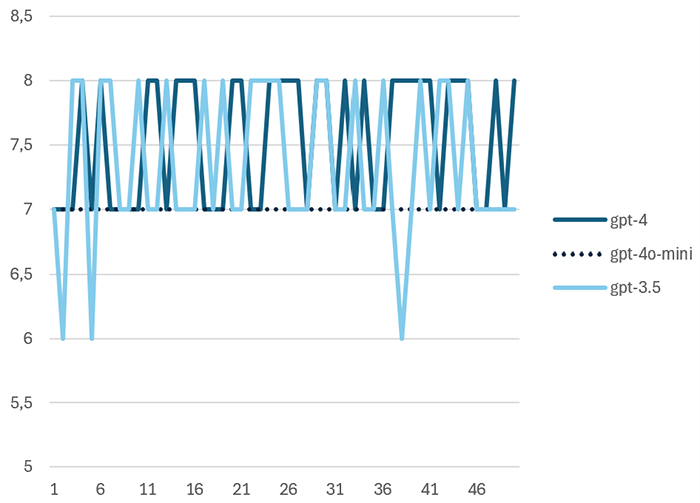

Abbildung 1 zeigt den Werteverlauf der Ergebnisse für drei unterschiedliche Modellgenerationen. Es fällt auf, dass das neuere Modell gpt-4o-mini im Vergleich zu den Vorgängermodellen gpt-3.5 und gpt-4 nicht mehr streut zur Übersetzung des folgenden Feedbacks in eine Punktebewertung.

Die Werteverläufe wurden mittels einer Messystemanalyse nach MSA und nach VDA Band 5 ausgewertet. Die Cg und Cgk-Werte wurden gemäß der VDA-Empfehlung ermittelt. Tabelle 1 zeigt die Übersicht der Ergebnisse. gpt-4o-mini hätte in diesem Fall die Fähigkeit nach VDA erreicht, scheitert allerdings an der aufgabenbedingten Auflösungsgrenze von 5 Prozent der Toleranz.

| gpt | x ̅ | s | Cg | Cgk | Qms |

|---|---|---|---|---|---|

| gpt-3.5 | 7,34 | 0,59 | 0,84 | 0,80 | 26,3% |

| gpt-4 | 7,54 | 0,50 | 0,99 | 0,74 | 23,1% |

| gpt-4o-mini | 7,00 | 0,00 | – | – | 11,5% |

Tab. 1: Ergebnisse der Fähigkeitsuntersuchungen für unterschiedliche Modellgenerationen

Ein Bereich, in dem die Bewertung von Text durch KI-Systeme eine hohe Relevanz hat, ist die Bildung. Ein gutes Beispiel hierfür ist die Firma Fobizz, die Software zur Unterstützung von Lehrkräften anbietet. Die Software von Fobizz wurde von den Bundesländern Mecklenburg-Vorpommern und Berlin lizensiert und steht dort allen Lehrkräften zur Verfügung. Pilotversuche in Bayern, Hessen und Baden-Würtemberg laufen. Ein Feature dieser Software ist die automatische Bewertung von Klassenarbeiten.

Rainer Mühlhoff und Marte Henningsen konnten in ihrem Vortrag auf dem Chaos Communications Congress 2024 zeigen, dass die Software bei mehrfacher Eingabe identischer Klausuren zu unterschiedlichen Bewertungsergebnissen kommt. Dies ist nicht überraschend, da es sich laut Auskunft der Firma um ein Webfrontend für ein großes Sprachmodell handelt. Eine Eigenschaft von Sprachmodellen ist, dass die Ausgabe üblicherweise innerhalb gewisser Grenzen zufällig variiert wird. Dies führt zu einer zufälligen Streuung in den Bewertungsergebnissen, die sich auch in Abbildung 1 gezeigt hat. Die Wissenschaftler konnten zeigen, dass die Benotung von einem Durchlauf zum nächsten um mehrere Notenschritte abweichen kann.

Ein interessanter Aspekt, der jedoch nicht untersucht wurde, ist die Frage, ob echte Lehrkräfte bei so einem Versuch besser abschneiden würden als das KI-System. Eine Auswertung nach Methode 2 mit zwei echten Lehrkräften und einem KI-System würde dies deutlich zeigen. So wäre es möglich zu entscheiden, ob das KI-System weniger streut als menschliche Lehrkräfte und ob es statistisch signifikante Abweichungen in Form von Bias zwischen dem KI-System und den Lehrern gibt. Tatsächlich fordert die KI-Verordnung genau solche Biasbewertungen als Teil der Absicherung für Hochrisiko-KI-Systeme.

Fobizz ist vorerst nicht zur Umsetzung statistischer Tests verpflichtet, weil die KI-Verordnung im Falle von Hochrisiko KI-Systemen nicht rückwirkend gilt. Voraussetzung ist dabei, dass das betroffene KI-System vor dem 02.08.2026 in Verkehr gebracht wurden und danach nicht wesentlich verändert wurden.

Die beiden obigen Beispiele zeigen, dass Prüfmittelfähigkeitsuntersuchungen für alle KI-Systeme anwendbar sind, die zur Kategorisierung oder Messung eingesetzt werden. Dies gilt selbst, wenn eine messende Bewertung eines Texts vorgenommen wird. Etwas anspruchsvoller ist der Fall der Bewertung eines reinen Chatbots. Da bei einem Chatbot sowohl Ein- als auch Ausgabe unstrukturierter Text ist, sind die statistischen Methoden der Qualitätssicherung hier nicht direkt einsetzbar. Dies ist Gegenstand aktueller Forschung. Das einfachste Vorgehen ist es Menschen einzusetzen, die bewerten, ob der Chatbot richtig reagiert hat und so den attributiven Eignungsnachweis zu führen. Als Mustereingaben können Chatverläufe genutzt werden, die in der Vergangenheit zu Auffälligkeiten geführt haben. Das Vorgehen ist dabei ähnlich wie bei Grenzmustern mit bekanntem Gut-/Schlechtentscheid in der Kameraprüfung.

Da bei diesem Vorgehen die Unsicherheit der menschlichen Einschätzung und die zufällig streuende Antwortqualität der Maschine mathematisch nicht unterscheidbar sind, kann der Eignungsnachweis hier deutlich schwieriger sein. In jedem Fall sollten statistische Methoden eingesetzt werden, um ausreichend hohe Stichprobenumfänge mit einer aussagekräftigen Anzahl an Wiederholungen festzulegen.

Zusammenfassung

Es wurde gezeigt, dass Methoden, wie die Prüfmittelfähigkeit sich in vielen Fällen direkt auf die Eignung von KI-Systemen anwenden lassen. Dies gilt auch für viele andere statistische Verfahren der Qualitätssicherung, wie zum Beispiel F- und t-Tests oder Kreuztabellenbetrachtungen. Durch den Einsatz anerkannter Bewertungsverfahren steigt das Vertrauen in das KI-System und die Genauigkeit der Systeme kann in transparenter Weise ausgewiesen werden.

Die Bedeutung von Eignungsnachweisen für KI-Systeme wird durch die Anforderungen der KI-Verordnung deutlich steigen. Es muss jedoch betont werden, dass viele Normen, die die praktische Umsetzung der KI-Verordnung beschreiben, aktuell noch in Erstellung sind. Bereits jetzt steht allerdings fest, dass die Qualitätssicherung einen wertvollen Beitrag dazu leisten kann, präzise KI-Systeme zu entwickeln und zu betreiben. Mitarbeiter der Qualitätssicherung können auf diese Weise ihre einzigartigen Fähigkeiten nutzen und neue Werte für ihr Unternehmen schaffen.

Lesen Sie mehr zum Thema “Künstliche Intelligenz in der Qualität” in den folgenden Fachbeiträgen:

- Teil 1: Künstliche Intelligenz in der Qualität – Bestehendes Know-how effektiv nutzen – zum Beitrag »

- Teil 2: Künstliche Intelligenz in der Qualität – Welche Qualifikationen werden benötigt? – zum Beitrag »

- Teil 3: Künstliche Intelligenz in der Qualität – Praktische Einführung durch iteratives Vorgehen – zum Beitrag »

Über den Autor:

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Künstliche Intelligenz. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten. Kontakt: ki@prophet-analytics.de

Neue Norm für Oberflächenrauheit seit 2022

Die geometrische Beschreibung von Bauteilen ist wesentlich, um die Funktion von Baugruppen und Produkten sicherzustellen. Dabei werden die Nenngeometrie und Toleranzen, mit denen die zulässigen Abweichungen begrenzt werden, unterschieden.

Als Makrogeometrie werden die Maße sowie Form- und Lageabweichungen bezeichnet. Die Mikrogeometrie entspricht der Oberflächenbeschaffenheit von Bauteilen und wird üblicherweise nur als Rauheit (gemeint ist damit die 2D-Rauheit an einem Profil) bezeichnet, obwohl noch viele andere Eigenschaften die Oberfläche charakterisieren. Funktionales Verhalten, zum Beispiel Gleiten oder Dichten, ist stark von der Beschaffenheit der Oberfläche abhängig. In geometrischen Produktspezifikationen, zum Beispiel technischen Zeichnungen, wird üblicherweise die Rauheit eingetragen, um zulässige Abweichungen der Oberfläche zu begrenzen.

Oberflächensymbol steht auf jeder Zeichnung

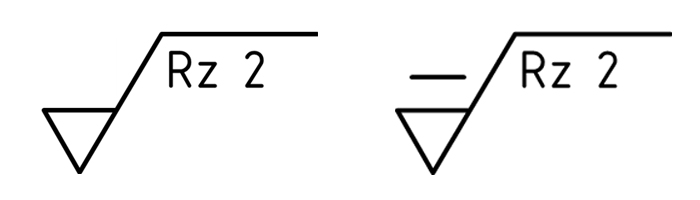

Das Oberflächensymbol hat jeder schon auf einer technischen Zeichnung gesehen, der mit technischen Zeichnungen in Kontakt kommt. Neben dem Symbol bestehend aus einem Dreieck verlängert mit einem Querstrich, sind eine Kenngröße und ein Toleranzwert die üblichen Angaben, wobei schätzungsweise 80 Prozent der Eintragungen in der Industrie mit den Kenngrößen Ra und Rz erfolgen. Das bedeutet nicht zwingend, dass die Oberflächen damit vollständig und eindeutig beschrieben sind, da sich die Kenngrößen nur auf die Höhe des damit in Verbindung stehenden Rauheitsprofils beziehen und eine Mittelung der Höhenwerte erfolgt. Das wird sich auch mit der neuen Rauheitsnorm nicht ändern. Aber es gibt eine große Anzahl weiterer Kenngrößen, die in Betracht gezogen werden können, um die Eigenschaften der Oberflächen eindeutiger zu beschreiben.

Zusammenführung und Anpassung bestehender Normen

Die bisherigen Normen wurden bereits vor 20 oder mehr Jahren veröffentlicht und mussten an den aktuellen Stand der Normung im Bereich der Geometrischen Produktspezifikation angepasst werden. Dieser Überarbeitungsprozess wurde gleichzeitig genutzt, um die verschiedenen Normen, zum Beispiel DIN EN ISO 1302, DIN EN ISO 4287 und DIN EN ISO 4288, zu einer neuen Normenreihe DIN EN ISO 21920 zusammenzufassen.

Zur Abgrenzung der bisherigen zu den neuen Festlegungen wurde als offensichtlicher Unterschied das Symbol mit einer Linie über dem Dreieck ergänzt. Zusätzlich sind zum Beispiel eine Veränderung der standardmäßigen Akzeptanzregel von 16 Prozent auf Max-Regel, Neuerungen zur Bezeichnung der Filter und Längen am Profil, Berechnung von Kenngrößen und neue zusätzliche Kenngrößen integriert.

Was bedeutet das für die Industrie?

Die Neuerungen in der Normenreihe DIN EN ISO 21920 führen auf Grund der Änderungen teilweise zu anderen Ergebnissen für die Oberflächenbewertung, selbst wenn Ra und Rz spezifiziert sind. Für die Auswertung der Kenngröße Rz ist beispielsweise eine neue Berechnung der Spitzen und Täler in der Abschnittlänge (bisher als Einzelmessstrecke bezeichnet) zu berücksichtigen. Das kann dazu führen, dass es in einer Abschnittlänge keinen Rp– oder Rv-Wert gibt, aus dem sich der Rz-Wert zusammensetzt. Damit kann sich der aus üblicherweise fünf Rz-Werten gemittelte Wert gegenüber dem bisherigen Rz-Wert verändern.

Kritisch ist zudem der gleitende (undatierte) Verweis zwischen der alten und der neuen Norm. Die Verwendung des alten Oberflächensymbols (ohne zusätzliche Linie über dem Dreieck) ruft eigentlich die DIN EN ISO 1302 auf. Diese wurde aber mit der DIN EN ISO 21920-1 ersetzt. Ohne die Eintragung der DIN EN ISO 1302 in Verbindung mit dem Datum der Norm, zum Beispiel DIN EN ISO 1302:2002, wird automatisch auf die neue Norm verwiesen. Zur Vermeidung von Diskussionen zwischen Kunden und Lieferanten, aber auch internen Produktfreigaben, ist eine Auseinandersetzung mit den Neuerungen in den Normen unumgänglich.

Abb. 1: Altes Rauheitssymbol (links) und neues Rauheitssymbol (rechts)

Über die Autorin:

Prof. Dr.-Ing. habil. Sophie Gröger leitet seit 2015 die Professur Fertigungsmesstechnik an der Technischen Universität Chemnitz. Darüber hinaus arbeitet sie im DIN-Normenausschuss Technische Grundlagen (NATG), NA 152-03 Arbeitsausschuss CEN/ISO Geometrische Produktspezifikation und -prüfung mit und unterstützt Unternehmen bei der Einführung und Anwendung der ISO GPS-Normen.

EU KI-Gesetz: Neue Regelungen für sichere und gesetzeskonforme KI-Produkte

Von Predictive Maintenance und Kameraprüfungen bis hin zu intelligenten Konsumgütern – KI spielt eine entscheidende Rolle in der modernen Industrie. Das kürzlich verabschiedete EU KI-Gesetz bringt neue Anforderungen und Regulierungen, die erhebliche Auswirkungen auf die Entwicklung und den Einsatz von KI in Europa haben werden. Dieser Artikel erläutert grundsätzliche Begriffe der EU KI-Gesetzgebung und erklärt, worauf Unternehmen bei der Einführung neuer KI-Lösungen achten müssen.

Das KI-Gesetz definiert ein KI-System als „ein maschinengestütztes System, das für einen in unterschiedlichem Grade autonomen Betrieb ausgelegt ist und das nach seiner Betriebsaufnahme anpassungsfähig sein kann und das aus den erhaltenen Eingaben für explizite oder implizite Ziele ableitet, wie Ausgaben wie etwa Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen erstellt werden, die physische oder virtuelle Umgebungen beeinflussen können.“

Diese Definition von KI-Systemen ist deutlich breiter als der allgemeine Sprachgebrauch. Wenn heute von KI-Systemen die Rede ist, dann meist im Zusammenhang mit Chatbots wie ChatGPT oder Gemini. Tatsächlich sind in der Definition des KI-Gesetzes auch Systeme eingeschlossen, die heute bereits zum Alltag gehören, wie Empfehlungsalgorithmen bei YouTube oder Amazon. Auch Übersetzungsprogramme können in diese Kategorie fallen.

Das EU KI-Gesetz wurde entwickelt, um die sichere und ethische Nutzung von KI in Europa zu gewährleisten. Er schafft ein einheitliches Regelwerk, das Transparenz, Verantwortlichkeit und Sicherheit fördern soll. Ein gutes Beispiel für den Einsatz von KI-Systemen in der Industrie sind Predictive Maintenance-Anwendungen , zum Beispiel bei der Wartung von Windturbinen. Hierbei werden Maschinen und Anlagen kontinuierlich überwacht, um potenzielle Ausfälle frühzeitig zu erkennen und präventive Wartungsmaßnahmen durchzuführen. Diese prädiktiven Systeme nutzen große Mengen an Sensordaten und fortschrittliche Algorithmen, um Muster zu erkennen und Vorhersagen zu treffen.

Ein weiteres Beispiel sind automatische Kameraprüfungen. Klassische Kameraprüfungen arbeiten mit Helligkeits- oder Kantenerkennungen. Inzwischen setzen immer mehr Hersteller auf KI-Methoden, um Kameraprüfungen anhand von Beispielbildern zu trainieren. Auf diesem Weg lassen sich auch aufwändige Prüfungen realisieren, die ansonsten nur mit Hilfe von Werkern umsetzbar wären.

Das EU KI-Gesetz folgt einem risikobasierten Ansatz. Insbesondere wenn Sicherheitsaspekte oder die Interessen von natürlichen Personen berührt sind, müssen Anbieter von solchen KI-Systemen eine Vielzahl von Anforderungen einhalten. Solche Systeme fallen in der Regel in den Hochrisikobereich. In unserem letzten Artikel der Serie haben wir die grundsätzlichen Anforderungen an Hochrisiko-Systeme aufgelistet.

Prinzipien des KI-Gesetz zur Absicherung von KI-Systemen

Das KI-Gesetz folgt bei der Absicherung von KI-Systemen folgenden Prinzipien:

Transparenz:

KI-Systeme müssen so gestaltet sein, dass ihre Entscheidungen nachvollziehbar sind. Nutzer sollten erkennen, dass sie mit einem KI-System interagieren. Entscheidungen eines KI-Systems müssen im Zweifelsfall nachvollziehbar sein.

Sicherheit:

KI-Produkte müssen robuste Sicherheitsmaßnahmen enthalten, um Missbrauch und unerwünschte Auswirkungen zu verhindern.

Fairness und Datenschutz:

Der Schutz personenbezogener Daten muss gewährleistet sein. Entscheidungen und Empfehlungen müssen frei von ungerechtfertigter Diskriminierung sein. Diese Anforderungen sind bereits bei der Entwicklung des Systems zu berücksichtigen.

Überwachung und Verantwortlichkeit:

Es müssen Mechanismen zur kontinuierlichen Überwachung und Bewertung der KI-Systeme etabliert werden. Zudem ist klar festzulegen, wer die Verantwortung für das Funktionieren und die Entscheidungen der KI trägt.

Diese Prinzipen decken sich in großen Teilen mit denen vorangegangener Veröffentlichungen, wie dem KI-Prüfkatalog des Fraunhofer IAIS Instituts.

Herausforderungen bei der Absicherung von KI-Systemen

Eine Herausforderung bei der Absicherung von KI-Systemen besteht in der Tatsache, dass diese Systeme in der Regel lernfähig sind.

Traditionell produzierte Produkte durchlaufen in der Regel einen linearen Entwicklungsprozess: Design, Prototyping, Produktion, Qualitätskontrolle und schließlich Markteinführung. Diese traditionellen Produkte sind in ihrer Funktion festgelegt und ändern sich nicht wesentlich nach dem Verkauf. Auf lernfähige KI-Systeme trifft dies nicht zu. Sie können sich in ihrer Funktion durch das Erlernen neuer Informationen nach der Markteinführung noch verändern. Aus diesem Grund umfasst der Entwicklungsprozess von KI-Produkten nicht nur das ursprüngliche Design und die Produktion, sondern auch die Implementierung von Datenmanagementstrategien, die Entwicklung und das Training von Modellen sowie fortlaufende Überwachung und Updates nach der Markteinführung.

Für die praktische Umsetzung der gesetzlichen Vorgaben hat die EU der europäischen Normenorganisation Cen/Cenelec einen Normungsauftrag erteilt. In der Arbeitsgruppe JTC21 – Artificial Intelligence sind inzwischen 21 Normen und Richtlinen in Erstellung, die die unterschiedlichen Aspekte der EU KI-Gesetzgebung betreffen. Diese Normen regeln zum Beispiel das Qualitätsmodell für künstliche Intelligenz und beschreiben Methoden zur Vermeidung von ungewollten statistischen Verzerrungen (Bias) in Trainingsdatensätzen.

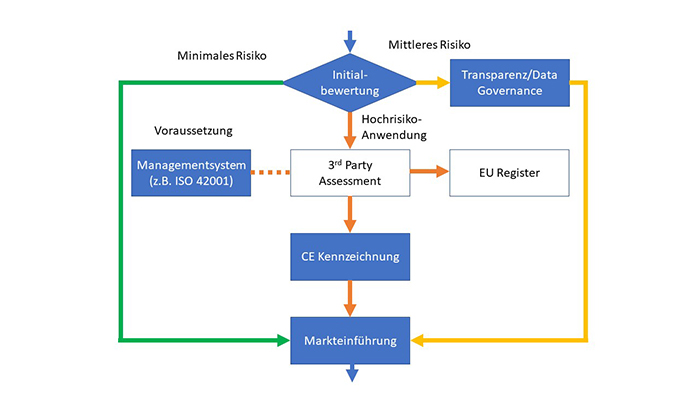

Unternehmen, die aktuell bereits KI in ihren Produkten einsetzen, sollten sich darauf einstellen, dass eine Vielzahl von Anforderungen in kurzer Zeit umgesetzt werden müssen. Ein Beispiel hierfür sind die Data Governance Anforderungen (CLC/TR 18115), die nach jetziger Planung am 29. August 2024 verabschiedet werden. Die zugehörigen gesetzlichen Anforderungen werden bereits im Mai 2025 verpflichtend für alle Systeme der mittleren und hohen Risikokategorie (siehe Abb. 1). Diese beiden Kategorien umfassen eine Vielzahl von Systemen von Chatbots über Empfehlungssysteme bis hin zu sicherheitskritischen Systemen (zum Beispiel in Medizin, Verkehr und Bildung).

Schritte zur Einführung von KI-Systemen gemäß EU-KI-Gesetzgebung

Das KI-Gesetz legt einen Großteil der Verantwortung für Absicherung zur Markteinführung und sicheren Betrieb in die Hände der Betreiber der KI-Systeme. Abbildung 1 zeigt die wichtigen Schritte zu Einführung von KI-Systemen gemäß EU KI-Gesetzgebung. Unternehmen, die KI einsetzen, müssen die eingesetzten KI-Systeme erfassen und die Risikokategorie selbstständig bestimmen. Unser KI-Selfassessment kann Sie bei dieser Aufgabe unterstützen. Eine nähere Beschreibung der Risikokategorien befindet sich im vorangegangenen Beitrag dieser Serie.

KI-Systeme, die in der EU zulässig sind, fallen in die Kategorien geringes Risiko (keine zusätzlichen gesetzlichen Anforderungen aus dem KI-Gesetz), mittleres Risiko (Transparenz- und Data-Governanceanforderungen) und Hochrisiko-Systeme.

Abb. 1: Einführung von KI-Systemen nach EU KI-Gesetz

Systeme mit mittlerem und geringem Risiko werden von den Unternehmen in Eigenregie überwacht. Für Hochrisiko-Systeme existieren weitere Anforderungen aus dem KI-Gesetz. Diese Anforderungen treten ab Mai 2026 in Kraft und werden nach Abschluss einer 12-monatigen Übergangsfrist im Mai 2027 verpflichtend. Bevor diese Hochrisiko-KI-Systeme in der EU in Verkehr gebracht werden dürfen, muss ein unabhängiges 3rd Party-Assessment durchgeführt werden. Voraussetzung für ein erfolgreiches 3rd Party-Assessment sind ein bestehendes Managementsystem und ein dazugehöriges Risikomanagement. In diesem Zusammenhang wird auch die ISO 42001:2023 als Systemnorm für künstliche Intelligenz an Bedeutung gewinnen. Sie ist zwar nicht explizit im Gesetzestext benannt, bietet aber eine gute Basis für die Entwicklung moderner KI-Systeme.

Nach bestandenem 3rd Party-Assessment muss die Hochrisiko-Anwendung in einer zentralen EU-Datenbank registriert werden. Auf dieser Basis kann das Unternehmen im Anschluss eine CE-Kennzeichnung erstellen und das Produkt in den Umlauf bringen.

Ausblick

Zusammenfassend kann gesagt werden, dass das EU KI-Gesetz einen bedeutenden Schritt zur Regulierung und Sicherstellung sicherer und ethischer KI-Systeme darstellt. Für Unternehmen bedeutet dies, dass sie ihre KI-Prozesse und -Produkte genau prüfen und an die neuen Anforderungen anpassen müssen. Der erste Schritt besteht in einer Bewertung der Risikokategorie aller bestehenden KI-Anwendungen, die bereits im Unternehmen oder in Produkten im Einsatz sind. Die Definition von KI-Systemen aus dem KI-Gesetz legt fest welche Systeme hierbei betrachtet werden müssen. Im zweiten Schritt muss die Einhaltung der relevanten Anforderungen sichergestellt werden. Hierbei sind insbesondere die Meilensteine für die Einhaltung der Transparenz- und Data Governance-Anforderungen ab Mai 2025 und das Ende der Übergangsfrist für Hochrisiko-Systeme im Mai 2027 zu beachten.

Lesen Sie mehr zum Thema “Künstliche Intelligenz in der Qualität” in den folgenden Fachbeiträgen:

- Teil 1: Künstliche Intelligenz in der Qualität – Bestehendes Know-how effektiv nutzen – zum Beitrag »

- Teil 2: Künstliche Intelligenz in der Qualität – Welche Qualifikationen werden benötigt? – zum Beitrag »

- Teil 3: Künstliche Intelligenz in der Qualität – Praktische Einführung durch iteratives Vorgehen – zum Beitrag »

Über die Autoren:

Dipl.-Ing. Waldemar Fahrenbruch ist Head of Q-Technology Division E-Mobility bei der ZF Friedrichshafen AG. Er ist verantwortlich für die Qualitätskostensenkung bei gleichzeitiger Optimierung von Qualitätskonzepten in den Werken der Division E (TCU, Power Electronics und E-Motoren Fertigung) durch Methodenkompetenz der Qualität, künstlicher Intelligenz und digitaler Transformation.

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Künstliche Intelligenz. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten. Kontakt: ki@prophet-analytics.de

Automatisierte Oberflächeninspektion dank industrieller Bildverarbeitung – welche Möglichkeiten gibt es?

Ein feiner Riss, eine abgebrochene Ecke, eine verfärbte Stelle – und es winkt die kostspielige Reklamation. Oberflächen sind der erste Kontaktpunkt zwischen einem Produkt und einem Kunden. Bereits kleinste Makel stören das Gesamtbild und beeinträchtigen die Kundenzufriedenheit. Neben ästhetischen Aspekten wirken sich viele Fehler auf die Funktionalität eines Produktes aus und reduzieren dessen Lebensdauer. Die Inspektion von Oberflächen bildet daher einen unverzichtbaren Bestandteil der Qualitätsprüfung.

Warum die manuelle Oberflächeninspektion an ihre Grenzen stößt

Oberflächenfehler sind vielfältig. Verschmutzungen und Verfärbungen entstehen oft durch Kontaminationen während der Produktion. Beim Gießen von Kunststoff oder Beton führen Verdichtungsfehler zu Lunkern im Material. Kratzer entstehen durch Reibung mit Schmutzpartikeln, während Risse unter anderem durch Spannungskonzentrationen oder hohe Temperaturen auftreten.

|

|

|

| Abb. 1: Automatisierte Risserkennung auf Beton (© IDS Imaging Development Systems GmbH) | Abb. 2: Automatisierte Risserkennung auf Beton (© IDS Imaging Development Systems GmbH) |

Unterschiedliche Werkstoffe bringen zusätzliche Herausforderungen mit sich. Spiegelnde Materialien wie Metalle, Lack und Glas erzeugen je nach Lichteinfall unterschiedliche Reflexionen, die Oberflächenfehler leicht tarnen. Gekrümmte Objekte erschweren es, alle Winkel zuverlässig zu inspizieren.

Weitere Schwierigkeiten sind komplexe oder sehr kleine Fehler, die mit bloßem Auge kaum erkennbar sind. Hohe Stückzahlen pro Tag machen die Oberflächeninspektion zu einer monotonen Tätigkeit, bei der Konzentrationsschwächen auftreten können. All diese Aspekte gestalten eine manuelle Inspektion fehleranfällig.

Bildverarbeitungslösungen machen unsichtbare Fehler sichtbar

Ob hundert oder tausend Teile – eine maschinelle Prüfung führt Oberflächenprüfungen zuverlässig durch und erzielt reproduzierbare Ergebnisse. Dafür werden Industriekameras beispielsweise über Förderbändern installiert. Die Kameras erzeugen hochauflösende Bilder der Objekte, die im Anschluss von einer Bildverarbeitungssoftware analysiert werden. Klassische Bildverarbeitung arbeitet mit vordefinierten Regeln und Algorithmen. Auf dieser Basis untersuchen Kameras Objekte Pixel für Pixel. Die Bildverarbeitungssoftware extrahiert Merkmale aus den Bildern und analysiert, ob sie mit den festgelegten Regeln übereinstimmen. Im Gegensatz zum menschlichen Auge ermöglicht die Bildverarbeitung eine kontinuierliche Überwachung aus verschiedenen Blickwinkeln und erkennt selbst mikroskopisch kleine Abweichungen vom Soll-Zustand.

Noch flexibler dank künstlicher Intelligenz

Viele Bildverarbeitungslösungen nutzen heutzutage künstliche Intelligenz (KI). Diese lernt, ähnlich wie ein Mensch, anhand von Bildern und Merkmalen, wie der gewünschte Zustand der zu prüfenden Objekte aussieht. Nach der Trainingseinheit ist sie in der Lage, unter verschiedenen Bedingungen flexibel zu agieren und eigenständig Rückschlüsse zu ziehen.

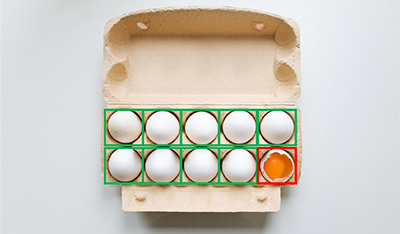

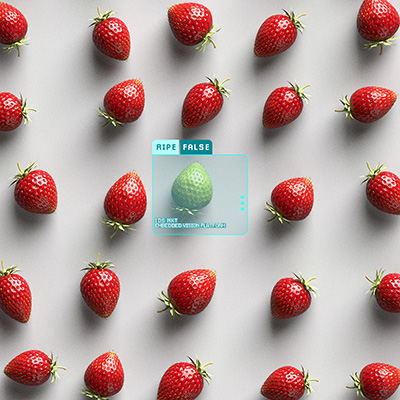

Bei unterschiedlichem Lichteinfall nimmt die künstliche Intelligenz beispielsweise automatische Beleuchtungskorrekturen vor und passt sich an neue Reflexionsmuster an. Des Weiteren besitzt ein Bildverarbeitungssystem mit künstlicher Intelligenz Stärken bei der Analyse von organischem Material, das in Form, Farbe und Struktur variiert. Früchte, Pflanzen und Menschen sehen immer unterschiedlich aus, weshalb keine Regeln vorprogrammiert werden können. Eine KI kann hingegen auch verschieden große Eier analysieren oder Gesichter voneinander unterscheiden.

|

|

|

| Abb. 3: Prüfung des Zustands von Eiern im Karton (© IDS Imaging Development Systems GmbH) | Abb. 4: Anomalieerkennung bei Pflanzen mit der IDS NXT (© IDS Imaging Development Systems GmbH) |

Von der Schweißnahtprüfung bis zur Reifegradbestimmung

Die Arbeitsweise der Bildverarbeitungslösungen kann überall eingesetzt werden, wo optische Qualitätskontrollen notwendig sind. Klassische Branchen und Beispiele sind:

- Automobilindustrie:

Lackkontrolle und Bauteilinspektion - Bauindustrie:

Schweißnahtkontrolle, Lunkererkennung in Beton- und Metalloberflächen, Kratzer- und Risserkennung in Fassaden, Fenstern und Türen - Kunststoffindustrie:

Kontrolle von Kunststoffteilen, Qualitätsprüfung von Spritzguss und Gusserzeugnissen - Elektroindustrie:

Defekterkennung an Leiterplatten, elektronischen Bauteilen und Gehäusen - Pharmaindustrie:

Inspektion von Tabletten sowie deren Verpackungen auf Beschädigungen oder Verunreinigungen, Etikettenkontrolle - Lebensmittelindustrie:

Pflanzenkrankheiten erkennen, Reifegradbestimmung von Obst und Gemüse

|

|

|

| Abb. 5: Reifegradbestimmung von Erdbeeren mit der IDS NXT (© IDS Imaging Development Systems GmbH) | Abb. 6: Kontrolle und Vermessung von Schweißnähten (© IDS Imaging Development Systems GmbH) |

Viele Industriekamerahersteller bieten heutzutage Bildverarbeitungslösungen für verschiedene Anwendungsfälle an. Des Weiteren hat sich der Marktplatz visionpier etabliert, auf dem sich über 120 Anwendungen befinden. Diese lassen sich in wenigen Schritten anfragen und auf individuelle Herausforderungen anpassen, ohne das eigene Kenntnisse in der industriellen Bildverarbeitung notwendig sind.

Zusammengefasst

Die automatisierte Oberflächeninspektion mithilfe industrieller Bildverarbeitung bietet präzise und zuverlässige Lösungen zur Erkennung selbst kleinster Fehler. Sie löst die Herausforderungen der manuellen Kontrolle und stellt sicher, dass Produkte höchste Qualitätsstandards erfüllen. Je nach Anwendungsfall kommt künstliche Intelligenz zum Einsatz, wodurch Anwendungen noch flexibler auf unterschiedliche Situationen reagieren können. Bildverarbeitungslösungen vereinen Hardware, Software und Integration, wodurch Unternehmen niederschwelligen Zugang zu zukunftsweisenden Technologien erhalten und wertvolle Entwicklungszeit sparen.

Über die Autorin:

Jacqueline Krauß arbeitet bei IDS Imaging Development Systems GmbH, einem langjährigen Mitglied der DGQ. IDS ist führender Industriekamerahersteller und Pionier in der industriellen Bildverarbeitung. Das Unternehmen mit Sitz in Obersulm, Baden-Württemberg, entwickelt 2D- und 3D-Kameras sowie Modelle mit künstlicher Intelligenz. Das nahezu unbegrenzte Anwendungsspektrum der Kameras erstreckt sich über verschiedenste nicht-industrielle sowie industrielle Branchen des Geräte , Anlagen- und Maschinenbaus. Mit dem Marktplatz visionpier bietet IDS Zugang zu über 120 Bildverarbeitungslösungen.

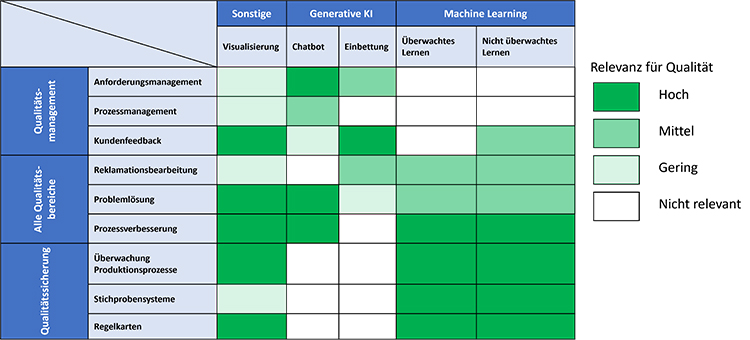

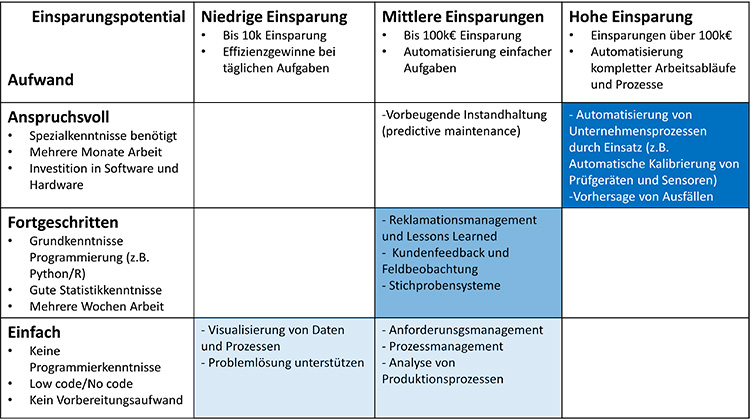

Neue Anforderungen für KI in Unternehmen: Die EU-KI-Gesetzgebung und ihre Auswirkungen auf das Qualitätswesen

Künstliche Intelligenz (KI) durchdringt immer mehr Bereiche des täglichen Lebens und der Arbeit. Lange Zeit war künstliche Intelligenz nur für Entwicklungs- und Technologiebereiche interessant. In den letzten Monaten lässt sich beobachten, dass KI immer mehr auch zum Qualitätsthema wird. Überall dort, wo KI eingesetzt wird, um Kundenbedürfnisse zu erfüllen, wird sie auch Gegenstand des Qualitätsmanagements. Viele Unternehmen nutzen KI bereits in ihren Produkten, in ihren Herstellungsprozessen oder im Kundensupport. Auf diese Unternehmen kommen nun neue Anforderungen zu. Dieser Artikel ist Teil einer Serie. Der erste Teil möchte die Leser mit grundsätzlichen Qualitätsanforderungen an KI-Systeme in der aktuellen Rechtslage vertraut machen. Der Beitrag zeigt die großen Parallelen zwischen dem EU-KI-Gesetz und QM-Methoden. Folgende Artikel werden sich mit unterschiedlichen Aspekten wie KI-Absicherung und KI-Zertifizierung auseinandersetzen.

Die EU hat im Dezember 2023 das EU-KI-Gesetz verabschiedet, welches seit April 2024 in überarbeiteter Form vorliegt. Dieses Gesetz definiert Anforderungen für den Betrieb von KI-Systemen in der Europäischen Union und schafft einen einheitlichen gesetzlichen Rahmen für Hersteller und Betreiber. Die EU-KI-Gesetzgebung bewertet KI-Systeme nach einem risikobasierten Ansatz, der starke Ähnlichkeit mit bestehenden Management-Systemen wie ISO 9001 oder ISO 14001 aufweist.

KI-Anwendungen mit unzulässigen Risiken

Abbildung 1 zeigt die vier Risikokategorien für KI-Systeme gemäß EU-KI-Gesetz. Die Einstufung in eine Risikokategorie ergibt sich im Wesentlichen aus den möglichen Auswirkungen auf interessierte Parteien wie Nutzer, die Gesellschaft als Ganzes oder die Umwelt. Das KI-Gesetz verwendet den Ausdruck interessierte Partei dabei nicht. Die oberste Kategorie bezeichnet KI-Anwendungen mit unzulässigen Risiken. Beispiele hierfür sind Social-scoring-Systeme, die dazu gedacht sind, das Verhalten von Menschen zu beeinflussen. Der Betrieb solcher Systeme ist in der EU nach Ablauf einer sechsmonatigen Übergangsfrist untersagt.

Abb. 1: Risikokategorien des EU-KI-Gesetzes mit Beispielen

KI-Systeme mit hohem Risiko

Die zweithöchste Kategorie sind KI-Systeme mit hohem Risiko. Allgemein fallen in diese Kategorie Systeme, die funktionale Sicherheitsanforderungen haben (zum Beispiel in der medizinischen Diagnostik oder dem Straßenverkehr) oder die persönlichen und wirtschaftlichen Interessen von natürlichen Personen betreffen (zum Beispiel im Finanzwesen oder der Bildung). Annex III des EU-KI-Gesetzes enthält eine Auflistung von Hochrisiko-Bereichen. In der aktuellen Fassung des wurde ein neues Kapitel zu KI-Modellen mit allgemeinem Verwendungszweck aufgenommen. Für Hersteller dieser Modelle, zu denen auch große Sprachmodelle zählen, gelten besondere Anforderungen (zum Beispiel gpt4, das Modell hinter ChatGPT). Je nach Komplexität des Modells können die Anforderungen im Hochrisiko-Bereich oder sogar darüber liegen, wenn ein systemisches Risiko festgestellt wurde.

Hochrisiko-KI-Systeme müssen eine CE-Kennzeichnung aufweisen und durch eine unabhängige dritte Stelle zertifiziert werden. Alle Hochrisiko-KI-Systeme müssen in einer zentralen EU-Datenbank registriert werden. Wenn erwiesen ist, dass ein KI-System aus einem Annex III gelisteten Bereich keinen Einfluss auf Sicherheit oder Interessen natürlicher Personen hat, dann kann das System auch als System mit mittlerem oder niedrigem Risiko behandelt werden. Die Pflicht zur externen Zertifizierung entfällt in diesem Fall, aber das System muss trotzdem an die zentrale EU-Datenbank gemeldet werden. Die Erfassung in der EU-Datenbank und die Zertifizierung gelten für einzelne KI-Produkte, nicht für eine Organisation als Ganzes. Die Zertifizierung muss für alle größeren Eingriffe wiederholt werden.

Für Hochrisiko-KI-Systeme stellt das EU-KI-Gesetz eine Vielzahl von Anforderungen. Eine genauere Betrachtung der Anforderungen wird in einem separaten Artikel besprochen. An dieser Stelle sollen nur die wichtigsten Anforderungen genannt werden:

- Einhaltung von Datenschutzvorschriften und Informationssicherheit

- Vorhandensein eines Qualitätsmanagementsystems

- Risikomanagement für vorhersehbare Fehler

- Verpflichtung zu Test und Validierung des KI-Systems

- Einhaltung der branchenspezifischen Vorschriften für funktionale Sicherheit

Die oben aufgeführten Stichpunkte zeigen den starken Überlapp zwischen der neuen EU-KI-Gesetzgebung und Methoden des klassischen Qualitätsmanagements. Aus diesem Grund gehen wir davon aus, dass das Qualitätsmanagement in Zukunft eine zentrale Rolle bei der Einführung und Überwachung von KI-Systemen einnehmen wird.

KI-Systeme mit mittlerem Risiko

Neben Hochrisiko-KI-Systemen gibt es noch Systeme mit mittlerem Risiko. In diese Kategorie fallen Systeme wie Chatbots für den Kundensupport. Diese Systeme haben nur unwesentliche persönliche und keine sicherheitsrelevanten Auswirkungen für Nutzer. Für diese Systeme gelten lediglich Transparenzanforderungen. Dies bedeutet, dass für Nutzer ersichtlich sein muss, wenn er mit einem KI-System interagiert. Der Nutzer muss ferner in Verständlicher Art und Weise über die Verarbeitung seiner Daten aufgeklärt werden. KI-generierte Inhalte sollten in maschinenlesbarer Art und Weise als solche gekennzeichnet sein (zum Beispiel durch Fingerprinting). Die EU arbeitet aktuell an einem Code of Conduct, der näher erklären soll, wie diese Anforderungen umzusetzen sind. Aktuell gibt es jedoch noch kein Veröffentlichungsdatum.

Es ist wichtig zu betonen, dass die Verantwortung für die Einhaltung von Transparenzregeln und Absicherung der korrekten Funktion hauptsächlich der Organisation zufällt, die das KI-System in Umlauf bringt. Dabei handelt es sich oft nicht um den Hersteller des KI-Modells. Insbesondere bei der Verwendung großer Sprachmodelle ist diese Unterscheidung wichtig. Chatbots sind in der Regel kundenspezifisch angepasst. Hersteller großer Sprachmodelle wie openAI agieren in diesem Fall als Lieferanten für Firmen, aber übernehmen in der Regel keine Haftung für firmenspezifische Anpassungen. Dieser Artikel beschreibt einige der Risiken, die dabei entstehen. Die Verantwortung für die Validierung der korrekten Funktion und die Einhaltung von Vorschriften obliegt der Firma, die das System für den Nutzer bereitstellt. Firmen werden somit selbst Prozesse zur Validierung ihrer KI -Lösungen implementieren müssen, wenn sie KI in ihren Produkten oder Prozessen nutzen möchten.

KI-Systeme mit vernachlässigbarem Risiko

Alle KI-Systeme, die nicht in die obersten drei Risikokategorien fallen, werden als Systeme mit vernachlässigbarem Risiko eingestuft. Für Anwendungen mit vernachlässigbarem Risiko stellt das KI-Gesetz neuen Anforderungen. Bestehende Anforderungen, zum Beispiel aus der Datenschutzgrundverordnung bleiben aber weiterhin bestehen. Wir stellen dazu ein kostenloses Self-Assessment bereit, mit dem die Risikoklasse einer KI-Anwendung bestimmt werden kann.

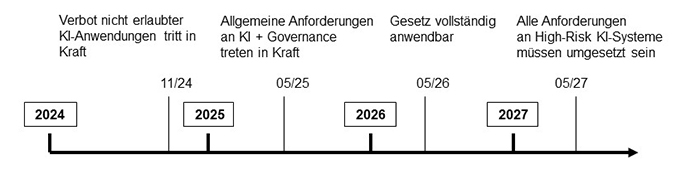

Abbildung 2 zeigt Umsetzungszeiten für die EU-KI-Gesetzgebung, wie sie zum 1. Mai 2024 bekannt waren. Das Verbot von Anwendungen mit unzulässigem Risiko wird bereits im November 2024 in Kraft treten. Die ersten Anforderungen, für Anwendungen mit mittlerem und hohem Risiko werden nach heutigem Kenntnisstand ab Mai 2025 in Kraft treten. Zu diesem Zeitpunkt greifen Verpflichtungen im Bezug auf Transparenz und Data Governance. Data Governance bedeutet, dass Trainings- und Testdatensätze alle für die Anwendung relevanten Kategorien oder Personengruppen abdecken müssen und dies auch nachvollziehbar zu dokumentieren ist.

Abb. 2: Zeitschiene der Implementierung der EU-KI-Gesetzgebung

Die Verpflichtung zur Zertifizierung von Hochrisikosystemen wird voraussichtlich ab Mai 2026 in Kraft treten, gefolgt von einem Übergangszeitraum von 12 Monaten. Spätestens im Mai 2027 müssen dann alle Anforderungen des KI-Gesetzes vollständig umgesetzt sein.

Auf Firmen, die bereits jetzt KI in ihren Produkten oder Prozessen nutzen, kommen daher in den nächsten Monaten folgende Aufgaben zu:

- Bewertung, in welche Risikokategorie die eingesetzten KI-Systeme fallen

- Zusammenstellung aller bindenden Verpflichtungen und Normenanforderungen

- Gesetze (mindestens Datenschutzgrundverordnung und KI-Gesetz)

- Managementsysteme (zum Beispiel ISO 9001:2015)

- Branchenstandards für funktionale Sicherheit (zum Beispiel ISO 26262 für Automotive)

- Erstellung der notwendigen Dokumentation (zum Beispiel für Risikomanagement)

- Test und Validierung der eingesetzten KI-Systeme

KI ist bereits heute in vielen Branchen eine zentrale Komponente der Wertschöpfungskette. Es ist davon auszugehen, dass KI-Assistenzsysteme mit mittlerem Risiko in den nächsten 24 Monaten branchenunabhängig in nahezu alle Bürotätigkeiten Einzug halten wird. Dabei werden KI-Systeme immer mehr Aufgaben übernehmen, die heute von Menschen erledigt werden. Das Qualitätsmanagement spielt eine entscheidende Rolle bei der Absicherung und gesetzeskonformen Umsetzung dieser Systeme. Es ist daher absehbar, dass in den nächsten Monaten ein erheblicher Trainingsbedarf im Bereich Qualitätsmanagement bestehen wird, um die Fachbereiche mit den neuen Anforderungen vertraut zu machen. Qualitätsverantwortliche sollten sich zeitnah mit den IT- und Rechtsbereichen ihrer Organisationen abstimmen um die Aufgabenverteilung, sowie die benötigten Ressourcen und die erforderlichen Qualifikationen zu bestimmen.

Lesen Sie mehr zum Thema “Künstliche Intelligenz in der Qualität” in den folgenden Fachbeiträgen:

- Teil 1: Künstliche Intelligenz in der Qualität – Bestehendes Know-how effektiv nutzen – zum Beitrag »

- Teil 2: Künstliche Intelligenz in der Qualität – Welche Qualifikationen werden benötigt? – zum Beitrag »

- Teil 3: Künstliche Intelligenz in der Qualität – Praktische Einführung durch iteratives Vorgehen – zum Beitrag »

Über die Autoren:

Dipl.-Ing. Waldemar Fahrenbruch ist Head of Q-Technology Division E-Mobility bei der ZF Friedrichshafen AG. Er ist verantwortlich für die Qualitätskostensenkung bei gleichzeitiger Optimierung von Qualitätskonzepten in den Werken der Division E (TCU, Power Electronics und E-Motoren Fertigung) durch Methodenkompetenz der Qualität, künstlicher Intelligenz und digitaler Transformation.

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Künstliche Intelligenz. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten. Kontakt: ki@prophet-analytics.de

Vertrauen stärken und Innovation ermöglichen: Eine digitale Qualitätsinfrastruktur für ein modernes Made-in-Germany

Produktion und Handel in immer komplexeren Wertschöpfungsnetzwerken, die fortschreitende digitale und grüne Transformation sowie technologische Innovationen sind in hohem Maße auf die verlässliche Sicherung und den effizienten Nachweis der Qualität, Sicherheit und Nachhaltigkeit von Waren, Dienstleistungen und Prozessen angewiesen. Unverzichtbar dafür ist eine moderne und leistungsfähige Qualitätsinfrastruktur (QI).

QI-Digital: Qualität smarter sichern

Im Rahmen der Initiative QI-Digital entwickeln die zentralen Akteure der Qualitätsinfrastruktur (QI) in Deutschland – die Bundesanstalt für Materialforschung und -prüfung (BAM), die Deutsche Akkreditierungsstelle (DAkkS), das Deutsche Institut für Normung (DIN), die Deutsche Kommission Elektrotechnik Elektronik Informationstechnik (DKE) und die Physikalisch-Technische Bundesanstalt (PTB) – gemeinsam mit Stakeholdern aus Wirtschaft und Forschung Lösungen für eine moderne Qualitätssicherung. Diese muss nicht nur den Anforderungen einer Wirtschaft gerecht werden, die zunehmend digital und vernetzt ist, sondern zudem nachhaltig und resilient sein.

Das Ziel: Qualität vertrauensvoll und effizient sichern und nachweisen. Gefördert wird die Initiative vom Bundesministerium für Wirtschaft und Klimaschutz (BMWK). Ein engagierter Beirat mit Mitgliedern aus Wirtschaft, Forschung und Verwaltung unterstützt bei der strategischen Ausrichtung, konkreten Umsetzung und der Vernetzung.

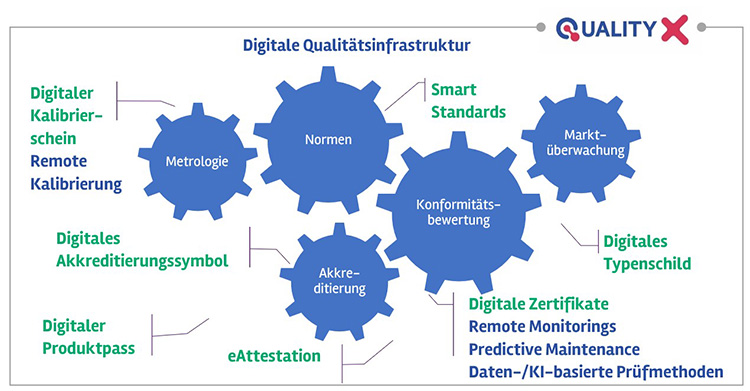

Abb. 1: Die Bundesanstalt für Materialforschung und -prüfung (BAM), die deutsche Akkreditierungsstelle DAkkS, die Normungsinstitute DIN und DKE sowie die Physikalisch-Technische Bundesanstalt (PTB) haben sich zur Initiative QI-Digital zusammengeschlossen. Quelle: QI-Digital.

Von einer Dokumenten- hin zu einer Datenbasierten Qualitätssicherung

Durch das Zusammenspiel von Metrologie, Normung, Konformitätsbewertung, Akkreditierung und Marktüberwachung bildet die QI die Grundlage für funktionierenden internationalen Handel und das Qualitäts-Label “Made in Germany“. Die QI selbst ist ein komplexes System aus regulativen Rahmenbedingungen und verschiedenen Institutionen, Werkzeugen und Prozessen – ihre digitale Transformation ein entsprechend umfangreiches Vorhaben.

Das Zielbild einer digitalen QI umfasst dabei datenbasierte und automatisierte Verfahren für Qualitätssicherung und -nachweis sowie einen Werkzeugkasten unter anderem aus Smart Standards und maschinenlesbaren Konformitätsnachweisen mit digitalem Akkreditierungssymbol (eAttestation). Diese bilden zusammen ein digitales Ökosystem für die QI, das es Unternehmen und anderen privatwirtschaftlichen und hoheitlichen Akteuren in Wertschöpfungsnetzwerken ermöglicht, vertrauensvoll, souverän und effizient qualitätsrelevante Daten, Informationen und Dokumentationen bereitzustellen, zu nutzen und auszutauschen. Die bisher weitgehend dokumentenbasierte, analoge und statische Qualitätssicherung wird damit fundamental transformiert hin zu einem datenbasierten, smarten System, das auf nutzungsorientierten, vorausschauenden Ansätzen fußt, die den modernen Anforderungen der Industrie 4.0 gerecht werden und effizient für nachhaltiges Vertrauen und Transparenz sorgen.

Abb. 2: Zielbild einer digitalen Qualitätsinfrastruktur: Digitale QI-Werkzeuge, -Verfahren und -Prozesse ermöglichen eine durchgängige Integration in Qualitätssicherungsprozesse der Industrie 4.0 sowie Transparenz und Vertrauen entlang der Wertschöpfungskette. Quelle: QI-Digital

Bürokratieaufwand reduzieren

Die Anforderungen an die Umsetzung regulatorischer Vorgaben steigen für Unternehmen stetig an. Die schon bald geforderte Implementierung des Digitalen Produktpasses in der EU im Rahmen der neuen Verordnung für nachhaltige Produkte (ESPR) ist nur ein Beispiel dafür. Digitale Innovationen in der QI sind hierbei ein Schlüssel, um diese bürokratischen Herausforderungen zu bewältigen, wie Dr. Gunter Kegel, Präsident des Verbands der Elektro- und Digitalindustrie ZVEI e.V., bei einem Austausch der Initiative QI-Digital mit Bundestagsabgeordneten zu Beginn des Jahres hervorhob. Voraussetzung ist es, von der analogen, dokumentenbasierten Qualitätssicherung hin zu einer datenbasierten Arbeitsweise zu kommen. Mithilfe digitaler Prozesse und Werkzeuge der QI lasse sich der personelle und administrative Aufwand für die Unternehmen wesentlich reduzieren und die Wettbewerbsfähigkeit der deutschen und europäischen Wirtschaft auch künftig sichern. Dies gilt nicht zuletzt vor dem Hintergrund des absehbar zunehmenden Fachkräftemangels.

Datenräume für die QI: Quality-X

Die Initiative QI-Digital entwickelt die nötigen digitalen Werkzeuge und Verfahren. Das wahre Potenzial der digitalen QI entfaltet sich erst, wenn ihre Akteure und Prozesse systemübergreifend und nahtlos in ein kohärentes digitales QI-Ökosystem integriert werden. Die jüngsten Entwicklungen hin zu industriellen internationalen Datenräumen ermöglichen ein solches Ökosystem.

Kernstück des angestrebten digitalen QI-Ökosystems ist Quality-X, eine föderierte Plattform zur Vernetzung von Institutionen und einfachen, sicheren Austausch qualitätsbezogener Daten und Informationen auf Basis internationaler Datenräume mit standardisierten Schnittstellen. Quality-X soll es Unternehmen erleichtern, Qualitätsnachweise zu erbringen und gleichzeitig Souveränität sichern, u.a. mit definierten Zugriffsberechtigungen. Basierend auf den Gaia-X-Grundsätzen, die Transparenz, Offenheit, Datenschutz und Sicherheit betonen, orientiert sich das Projekt an den technischen und rechtlichen Rahmenbedingungen bekannter Gaia-X-Leuchtturmprojekte wie Catena-X und Manufacturing-X. In einem Whitepaper hat die Initiative QI-Digital Konzept und Idee von Quality-X zusammengefasst.

Umsetzung anhand greifbarer, praxisrelevanter Pilotprojekte

Aufgrund der Komplexität der Prozesse, Verfahren und Werkzeuge der QI, werden die Lösungen entlang konkreter, praxisrelevanter Anwendungen der Qualitätssicherung in der modernen Produktion (Industrie 4.0) und dem Betrieb technischer Anlagen entwickelt, erprobt und demonstriert. Dazu dienen der Initiative praxisnahe Testumgebungen, die die Bundesanstalt für Materialforschung und -prüfung (BAM) im Rahmen der beiden Pilotprojekte „Additive Fertigung“ und „Verlässliche Wasserstofftankstelle“ bereitstellt. Neben Forschung und Entwicklung an modernen Prüfmethoden werden dort die digitalen Werkzeuge der QI erprobt und ihr Zusammenwirken demonstriert. So können integrierte Prozessketten dargestellt werden – vom Einlesen digital über Smart Standards bereitgestellter Normen-Anforderungen (siehe Initiative IDiS von DIN und DKE) über die prozessbegleitende Konformitätsbewertung mittels moderner (Prüf-)Verfahren hin zum automatisierten Erstellen von maschinenlesbaren Prüfberichten und anderer Konformitätsnachweise, eingebettet in das datenraumbasierte System Quality-X.

Dabei zeigt sich deutlich die zunehmende Bedeutung Künstlicher Intelligenz (KI) auch für die QI: Ganz neue Datenverfügbarkeit durch Sensortechnologien, thermographische Bildaufnahmen und andere moderne Ansätze eröffnet bisher ungekannte Möglichkeiten für die Qualitätssicherung. Entsprechende digitale, datenbasierte Prüfverfahren unter Nutzung von KI werden an der BAM entwickelt. Zudem wird das Potenzial des Federated Learning via Data Spaces erkundet. Umgekehrt ist auch die Frage der Vertrauenswürdigkeit von KI-Anwendungen ein zentrales Thema in QI-Digital. Damit der Einsatz qualitätsgesichert und vertrauensvoll erfolgen kann, werden bspw. an der PTB für den Gesundheitsbereich die Grundlagen messbarer Qualitätskriterien und Verfahren entwickelt.

Begleitforschungsaktivitäten und Stakeholder-Einbindung

Anwender und andere relevante Akteure über aktives Stakeholder-Engagement und umfassende Transferaktivtäten eng einzubeziehen, ist ein zentrales Anliegen der Initiative QI-Digital. Nicht nur ein engagierter Beirat steuert wertvolle Impulse bei. Auch ein stetig wachsendes Netzwerk liefert wichtige Informationen zu Anforderungen aus der Praxis, die in die Entwicklung der Lösungen einfließen.

Eine tragende Säule der QI sind Konformitätsbewertungsstellen. Um ihre Perspektiven und Erwartungen an eine digitale QI zu erfassen, hat die BAM in Kooperation mit der DAkkS und dem Verband Unabhängiger Prüflaboratorien (VUP) einen zielgerichteten, professionell begleiteten Dialogprozess für Prüf- und Kalibrierlabore mit ko-kreativen Online-Workshops aufgesetzt. Die gewonnenen Erkenntnisse aus diesen Praxiswerkstätten erlauben es, die Arbeit der Initiative noch stärker an den Praxis-Bedarfen auszurichten und weiterzuentwickeln.

Entsprechende konkrete Folgeprojekte mit interessierten Laboren bspw. zu Quality-X werden folgen. Weitere Begleitforschungsprojekte wie bspw. eine Trendstudie zur Zukunft der QI oder die internationale Vergleichsstudie der BAM zum Stand der Digitalisierung in der Konformitätsbewertung erlauben nicht nur vertiefte Erkenntnisse, sondern dienen auch der nachhaltigen Vernetzung.

Holistischer Ansatz: Technische Lösungen und geeignete Rahmenbedingungen

Ein solcher umfassender Stakeholderdialog ist auch deshalb wichtig, da neue digitale Lösungen in der QI, sowohl auf technischer als auch prozessualer Ebene zwischen Akteuren, Unternehmen (Hersteller/Inverkehrbringer/Betreiber) genauso wie Behörden/öffentliche Verwaltung (Genehmiger, Marktüberwacher, und andere), privatwirtschaftliche Konformitätsbewerter und andere Stakeholder betreffen. Die digitale Transformation der QI muss daher ganzheitlich auf verschiedenen Ebenen betrachtet werden. Sie bedeutet nicht nur technische Innovationen für Werkzeuge und Verfahren allein. Vielmehr erfordern digitale, transformative Lösungen die Gestaltung weitreichender Rahmenbedingungen an der Schnittstelle von Politik, Wirtschaft und Forschung.

Eine wesentliche Hürde können nötige Anpassungen des Rechtsrahmens sein, um innovative Lösungen tatsächlich in die Anwendung bringen zu können. Der bestehende Rechtsrahmen – von europäischen Richtlinien im Rahmen des New Legislative Frameworks über bundesdeutsche Gesetzgebung, technische Regeln bis hin zu kommunalen Verordnungen – kann mitunter so gestaltet sein, dass dieser die Einführung und Nutzung neuer, digitaler Lösungen behindert. Dies kann diverse Anwendungsbereiche betreffen – von Produktsicherheit über Umwelt- und Verbraucherschutz hin zu Handelsrecht. Es stellen sich daher die Fragen, inwiefern der bestehende Rechtsrahmen für eine digitale QI geeignet ist, bspw. welche Hürden, Hemmnisse (Stichwort Schriftformerfordernis), aber auch Potentiale sowie Anpassungsbedarfe und Gestaltungsoptionen bestehen. Im Rahmen einer von der BAM beauftragten juristischen Fachstudie werden daher gezielt alle Ebenen der Regelsetzung nach Lücken und Hindernissen für digitale Innovationen der QI untersucht. Entsprechende Analysen und abgeleitete Handlungsempfehlungen werden mit den zuständigen Akteuren, bspw. Gesetzgebern und Ministerien, aktiv geteilt und diskutiert.

Darüber hinaus ist die Initiative QI-Digital aktiv in relevanten Roadmapping-Prozessen und Normungsgremien (unter anderem bspw. zum Digitalen Produktpass) beteiligt.

QI-Digital Forum 2024

Das Jahr 2024 hält einige zentrale Entwicklungen für die QI bereit: Die EU verabschiedet den AI Act, der Digitale Produktpass nimmt Gestalt an und immer mehr europäische Datenraumkonzepte versprechen sichere digitale Ökosysteme. Diese Themen stehen daher auch im Fokus des 3. QI-Digital Forums, das am 9. und 10. Oktober an der BAM in Berlin stattfindet.

Unter dem Titel “AI Act, Data Spaces and Digital Product Passport – Setting the course for a green and digital transition“ erwarten die Besucher:innen spannende Keynotes, Paneldiskussionen und Fachvorträge sowie ein interaktiver Marktplatz mit Ausstellern und Exponaten rund um die Digitalisierung der QI. Außerdem werden Ergebnisse und Demonstratoren zu den Pilotprojekten und digitalen QI-Werkzeugen vorgestellt, die im Rahmen der Initiative QI-Digital entwickelt werden. Zudem bietet das QI-Digital Forum eine gute Gelegenheit, sich zu vernetzen und mit weiteren Stakeholdern aus der QI Herausforderungen und Chancen der Digitalisierung zu diskutieren. Mehr Informationen und die Anmeldung für eine Teilnahme vor Ort oder virtuell sind über die Website der Initiative unter www.qi-digital.de abrufbar.

Abb. 3: Das QI-Digital Forum 9. und 10. Oktober 2024 an der BAM bietet spannende Keynotes, Paneldiskussionen und Fachvorträge sowie einen interaktiven Marktplatz mit Ausstellern und Exponaten rund um die Digitalisierung der QI – und natürlich viel Gelegenheit zum Netzwerken. Quelle: QI-Digital

Einladung zur Beteiligung

Für die notwendige Weiterentwicklung der digitalen QI bedarf es des Engagements von Stakeholdern aus der QI, Wirtschaft, Politik, Verwaltung und Forschung – in Deutschland und darüber hinaus. Die Initiative QI-Digital begrüßt daher ausdrücklich die Beteiligung von Unternehmen und weiteren interessierten Akteuren.

Kontakt:

www.qi-digital.de

info@qi-digital.de

Über die Autoren:

Dr. Claudia Koch leitet das Referat Digitalisierung der Qualitätsinfrastruktur an der Bundesanstalt für Materialforschung und -prüfung (BAM) und ist Koordinatorin der BAM für die Initiative QI-Digital. Sie hat Betriebswirtschaftslehre und Internationales Wirtschaftsrecht studiert und in Innovationsökonomie an der TU Berlin promoviert.

Dr. Anna Maria Elert ist Koordinatorin der BAM für QI-Digital mit besonderem Schwerpunkt auf Themen rund um die Qualitätssicherung an technischen Anlagen. Sie hat im Fachgebiet Chemical Technology promoviert.

Lena Meyer koordiniert für die BAM QI-Digital-Aktivitäten mit Fokus auf Themen der modernen Produktion. Sie hat einen Masterabschluss in Produktionstechnik (Maschinenbau und Verfahrenstechnik).

Kontinuierliche Eignung von Prüfprozessen nach VDA Band 5 – Hintergrund und praktische Umsetzung

Die Neuauflage des VDA Band 5 aus dem Jahr 2021 enthält eine Vielzahl von Neuerungen, die für Unternehmen im Automobilbereich in Zukunft wichtig werden. Eine der wichtigsten Neuerungen stellt die Forderung eines fortlaufenden Eignungsnachweises für kritische Prüfprozesse dar. Dieser Fachbeitrag erklärt die technischen und normativen Hintergründe der Anforderung und stellt konkrete Umsetzungsmöglichkeiten dar.

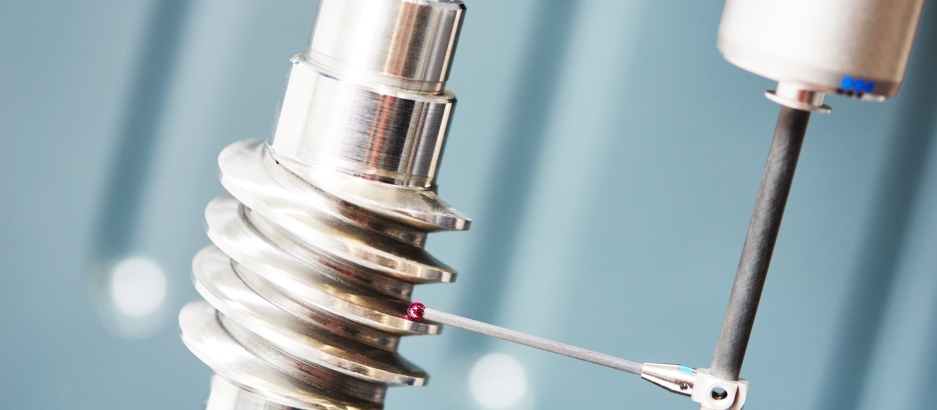

Die ISO 9001:2015 definiert Begriffe für die korrekte Funktion von Prüfmitteln. Grundsätzlich müssen im Kontext der ISO 9001:2015 zu jedem Zeitpunkt Eignung und Rückführbarkeit von Prüfmitteln sichergestellt sein. Diese beiden Anforderungen finden sich in vergleichbarer Form in Automobilspezifischen Normen wie der IATF 16949 oder dem VDA Band 5 wieder. Der VDA Band 5 beschreibt unter anderem, wie Eignung und Rückführbarkeit statistisch nachgewiesen werden können. Die Nachweispflicht gilt für alle Sensoren, Messgeräte und sonstige Hilfsmittel, bei denen eine Kundenspezifikation abgeprüft wird.

Um zu verstehen, was der VDA Band 5 unter einem fortlaufenden Eignungsnachweis versteht, ist es hilfreich zu veranschaulichen was die beiden Begriffe Rückführbarkeit und Eignung bedeuten:

| Begriffsdefinition Rückführbarkeit Rückführbarkeit stellt sicher, dass Messungen verschiedener Messmittel untereinander vergleichbar sind. So ist z.B. sichergestellt, dass Kunden und Lieferanten bei Messungen an Produkten zu gleichen Ergebnissen kommen. Die Vergleichbarkeit wird durch regelmäßige Kalibrierung sichergestellt. Das Kalibrierergebnis setzt sich aus Kalibrierabweichung und Kalibrierunsicherheit zusammen. Aus dem Kalibrierergebnis lässt sich eine Obergrenze für den systematischen Messfehler ableiten. Kalibrierung findet in regelmäßigen Intervallen und unter kontrollierten Bedingungen außerhalb des laufenden Produktionsprozesses statt. |

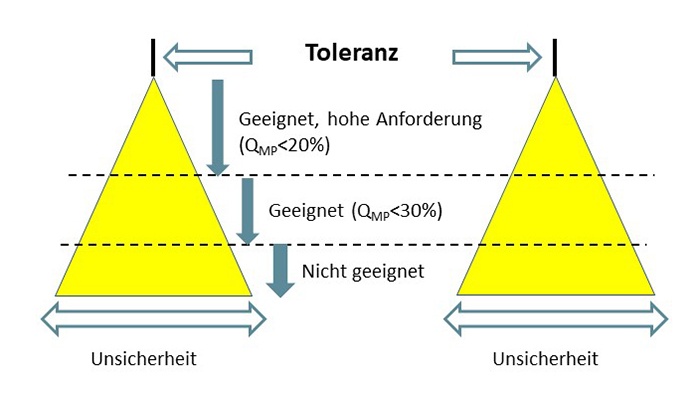

| Begriffsdefinition Eignung Eignung beschreibt die Unsicherheit einer Messung im Verhältnis zu einer gegebenen Toleranz (z.B. ein Zeichnungsmaß). Je kleiner die Unsicherheit einer Messung im Verhältnis zur Toleranz, desto höher ist die Eignung eines Messmittels für eine gegebene Prüfaufgabe. Abbildung 1 stellt den Sachverhalt grafisch dar. Wichtig ist, dass ein Eignungsnachweis immer unter Berücksichtigung der realen Anwendungsbedingungen geführt werden muss. Alle Einflussfaktoren, die im Serienprüfprozess wirksam sind, müssen auch im Eignungsnachweis berücksichtigt werden. Der systematische Messfehler aus der Kalibrierung ist somit einer von mehreren Einflussfaktoren, die zur Messunsicherheit beitragen. |

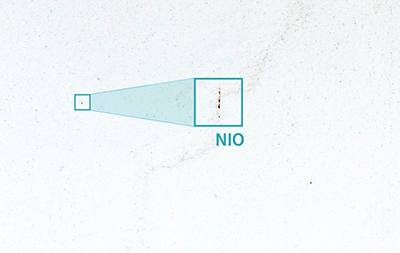

Abb. 1: Schematische Darstellung von Eignung nach VDA Band 5. Der gelb hinterlegte Bereich stellt den Unsicherheitsbereich der Messung dar.

Sicherstellung der fortlaufenden Eignung eines Prüfsystems

Bisher war es in vielen Firmen gelebte Praxis, den Eignungsnachweis einmalig bei der Inbetriebnahme oder nach größeren Änderungen durchzuführen. Die korrekte Funktion des Prüfmittels wurde lediglich über die regelmäßige Kalibrierung abgesichert. Dahinter steckt die Annahme, dass sich die Messunsicherheit eines Prüfmittels während des Betriebes nicht nennenswert verändert. Aus technischer Sicht ist dies jedoch eine gewagte Annahme. In vielen Messprozessen wird die Unsicherheit stark von äußeren Einflüssen bestimmt. Maschinen und Messaufnahmen und elektrische Kontaktierungen unterliegen beispielsweise dem Verschleiß, der über die Zeit hinweg zu einer höheren Messunsicherheit führen kann. Viele dieser äußeren Einflüsse auf die Messunsicherheit bleiben bei der regelmäßigen Kalibrierung jedoch unsichtbar.

An dieser Stelle setzt der neue VDA Band 5 an. In Kapitel 10 über die fortlaufende Eignung steht geschrieben: “Die Beurteilung der fortlaufenden Eignung, bislang oft auch als Stabilitätsüberwachung oder Messbeständigkeit genannt, hat aufgrund der Normenanforderung in der ISO 9001 an Bedeutung gewonnen.” Und weiter: “Die regelmäßige Kalibrierung der Messmittel ist im Rahmen der Prozesse zur Prüfmittelüberwachung unumgänglich (siehe Kapitel 4.5.2), reicht aber in vielen Fällen für eine umfassende Stabilitätsüberwachung nicht aus, da die Kalibrierung nicht unter tatsächlichen Einsatzgegebenheiten durchgeführt wird.”

Der VDA Band 5 stellt somit deutlich heraus, dass nicht alle Einflussfaktoren auf die Messunsicherheit durch Kalibrierung abgesichert werden können. Aus diesem Grund reicht die regemäßige Kalibrierung allein nicht aus, um fortlaufende Eignung eines Prüfsystems nachzuweisen.

Da Eignungsnachweise in der Regel mit erheblichem Aufwand verbunden sind, stellt sich die Frage, für welche Prüfprozesse ein fortlaufender Eignungsnachweis erforderlich ist. Der VDA Band 5 fordert insbesondere für sicherheitskritische und zulassungskritische Merkmale Absicherungsmaßnahmen, um die fortlaufende Eignung von Prüfprozessen sicherzustellen. In verringertem Umfang gilt diese Anforderung auch für Prüfungen von funktionswichtigen Merkmalen und Messungen, die direkten Einfluss auf die Produktqualität haben.

Praktische Umsetzung des kontinuierlichen Eignungsnachweises

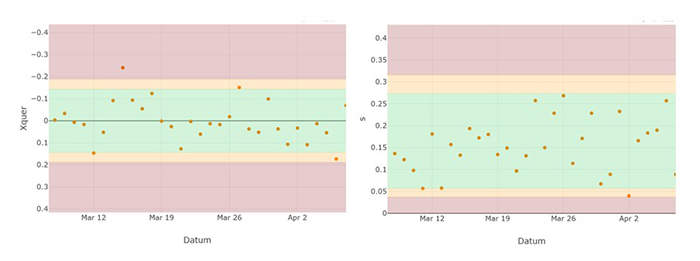

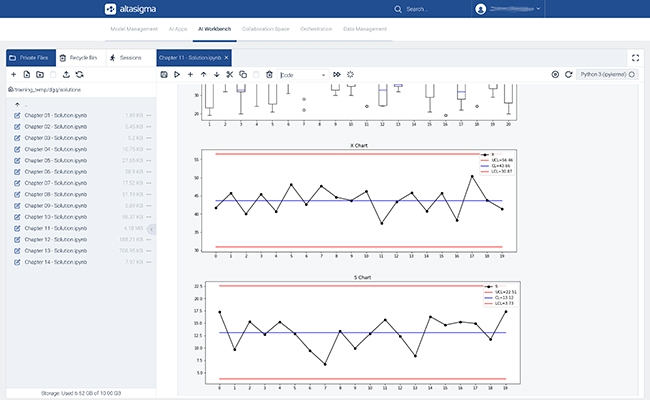

Neben der Frage, für welche Prüfprozesse fortlaufende Eignung gefordert ist, ist die praktische Umsetzung eines solchen kontinuierlichen Eignungsnachweises besonders wichtig. Der zusätzliche Aufwand, der durch den kontinuierlichen Eignungsnachweis entsteht, sollte dabei so gering wie möglich ausfallen. Der VDA Band 5 schlägt zur praktischen Umsetzung einer fortlaufenden Eignungsprüfung den Einsatz von Regelkarten vor. Um die Daten für die Regelkarte zu erheben, werden regelmäßig ein oder mehrere Meisterteile geprüft und die Messwerte erfasst. Die Meisterteile sollten in sich stabil sein und ihre Messwerte über die Zeit hinweg möglichst wenig ändern. Auf diesem Weg kann die Stabilität eines Messprozesses in Bezug auf Lage und Streuung überwacht werden. Häufigkeit und Umfang der Prüfung werden auf Basis des Risikos festgelegt. Im VDA Band 5 werden als Beispiel klassische x ̅-s Karten mit einer Eingriffsgrenze von drei Standardabweichungen (99,73% Vertrauensniveau) oder gleitende Mittelwertkarten vorgeschlagen.

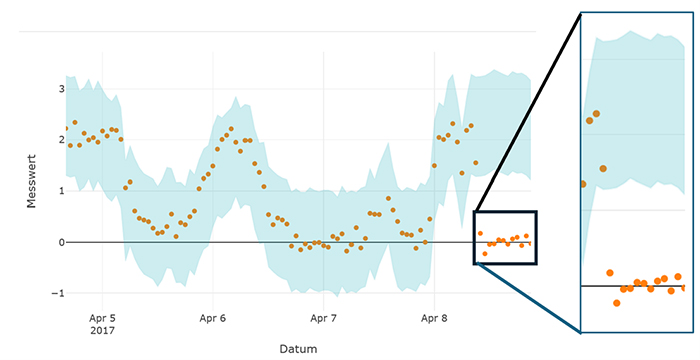

Abbildung 2 zeigt eine Regelkarte mit x ̅- und s-Spur, die zur Stabilitätsüberwachung eingesetzt werden kann. Der Nachteil der Regelkartentechnik besteht im beträchtlichen zeitlichen Aufwand. Prüfstände für komplexe Produkte wie Steuergeräte oder Getriebe haben hunderte von Prüfungen. Selbst wenn nur ein Teil der Messungen für die fortlaufende Eignung ausgewählt wird, kommen auf diese Art schnell dutzende Regelkarten zusammen.

Abb. 2: Zweispurige Stabilitätskarte zur Überwachung von Lage und Streuung eines Messprozesses. Die Eingriffsgrenzen sind rot gekennzeichnet. Zur besseren Orientierung wurden zusätzlich auch die Warngrenzen in Gelb dargestellt.

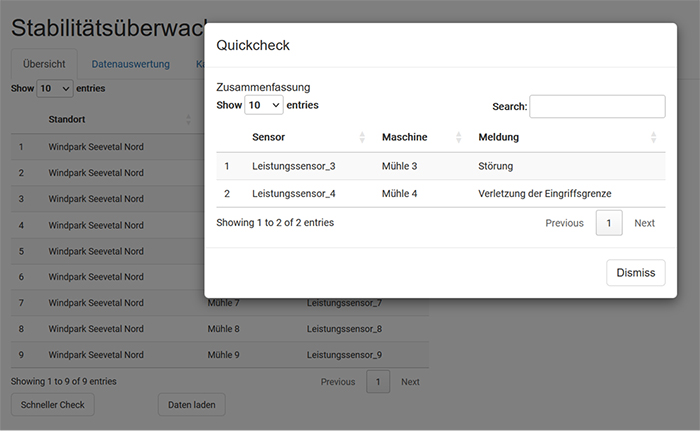

Automatische Überwachung von Prüfprozessen mittels Softwarelösung

Eine digitale Auswertung von Messdaten kann den zeitlichen Aufwand für den kontinuierlichen Eignungsnachweis erheblich reduzieren. Prophet Analytics bietet eine Softwarelösung, die Prüfprozesse automatisch überwacht und bei Abweichungen Benachrichtigungen erzeugt. So ist es nicht länger notwendig, jede Regelkarte manuell zu führen und zu bewerten. Verletzungen von Eingriffs- und Warngrenzen können über automatische Benachrichtigungen gelenkt werden.

Obwohl die Regelkartentechnik das Risiko fehlerhafter Messungen deutlich verringert, erlaubt dieser Ansatz streng genommen keine fortlaufende Eignungsprüfung. Regelkarten basieren grundsätzlich auf Stichprobenprüfungen und geben somit immer nur eine Momentaufnahme wieder. Einflussfaktoren, die nur sporadisch wirksam sind, können durch Regelkarten nicht zuverlässig überwacht werden. Ein zweiter Nachteil der Regelkartentechnik ist die Tatsache, dass das Einlegen der Meisterteile in der Regel einen Eingriff in den normalen Produktionsprozess bedeutet. In Produktionsanlagen und Maschinen, die auf eine kontinuierliche Fertigung ausgelegt sind, ist so ein Eingriff nicht möglich. Beispiele hierfür sind chemische Prozesse oder die Herstellung von Blechen oder Folien.

Prophet Analytics bietet auch eine Lösung zur Stabilitätsüberwachung für Maschinen, bei denen keine Meisterteile verwendet werden können. Eine Überwachung von einzelnen Prüfmitteln ist dann möglich, wenn weitere Daten aus unterschiedlichen Quellen verfügbar sind. Abbildung 3 zeigt eine schematische Darstellung des Verfahrens. Das Verfahren nutzt Daten aus Messungen, die von anderen Prüfeinrichtungen erhoben wurden und mit dem zu überwachenden Prüfmittel korreliert sind.

Abb. 3: Schematische Darstellung des Korrelationsverfahrens zur Stabilitätsüberwachung von Messprozessen.

Anwendung des Korrelationsverfahren in der Automobilindustrie

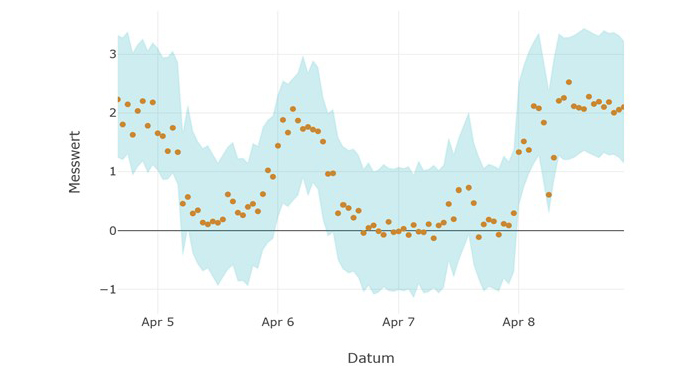

Ein Anwendungsbeispiel für das Korrelationsverfahren ist die Fertigung von Steuergeräten in der Automobilindustrie. Steuergeräte werden häufig mehrfach bei unterschiedlichen Temperaturen geprüft. Die Messwerte an den unterschiedlichen Prüfstationen sind korreliert. Durch Vergleich der Messwerte an den unterschiedlichen Prüfstationen kann eine Prognose für den erwarteten Messwert und ein plausibler Streubereich ermittelt werden. Abbildung 4 zeigt Messungen eines Prüfprozesses und den Zufallsstreubereich der Messung, der mit Hilfe des Korrelationsverfahrens ermittelt wurde. Messwerte außerhalb des blauen Zufallsstreubereichs würden auf eine Fehlfunktion des Messgeräts hindeuten.

Abb. 4: Daten eines Messgeräts (Punkte). Die blau hinterlegte Fläche zeigt Zufallsstreubereich an.

Das Korrelations-Verfahren hat zwei entscheidende Vorteile gegenüber der Regelkartentechnik: Es basiert nicht auf Stichproben und ermöglicht daher je nach Anlagenaufbau bis zu 100 Prozent Überwachung. Außerdem ist das Korrelationsverfahren aufwandsneutral, weil bestehende Daten aus dem laufenden Prozess verwendet werden und kein händischer Prozesseingriff mehr erforderlich ist. Das Korrelationsverfahren und das Regelkartenverfahren lassen sich unabhängig voneinander oder in Kombination anwenden (siehe Beispielanwendung einer Stabilitätsüberwachung).

Fazit