Die digitale Transformation in akkreditierten Laboren: Aktueller Stand, Herausforderungen und Chancen, Teil 1

Die Digitalisierung ist in aller Munde und macht auch vor den Laboren nicht Halt. Immer mehr Finanztöpfe werden für die digitale Transformation bereitgestellt, immer mehr Budgets freigegeben.

Aber wie ist der aktuelle Stand in den akkreditierten Laboren? Welche Hindernisse blockieren die digitale Transformation? Und welche Möglichkeiten eröffnen sich zum Beispiel durch generative KI? Gibt es das Labor 4.0 schon? Diese Fragen werden im Rahmen dieses Artikels und des zweiten Teils erörtert.

Das VUP-Konjunkturbarometer, welches vom VUP Deutscher Verband Unabhängiger Prüflaboratorien e.V. herausgegeben wird, vom November 2023 zeigt: Der Bereich IT und Digitalisierung hält mit 0,5 sein positives Niveau und trotzt der Krisensituation, obwohl in den akkreditierten Laboren in vielen Bereichen weniger investiert wird. Die Laborbranche investiert damit ganz gezielt in Zukunftstechnologien. Auch die QZ (Ausgabe 5/24) beschreibt in einem Artikel, dass die Investitionen für KI 2024 im Durchschnitt um 30 Prozent erhöht wurden. Die Labore richten hohe Erwartungen an die Digitalisierung hinsichtlich Effizienzsteigerung und Ausweitung der Geschäftsfelder. Doch laut einer aktuellen Horváth-Studie drohen diese Investitionen in vielen Unternehmen aufgrund fehlender Voraussetzungen ohne Mehrwert zu versickern.

Aktueller Stand in verschiedenen Laborarten

Der digitale Reifegrad in den verschiedenen akkreditierten Laboren ist sehr unterschiedlich und wird insbesondere bei der Betrachtung verschiedener Laborbereiche deutlich. In den technischen Laborsparten, beispielsweise im Automotive-Bereich, ist die Digitalisierung bereits wesentlich weiter fortgeschritten als in den medizinischen Laboren. Die Akkreditierungsanforderungen bezüglich der Informationssicherheit sind jedoch annähernd gleich. Viele Qualitätsmanagementsysteme (QMS) der medizinischen Labore sind noch sehr oder ausschließlich papierbasiert aufgebaut. Oft hört man die Aussage: „Weil wir das schon immer so gemacht haben.“ Dass diese Labore trotz ihres papierbasiertem QMS, das nicht mehr dem „Stand der Technik“ entspricht, ihre Akkreditierung erfolgreich bestehen, verstärkt diese Haltung zusätzlich. Warum das ganze Managementsystem ändern und hierfür viel Geld, Zeit und Ressourcen in die Hand nehmen, wenn die Akkreditierungsstellen dies nicht explizit fordern? Der Vorteil der digitalen Transformation ist für die Labore nicht deutlich genug. Zusätzlich ist der Gegenwind durch die Mitarbeitende für diesen ausgeprägten Change-Prozess häufig sehr hoch.

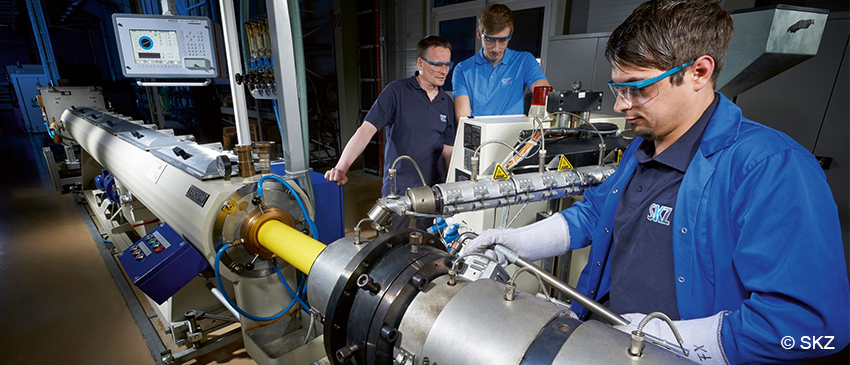

Labore, die beispielsweise als interne Qualitätssicherungslabore in innovativen und modernen Unternehmen verankert sind, etwa in der Werkstoff-, oder Materialprüfung, pflegen oft gleichfalls moderne und agile Prozesse. Die Mitarbeitenden sind an Veränderungen und Innovationen gewöhnt und gelten als resilienter und flexibler als Mitarbeitende in sehr konservativen Laborsparten.

Bei der Beurteilung der Automatisierung und Digitalisierung muss jedoch grundsätzlich zwischen dem Probendurchlauf, das heißt dem Laborprozess zur Probenbearbeitung und dem nach DIN EN ISO/IEC 17025 oder DIN EN ISO 15189 aufgebauten Managementsystem für die Aufrechterhaltung der Akkreditierung unterschieden werden.

Der Probenbearbeitungsprozess wird durch sogenannte Laborinformationsmanagementsysteme, abgekürzt LIMS, automatisiert und digitalisiert. Besonders bei sehr hohen Probenzahlen steigt der Automatisierungsgrad des Laborprozesses proportional und LIMS werden häufiger implementiert. Da medizinische Labore häufig hohe Probenzahlen untersuchen, nutzen medizinische Labore oft elektronische LIMS für die automatisierte Bearbeitung der Proben und die Anbindung der Geräte für die elektronische Ergebnisübertragung.

In den Prüf- und Kalibrierlaboren, die nach DIN EN ISO/IEC 17025 akkreditiert sind, werden regelmäßig weniger Proben getestet und LIMS sind seltener anzutreffen. Das heißt, speziell für den Laborprozess ist der digitale Automatisierungsreifegrad bei den Prüf- und Kalibrierlaboren und den technischen Laborsparten weniger ausgeprägt als bei den medizinischen Laboren.

Auf Ebene der Qualitätsmanagementsysteme nach DIN EN ISO/IEC 17025 und DIN EN ISO 15189 sehen wir ein gegenteiliges Bild. Medizinische Labore pflegen oft ein papierlastiges Managementsystem, wobei die Prüf- und Kalibrierlabore tendenziell stärker, zum Beispiel durch CAQ Systeme oder SharePoint digitalisiert sind. Ein Großteil der Labore unterhält momentan noch ein Hybridsystem aus Papierdokumenten und elektronischen Dokumenten.

Digitalisierung ist also nicht gleich Digitalisierung. Die Labore müssen sich fragen, welche Prozesse ihr „Nadelöhr“ sind, in welche Prozesse unverhältnismäßig viele Ressourcen und Kapazitäten fließen. In welchen Bereichen müssen sie effizienter, schneller und sicherer werden? Welchen Risiken unterliegen ihre Prozesse? Mancherorts werden etwa veraltete, nicht mehr unterstützte Systeme und MS Access Datenbanken genutzt, die nur von einer Person im Unternehmen verwaltet werden können. Was passiert mit diesen Prozessen, wenn diese Person ausfällt? Die Auswirkung für das Labor ist ähnlich einem Cyber-Angriff – der Stillstand aller Testungen und Prozesse.

Digitaler Umstellungsprozess in den akkreditierten Laboren

Die Umstellung von analogen zu digitalen Prozessen erfolgt in den Laboren in unterschiedlichen Stufen. Ausgedruckte Papierdokumente werden durch Excel- und Word-Dokumente ersetzt. Diese werden nicht mehr ausgedruckt, sondern digital gepflegt, gegebenenfalls mit elektronischen Unterschriften versehen und in den Audits und Begutachtungen digital präsentiert.

Der nächste Reifeschritt ist der Ersatz dieser Dokumente durch kommerzielle Softwaresysteme und Datenbanken oder -sätze, wie zum Beispiel CAQ, SharePoint für die Dokumentenlenkung, Pflege und Ablage.

Die Königsdisziplin ist eine kommerzielle Softwarelösung, auch „Software as a Service“ genannt (SaaS), die bereits bei der Auslieferung alle Akkreditierungsanforderungen erfüllt und schnell, also ohne großes Softwareimplementierungsprojekt, gestartet werden kann. Diese SaaS Lösungen, wie zum Beispiel 17025_SaaS von AUDITTRAILS Networks, sind seit wenigen Jahren für die Labore käuflich zu erwerben und bilden über Datensätze die kompletten Akkreditierungsanforderungen ab. Zum Aufbau eines Managementsystems muss auf diesem Wege nicht alles eigenständig erarbeitet werden. Die Labore können sich sicher sein, dass sie alle Akkreditierungsanforderungen erfüllen.

Selbsteinschätzung der Labore zum vorliegenden Digitalisierungsstand

Was sagen die Labore selbst über den Grad ihrer Digitalisierung? Welche Prozesse wurden bereits digitalisiert? Eine QI-FoKus-Studie von 2024, die in Zusammenarbeit mit der BAM erstellt wurde, befragte über 1.300 internationale Labore zu Digitalisierungsthemen.

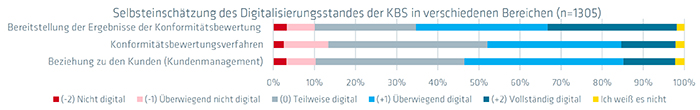

Abb. 1: Selbsteinschätzung des Digitalisierungsstandes der KBS in verschiedenen Bereichen. Quelle: QI-FoKus-Studie 2024 zur Digitalisierung in der Konformitätsbewertung: Ein internationaler Vergleich

Die Studie ergab, dass hauptsächlich die Übermittlung der Prüfergebnisse an die Kunden digital erfolgt.

Auch wurde festgestellt, dass Digitalisierung häufig erst in den letzten Jahren für die Labore relevant wurde. Jede zweite Konformitätsbewertungsstelle, unter anderem Labore, hat erst in den letzten 5 Jahren begonnen, sich mit der digitalen Transformation zu beschäftigen. Nur 20 Prozent haben dies bereits vor 10 Jahren getan.

|

|

|

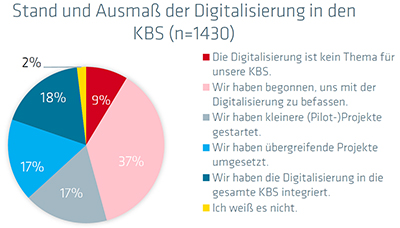

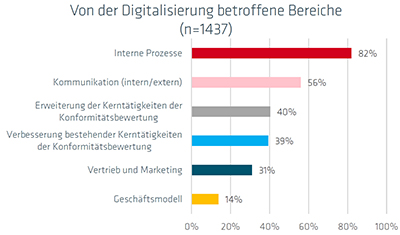

| Abb. 2: Stand und Ausmaß der Digitalisierung in den KBS. Quelle: QI-FoKus-Studie 2024 zur Digitalisierung in der Konformitätsbewertung: Ein internationaler Vergleich | Abb. 3: Von der Digitalisierung betroffene Bereiche. Quelle: QI-FoKus-Studie 2024 zur Digitalisierung in der Konformitätsbewertung: Ein internationaler Vergleich |

International haben nur 18 Prozent der Labore die Digitalisierung in das gesamte Labor integriert. Die meisten Digitalisierungsaktivitäten betreffen interne Prozesse, gefolgt von verbesserter Kommunikation. Nur in geringerem Ausmaß unterstützt die Digitalisierung jedoch die Erweiterung und Verbesserung der klassischen Labor-Tätigkeiten.

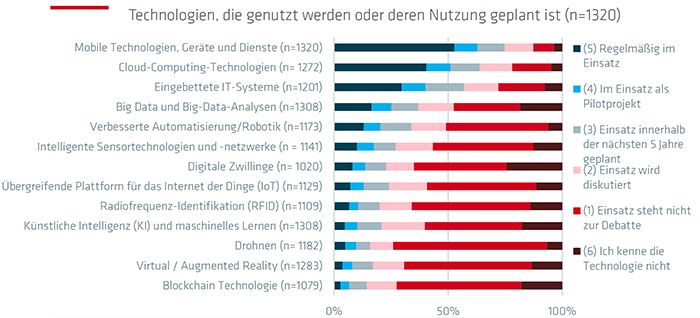

Abb. 3: Technologien, die genutzt werden oder deren Nutzung geplant ist. Quelle: QI-FoKus-Studie 2024 zur Digitalisierung in der Konformitätsbewertung: Ein internationaler Vergleich

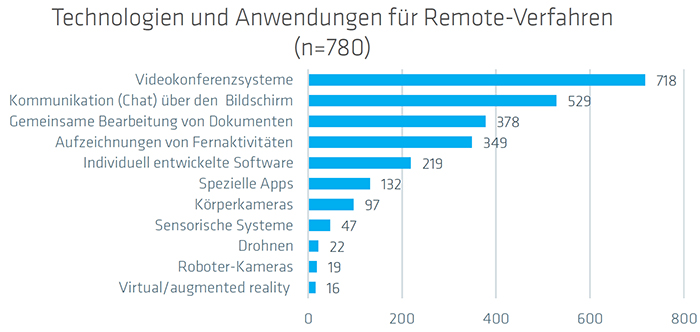

Die neuesten digitalen Technologien, wie Blockchain, KI, Virtual Reality und Big Data Analytics werden nur in geringem Ausmaß in den akkreditierten Laboren eingesetzt. Regelmäßig zum Einsatz kommen bereits Mobile Technologien, Cloud-Computing-Technologien und eingebettete IT-Systeme. Auch Technologien und Anwendungen für Remote-Verfahren wie Videokonferenzsysteme und Chats sind fest im Alltagsgeschäft der Unternehmen verankert. Sie werden von 60 Prozent der befragten Unternehmen genutzt.

Abb. 4: Technologien und Anwendungen für Remote-Verfahren. Quelle: QI-FoKus-Studie 2024 zur Digitalisierung in der Konformitätsbewertung: Ein internationaler Vergleich

45 Prozent nutzen sie auch für ihre Audits. Als größte Hürden und Probleme bei den eingesetzten Remote-Methoden werden die mangelnde zwischenmenschliche Interaktion und Risiken bezüglich des Datenschutzes und der Informationssicherheit gesehen.

Mehr als die Hälfte der akkreditierten Routineprozesse wurden in 69 Prozent der internationalen Labore digitalisiert. 13 Prozent der Labore haben dagegen nicht einmal 10 Prozent ihrer Labortätigkeiten digitalisiert.

Zusammenfassung des aktuellen Standes der Digitalisierung in akkreditierten Laboren

In den letzten Jahren hat die Digitalisierung in diesen Laboren stark zugenommen. Die Fortschritte sind:

- Laborinformationssysteme (LIMS):

LIMS ermöglichen es, akkreditierten Laboren, die Probenbearbeitung und -verwaltung, die Datenverarbeitung sowie den gesamten Laborbetrieb automatisiert und digital abzubilden. Anfangs wurden diese Systeme häufig durch die eigene IT-Abteilung entwickelt. In den letzten Jahren wurden diese System wegen der gestiegenen Akkreditierungsanforderungen durch kommerzielle LIMS-Lösungen ersetzt. - Automatisierung von Prozessen:

Fortschrittliche Analysegeräte und Sensoren automatisieren die Datenerfassung und -analyse, was zu einer erhöhten Effizienz und Genauigkeit führt. Dies ist besonders wichtig für akkreditierte Labore, da die Genauigkeit und Reproduzierbarkeit der Ergebnisse von entscheidender Bedeutung sind. Besonders die Anbindung der Geräte an die Server führen durch die automatisierte Rohdaten- und Ergebnisübertragung zu enormen Effizienzsteigerungen und Fehlerreduzierungen. Auch die digitale Übertragung der Prüfergebnisse und Prüfberichte an die Kunden führt zu einem enormen Effizienzgewinn. - Datenmanagement und -sicherheit:

Die Nutzung von Cloud-Computing und Big-Data-Analyse ermöglicht es akkreditierten Laboren, große Datenmengen effizient und sicher zu speichern, zu verarbeiten und zu analysieren. Gleichzeitig wird die Sicherheit sensibler Daten gewährleistet. Diese Methodiken werden momentan in den internationalen Laboren noch nicht ausreichend genutzt. - Remote-Techniken:

Seit 2020 setzen Labore vermehrt Remote-Techniken für die Tätigkeiten und Kommunikationsabläufe in den Laboren ein. Videokonferenzsysteme stellen das am häufigsten verwendete Tool für die Remote-Arbeit dar, gefolgt von digitaler Kommunikation (Chat).

Über die Autorin

Susanne Kolb ist Geschäftsführerin der Laborberatungsfirma LaborConsultingGenius GmbH und berät seit über 10 Jahren alle Branchen von Prüf-, Kalibrier- und medizinischen Laboren bei Akkreditierungsprojekten nach DIN EN ISO/IEC 17025 und DIN EN ISO 15189. Zusätzlich war sie fast 10 Jahre leitende DAkkS Systembegutachterin und Fachbegutachterin und ist seit Jahren Trainerin und Prüferin des DGQ-Zertifikats Labormanagement.

Koch, C., Ladu, L (2022). QI-FoKuS-Studie in Zusammenarbeit mit der BAM, Auswirkungen der Corona-Pandemie auf Konformitätsbewertung und Konformitätsbewertungsstellen in Deutschland (qi-digital.de)

Koch, C., Ladu, L (2024, März). QI-FoKuS-Studie in Zusammenarbeit mit der BAM (www.bam.de)

Frenzl, A. (2024, 26.März). Blogbeitrag: Moderne Managementsysteme – AUDITTRAILS Networks GmbH

Zeitschrift Laborpraxis 2024 : Dossier – Digitalisierung im Labor

VUP-Konjunkturbarometer, November 2023 (VUP – Verband unabhängiger Prüflabore)

Zeitschrift QZ 5/24, Seite 7, KI ist der Managementhype 2024 – und eine Investment-Falle, Hanser Verlag, Herausgeber DGQ

April 2024, DIALOGPROZESS „DIGITALE QI IN PRÜF- UND KALIBRIERLABOREN – VOM TREND ZUM TAGESGESCHÄFT“ Zentrale Erkenntnisse aus den Praxiswerkstätten #1 und #2

DGQ-Vortrag zu Digitalisierung: Zusammenspiel von Software, Hardware und Mensch im Blick

Qualitätsmanagement (QM) und Qualitätssicherung (QS) hinken derzeit digital noch hinterher: Das ist eine der Erkenntnisse aus dem Vortrag von Dr. Benedikt Sommerhoff, Leiter des Research Teams bei der DGQ, auf dem „Quality Day Software“ des Fachmagazins Quality Engineering. Unter dem Titel „Software, Hardware, Wetware – Alle(s) für die Qualität“ erörterte Sommerhoff als Keynote-Speaker unter anderem, worauf Unternehmen auf dem Weg in die Digitalisierung von Qualitätsmanagement (QM) und Qualitätssicherung (QS) achten sollten. Dabei stand insbesondere das Zusammenspiel von Software, Hardware und dem Menschen in Zeiten der beschleunigten Digitalisierung im Fokus.

Potenziale bewusst nutzen

In seinem Vortrag fokussierte sich Sommerhoff darauf, mit den Teilnehmerinnen und Teilnehmern ein gemeinsames Verständnis von Digitalisierung und ihres Potenzials zu erreichen sowie den unterschiedlichen Charakter von Soft- und Hardware zu vermitteln. Auch der Identifikation von Use Cases bei Software/Digitalisierung in und für QS und QM kam eine große Rolle zu sowie dem Ziel, Digitalisierung als Zusammenspiel von Software, Hardware und Mensch zu erkennen. Letzteres führte Sommerhoff zu der Fragestellung, wie dieses Zusammenspiel künftig die Rollen der Beteiligten verändern werde: Dabei sei mittlerweile insbesondere auch zu bedenken, wie Qualitätsverantwortliche in der Zukunft mit Künstlicher Intelligenz (KI) zusammenarbeiten werden. Sommerhoffs Appell: Organisationen sollten die Interaktion mit der KI bewusst und aktiv begleiten, und das auf Basis realistischer organisationsspezifischer Zielvorstellungen.

Interessierte können sich die Aufzeichnung des Vortrags hier anschauen:

Neue Anforderungen für KI in Unternehmen: Die EU-KI-Gesetzgebung und ihre Auswirkungen auf das Qualitätswesen

Künstliche Intelligenz (KI) durchdringt immer mehr Bereiche des täglichen Lebens und der Arbeit. Lange Zeit war künstliche Intelligenz nur für Entwicklungs- und Technologiebereiche interessant. In den letzten Monaten lässt sich beobachten, dass KI immer mehr auch zum Qualitätsthema wird. Überall dort, wo KI eingesetzt wird, um Kundenbedürfnisse zu erfüllen, wird sie auch Gegenstand des Qualitätsmanagements. Viele Unternehmen nutzen KI bereits in ihren Produkten, in ihren Herstellungsprozessen oder im Kundensupport. Auf diese Unternehmen kommen nun neue Anforderungen zu. Dieser Artikel ist Teil einer Serie. Der erste Teil möchte die Leser mit grundsätzlichen Qualitätsanforderungen an KI-Systeme in der aktuellen Rechtslage vertraut machen. Der Beitrag zeigt die großen Parallelen zwischen dem EU-KI-Gesetz und QM-Methoden. Folgende Artikel werden sich mit unterschiedlichen Aspekten wie KI-Absicherung und KI-Zertifizierung auseinandersetzen.

Die EU hat im Dezember 2023 das EU-KI-Gesetz verabschiedet, welches seit April 2024 in überarbeiteter Form vorliegt. Dieses Gesetz definiert Anforderungen für den Betrieb von KI-Systemen in der Europäischen Union und schafft einen einheitlichen gesetzlichen Rahmen für Hersteller und Betreiber. Die EU-KI-Gesetzgebung bewertet KI-Systeme nach einem risikobasierten Ansatz, der starke Ähnlichkeit mit bestehenden Management-Systemen wie ISO 9001 oder ISO 14001 aufweist.

KI-Anwendungen mit unzulässigen Risiken

Abbildung 1 zeigt die vier Risikokategorien für KI-Systeme gemäß EU-KI-Gesetz. Die Einstufung in eine Risikokategorie ergibt sich im Wesentlichen aus den möglichen Auswirkungen auf interessierte Parteien wie Nutzer, die Gesellschaft als Ganzes oder die Umwelt. Das KI-Gesetz verwendet den Ausdruck interessierte Partei dabei nicht. Die oberste Kategorie bezeichnet KI-Anwendungen mit unzulässigen Risiken. Beispiele hierfür sind Social-scoring-Systeme, die dazu gedacht sind, das Verhalten von Menschen zu beeinflussen. Der Betrieb solcher Systeme ist in der EU nach Ablauf einer sechsmonatigen Übergangsfrist untersagt.

Abb. 1: Risikokategorien des EU-KI-Gesetzes mit Beispielen

KI-Systeme mit hohem Risiko

Die zweithöchste Kategorie sind KI-Systeme mit hohem Risiko. Allgemein fallen in diese Kategorie Systeme, die funktionale Sicherheitsanforderungen haben (zum Beispiel in der medizinischen Diagnostik oder dem Straßenverkehr) oder die persönlichen und wirtschaftlichen Interessen von natürlichen Personen betreffen (zum Beispiel im Finanzwesen oder der Bildung). Annex III des EU-KI-Gesetzes enthält eine Auflistung von Hochrisiko-Bereichen. In der aktuellen Fassung des wurde ein neues Kapitel zu KI-Modellen mit allgemeinem Verwendungszweck aufgenommen. Für Hersteller dieser Modelle, zu denen auch große Sprachmodelle zählen, gelten besondere Anforderungen (zum Beispiel gpt4, das Modell hinter ChatGPT). Je nach Komplexität des Modells können die Anforderungen im Hochrisiko-Bereich oder sogar darüber liegen, wenn ein systemisches Risiko festgestellt wurde.

Hochrisiko-KI-Systeme müssen eine CE-Kennzeichnung aufweisen und durch eine unabhängige dritte Stelle zertifiziert werden. Alle Hochrisiko-KI-Systeme müssen in einer zentralen EU-Datenbank registriert werden. Wenn erwiesen ist, dass ein KI-System aus einem Annex III gelisteten Bereich keinen Einfluss auf Sicherheit oder Interessen natürlicher Personen hat, dann kann das System auch als System mit mittlerem oder niedrigem Risiko behandelt werden. Die Pflicht zur externen Zertifizierung entfällt in diesem Fall, aber das System muss trotzdem an die zentrale EU-Datenbank gemeldet werden. Die Erfassung in der EU-Datenbank und die Zertifizierung gelten für einzelne KI-Produkte, nicht für eine Organisation als Ganzes. Die Zertifizierung muss für alle größeren Eingriffe wiederholt werden.

Für Hochrisiko-KI-Systeme stellt das EU-KI-Gesetz eine Vielzahl von Anforderungen. Eine genauere Betrachtung der Anforderungen wird in einem separaten Artikel besprochen. An dieser Stelle sollen nur die wichtigsten Anforderungen genannt werden:

- Einhaltung von Datenschutzvorschriften und Informationssicherheit

- Vorhandensein eines Qualitätsmanagementsystems

- Risikomanagement für vorhersehbare Fehler

- Verpflichtung zu Test und Validierung des KI-Systems

- Einhaltung der branchenspezifischen Vorschriften für funktionale Sicherheit

Die oben aufgeführten Stichpunkte zeigen den starken Überlapp zwischen der neuen EU-KI-Gesetzgebung und Methoden des klassischen Qualitätsmanagements. Aus diesem Grund gehen wir davon aus, dass das Qualitätsmanagement in Zukunft eine zentrale Rolle bei der Einführung und Überwachung von KI-Systemen einnehmen wird.

KI-Systeme mit mittlerem Risiko

Neben Hochrisiko-KI-Systemen gibt es noch Systeme mit mittlerem Risiko. In diese Kategorie fallen Systeme wie Chatbots für den Kundensupport. Diese Systeme haben nur unwesentliche persönliche und keine sicherheitsrelevanten Auswirkungen für Nutzer. Für diese Systeme gelten lediglich Transparenzanforderungen. Dies bedeutet, dass für Nutzer ersichtlich sein muss, wenn er mit einem KI-System interagiert. Der Nutzer muss ferner in Verständlicher Art und Weise über die Verarbeitung seiner Daten aufgeklärt werden. KI-generierte Inhalte sollten in maschinenlesbarer Art und Weise als solche gekennzeichnet sein (zum Beispiel durch Fingerprinting). Die EU arbeitet aktuell an einem Code of Conduct, der näher erklären soll, wie diese Anforderungen umzusetzen sind. Aktuell gibt es jedoch noch kein Veröffentlichungsdatum.

Es ist wichtig zu betonen, dass die Verantwortung für die Einhaltung von Transparenzregeln und Absicherung der korrekten Funktion hauptsächlich der Organisation zufällt, die das KI-System in Umlauf bringt. Dabei handelt es sich oft nicht um den Hersteller des KI-Modells. Insbesondere bei der Verwendung großer Sprachmodelle ist diese Unterscheidung wichtig. Chatbots sind in der Regel kundenspezifisch angepasst. Hersteller großer Sprachmodelle wie openAI agieren in diesem Fall als Lieferanten für Firmen, aber übernehmen in der Regel keine Haftung für firmenspezifische Anpassungen. Dieser Artikel beschreibt einige der Risiken, die dabei entstehen. Die Verantwortung für die Validierung der korrekten Funktion und die Einhaltung von Vorschriften obliegt der Firma, die das System für den Nutzer bereitstellt. Firmen werden somit selbst Prozesse zur Validierung ihrer KI -Lösungen implementieren müssen, wenn sie KI in ihren Produkten oder Prozessen nutzen möchten.

KI-Systeme mit vernachlässigbarem Risiko

Alle KI-Systeme, die nicht in die obersten drei Risikokategorien fallen, werden als Systeme mit vernachlässigbarem Risiko eingestuft. Für Anwendungen mit vernachlässigbarem Risiko stellt das KI-Gesetz neuen Anforderungen. Bestehende Anforderungen, zum Beispiel aus der Datenschutzgrundverordnung bleiben aber weiterhin bestehen. Wir stellen dazu ein kostenloses Self-Assessment bereit, mit dem die Risikoklasse einer KI-Anwendung bestimmt werden kann.

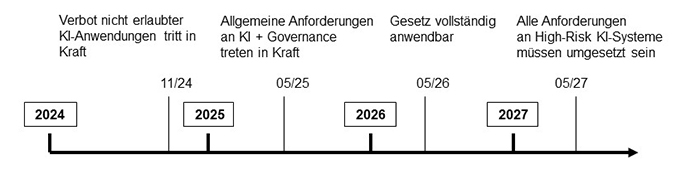

Abbildung 2 zeigt Umsetzungszeiten für die EU-KI-Gesetzgebung, wie sie zum 1. Mai 2024 bekannt waren. Das Verbot von Anwendungen mit unzulässigem Risiko wird bereits im November 2024 in Kraft treten. Die ersten Anforderungen, für Anwendungen mit mittlerem und hohem Risiko werden nach heutigem Kenntnisstand ab Mai 2025 in Kraft treten. Zu diesem Zeitpunkt greifen Verpflichtungen im Bezug auf Transparenz und Data Governance. Data Governance bedeutet, dass Trainings- und Testdatensätze alle für die Anwendung relevanten Kategorien oder Personengruppen abdecken müssen und dies auch nachvollziehbar zu dokumentieren ist.

Abb. 2: Zeitschiene der Implementierung der EU-KI-Gesetzgebung

Die Verpflichtung zur Zertifizierung von Hochrisikosystemen wird voraussichtlich ab Mai 2026 in Kraft treten, gefolgt von einem Übergangszeitraum von 12 Monaten. Spätestens im Mai 2027 müssen dann alle Anforderungen des KI-Gesetzes vollständig umgesetzt sein.

Auf Firmen, die bereits jetzt KI in ihren Produkten oder Prozessen nutzen, kommen daher in den nächsten Monaten folgende Aufgaben zu:

- Bewertung, in welche Risikokategorie die eingesetzten KI-Systeme fallen

- Zusammenstellung aller bindenden Verpflichtungen und Normenanforderungen

- Gesetze (mindestens Datenschutzgrundverordnung und KI-Gesetz)

- Managementsysteme (zum Beispiel ISO 9001:2015)

- Branchenstandards für funktionale Sicherheit (zum Beispiel ISO 26262 für Automotive)

- Erstellung der notwendigen Dokumentation (zum Beispiel für Risikomanagement)

- Test und Validierung der eingesetzten KI-Systeme

KI ist bereits heute in vielen Branchen eine zentrale Komponente der Wertschöpfungskette. Es ist davon auszugehen, dass KI-Assistenzsysteme mit mittlerem Risiko in den nächsten 24 Monaten branchenunabhängig in nahezu alle Bürotätigkeiten Einzug halten wird. Dabei werden KI-Systeme immer mehr Aufgaben übernehmen, die heute von Menschen erledigt werden. Das Qualitätsmanagement spielt eine entscheidende Rolle bei der Absicherung und gesetzeskonformen Umsetzung dieser Systeme. Es ist daher absehbar, dass in den nächsten Monaten ein erheblicher Trainingsbedarf im Bereich Qualitätsmanagement bestehen wird, um die Fachbereiche mit den neuen Anforderungen vertraut zu machen. Qualitätsverantwortliche sollten sich zeitnah mit den IT- und Rechtsbereichen ihrer Organisationen abstimmen um die Aufgabenverteilung, sowie die benötigten Ressourcen und die erforderlichen Qualifikationen zu bestimmen.

Lesen Sie mehr zum Thema “Künstliche Intelligenz in der Qualität” in den folgenden Fachbeiträgen:

- Teil 1: Künstliche Intelligenz in der Qualität – Bestehendes Know-how effektiv nutzen – zum Beitrag »

- Teil 2: Künstliche Intelligenz in der Qualität – Welche Qualifikationen werden benötigt? – zum Beitrag »

- Teil 3: Künstliche Intelligenz in der Qualität – Praktische Einführung durch iteratives Vorgehen – zum Beitrag »

Über die Autoren:

Dipl.-Ing. Waldemar Fahrenbruch ist Head of Q-Technology Division E-Mobility bei der ZF Friedrichshafen AG. Er ist verantwortlich für die Qualitätskostensenkung bei gleichzeitiger Optimierung von Qualitätskonzepten in den Werken der Division E (TCU, Power Electronics und E-Motoren Fertigung) durch Methodenkompetenz der Qualität, künstlicher Intelligenz und digitaler Transformation.

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Künstliche Intelligenz. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten. Kontakt: ki@prophet-analytics.de

Vertrauen stärken und Innovation ermöglichen: Eine digitale Qualitätsinfrastruktur für ein modernes Made-in-Germany

Produktion und Handel in immer komplexeren Wertschöpfungsnetzwerken, die fortschreitende digitale und grüne Transformation sowie technologische Innovationen sind in hohem Maße auf die verlässliche Sicherung und den effizienten Nachweis der Qualität, Sicherheit und Nachhaltigkeit von Waren, Dienstleistungen und Prozessen angewiesen. Unverzichtbar dafür ist eine moderne und leistungsfähige Qualitätsinfrastruktur (QI).

QI-Digital: Qualität smarter sichern

Im Rahmen der Initiative QI-Digital entwickeln die zentralen Akteure der Qualitätsinfrastruktur (QI) in Deutschland – die Bundesanstalt für Materialforschung und -prüfung (BAM), die Deutsche Akkreditierungsstelle (DAkkS), das Deutsche Institut für Normung (DIN), die Deutsche Kommission Elektrotechnik Elektronik Informationstechnik (DKE) und die Physikalisch-Technische Bundesanstalt (PTB) – gemeinsam mit Stakeholdern aus Wirtschaft und Forschung Lösungen für eine moderne Qualitätssicherung. Diese muss nicht nur den Anforderungen einer Wirtschaft gerecht werden, die zunehmend digital und vernetzt ist, sondern zudem nachhaltig und resilient sein.

Das Ziel: Qualität vertrauensvoll und effizient sichern und nachweisen. Gefördert wird die Initiative vom Bundesministerium für Wirtschaft und Klimaschutz (BMWK). Ein engagierter Beirat mit Mitgliedern aus Wirtschaft, Forschung und Verwaltung unterstützt bei der strategischen Ausrichtung, konkreten Umsetzung und der Vernetzung.

Abb. 1: Die Bundesanstalt für Materialforschung und -prüfung (BAM), die deutsche Akkreditierungsstelle DAkkS, die Normungsinstitute DIN und DKE sowie die Physikalisch-Technische Bundesanstalt (PTB) haben sich zur Initiative QI-Digital zusammengeschlossen. Quelle: QI-Digital.

Von einer Dokumenten- hin zu einer Datenbasierten Qualitätssicherung

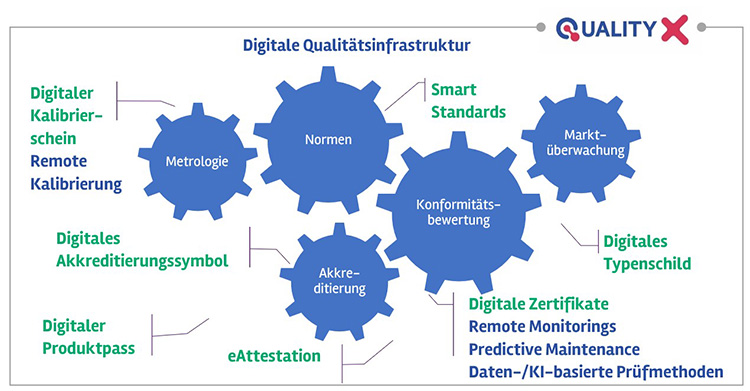

Durch das Zusammenspiel von Metrologie, Normung, Konformitätsbewertung, Akkreditierung und Marktüberwachung bildet die QI die Grundlage für funktionierenden internationalen Handel und das Qualitäts-Label “Made in Germany“. Die QI selbst ist ein komplexes System aus regulativen Rahmenbedingungen und verschiedenen Institutionen, Werkzeugen und Prozessen – ihre digitale Transformation ein entsprechend umfangreiches Vorhaben.

Das Zielbild einer digitalen QI umfasst dabei datenbasierte und automatisierte Verfahren für Qualitätssicherung und -nachweis sowie einen Werkzeugkasten unter anderem aus Smart Standards und maschinenlesbaren Konformitätsnachweisen mit digitalem Akkreditierungssymbol (eAttestation). Diese bilden zusammen ein digitales Ökosystem für die QI, das es Unternehmen und anderen privatwirtschaftlichen und hoheitlichen Akteuren in Wertschöpfungsnetzwerken ermöglicht, vertrauensvoll, souverän und effizient qualitätsrelevante Daten, Informationen und Dokumentationen bereitzustellen, zu nutzen und auszutauschen. Die bisher weitgehend dokumentenbasierte, analoge und statische Qualitätssicherung wird damit fundamental transformiert hin zu einem datenbasierten, smarten System, das auf nutzungsorientierten, vorausschauenden Ansätzen fußt, die den modernen Anforderungen der Industrie 4.0 gerecht werden und effizient für nachhaltiges Vertrauen und Transparenz sorgen.

Abb. 2: Zielbild einer digitalen Qualitätsinfrastruktur: Digitale QI-Werkzeuge, -Verfahren und -Prozesse ermöglichen eine durchgängige Integration in Qualitätssicherungsprozesse der Industrie 4.0 sowie Transparenz und Vertrauen entlang der Wertschöpfungskette. Quelle: QI-Digital

Bürokratieaufwand reduzieren

Die Anforderungen an die Umsetzung regulatorischer Vorgaben steigen für Unternehmen stetig an. Die schon bald geforderte Implementierung des Digitalen Produktpasses in der EU im Rahmen der neuen Verordnung für nachhaltige Produkte (ESPR) ist nur ein Beispiel dafür. Digitale Innovationen in der QI sind hierbei ein Schlüssel, um diese bürokratischen Herausforderungen zu bewältigen, wie Dr. Gunter Kegel, Präsident des Verbands der Elektro- und Digitalindustrie ZVEI e.V., bei einem Austausch der Initiative QI-Digital mit Bundestagsabgeordneten zu Beginn des Jahres hervorhob. Voraussetzung ist es, von der analogen, dokumentenbasierten Qualitätssicherung hin zu einer datenbasierten Arbeitsweise zu kommen. Mithilfe digitaler Prozesse und Werkzeuge der QI lasse sich der personelle und administrative Aufwand für die Unternehmen wesentlich reduzieren und die Wettbewerbsfähigkeit der deutschen und europäischen Wirtschaft auch künftig sichern. Dies gilt nicht zuletzt vor dem Hintergrund des absehbar zunehmenden Fachkräftemangels.

Datenräume für die QI: Quality-X

Die Initiative QI-Digital entwickelt die nötigen digitalen Werkzeuge und Verfahren. Das wahre Potenzial der digitalen QI entfaltet sich erst, wenn ihre Akteure und Prozesse systemübergreifend und nahtlos in ein kohärentes digitales QI-Ökosystem integriert werden. Die jüngsten Entwicklungen hin zu industriellen internationalen Datenräumen ermöglichen ein solches Ökosystem.

Kernstück des angestrebten digitalen QI-Ökosystems ist Quality-X, eine föderierte Plattform zur Vernetzung von Institutionen und einfachen, sicheren Austausch qualitätsbezogener Daten und Informationen auf Basis internationaler Datenräume mit standardisierten Schnittstellen. Quality-X soll es Unternehmen erleichtern, Qualitätsnachweise zu erbringen und gleichzeitig Souveränität sichern, u.a. mit definierten Zugriffsberechtigungen. Basierend auf den Gaia-X-Grundsätzen, die Transparenz, Offenheit, Datenschutz und Sicherheit betonen, orientiert sich das Projekt an den technischen und rechtlichen Rahmenbedingungen bekannter Gaia-X-Leuchtturmprojekte wie Catena-X und Manufacturing-X. In einem Whitepaper hat die Initiative QI-Digital Konzept und Idee von Quality-X zusammengefasst.

Umsetzung anhand greifbarer, praxisrelevanter Pilotprojekte

Aufgrund der Komplexität der Prozesse, Verfahren und Werkzeuge der QI, werden die Lösungen entlang konkreter, praxisrelevanter Anwendungen der Qualitätssicherung in der modernen Produktion (Industrie 4.0) und dem Betrieb technischer Anlagen entwickelt, erprobt und demonstriert. Dazu dienen der Initiative praxisnahe Testumgebungen, die die Bundesanstalt für Materialforschung und -prüfung (BAM) im Rahmen der beiden Pilotprojekte „Additive Fertigung“ und „Verlässliche Wasserstofftankstelle“ bereitstellt. Neben Forschung und Entwicklung an modernen Prüfmethoden werden dort die digitalen Werkzeuge der QI erprobt und ihr Zusammenwirken demonstriert. So können integrierte Prozessketten dargestellt werden – vom Einlesen digital über Smart Standards bereitgestellter Normen-Anforderungen (siehe Initiative IDiS von DIN und DKE) über die prozessbegleitende Konformitätsbewertung mittels moderner (Prüf-)Verfahren hin zum automatisierten Erstellen von maschinenlesbaren Prüfberichten und anderer Konformitätsnachweise, eingebettet in das datenraumbasierte System Quality-X.

Dabei zeigt sich deutlich die zunehmende Bedeutung Künstlicher Intelligenz (KI) auch für die QI: Ganz neue Datenverfügbarkeit durch Sensortechnologien, thermographische Bildaufnahmen und andere moderne Ansätze eröffnet bisher ungekannte Möglichkeiten für die Qualitätssicherung. Entsprechende digitale, datenbasierte Prüfverfahren unter Nutzung von KI werden an der BAM entwickelt. Zudem wird das Potenzial des Federated Learning via Data Spaces erkundet. Umgekehrt ist auch die Frage der Vertrauenswürdigkeit von KI-Anwendungen ein zentrales Thema in QI-Digital. Damit der Einsatz qualitätsgesichert und vertrauensvoll erfolgen kann, werden bspw. an der PTB für den Gesundheitsbereich die Grundlagen messbarer Qualitätskriterien und Verfahren entwickelt.

Begleitforschungsaktivitäten und Stakeholder-Einbindung

Anwender und andere relevante Akteure über aktives Stakeholder-Engagement und umfassende Transferaktivtäten eng einzubeziehen, ist ein zentrales Anliegen der Initiative QI-Digital. Nicht nur ein engagierter Beirat steuert wertvolle Impulse bei. Auch ein stetig wachsendes Netzwerk liefert wichtige Informationen zu Anforderungen aus der Praxis, die in die Entwicklung der Lösungen einfließen.

Eine tragende Säule der QI sind Konformitätsbewertungsstellen. Um ihre Perspektiven und Erwartungen an eine digitale QI zu erfassen, hat die BAM in Kooperation mit der DAkkS und dem Verband Unabhängiger Prüflaboratorien (VUP) einen zielgerichteten, professionell begleiteten Dialogprozess für Prüf- und Kalibrierlabore mit ko-kreativen Online-Workshops aufgesetzt. Die gewonnenen Erkenntnisse aus diesen Praxiswerkstätten erlauben es, die Arbeit der Initiative noch stärker an den Praxis-Bedarfen auszurichten und weiterzuentwickeln.

Entsprechende konkrete Folgeprojekte mit interessierten Laboren bspw. zu Quality-X werden folgen. Weitere Begleitforschungsprojekte wie bspw. eine Trendstudie zur Zukunft der QI oder die internationale Vergleichsstudie der BAM zum Stand der Digitalisierung in der Konformitätsbewertung erlauben nicht nur vertiefte Erkenntnisse, sondern dienen auch der nachhaltigen Vernetzung.

Holistischer Ansatz: Technische Lösungen und geeignete Rahmenbedingungen

Ein solcher umfassender Stakeholderdialog ist auch deshalb wichtig, da neue digitale Lösungen in der QI, sowohl auf technischer als auch prozessualer Ebene zwischen Akteuren, Unternehmen (Hersteller/Inverkehrbringer/Betreiber) genauso wie Behörden/öffentliche Verwaltung (Genehmiger, Marktüberwacher, und andere), privatwirtschaftliche Konformitätsbewerter und andere Stakeholder betreffen. Die digitale Transformation der QI muss daher ganzheitlich auf verschiedenen Ebenen betrachtet werden. Sie bedeutet nicht nur technische Innovationen für Werkzeuge und Verfahren allein. Vielmehr erfordern digitale, transformative Lösungen die Gestaltung weitreichender Rahmenbedingungen an der Schnittstelle von Politik, Wirtschaft und Forschung.

Eine wesentliche Hürde können nötige Anpassungen des Rechtsrahmens sein, um innovative Lösungen tatsächlich in die Anwendung bringen zu können. Der bestehende Rechtsrahmen – von europäischen Richtlinien im Rahmen des New Legislative Frameworks über bundesdeutsche Gesetzgebung, technische Regeln bis hin zu kommunalen Verordnungen – kann mitunter so gestaltet sein, dass dieser die Einführung und Nutzung neuer, digitaler Lösungen behindert. Dies kann diverse Anwendungsbereiche betreffen – von Produktsicherheit über Umwelt- und Verbraucherschutz hin zu Handelsrecht. Es stellen sich daher die Fragen, inwiefern der bestehende Rechtsrahmen für eine digitale QI geeignet ist, bspw. welche Hürden, Hemmnisse (Stichwort Schriftformerfordernis), aber auch Potentiale sowie Anpassungsbedarfe und Gestaltungsoptionen bestehen. Im Rahmen einer von der BAM beauftragten juristischen Fachstudie werden daher gezielt alle Ebenen der Regelsetzung nach Lücken und Hindernissen für digitale Innovationen der QI untersucht. Entsprechende Analysen und abgeleitete Handlungsempfehlungen werden mit den zuständigen Akteuren, bspw. Gesetzgebern und Ministerien, aktiv geteilt und diskutiert.

Darüber hinaus ist die Initiative QI-Digital aktiv in relevanten Roadmapping-Prozessen und Normungsgremien (unter anderem bspw. zum Digitalen Produktpass) beteiligt.

QI-Digital Forum 2024

Das Jahr 2024 hält einige zentrale Entwicklungen für die QI bereit: Die EU verabschiedet den AI Act, der Digitale Produktpass nimmt Gestalt an und immer mehr europäische Datenraumkonzepte versprechen sichere digitale Ökosysteme. Diese Themen stehen daher auch im Fokus des 3. QI-Digital Forums, das am 9. und 10. Oktober an der BAM in Berlin stattfindet.

Unter dem Titel “AI Act, Data Spaces and Digital Product Passport – Setting the course for a green and digital transition“ erwarten die Besucher:innen spannende Keynotes, Paneldiskussionen und Fachvorträge sowie ein interaktiver Marktplatz mit Ausstellern und Exponaten rund um die Digitalisierung der QI. Außerdem werden Ergebnisse und Demonstratoren zu den Pilotprojekten und digitalen QI-Werkzeugen vorgestellt, die im Rahmen der Initiative QI-Digital entwickelt werden. Zudem bietet das QI-Digital Forum eine gute Gelegenheit, sich zu vernetzen und mit weiteren Stakeholdern aus der QI Herausforderungen und Chancen der Digitalisierung zu diskutieren. Mehr Informationen und die Anmeldung für eine Teilnahme vor Ort oder virtuell sind über die Website der Initiative unter www.qi-digital.de abrufbar.

Abb. 3: Das QI-Digital Forum 9. und 10. Oktober 2024 an der BAM bietet spannende Keynotes, Paneldiskussionen und Fachvorträge sowie einen interaktiven Marktplatz mit Ausstellern und Exponaten rund um die Digitalisierung der QI – und natürlich viel Gelegenheit zum Netzwerken. Quelle: QI-Digital

Einladung zur Beteiligung

Für die notwendige Weiterentwicklung der digitalen QI bedarf es des Engagements von Stakeholdern aus der QI, Wirtschaft, Politik, Verwaltung und Forschung – in Deutschland und darüber hinaus. Die Initiative QI-Digital begrüßt daher ausdrücklich die Beteiligung von Unternehmen und weiteren interessierten Akteuren.

Kontakt:

www.qi-digital.de

info@qi-digital.de

Über die Autoren:

Dr. Claudia Koch leitet das Referat Digitalisierung der Qualitätsinfrastruktur an der Bundesanstalt für Materialforschung und -prüfung (BAM) und ist Koordinatorin der BAM für die Initiative QI-Digital. Sie hat Betriebswirtschaftslehre und Internationales Wirtschaftsrecht studiert und in Innovationsökonomie an der TU Berlin promoviert.

Dr. Anna Maria Elert ist Koordinatorin der BAM für QI-Digital mit besonderem Schwerpunkt auf Themen rund um die Qualitätssicherung an technischen Anlagen. Sie hat im Fachgebiet Chemical Technology promoviert.

Lena Meyer koordiniert für die BAM QI-Digital-Aktivitäten mit Fokus auf Themen der modernen Produktion. Sie hat einen Masterabschluss in Produktionstechnik (Maschinenbau und Verfahrenstechnik).

Künstliche Intelligenz in der Qualität – Praktische Einführung durch iteratives Vorgehen

In den vergangenen Jahren sind eine Reihe von einfach zu bedienenden künstliche Intelligenz (KI) Werkzeugen entstanden, die sich problemlos in bestehende Arbeitsabläufe integrieren lassen. Chatbots wie ChatGPT und Low-Code/No-Code- Lösungen sind Beispiele hierfür. Diese Entwicklung hat die Einstiegsschwelle für Mitarbeiter, die mit KI arbeiten möchten, deutlich reduziert. Im zweiten Teil der Fachbeitragsreihe haben wir die notwendigen Qualifikationen behandelt, die Mitarbeiter in Zukunft mitbringen sollten. In diesem Fachbeitrag wird anhand eines konkreten Beispiels gezeigt, wie eine Einbindung von einfachen KI-Werkzeugen einen Mehrwert im Unternehmen schaffen kann.

Die Anwendungsfälle für KI entstehen im besten Fall aus der Kreativität der Mitarbeiter und nicht aus einer übergeordneten Firmenstrategie. Das bedeutet: Reale Probleme lösen und nicht Probleme für bestehende (IT-)Lösungen suchen. Der Vorteil hierbei ist, dass zum frühestmöglichen Zeitpunkt ein Mehrwert für das Unternehmen entsteht, ohne dass große Projektbudgets ausgelobt werden müssen.

Einsatz von Methoden aus dem agilen Projektmanagement

Insbesondere durch den Einsatz der Methoden des agilen Projektmanagements (SCRUM, KANBAN) lassen sich Projekte in eigenständige Teillösungen, sogenannte Minimal Viable Products (MVP) planen. Dies hat zur Folge, dass man Produkte beziehungsweise Lösungen in einem Baukastensystem aufbaut und immer wieder verbessert und erweitert. Gleichzeitig lässt sich die hergestellte Teillösung nutzen, ohne das Gesamtergebnis abwarten zu müssen. Dieser Ansatz fügt sich nahtlos in bestehende Programme zur kontinuierlichen Verbesserung (zum Beispiel Kaizen) ein.

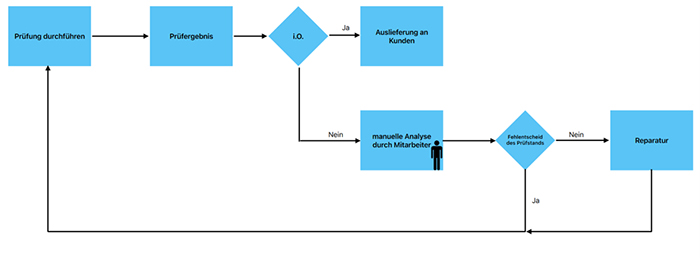

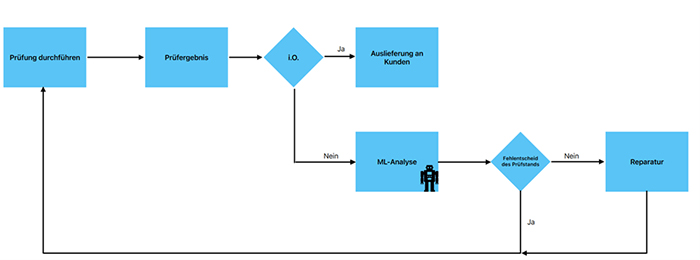

Hierfür ein Beispiel: In einer Produktionslinie werden Produkte durch das Prüfgerät fälschlicherweise als nicht in Ordnung (n.i.O.) eingestuft. Nach einer manuellen Analyse und dem Erstellen eines Analyseberichts des Mitarbeiters, wird das Produkt erneut getestet und durch das Prüfergebnis als in Ordnung (i.O.) eingestuft (siehe Abbildungen 1 und 2). Diese Fehlentscheidungen führen zu Verschwendungsformen wie: Fehlerkorrekturen, Lagerbestände, Wartezeiten und nicht genutztes Mitarbeiterpotential (s. sieben Arten der Verschwendung des Toyota Produktionssystems).

Abb. 1: Ablauf einer Prüfausfallanalyse mit manuellem Prozess

Abb. 12 Ablauf einer Prüfausfallanalyse mit maschinengestütztem Prozess

In der klassischen Qualitätssicherung ergreift man in erster Linie Maßnahmen, um das Prüfgerät und den Prüfprozess zu optimieren, zum Beispiel durch die klassische Six-Sigma-DMAIC-Methode. Gerade bei technisch anspruchsvollen Prüfungen muss jedoch häufig ein Kompromiss zwischen Fehlalarmen und der Gefahr eines Durchschlupfes gefunden werden, der sich mit klassischen Statistikwerkzeugen nur schwer auflösen lässt.

Machine-Learning-Methoden (ML) wie supervised learning können die bereits vorhandene Expertise des Mitarbeiters in Form eines Modells nachbilden und so offensichtliche Fehlalarme von vornherein zur Nachprüfung vorsehen. Das Modell wird dabei auf Basis bereits vorhandener Analyseberichte der Mitarbeiter trainiert.

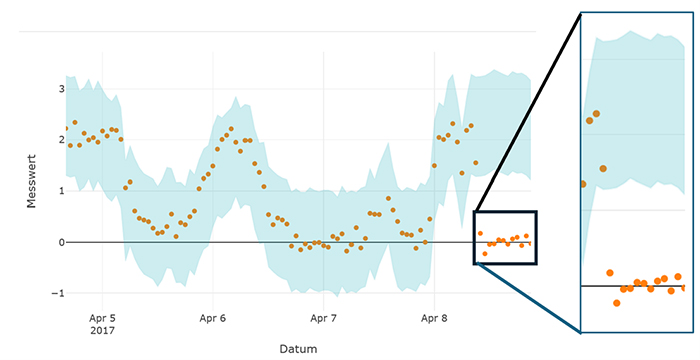

Das Ergebnis des Pilotprojekts könnte wie folgt aussehen: Der Mitarbeiter liest die Prüfberichte des Prüfgeräts im erstellten ML-Programm ein. Algorithmen wie lineare Regression oder Entscheidungsbäume erlauben es mit wenig Aufwand die Wahrscheinlichkeit für eine Fehlmessung des Prüfgeräts zu ermitteln. Abbildung 3 zeigt ein Visualisierungsbeispiel. Der Mitarbeiter kann nun alle offensichtlichen Fehlentscheide einer Wiederholungsprüfung unterziehen, ohne diese vorher im Detail zu analysieren. Alle weiteren Prüfstandsausfälle, die nicht als klare Fehlmessung klassifiziert wurden, werden zur internen Analyse weitergeleitet.

Abb. 3: Beispielhafte Darstellung einer Messdatenbewertung mit Hilfe von Machine Learning. Werte außerhalb des blauen Stabilitätsbereichs sind mit hoher Wahrscheinlichkeit auf eine Fehlfunktion am Prüfgerät zurückzuführen. ©Prophet Analytics GmbH

Durch dieses Pilotprojekt lassen sich nicht wertschöpfende Aufgaben des Mitarbeiters reduzieren und der Fokus liegt auf den tatsächlich fehlerhaften Produkten. Nun hat man einen MVP, der sofort einsatzfähig ist. Allerdings muss dieser MVP offline am (Prüf-) Rechner des Mitarbeiters bedient werden. Nicht alle Verschwendungsarten lassen sich so vollständig eliminieren.

Integration von Machine Learning basierten Lösungen in den Produktionsprozess

Eine weitere Reduzierung von Verschwendung ist möglich, wenn das Machine-Learning-Modell in die Maschinensteuerung integriert wird. So können beispielsweise Transportkosten eliminiert und die Linienauslastung verbessert werden. Für eine Linienintegration benötigt man in der Regel weitere Ressourcen, zum Beispiel aus der IT -und Prozessplanungsabteilung. Diese würde man im Rahmen der weiteren Projektarbeit und weitere MVPs planen. Der erste MVP bleibt über die gesamte Projektdauer nutzbar und erzielt Einsparungen. Wichtig ist auch, dass das Projekt erst aufgesetzt wird, wenn die technische Umsetzbarkeit der Lösung schon nachgewiesen ist und Projektrisiken so auf ein Minimum reduziert werden.

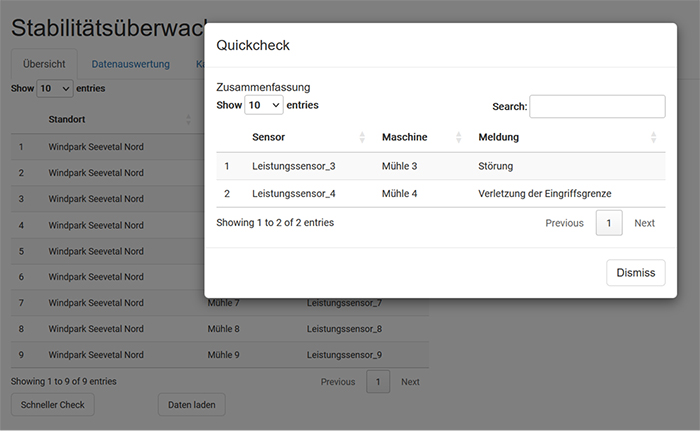

Die Firma Prophet Analytics hat diesen Ansatz zur Reduzierung von Prüfstandsfehlern noch weiter ausgebaut. Die Machine Learning basierte Lösung erkennt und lokalisiert Ursachen für Prüfstandsfehler im laufenden Betrieb (siehe Abbildung 4). Die Überwachung von Messprozessen auf Basis von Daten eliminiert unnötige Eingriffe in den Produktionsprozess. Im Gegensatz zu Stichprobenverfahren wie der statistischen Prozesskontrolle (SPC) werden die Prüfprozesse durchgehend überwacht. Verschwendung durch Fehlentscheide können so von Vornherein vermieden werden und die Gefahr von Durchschlupf und Kundenreklamationen wird gebannt.

Abb. 4: Darstellung einer automatischen Überwachung von Messprozessen mit Hilfe von Machine Learning

Das Beispiel soll zeigen, wie die einzelnen Teilprojekte logisch auf einander aufbauen. Jeder weitere MVP hebt für zusätzliche Einsparpotentiale, aber erfordert auch mehr technisches Verständnis und eine höhere Qualifikation der Mitarbeiter.

Entwicklung neuer Berufsqualifikationen

Das bemerkenswerte an dem vorgestellten Ansatz für die Einführung von KI ist, dass interessierte Mitarbeiter automatisch höhere Qualifikationen erwerben, während sie an ihren eigenen Lösungen arbeiten. Das Ergebnis der Projekte kommt direkt ihrer eigenen täglichen Arbeit zugute und es werden nur Fähigkeiten aufgebaut, die relevant und zielführend sind. Mitarbeiter, die auf diesem Wege ein hohes Qualifikationsniveau erreicht haben, werden in der Fachwelt auch Citizen Data Scientists genannt. Diese Mitarbeiter wenden regelmäßig Methoden der KI und des Machine Learning zur Unterstützung ihrer eigentlichen Tätigkeit an, sind aber keine hauptberuflichen Data Science Experten.

Zusammenfassend kann gesagt werden, dass der Fokus auf einfache Anwendungsfälle für KI sich direkt aus dem kontinuierlichen Verbesserungsgedanken ergibt. Das Beispiel hat gezeigt, wie sich selbst bei einfachen KI Anwendungsfällen durch mehrfache Erweiterung immer höhere Einsparpotentiale heben lassen. Das iterative Vorgehen stellt dabei sicher, dass Einsparungen zeitnah wirksam werden und Finanzierungskosten für Projekte gering bleiben. Die Qualifikation der Mitarbeiter wächst parallel zur Umsetzung mit jedem KI-Anwendungsfall. Das natürliche Ende dieses iterativen Aufbaus von Qualifikationen ist der Citizen Data Scientist. Der Citizen Data Scientist kann KI-Methoden einsetzen und bringt ein hohes Maß an anwendungsspezifischen Kenntnissen mit.

Lesen Sie auch die ersten beiden Teile der Reihe “Künstliche Intelligenz in der Qualität“:

- Teil 1: Künstliche Intelligenz in der Qualität – Bestehendes Know-how effektiv nutzen – zum Beitrag »

- Teil 2: Künstliche Intelligenz in der Qualität – Welche Qualifikationen werden benötigt? – zum Beitrag »

Über die Autoren:

Dipl.-Ing. Waldemar Fahrenbruch ist Head of Q-Technology Division E-Mobility bei der ZF Friedrichshafen AG. Er ist verantwortlich für die Qualitätskostensenkung bei gleichzeitiger Optimierung von Qualitätskonzepten in den Werken der Division E (TCU, Power Electronics und E-Motoren Fertigung) durch Methodenkompetenz der Qualität, künstlicher Intelligenz und digitaler Transformation.

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Künstliche Intelligenz. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten. Kontakt: ki@prophet-analytics.de

Mehr digitale Resilienz dank NIS-2-Richtlinie der EU

Die Richtlinie hat das Ziel, das Cybersicherheitsniveau innerhalb der EU zu vereinheitlichen und zu erhöhen. Sie ist im Januar 2023 in Kraft getreten und muss bis Oktober 2024 von den Mitgliedstaaten in nationales Recht umgesetzt werden. Aber dies geht nicht ohne gewissen Aufwand. Die Richtlinie sieht diverse Maßnahmen auf staatlicher Seite sowie für Unternehmen vor. Sie gilt in Deutschland für circa 40.000 Unternehmen in 18 Branchen ab 50 Mitarbeiter.

Die NIS-2-Richtlinie zielt darauf ab, die Sicherheit von Netzwerken und Informationssystemen in der EU zu stärken und die Resilienz- und Reaktionskapazitäten öffentlicher und privater Stellen, der zuständigen Behörden und der EU insgesamt weiter zu verbessern. Dies ist in Zeiten der wachsenden Digitalisierung und anhand der fast täglichen Meldungen im Bereich Cyberkriminalität zu begrüßen.

Solche Anforderungen stoßen aber in diesen unruhigen Zeiten aufgrund von Fachkräftemangel, Zeitnot und der für viele Organisationen engen finanziellen Spielräume auch auf Widerstände. Viele davon sind vermutlich auf eine Mischung aus Ignoranz, Hoffnung („Bei uns passiert schon nichts.“), Unwissenheit („Was ist NIS-2?“) und Fehleinschätzungen („Wir sind kein Ziel, bei uns ist nichts zu holen.“) zurückzuführen. Teilweise sind Widerstände auch der brutalen Erkenntnis geschuldet, angesichts der Bedrohungen bisher zu wenig getan zu haben. Gar mancher scheint das Ohnmachtsgefühl zu haben, sich ohnehin nicht wehren zu können.

Andererseits geht die Digitalisierung ohne Pause weiter. Neue Trends wie die KI bringen neue Herausforderungen, aber auch Möglichkeiten. Also wann will man mehr für die Sicherheit tun, wenn nicht jetzt? Und ist „Nichtstun“ wirklich eine Option?

Vorbereitung der Mitgliedsstaaten auf den Ernstfall

Die genannten staatlichen Maßnahmen dienen der Vorbereitung der Mitgliedstaaten. Sie verlangen, dass sie eine Organisation hierfür aufbauen und angemessen ausgerüstet sind. Zum Beispiel soll ein Computer Security Incident Response Team (CSIRT) und eine zuständige nationale Behörde für Netzwerk- und Informationssysteme (NIS) geschaffen werden. Dies wird in Deutschland in weiten Teilen vom Bundesamt für Sicherheit in der Informationstechnik sowie anderen Stellen abgedeckt. So unterhält die Polizei in den Ländern spezielle Stellen für diese Themen, die sogenannten ZAC, die Zentrale Ansprechstelle Cybercrime. Dort sind auf das Thema spezialisierte Juristen, IT-Fachleute und Polizei im Verbund aktiv.

Auch gilt es, die Zusammenarbeit zwischen allen Mitgliedstaaten durch Einsetzung einer Kooperationsgruppe zur Unterstützung und Erleichterung der strategischen Zusammenarbeit und des Informationsaustauschs zu organisieren und schrittweise zu verbessern.

Für staatliche Stellen und die Privatwirtschaft in allen Sektoren, die für unsere Wirtschaft und Gesellschaft von entscheidender Bedeutung und stark auf IKT angewiesen sind, müssen Maßnahmen ergriffen werden. Dies sind zum Beispiel Energie, Verkehr, Wasser, Banken, Finanzmarktinfrastrukturen, Gesundheitsversorgung und digitale Infrastruktur. Wichtige Anbieter digitaler Dienste wie Suchmaschinen, Cloud-Computing-Dienste und Online-Marktplätze müssen die Sicherheits- und Benachrichtigungsanforderungen der Richtlinie erfüllen. Besonders hervorzuheben ist die Geltung in großen Sektoren wie dem Maschinen- und Fahrzeugbau sowie der Chemie- und Lebensmittelindustrie.

Besonders relevant ist das Thema Haftung, denn Geschäftsführer sollen teilweise persönlich(!) für die Umsetzung (und Billigung) der Sicherheitsmaßnahmen in ihrer Einrichtung haften. In Verbindung mit Durchsetzungsregeln (Kontrollbesuche, Überprüfungen etc.) und einem verschärften Bußgeld- und Berichtswesen ist die NIS-2-Richtlinie ein wichtiger Schritt in Richtung einer einheitlichen und verbesserten Cybersicherheit in der EU.

| Berufsbild Informationssicherheitsbeauftragter Informationen und Daten haben einen sehr großen Wert und bilden die Grundlage für Unternehmen und deren Geschäftsprozesse. Umso wichtiger ist es, diese vor Diebstahl, Missbrauch oder Verlust zu schützen. Informationssicherheit und der Job als Informationssicherheitsbeauftragter spielen dabei eine wesentliche Rolle. Sie wollen Unternehmen bei dem Schutz ihrer Daten unterstützen und finden einen Job als Informationssicherheitsbeauftragter spannend? Antworten auf die wichtigsten Fragen finden Sie in unserem Berufsbild zum Informationssicherheitsbeauftragten:

|

Maßnahmenbündel zum Schutz vor Sicherheitsheitsvorfällen

Die konkret genannten Maßnahmen müssen auf einem umfassenden gefahrenübergreifenden Ansatz beruhen, der darauf abzielt, die Netz- und Informationssysteme und die physische Umwelt dieser Systeme vor Sicherheitsvorfällen zu schützen. Ein paar Beispiele für den Themenkreis der Anforderungen sind:

- Risikoanalyse

- Bewältigung von Sicherheitsvorfällen

- Aufrechterhaltung des Betriebes

- Sicherheit der Lieferkette

- Sicherheit bei Entwicklung und Wartung

- Bewertung von Risikomanagementmaßnahmen

- Schulungen im Bereich der Cybersicherheit

- Kryptografie und Verschlüsselung

- Sicherheit des Personals und Konzepte für die Zugriffskontrolle

- Sichere (Notfall-)Kommunikation

- Awareness-Schulungen für Mitarbeiter und Führungskräfte

Positiv zu werten ist, dass die genannten Themen in der Praxis heute bereits im Rahmen von ausgereiften Informationssicherheitsmanagementsystemen (ISMS) unter anderem im Bereich Automotive durch TISAX® adressiert werden und im Business Continuity Management System (BCMS) Thema sind.

Die Umsetzung der Richtlinie erfolgt im Rahmen eines NIS-2-Umsetzungs- und Cybersicherheitsstärkungsgesetz (NIS2UmsuCG). Das Gesetzgebungsverfahren ist bereits im Gange, da verschiedene bestehende Gesetze (zum Beispiel BSIG; Kritis-Gesetze) miteinander im Sinne der NIS-2-Richtlinie zu harmonisieren sind. Aufgrund der vorhandenen Behörden und der gesetzlichen Vorarbeiten ist Deutschland hier schon relativ gut aufgestellt und muss wenig „Neues“ schaffen. Vielmehr geht es hierzulande darum zu integrieren, zu strukturieren und zu konkretisieren sowie schneller und besser zu werden.

Nach ISO/IEC 27001 zertifizierte Unternehmen sind im Vorteil

Erfreulich ist zudem, dass in den Erwägungsgründen der Richtlinie ausdrücklich die Normenreihe ISO/IEC 27000 (die 27001er ist ein Teil davon und zertifizierbar) als Bezugsrahmen für den Nachweis der Einhaltung der gesetzlichen Anforderungen zugelassen ist. Wohl dem, der bereits ein ISMS auf Basis ISO/IEC 27001 beziehungsweise TISAX® und BCMS (zum Beispiel auf Basis BIS-IT Grundschutz 200-4 oder ISO/IEC 22301) hat. Denn für diese Organisation wird wenig Mehraufwand wegen NIS-2 anfallen.

Über den Autor:

Klaus Kilvinger ist Geschäftsführender Gesellschafter der Opexa Advisory GmbH, einer auf die Themen Digitalisierung, Cyber- und Informationssicherheit, sowie deren Integration in Geschäftsprozesse spezialisiertes Beratungsunternehmen mit Hauptsitz in München. Er ist seit über 30 Jahren in der IT-Branche aktiv und verfügt über ein breites anwendungsbezogenes Erfahrungswissen, verfügt ferner über umfassende Kenntnisse und Erfahrungen im IT-Projektgeschäft sowie Fachwissen in der Software-Qualitätssicherung. Die Informationssicherheit im nationalen und internationalen Umfeld ist sein Zuhause. Als zertifizierter IT-Security Manager, IT-Security Beauftragter sowie Datenschutzbeauftragter verfügt er über breite Branchenkenntnisse, über die Fertigungs-, Automobilindustrie, den öffentlichen Sektor bis hin zur Wirtschaftsprüfung.

Künstliche Intelligenz in der Qualität – Welche Qualifikationen werden benötigt?

Künstliche Intelligenz (KI) in ihrer aktuellen Form hat eine hohe Aufmerksamkeit auf sich gezogen. Viele Firmen stellen sich die Frage, wie sie sich am besten auf die neuen Entwicklungen vorbereiten können. Einer der wichtigsten Erfolgsfaktoren ist dabei die Qualifikation der Mitarbeiter. Im ersten Teil dieser Serie wurde gezeigt, dass das Qualitätswesen eine vergleichsweise kleine Einstiegsschwelle in diese neuen KI-Technologien hat. Die Aufgabe des Qualitätswesens war es seit jeher, mit Hilfe von Daten und Statistik Transparenz zu schaffen und Verbesserungspotentiale zu heben. KI stellt somit in vielerlei Hinsicht eine Erweiterung des bestehenden Methodenkoffers dar. Auch für das Qualitätswesen stellt sich jedoch die Frage, wie Mitarbeiter am besten für den Einsatz neuer Methoden qualifiziert werden können.

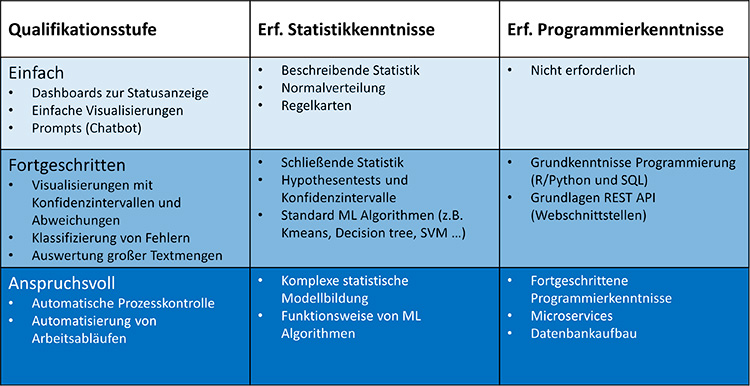

In diesem Beitrag beschreiben wir drei Stufen der Qualifikation mit Mindestanforderungen. Die niedrigste Qualifikationsstufe ist dabei in der Regel für alle Qualitätsmitarbeiter ohne erweiterte Trainingsmaßnahmen erreichbar. Es wird gezeigt, dass sich mit jeder Qualifikationsstufe neue Anwendungsfälle erschließen lassen, die weitere Einsparpotenziale bieten. Welche Methoden für den einzelnen Mitarbeiter relevant sind, hängt vom Einsatzbereich innerhalb der Qualität ab. Es wird daher gezeigt, in welchem Bereich welche Technologie am besten einsetzbar ist und wie hoch die Einsparpotenziale typischerweise sind.

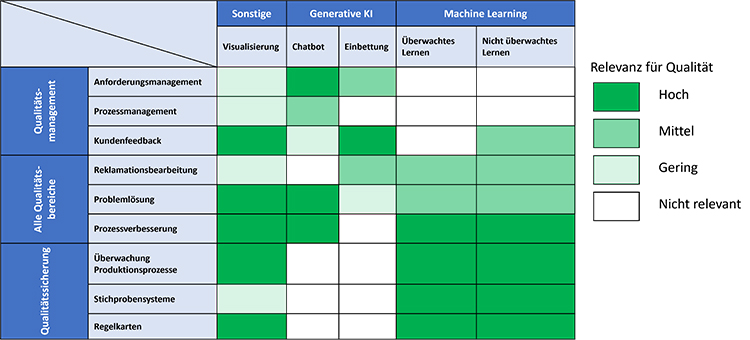

Methoden der künstlichen Intelligenz und ihre Anwendungsgebiete innerhalb des Qualitätswesens

Tabelle 1 zeigt eine Übersicht, welche Methoden für das Qualitätsmanagement und die Qualitätssicherung relevant sind. Die Methoden fallen in zwei große Bereiche der künstlichen Intelligenz: Machine Learning und generative KI. Machine Learning beinhaltet sowohl erweiterte statistische Verfahren als auch Bilderkennung. Generative KI wurde durch den Chatbot ChatGPT und die Bildverarbeitungsmodelle Midjourney und Stable Diffusion bekannt. Chatbots eignen sich zur Verarbeitung großer Textmengen (z.B. Normentexten oder Kundenanforderungen). Bildverarbeitungsmodelle sind im Qualitätsbereich weniger von Interesse.

Eine weniger bekannte Anwendung generativer KI ist die Einbettung (embedding). Einbettung erlaubt Texte zu gruppieren oder auf Ähnlichkeit zu prüfen. So können beispielsweise Kundenbewertungen zusammengefasst werden oder 8D Berichte nach ähnlichen Fehlerbildern durchsucht werden. Einbettung kann als eine Art erweiterte Schlagwortsuche verstanden werden, bei der nicht mehr nach exakten Übereinstimmungen, sondern nach ähnlichen Sinnzusammenhängen gesucht wird.

Eine weitere wichtige Disziplin stellt die Visualisierung von Daten dar. Visualisierung ist kein Teilgebiet der künstlichen Intelligenz, aber sie spielt eine wichtige Rolle in der Vermittlung von Ergebnissen. Insbesondere bei komplexeren Methoden des Machine Learnings ist eine gute Visualisierung unabdingbar.

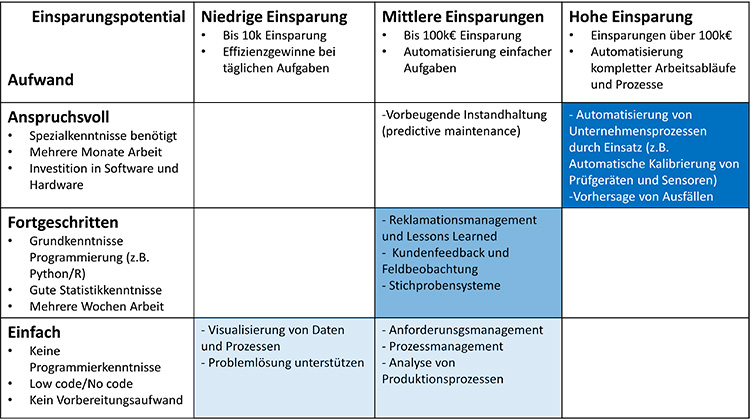

Tab. 1: Methoden der künstlichen Intelligenz und ihre Anwendungsgebiete innerhalb des Qualitätswesens.

Tabelle 1 kann in drei Anwendungsgruppen unterteilt werden. Visualisierung spielt überall dort eine große Rolle, wo aus Daten Korrekturmaßnahmen abgeleitet werden. Dies ist in der Problemlösung und Prozessverbesserung (KVP/Kaizen) der Fall. Auch in der Fertigung findet man solche Anwendungsfälle (z.B. Shopfloorvisualisierungen). Diese Anwendungsfälle lassen sich häufig mit geringem Aufwand und No-Code-Werkzeugen umsetzen.

Die zweite Anwendungsgruppe Generative KI beinhaltet Anwendungsfälle, bei denen große Mengen an Text analysiert und verarbeitet werden müssen. Das Qualitätsmanagement hat einen starken Bezug zu Normen, Richtlinien und Kundenvorgaben. Generative KI können in Form von Chat Bots viele Aufgaben vereinfachen (z.B. der Vergleich unterschiedlicher Normen oder das Erstellen von Gap-Listen bei Normänderungen). Außerdem können Chatbots mit geeigneten Prompts Problemlösungsprozesse unterstützen.

Die dritte Anwendungsgruppe umfasst das Machine Learning. Machine Learning hat eine große Überschneidung mit klassischer Statistik. Statistikwerkzeuge sind in der Qualitätssicherung weit verbreitet. Machine Learning bietet Methoden zum Klassifizieren und Clustern von Daten. Es können auch Modelle und Prognosen über zukünftige Verläufe erstellt werden. Diese Methoden eignen sich auch hervorragend zur Analyse großer Datensätze, die in modernen Produktionsprozessen entstehen.

Die Frage, die sich Mitarbeitern und Führungskräften gleichermaßen stellt ist: Welche Anwendungsfälle können mit den zur Verfügung stehenden Zeitressourcen bearbeitet werden und wie hoch sind die zu erwartenden Einsparungen. Tabelle 2 soll hierzu eine Hilfestellung geben. Auf der horizontalen Achse sind die zu erwartenden Einsparsummen und auf der vertikalen Achse sind die benötigten Ressourcen abgetragen. Es zeigt sich, dass mit höheren Qualifikationen und größerem Zeiteinsatz auch Anwendungen erschlossen werden können, die größere Einsparungen hervorbringen. Mit Hilfe der Tabelle können Qualifikationsmaßnahmen und Einsparziele zu einer Strategie mit Zielvorgaben verzahnt werden. Es ist wichtig zu betonen, dass es sich bei der Einteilung um Erfahrungswerte handelt, die je nach Anwendung abweichen können.

Tab. 2: Gegenüberstellung von typischen Einsparpotenzialen und notwendiger Qualifikation für typische Anwendungsfälle.

Als Pilotprojekte für künstliche Intelligenz eignen sich Anwendungsfälle der einfachen Kategorie. Diese Projekte können in der Regel ohne Einsatz von Programmierung erstellt werden und nutzen entweder vorgefertigte Lösungen wie ChatGPT oder Low-code-/No-Code-Software wie PowerBI oder KNIME. Das Ergebnis solcher Projekte sind häufig Dashboard-Lösungen oder kleine Werkzeuge. Sie können elegant in bestehende Prozesse eingebunden werden und reduzieren den Arbeitsaufwand bei wiederkehrenden Tätigkeiten. Der Fokus auf einfache Pilotprojekte erzeugt schnellen Mehrwert und Motivation.

Es ist nicht ungewöhnlich, dass einfache Projekte, wenn sie erfolgreich sind, immer wieder erweitert werden und von der einfachen auf die fortgeschrittene oder sogar anspruchsvolle Stufe gelangen. Ähnlich wie beim agilen Projektmanagement entsteht auf jeder Stufe neuer Mehrwert.

Typische Anforderungsprofile für Mitarbeiter der unterschiedlichen Qualifikationsniveaus

Ein Beispiel soll dies verdeutlichen: Viele Firmen nutzen automatische Prüfsysteme. Bei schwierigen Prüfaufgaben muss oft ein gewisses Maß an Fehlentscheidungen in Kauf genommen werden. Die Fehlerteile müssen dann händisch nachkontrolliert und gegebenenfalls nachgeprüft werden. Die Nachprüfentscheidung basiert oft auf einfachen Regeln. Diese Regeln lassen sich leicht mit Hilfe von Machine Learning auf Software übertragen, wenn eine ausreichende Anzahl von Beispielen vorhanden sind.

Das Ergebnis eines einfachen Pilotprojekts könnte wie folgt aussehen: Der Mitarbeiter liest die n.i.O.-Prüfberichte im erstellten ML-Programm ein. Das Programm gibt als Ergebnis alle Fehlentscheide mit einem zugehörigen Vertrauensniveau aus. Der Mitarbeiter kann alle offensichtlichen Fehlentscheide einer Wiederholungsprüfung unterziehen, ohne die Ausfälle im Detail zu analysieren. Durch das Pilotprojekt lassen sich repetitiven Aufgaben des Mitarbeiters reduzieren und er kann seinen Fokus den Echtfehlern widmen.

Das Pilotprojekt lässt sich in die fortgeschrittene Stufe erweitern, wenn die Software in die Produktionslinie integriert wird. Die benötigten Ressourcen steigen und es werden mehr Kenntnisse aus der IT und den technischen Abteilungen benötigt, aber die Einsparung ist ungleich größer. Da die Entscheidung nun innerhalb der Produktionsmaschine erfolgt, fallen Transportschritte und händische Teileerfassung in der Analyse weg. Dieses iterative Vorgehen minimiert Umsetzungsrisiken und erzeugt zählbaren Mehrwert bei jeder Erweiterung.

Die fortgeschrittene Aufwandskategorie benötigt bereits Grundkenntnisse in der Programmierung. R und Python sind hier die am weitesten verbreiteten Programmiersprachen [5]. Diese Programmiersprachen sind in vielen anderen Werkzeugen integriert, so dass beispielsweise ein Knime- oder PowerBI-Dashboard verwendet werden kann, um die Ergebnisse zu visualisieren, die mit einem Python Skript berechnet wurden. Mitarbeiter mit fortgeschrittener Qualifikation können Projekte mit erheblichen Einsparpotentialen umsetzen. Gleichzeitig sind die Projekte meist noch klein genug, um als Abschlussarbeit oder als Sonderaufgabe neben dem Tagesgeschäft bearbeitet zu werden.

In die anspruchsvolle Kategorie fallen Projekte, die von hochqualifizierten Mitarbeitern bearbeitet werden müssen. Die Einsparpotenziale sind hier nach oben offen, aber in der Regel sind diese Projekte so groß und komplex, dass Mitarbeiter mehrer Fachabteilungen zusammenarbeiten müssen. Oft werden bei solchen Projekten auch externe Experten hinzugezogen, um Qualifikationslücken innerhalb des Teams zu kompensieren. Anspruchsvolle Projekte zielen oft darauf ab, komplette Arbeitsabläufe zu komplett zu automatisieren. Ein Anwendungsbeispiel hierfür ist die Automatisierung der Überwachung von Prüfmitteln, die heute in der Regel händisch und unter hohem Aufwand erfolgt.

Mitarbeiter, die das höchste Qualifikationsniveau erreichen, sind Spezialisten. Im letzten Beitrag wurde die große Ähnlichkeit zwischen dem IBM Data Science Modell und Six Sigma dargestellt. Ähnlich wie ein Six Sigma Black Belt haben diese Spezialisten oft die Aufgabe, weniger qualifizierte Mitarbeiter anzuleiten und zu unterstützen.

Tabelle 3 zeigt Mindestqualifikationen für die Aufgabenkategorien aus Tabelle 2. Die erforderlichen Qualifikationen fallen in zwei Kategorien: Statistikkenntnisse, die benötigt werden, um die Korrektheit der Auswertungen bewerten zu können und Programmierkenntnisse, die für anspruchsvolle Anwendungen erforderlich sind. Auch hier handelt es sich um Erfahrungswerte. Im Einzelfall können die notwendigen Qualifikationen abweichen.

Die Tabelle 3 soll eine Richtschnur darstellen, was Mitarbeiter üblicherweise benötigen, um KI Aufgabenstellungen zu bearbeiten. Die Richtschnur ermöglicht Führungskräften, ihre Qualifikationsmaßnahmen auf ihre eigenen Anwendungen abzustimmen. Sie stellt außerdem sicher, dass Mitarbeiter mit Aufgaben betraut werden, die zu ihrem Qualifikationsprofil passen und so weder über- noch unterfordert sind. Wenn die Möglichkeit besteht, ist interne Qualifikation externer Unterstützung vorzuziehen. Der entscheidende Vorteil liegt darin, dass die Mitarbeiter aus der eigenen Domäne die Daten, Prozesse und Produkte des Unternehmens bereits kennen. Externe Experten müssen sich dieses Wissen erst erarbeiten.

Zusammenfassend kann gesagt werden, dass die Qualifikation der Mitarbeiter eine Schlüsselrolle bei der Einführung von KI im Qualiätsbereich darstellt. Die Qualifikation der Mitarbeiter bestimmt die Anwendungsfälle, die bearbeitet werden können. Aus diesem Grund müssen Qualifikationsmaßnahmen und die Projektplanung für den Einsatz von KI auf einander abgestimmt sein. Die beigestellten Tabellen liefern Richtwerte für gängige Anwendungsfälle und erlauben es Führungskräften, die richtigen Prioritäten bei der Einführung von KI zu setzen.

Lesen Sie auch die beiden anderen Teile der Reihe “Künstliche Intelligenz in der Qualität“:

- Teil 1: Künstliche Intelligenz in der Qualität – Bestehendes Know-how effektiv nutzen – zum Beitrag »

- Teil 3: Künstliche Intelligenz in der Qualität – Praktische Einführung durch iteratives Vorgehen – zum Beitrag »

Über die Autoren:

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Künstliche Intelligenz. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten. Kontakt: ki@prophet-analytics.de

Dipl.-Ing. Waldemar Fahrenbruch ist Head of Q-Technology Division E-Mobility bei der ZF Friedrichshafen AG. Er ist verantwortlich für die Qualitätskostensenkung bei gleichzeitiger Optimierung von Qualitätskonzepten in den Werken der Division E (TCU, Power Electronics und E-Motoren Fertigung) durch Methodenkompetenz der Qualität, künstlicher Intelligenz und digitaler Transformation.

Fahrenbruch, Waldemar, Prorok Stefan. „Künstliche Intelligenz in der Qualität – Bestehendes Know-how effektiv nutzen“ https://www.dgq.de/fachbeitraege/kuenstliche-intelligenz-in-der-qualitaet-bestehendes-know-how-effektiv-nutzen/

Mumtarin, Maroa, Md Samiullah Chowdhury, and Jonathan Wood. “Large Language Models in Analyzing Crash Narratives–A Comparative Study of ChatGPT, BARD and GPT-4.” arXiv preprint arXiv:2308.13563 (2023).

Zhang, Yongfeng, et al. “Learning over knowledge-base embeddings for recommendation.” arXiv preprint arXiv:1803.06540 (2018).

Bach, Benjamin, et al. “Challenges and opportunities in data visualization education: A call to action.” IEEE Transactions on visualization and computer graphics (2023).

Agresti, Alan, and Maria Kateri. Foundations of statistics for data scientists: with R and Python. CRC Press, 2021.

Prorok, Stefan „Machine Learning in der Produktion – Warum die digitale Revolution anders aussieht, als gedacht.“ https://prophet-analytics.de/whitepapers/stat_models.pdf

Künstliche Intelligenz in der Qualität – Bestehendes Know-how effektiv nutzen

Viele Branchen sind heute mit stetig steigenden Qualitätsanforderungen konfrontiert. Zusätzlich erfordern komplexere Produkte erweiterte Absicherungen im Herstellungsprozess. Gleichzeitig stehen viele Hersteller vor der Herausforderung, Kostenoptimierungen umzusetzen, um langfristig wirtschaftlich zu bleiben. Wie kann Qualität diesen Spagat schaffen?

Neue Methoden im Bereich der künstlichen Intelligenz (KI), insbesondere des Machine Learnings bieten Möglichkeiten, um Verbesserungspotenziale auf Basis bestehender Daten zu heben. Besonders bei komplexen Produktionsabläufen kann Machine Learning zu neuen Erkenntnissen führen. Für Praktiker stellt sich allerdings die Frage, wie sich neue Methoden sinnvoll in bestehende Arbeitsabläufe integrieren lassen.

Dieser Beitrag zeigt auf, dass es große Überschneidungen zwischen klassischen Q-Werkzeugen und modernen KI Methoden gibt. Machine Learning, als Unterdisziplin der KI, wird den Methodenkoffer der Qualität langfristig erweitern. Der Beitrag nennt darüber hinaus Erfolgsfaktoren für Mitarbeiter und Führungskräfte, die Machine Learning in ihrer Firma einsetzen wollen, um ihre Prozesse effizienter zu gestalten.

Machine Learning als Prozess und Methode

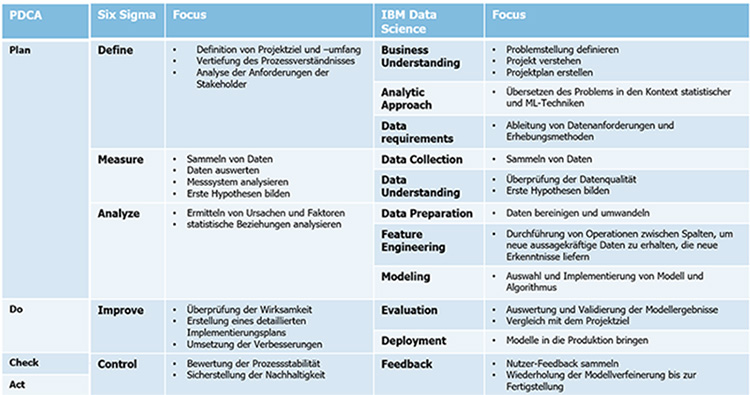

Der Einstieg in den Bereich des Machine Learnings gestaltet sich in der Qualität wesentlich einfacher als in anderen Ressorts. In Abbildung 1 ist ein Vergleich der Methoden des PDCA-Zyklus, der Six Sigma DMAIC Methode und der IBM Data Science Methode dargestellt. Die Abbildung zeigt die Parallelen der Ansätze.

Alle drei Methoden verfolgen das gleiche Ziel: Nachhaltige Lösung eines bestimmten Problems.

Machine Learning und klassische Qualitätswerkzeuge basieren grundsätzlich auf Methoden der Statistik (induktive, deskriptive und explorative Statistik). Hier zeigen sich ebenfalls große Überschneidungen zwischen den beiden Ansätzen. Somit ist das Grundwissen für Machine Learning in vielen Qualitätsbereichen bereits vorhanden.

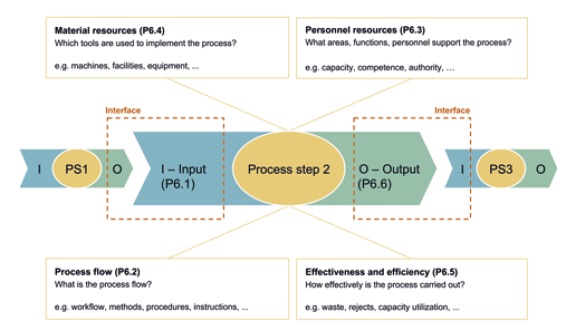

Auch prozessseitig gibt es große Parallelen zwischen KI-Projekten und dem klassischen Qualitätswesen. KI-Anwendungen lassen sich durch das Turtle Modell beschreiben (vergleiche Abbildung 2). In diesem Fall liegt der Fokus auf Dateneingabe, Verarbeitung mit Generierung der wertschöpfenden Informationen und Datenausgabe. Der Ansatz ist jedoch gleich.

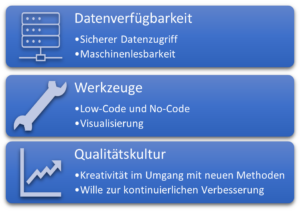

Was bleibt ist die Frage, wie eine gute Umsetzungsstrategie aussehen kann, um die neuen Machine Learning Werkzeuge im Unternehmen einzuführen. Eine der größten Hürden bei der Nutzung von Machine Learning besteht darin, Daten in geeigneter Art und Weise für die Mitarbeiter bereitzustellen. Hierbei kommt den Führungskräften eine Schlüsselrolle zu.

Datenverfügbarkeit und Dokumentation

Führungskräfte haben großen Einfluss darauf, wie und in welcher Form Daten abgelegt werden. Es gilt darauf achten, dass von vornherein möglichst nur maschinenlesbare Daten erzeugt werden.

Folgende Prinzipien helfen dabei, dieses Ziel zu erreichen:

- Standardisierung der Daten mit einem einheitlichen Datenmodell

- Nutzung von Datenbanken als Datenablage

- Wenn keine Datenbank verwendet werden, sind einfach interpretierbare Dateiformate (z.B. csv oder xml) sinnvoll

- Für Prozessdokumentation sollten feste Formulare mit möglichst wenig Freitext gewählt werden.

Die zweite Aufgabe für Führungskräfte besteht darin die Daten verfügbar zu machen. Es müssen Schnittstellen geschaffen werden, über die die Mitarbeiter sicher auf Daten zugreifen können. Dabei muss sichergestellt sein, dass eine fehlerhafte Abfrage nicht zu ungewolltem Datenverlust führen kann. Dies ermöglicht einen spielerischen Umgang mit Daten ohne Risiko. Anschließend sind die Mitarbeiter an der Reihe diese Daten gewinnbringend zu nutzen.

Auswahl geeigneter Anwendungen

Eine wichtige Aufgabe der Qualität war es seit jeher Transparenz zu schaffen und Optimierungspotenziale aufzudecken. Diese Aufgabe wird im Datenzeitalter noch wichtiger. Der Umgang mit Daten wird in Zukunft eine grundlegende Anforderung an Mitarbeiter im Qualitätswesen sein. Es ist jedoch nicht realistisch, alle Qualitätsmitarbeiter auf das Qualifikationsniveau von Datenspezialisten zu heben. Dies ist aber auch nicht nötig. Der Schlüssel zum Erfolg liegt in einer geeigneten Auswahl von Softwarewerkzeugen.

No-Code/Low-Code Lösungen, wie KNIME oder Tableau, bieten einfache Möglichkeiten, die Einstiegsschwelle für Mitarbeiter zu senken und schnellen Mehrwert zu schaffen. Grafische Visualisierungen und Dashboards stellen dabei einen guten Einstieg in die Welt des Machine Learnings dar. Dashboards können beispielswese gleichzeitig Auskunft über verschiedene Kennzahlen (z.B. Stillstandszeiten, OEE oder Ausschuss) geben und lassen sich gut in tägliche Shopfloormeetings einbinden. Es werden keine Programmierkenntnisse benötigt, um einfache Dashboards zu erstellen. Die Anleitungen sind meist frei im Internet verfügbar und viele Werkzeuge können kostenlos verwendet werden. Entscheidend für den erfolgreichen Einsatz von Dashboards ist, dass die Daten nicht mehr von Hand eingepflegt werden. So können die Mitarbeiter sich auf die Lösung der Probleme konzentrieren. Dies erhöht die Akzeptanz und motiviert die Mitarbeiter nach weiteren Anwendungen zu suchen. Der Übergang zum tatsächlichen Machine Learning (zum Beispiel durch Erweiterung von Dashboards für Klassifikation und Prognosen) ist fließend.

Ein weiteres Themenfeld für einen einfachen Einstieg sind Sprachmodelle. KI-Werkzeuge wie ChatGPT können Daten und Texte schnell zusammenfassen oder Fragen zu den Eingangsdaten beantworten. Sprachmodelle benötigen ebenfalls keine Programmiererfahrung und eignen sich hervorragend für Einsteiger. Interessant sind Sprachmodelle auch deshalb, weil sie sich einfach anpassen und mit anderen Systemen verknüpfen lassen (zum Beispiel automatische Terminbuchungen im Kalender oder Erfassung von Kundenreklamationen). Folgender Link zeigt ein angepasstes Sprachmodell, welches Fragen zu ISO 9001 oder IATF 16949 beantwortet. Sprachmodelle und Datenverarbeitung werden in den nächsten Jahren noch sehr viel enger zusammenwachsen. Beispiele hierfür sind Copilotfunktionen, die den Benutzer bei seiner Arbeit unterstützen und für Microsoft Windows und Office bereits erprobt werden.

Was die Zukunft bringt

Wir gehen davon aus, dass Programmierkenntnisse durch weitere Verbreitung von Copiloten und Low-Code/No-Code Werkzeugen an Bedeutung verlieren werden. Machine Learning wird damit für mehr Mitarbeiter ohne Programmierkenntnisse einsetzbar.

Im Zuge dieser Entwicklung werden immer mehr Methoden des Machine Learnings (Clustern, Klassifikation, Regression oder Prognosen auf Basis von Modellen) in den Methodenkoffer des Qualitätswesens integriert werden. Die grundlegende Arbeitsweise des Qualiätswesens nach PDCA und DMAIC bleibt dabei erhalten. Die neuen Werkzeuge aus dem Bereich Machine Learning versprechen schnellere Problemlösung und hohe Transparenz. Mitarbeiter, die heute noch händisch Daten erfassen und verarbeiten, werden entlastet und können so weitere Verbesserungen für das Unternehmen erzielen.

Unternehmen können diese Entwicklung aktiv fördern, indem sie die Datenqualität und Datenverfügbarkeit verbessern (siehe Abbildung 3). Mitarbeiter sollten spielerisch an Datenverarbeitung und Machine Learning herangeführt werden und ihre intrinsische Motivation sollte durch geeignete Schulungen aktiv unterstützt werden. Der Fokus für Qualifikation sollte dabei darauf liegen die Methoden des Machine Learnings zu kennen und diese Methoden mittels Low Code / No Code Lösungen im Unternehmenskontext einzusetzen.

Lesen Sie auch die beiden anderen Teile der Reihe “Künstliche Intelligenz in der Qualität“:

- Teil 2: Künstliche Intelligenz in der Qualität – Welche Qualifikationen werden benötigt? – zum Beitrag »

- Teil 3: Künstliche Intelligenz in der Qualität – Praktische Einführung durch iteratives Vorgehen – zum Beitrag »

Über die Autoren:

Dipl.-Ing. Waldemar Fahrenbruch ist Head of Q-Technology Division E-Mobility bei der ZF Friedrichshafen AG. Er ist verantwortlich für die Qualitätskostensenkung bei gleichzeitiger Optimierung von Qualitätskonzepten in den Werken der Division E (TCU, Power Electronics und E-Motoren Fertigung) durch Methodenkompetenz der Qualität, künstlicher Intelligenz und digitaler Transformation.

Dr.-Ing. Stefan Prorok ist Geschäftsführer der Prophet Analytics GmbH und DGQ-Trainer für Qualitätssicherung und Künstliche Intelligenz. Prophet Analytics unterstützt Unternehmen in allen Phasen Ihrer KI-Umsetzung mit Trainings- und Beratungsangeboten. Kontakt: ki@prophet-analytics.de

Rollins, John. “Why we need a methodology for data science.”, IBM Analytics Whitepaper (2015). https://tdwi.org/~/media/64511A895D86457E964174EDC5C4C7B1.PDF

Al-Sai, Zaher Ali, Rosni Abdullah, and Mohd Heikal Husin. “Critical success factors for big data: a systematic literature review.” IEEE Access 8 (2020): 118940-118956.

Ahmad, Norita, and Areeba Hamid. “Will Data Science Outrun the Data Scientist?.” Computer 56.2 (2023): 121-128.

https://www.knime.com/blog/anomaly-detection-predictive-maintenance-control-chart

https://prophet-analytics.de/norma_ai/

Der DISCQM-Zyklus – Ein Fahrplan zur Umsetzung von Digitalisierungsprojekten in QM und QS

Digitalisierung in Qualitätsmanagement und Qualitätssicherung – Beispiele und Herausforderungen

In der heutigen Zeit ist Digitalisierung ein häufig genutzter Begriff, der für viele Menschen in seiner Bedeutung schlicht noch sehr abstrakt und selten greifbar ist. Dabei dient er im Grunde nur als Schlüsselwort für die digitale Transformation und Veränderung der Geschäftsmodelle, Prozesse, Strategien, Produkte oder Services durch beispielweise Softwarelösungen.

Dieser angesprochene Prozess bedeutet nicht notwendigerweise eine Vollautomatisierung von Teilbereichen oder das Verändern von gelernten Abläufen ohne menschliche Komponente, sondern vielmehr, die Optimierung im Hinblick auf direkte Interaktion innerhalb der Organisation mittels Daten oder Software-Anwendungen.