Data Analytics – Von der Datenerfassung zur Entscheidungsunterstützung

Wenn wir uns die vergangenen Jahrzehnte anschauen, wird eines ziemlich klar: Daten haben enormen Einfluss, egal ob es sich um kleine Mengen an Daten, Big Data, klassische oder moderne Statistik, Analytik oder gar künstliche Intelligenz handelt – und das betrifft Mitarbeiter:innen auf allen Unternehmensebenen. Daten helfen auf vielfältige Art und Weise, die Unternehmensleistung zu verbessern.

Auf der einen Seite haben wir künstliche Intelligenz, von der wir uns versprechen, Geschäftsmodelle komplett zu verändern und die deshalb die meiste Aufmerksamkeit bekommt. Auf der anderen Seite sind schon einfache Analysen mit wenigen Daten äußerst wirkungsvoll, wenn es darum geht, Unternehmen dabei zu unterstützen, bessere Entscheidungen zu treffen, Geschäftsabläufe zu steuern und zu optimieren, ein besseres Verständnis für Kunden zu bekommen und Produkte sowie Dienstleistungen zu verbessern.

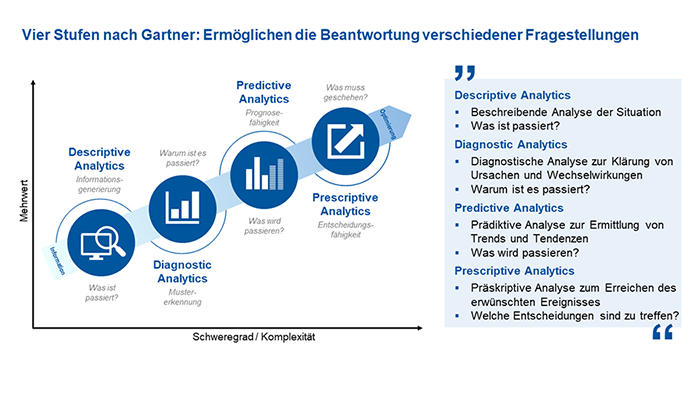

Die Nutzung von Daten zur Informationsgewinnung und Entscheidungsunterstützung hat sich zu einer zentralen Säule in vielen Unternehmen entwickelt. Data Analytics bietet die Möglichkeit, aus Daten wertvolle Erkenntnisse zu gewinnen, Geschäftsprozesse zu optimieren und fundierte Entscheidungen zu treffen. In diesem Beitrag stelle ich Ihnen die vier Analytics-Reifegradstufen nach Gartner vor und wie das Vorgehensmodell des CRISP-DM (Cross-Industry Standard Process for Data Mining) einen strukturierten Rahmen bieten kann, um den größtmöglichen Nutzen aus Daten zu ziehen.

Analytics-Reifegradstufen nach Gartner

Die Unternehmensberatung Gartner Inc. hat im Jahr 2012 Forschungsergebnisse vorgestellt, die es bis heute anschaulich ermöglichen, Data Analytics in vier Reifegradstufen zu unterteilen. Hierzu zählen:

- Deskriptive Analytics

Deskriptive Analytics ist der Ausgangspunkt jeder Datenanalyse und beschreibt vergangene Ereignisse. Hierbei sammeln die Beteiligten historische Daten und nutzen diese, um überhaupt erst einmal zu verstehen, „Was ist passiert?“. Diese Phase legt den Grundstein für das Verständnis der eigenen Datenlandschaft und ermöglicht erste Einblicke in vergangene Entwicklungen. - Diagnostic Analytics

In der zweiten Reifegradstufe beschreibt Diagnostic Analytics die Identifizierung von Mustern und Trends in den Daten. Wenn diese erkannt wurden, geht es darum, die Gründe hinter den Ereignissen zu verstehen. Basierend auf der Frage „Warum ist es passiert?“ analysieren die Verantwortlichen Zusammenhänge und Kausalitäten, um beispielsweise Ursachen für Qualitätsprobleme oder Engpässe in Geschäftsprozessen aufzudecken. - Predictive Analytics

Predictive Analytics ist die erste in die Zukunft gerichtete Stufe. Es werden historische Daten genutzt, um zukünftige Entwicklungen vorherzusagen. Statistische Modelle und Machine-Learning-Algorithmen ermöglichen Prognosen, die als Grundlage für vorausschauende Entscheidungen dienen und der Frage nachgehen „Was wird passieren?“. - Prescriptive Analytics

Stufe vier ist die höchste Stufe der Data Analytics: Prescriptive Analytics geht über die Vorhersage hinaus und empfiehlt konkrete Handlungsschritte, indem sie fragt, „Was muss geschehen?“. Basierend auf den Erkenntnissen der vorherigen Stufen schlägt sie Maßnahmen vor, um gewünschte Ziele zu erreichen.

Maoz, Michael: How IT Should Deepen Big Data Analysis to Support Customer-Centricity. Gartner Research 2013.

Die Einteilung in die vier Stufen und ihre Leitfragen helfen Mitarbeiter:innen in Unternehmen insbesondere in der Praxis dabei, eine klare Struktur zu schaffen, um ihre Datenanalysestrategien zu gestalten und zu verbessern. Dies ermöglicht eine schrittweise Entwicklung von der reinen Datenerfassung bis hin zur datengestützten Entscheidungsfindung.

Durch diese Einteilung können Unternehmen gezielt in die jeweiligen Stufen investieren, um die Leistung ihrer Geschäftsprozesse zu steigern. Die Vorteile liegen in der schrittweisen Steigerung der Analysekomplexität, von retrospektiven Einblicken bis hin zu proaktiven Handlungsempfehlungen. Dadurch können sie nicht nur Vergangenes besser verstehen lernen, sondern auch zukünftige Trends vorhersagen und schließlich fundierte Maßnahmen ableiten, um ihre Ziele effizient zu erreichen und ihre Wettbewerbsfähigkeit zu stärken.

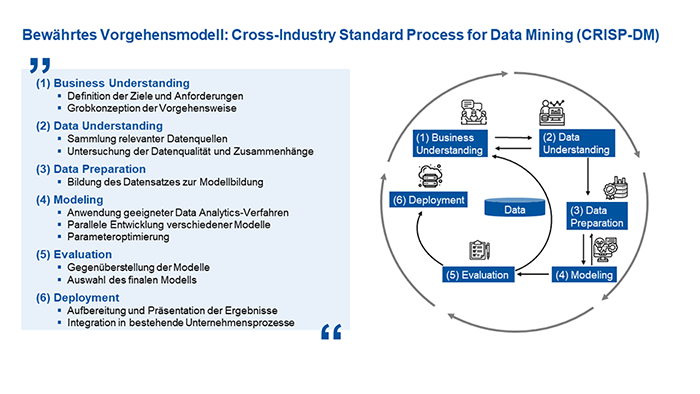

Der CRISP-DM-Prozess in der Data Analytics

Das CRISP-DM-Vorgehensmodell (CRoss Industry Standard Process for Data Mining) bietet einen bewährten Rahmen für den Datenanalyseprozess in Unternehmen. Es ist in folgende sechs Phasen unterteilt:

- Business Understanding

Die Phase des Business Understanding dient dazu, zu Beginn klare Geschäftsziele und Anforderungen festzulegen. Dabei definieren die Beteiligten die grundlegenden Fragen, die durch die Datenanalyse beantwortet werden sollen. Hierbei steht im Fokus, wie die Daten zur Erreichung der Unternehmensziele beitragen können. - Data Understanding

In der Phase des Data Understanding geht es darum, verfügbare Datenquellen zu analysieren und zu verstehen. Die Untersuchung der Datenqualität und deren Zusammenhänge sind zentrale Aufgaben und Ziele in dieser Phase. - Data Preparation

Anschließend erfolgt die Data Preparation: Daten werden bereinigt, transformiert und aggregiert, um sie für die Modellbildung vorzubereiten. - Modeling

Während des Modeling erfolgt die Anwendung geeigneter Data-Analytics-Verfahren. Hierbei können verschiedene Modelle auch parallel entwickelt und erprobt werden, um Muster und Zusammenhänge in den Daten zu identifizieren. - Evaluation

Die Evaluation dient dazu, die erstellten Modelle auf ihre Leistung und Ergebnisse zu überprüfen und zu vergleichen. Als Ergebnis soll eine Auswahl des finalen Modells erfolgen. Hierbei ist es wichtig zu erwähnen, dass es zu einem Closed-Loop kommt, in dem die Ergebnisse mit den Zielen und Anforderungen des Business Understanding abgeglichen werden. Bei Abweichungen, die durchaus auch positive Erkenntnisse und Verbesserungen sein können, erfolgen die weiteren Phasen iterativ. - Deployment

In der letzten Phase des Deployment steht im Fokus, die am besten geeigneten Modelle zu implementieren und in die Geschäftsprozesse zu integrieren. Die implementierten Modelle sollten kontinuierlich überwacht werden, um sicherzustellen, dass sie effektiv arbeiten.

Die Verknüpfung der vier Reifegradstufen nach Gartner mit den Phasen des CRISP-DM schafft einen leistungsstarken Rahmen für den effektiven Einsatz von Data Analytics. Von der explorativen Analyse der Vergangenheit bis zur präskriptiven Handlungsempfehlung für die Zukunft bietet dieser Ansatz ein umfassendes Vorgehensmodell, um Daten in konkrete und strategische Entscheidungen umzuwandeln.

Fazit

Data Analytics ist heute mehr denn je ein entscheidender Faktor für den Geschäftserfolg. Die systematische Orientierung an den oben genannten Reifegradstufen und die strukturierte Anwendung des CRISP-DM als Vorgehensmodell ermöglichen es Unternehmen, von der Datenerfassung zur wirkungsvollen Handlungsempfehlung zu gelangen. Egal, ob es um die Optimierung der Produktqualität, Prozesseffizienz oder die Vorhersage von Kundentrends geht – Data Analytics bietet eine reichhaltig wachsende Quelle für fundierte Entscheidungen und Innovationspotenzial.

Wie weit sind Sie in Ihrem Unternehmen mit der Anwendung von Data Analytics fortgeschritten? Teilen Sie uns Ihre Erfahrungen mit!

Autor:

Sebastian Beckschulte ist wissenschaftlicher Mitarbeiter am Lehrstuhl für Fertigungsmesstechnik und Qualitätsmanagement am WZL der RWTH Aachen. In der Abteilung Quality Intelligence entwickeln er und seine Kolleg:innen in den Bereichen der Produkt- und Prozessqualität bestehende Ansätze weiter und beantworten bekannte, unternehmerische Problemstellungen mit neuen Methoden und Technologien. Nach seinem Studium zum Wirtschaftsingenieur an der Universität Duisburg-Essen schlug Sebastian Beckschulte am Lehrstuhl eine wissenschaftliche Laufbahn ein. Als wissenschaftlicher Mitarbeiter setzt er sich dabei intensiv mit den Themen der datenbasierten Entscheidungsunterstützung in Fehlermanagement- und Produktionsprozessen auseinander.

Digitaler Wandel im Reklamationsmanagement – ein Besuch bei der VDMA-Tagung

Ganz im Zeichen der Digitalisierung stand die diesjährige VDMA-Tagung zum Reklamationsmanagement mit dem Motto “Mit digitalem Beschwerdemanagement beim Kunden punkten”. 88 Teilnehmer aus dem Anlagen- und Maschinenbau nutzten die Möglichkeit zum Austausch und verfolgten die sechs abwechslungsreichen Beiträge. Redner mit ganz unterschiedlichem Fokus wie Qualitätsmanagement, IT, Recht und Data Analytics waren eingeladen und ermöglichten so einen umfassenden Blick auf das Thema aus verschiedenen Perspektiven. So wurde von führenden Unternehmen ganz praxisnah demonstriert, wie die digitale Transformation der Reklamationsprozesse schon heute gelingt. Einen Blick aus der Vogelperspektive auf die Kennzahlen im Reklamationsmanagement gab es direkt aus erster Hand vom VDMA. Wie künstliche Intelligenz und Software im europäischen Recht verstanden werden, war für viele Besucher sicher eine ganz neue Perspektive.

Auch die Deutsche Gesellschaft für Qualität war mit dem Beitrag “Wie Sie mit Data Analytics Reklamationen vorhersagen” des DGQ-Trainers Dr. Gregor Bartsch vertreten. Herr Bartsch zeigte auf, wie das Thema sich in digitalisierte Reklamationsprozesse einfügt; denn belastbare Reklamationsdaten ermöglichen überhaupt erst solide Vorhersagen. Grundlegende Modelle zur Produktalterung wurden ganz unkompliziert am Beispiel eines Spielzeugflugzeuges veranschaulicht. Das bereitete den Einstieg in eine allgemeine Fallstudie zur Reklamationsprognose: Es ging um ein noch junges Qualitätsproblem mit einem neuen Fehlerbild. In der Situation war unklar, ob es nach den ersten wenigen Reklamationen ruhig weitergeht, oder ob sich die Sache in eine Reklamationswelle epidemischen Ausmaßes entwickeln würde. “In solchen Fällen haben Sie nur sehr wenig Daten in der Hand für Ihre Prognosen”, kommentierte Dr. Bartsch die dünne Datengrundlage. “Mit gut überlegten Annahmen zum Alterungsmodell kann man aber auch in so frühen Phasen viel erreichen”, führte er fort, um gleich darauf Prognosen für Reklamationszahlen und Kosten mit einer Web-Applikation vorzurechnen. Durch den Vergleich mehrerer Prognosen verdeutlichte sich die Idee der Methode als Entscheidungshilfe. “Sie können verschiedene Szenarien von potenziellen Maßnahmen direkt miteinander vergleichen und die Folgen für Qualität und Kosten sichtbar machen”, fasste Dr. Bartsch die Ergebnisse zusammen und teilte seine Gedanken zur gezeigten Software-Unterstützung: “Der Computer kann einem viel Mathematik abnehmen – das erleichtert den Zugang ungemein. Das Thema bleibt aber sehr anspruchsvoll und man kann ohne gutes Verständnis für die Modelle einiges falsch machen. Es lohnt sich daher Zeit zu investieren, um die Denkkonzepte richtig zu verstehen und damit bestmögliche Prognosen zu erstellen.”

Für alle, die das Thema verstehen möchten und praxisnahe Beispiele im anschaulichen Format suchen, ist das DGQ E-Training “Wie Sie mit Data-Analytics Reklamationen vorhersagen” genau das richtige.

Daten werden zum Wirtschaftsgut – Unternehmen auf dem Weg in die Datenökonomie

In unserer Gesellschaft spielen Daten, die wir durch Messung oder Beobachtung erhalten, eine zentrale Rolle. Nicht umsonst gelten sie als das neue Öl unserer Zeit. Dies betrifft sowohl die Daten, die tagtäglich über uns gesammelt werden, als auch Daten, Kennzahlen und Messwerte im unternehmerischen Kontext. Durch neue und rasante technologische Entwicklungen wächst die verfügbare Datenmenge aus allen Geschäftsbereichen eines Unternehmens stetig an. Doch was fängt man mit diesen Daten an und welchen Nutzen können Unternehmen aus ihnen ziehen? Inzwischen geht es nicht mehr nur darum, vorhandene Daten sinnvoll zu nutzen – zum Beispiel zur Fehlerbehebung oder Prozessoptimierung. Daten selbst werden zur Ressource und zum Wirtschaftsgut. Datenökonomie bedeutet, Daten in eigenständigen Geschäftsmodellen zu kommerzialisieren.

Big Data bei vielen Unternehmen an erster Stelle

Neue Technologien, wie das Internet of Things, künstliche Intelligenz oder Block Chain haben einen immer größeren Einfluss auf die Wettbewerbsfähigkeit von Unternehmen. Das besagt eine repräsentative Befragung von Managern in 604 deutschen Unternehmen ab 20 Mitarbeitern, die der Digitalverband Bitkom 2018 durchgeführt hat. Ein zentrales Ergebnis: Big Data steht an erster Stelle der geplanten oder bereits umgesetzten Technologien (57 Prozent).

(mehr …)

Digitalisierung – so ändern sich die Anforderungen an Datenerhebung und statistische Methoden

Die Relevanz von Daten und deren Erhebung, Analyse und Interpretation stehen zunehmend im Zentrum digitalisierten Industrie und Gesellschaft. Neben dem Einsatz innovativer Technologien und der Entwicklung digitaler Geschäftsmodelle bietet die Analyse großer Datenmengen für Unternehmen bemerkenswertes Potenzial zur besseren Marktpositionierung.

DGQ überarbeitet Statistik-Lehrgänge: Data Analytics im Fokus

Große Datenmengen smart zu analysieren und aufzubereiten – in Zeiten der digitalen Transformation wird diese Fähigkeit immer wichtiger. Statistische Methoden und Modelle bilden auch hierbei die Grundlage für die Gewinnung valider Erkenntnisse. Statistik erweitert sich um den Bereich Data Analytics. So bieten sich künftig noch effektivere Möglichkeiten, Prozesse zu verbessern und Unternehmensziele zu erreichen. Das Know-how zur Analyse großer Datenmengen wird zur Schlüsselkompetenz für Effizienzsteigerung. Es bildet die Grundlage von Entscheidungsfähigkeit und Strategieentwicklung im digitalen Wandel.

Um Qualitätsfachleute auch künftig umfassend für die aktuellen Herausforderungen im Bereich Data Analytics in Produktion und Dienstleistung zu rüsten, überarbeitet die DGQ aktuell ihre Statistik-Trainings. Ab Mitte 2019 bietet sie neue Lehrgänge und Zertifikate zum Thema Data Analytics mit unterschiedlichen Schwerpunkten für Industrie- und Dienstleistungsunternehmen an.

Die DGQ ist seit Jahrzehnten ein renommierter Trainingspartner für Statistik – und vergibt anerkannte Zertifikate wie den DGQ-Schein „Qualitätstechnik QII“ oder den „DGQ-Instruktoren-Ausweis“. DGQ-Instruktoren sind Experten auf dem Gebiet statistischer Methoden und darüber hinaus in der Lage, ihre praktische Anwendung zu vermitteln. Diese langjährige Erfahrung in der Ausbildung bildet die Basis für die Modernisierung der Lehrgangsreihe.