Digitalisierung – so ändern sich die Anforderungen an Datenerhebung und statistische Methoden

Die Relevanz von Daten und deren Erhebung, Analyse und Interpretation stehen zunehmend im Zentrum digitalisierten Industrie und Gesellschaft. Neben dem Einsatz innovativer Technologien und der Entwicklung digitaler Geschäftsmodelle bietet die Analyse großer Datenmengen für Unternehmen bemerkenswertes Potenzial zur besseren Marktpositionierung.

Um dieses Potenzial nutzen zu können, sind gut ausgebildete Mitarbeiter und Mitarbeiterinnen eine Grundvoraussetzung. So sind laut des „Mittelstandsbarometers 2018: Digitalisierung“ der Wirtschaftsprüfungsgesellschaft Ernst & Young fehlendes Personal und mangelndes Know-how die relevantesten Investitionshemmnisse von Unternehmen.

Erhebung, smarte Auswertung und Nutzung von Daten wird zur Schlüsselkompetenz

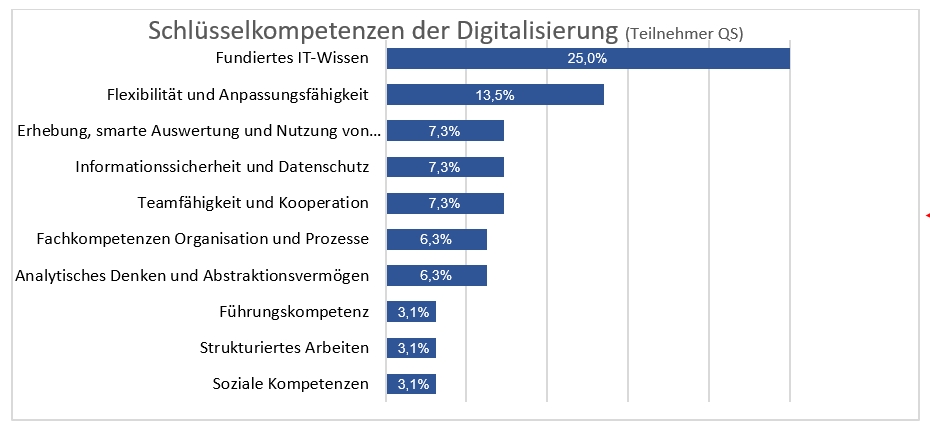

Die Ergebnisse des DGQ-Monitors „Digitalisierung“ aus 2018 zeigen, dass vor allem für die Qualitätssicherung in Unternehmen die Sammlung, Verarbeitung und Auswertung von Daten einen großen Stellenwert einnimmt. Die befragten QS-Fachleute sehen in der „Erhebung, smarten Auswertung und Nutzung von Daten“ eines der fünf wichtigsten Kompetenzfelder der Zukunft (vgl. Abbildung 1). In dieser hohen Relevanz intelligenter Analyse von Daten zeigt sich der fortschreitende Bedarf an Anwendungs-Know-how aus dem Bereich Data Analytics.

Abbildung 1: Gruppierte Antworten aller Teilnehmer mit Aufgabenbereich QS auf die Frage „Welche Kompetenzen und Qualifikationen halten Sie im Zuge der fortschreitenden Digitalisierung für besonders wichtig?“ (Kompetenzfelder basierend auf 96 Nennungen; ausgewiesene Top 10 vereinen 76 Prozent der gesamten Angaben auf sich). Quelle: DGQ-Monitor „Digitalisierung“.

Unternehmen planen Investitionen in Big Data

Vor allem Big Data-Anwendungen stehen für deutsche Unternehmen an erster Stelle, wenn es um Investitionen in neue Technologien geht. Das ist das Ergebnis einer repräsentativen Befragung des Digitalverbandes Bitkom. 57 Prozent der befragten Unternehmen planen Investitionen in Big Data oder sind bereits in der Umsetzung. Der Einsatz von Big Data-Methoden bietet nicht nur die Möglichkeit der effizienten Analyse großer Datenmengen, sondern produziert Informationen unterschiedlichster Art.

Besonders interessant ist der Einsatz im Qualitätsmanagement. Laut des Deutschen Industrie 4.0-Index 2018 der Unternehmensberatung Staufen werten rund sieben von zehn Unternehmen mit Industrie-4.0-Anwendungen ihre in der Produktion anfallenden Datenmengen aus, um die Qualität ihrer Produkte zu kontrollieren. Allerdings schöpfen die Betriebe dabei das Potenzial von Big Data nicht annähernd aus. Den Ursachen von Qualitätsproblemen sind sie mit ihren Analysen bisher jedenfalls kaum auf der Spur, wie ein gemeinsames Forschungsprojekt von Staufen und der TU Darmstadt belegt. Ein genauer Blick auf die Produktionsdaten ermögliche jedoch Einblicke in die Ursachen von Qualitätsproblemen und in Wirkungszusammenhänge, die nicht offensichtlich sind.

Neue Lehrgänge zu Data Analytics vermitteln das richtige Know-how

Aktuell überarbeitet die DGQ ihre bewährten Statistiklehrgänge. Sie geht relevante Schritte in Richtung Data Analytics, damit sich Qualitäts- und Prozessverantwortliche auch künftig umfassend für die aktuellen Herausforderungen rüsten. Ab Mitte 2019 werden die neuen Lehrgänge und Zertifikate mit unterschiedlichen thematischen Schwerpunkten angeboten. In sechs Lehrgängen verbindet sich die jahrzehntelange Erfahrung der DGQ mit neu entwickelten Lösungen für die aktuellen Anforderungen an die professionelle Analyse von Daten. Die Teilnehmer der neuen Trainings werden umfassend darauf vorbereitet, Prozesse mit den richtigen statistischen Methoden zu verbessern und eine hohe Produktqualität sicherzustellen, die dem definierten Niveau entspricht.

Alle Lehrgänge im Überblick:

- Big Data mit explorativen Methoden analysieren

- Zuverlässigkeit methodisch beschreiben und vorhersagen

- Fähigkeit von Mess- und Fertigungsprozessen statistisch nachweisen

- Versuche mit statistischen Methoden planen, durchführen und analysieren

- Prozesse mit statistischen Methoden analysieren, freigeben und regeln

- Statistische Stichprobenverfahren auswählen und zielgerichtet einsetzen