8D-Report – Ein Werkzeug, das sich verändern muss

8D-Report – Ein Werkzeug, das sich verändern muss

– Warum der A3 Report innerbetrieblich das bessere Instrument ist

Viele kennen die Situation: fast täglich kommt ein neuer 8D-Report ins Unternehmen, mit dem man nichts anzufangen weiß oder für den man nicht zuständig ist. Doch die häufig negative Einstellung, die mittlerweile gegenüber dem 8D-Report vorherrscht, sollte kritisch hinterfragt werden. Gerade in der jetzigen Zeit muss die Qualität als Führungsthema im Vordergrund der Unternehmen stehen. Walter Masing, der den Qualitätsbegriff entscheidend geprägt hat, hat die These aufgestellt, dass die meisten personenbedingten Fehler ihre Ursachen im System haben, für das im weitesten Sinne die Führung verantwortlich ist. (mehr …)

Warum rückgeführte Messergebnisse für Ihr Unternehmen notwendig sind

Rund um die Uhr wird gemessen. Im täglichen Leben beschäftigen wir uns eher unbewusst mit der Fragestellung, ob der Messwert überhaupt ein richtiger, gültiger Messwert ist. Vielleicht beim Kauf von hochpreisigen Lebensmitteln, bei einer gemessenen Geschwindigkeitsüberschreitung oder einer Reklamation, bewerten wir das Messergebnis auf seine Richtigkeit. In einer so schnelllebigen Zeit wie heute sind wir in einem besonderen Maß auf gültige Messergebnisse angewiesen. Aber wie kommen diese zustande, bzw. wann kann von einem gültigen Messergebnis die Rede sein?

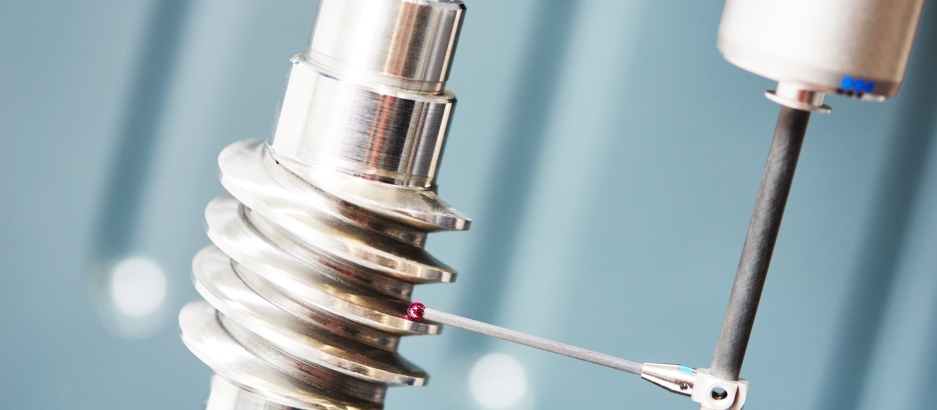

Geeignete Mess- und Prüfmittel – das Herz jeder Produktion

Wer komplexe Produktionsprozesse oder Konformitätsbestätigungen sicher beherrschen möchte, muss auch die „Kunst des Messens“ beherrschen. Dazu gehört vor allem die Feststellung der Eignung von Mess- und Prüfmitteln. Tatsächlich geht es jedoch nicht um die Eignung von Mess- und Prüfmitteln, sondern um den Nachweis das die zur Anwendung kommenden Mess- und Prüfmittel inkl. der dazugehörigen Methoden für die jeweiligen Überwachungs- und Messtätigkeiten geeignet sind. Nur dadurch wird gewährleistet, dass die Risiken in Verbindung mit ungeeigneten Überwachungs- und Messtätigkeiten nahezu auf null reduziert werden. Zu den wesentlichen Risiken zählen:

- ungültige Konformitätsbestätigung (Auslieferung unsicherer Produkte)

- nicht wirksame Regelkreise in der Produktion (hoher Ausschuss)

- etwaiger Fehlerdurchschlupf zum Kunden (Reklamation, Kosten)

- nicht Einhaltung von gesetzlichen Forderungen (z.B. CE)

- Rückrufaktionen (erhebliche Kosten und Imageverlust)

- erhebliche Haftungsrisiken (z.B. Umweltrecht)

In allen gängigen branchenübergreifenden (z.B. ISO 9001, ISO 14001, ISO 45001, etc.) und -spezifischen (ISO 9100, HACCP, QSF, ISO 17025, DIN 27201-9, ISO 13485, IATF 16949, etc.) Standards ist das Thema „… gültige und zuverlässige Überwachungs- und Messergebnisse“ in Verbindung mit festgelegten Anforderungen“ als „muss“ Forderung enthalten. Dazu kommen dann noch die Anforderungen an die Eignung von Überwachungs- und Messtätigkeiten aus diversen Rechtsvorschriften.

Die Kernforderung von ISO 9001 ist nicht das Kleben von Plaketten an Mess- oder Prüfmitteln

Was ist die Kernforderung von ISO 9001 in Bezug auf Produktkonformität? Erinnern wir uns an die Einleitung zu ISO 9001 „Die potenziellen Vorteile für eine Organisation, die sich aus der Umsetzung eines Qualitätsmanagementsystems basierend auf dieser Internationalen Norm ergeben, sind folgende: a) die Fähigkeit, beständig Produkte und Dienstleistungen zu liefern, die die Kundenanforderungen und zutreffende gesetzliche und behördliche Anforderungen erfüllen;…“. Das heißt im Klartext, dass die definierte Produkt-/Dienstleistungsqualität abgesichert hergestellt wird.

Dazu fordert die Norm, dass die entsprechenden Ressourcen festgelegt und bereitgestellt werden müssen, um die Konformität von Produkten und Dienstleistungen durch Mess- oder Überwachungsergebnisse nachweisen zu können. Konformität wiederum bedeutet die Erfüllung von Anforderungen. Eine weitere wesentliche Anforderung von ISO 9001 ist, dass die Eignung der bereitgestellten Ressourcen für die jeweilige Mess- oder Überwachungstätigkeit gegeben ist. Der Nachweis dieser Eignung ist dann auch entsprechend zu dokumentieren. Da ISO 9001 eine sogenannte wirkzielorientierte Norm ist, sind keine Methoden zur Eignungsfeststellung festgelegt worden. Die Definition der Methoden zur Eignungsfeststellung obliegt somit dem Anwender der Norm.

Was verbirgt sich hinter der Eignungsfeststellung?

Grundlage für die Eignungsfeststellung (also den geeigneten Einsatz für den beabsichtigten Gebrauch) bilden die Spezifikationen der Merkmale des Produktes. Eine Eignung ist dann gegeben, wenn ein Mess- oder Prüfmittel die definierten Anforderungen an seine beabsichtigte Verwendung erfüllt. Die definierte Anforderung ist das erwartete Mess- oder Überwachungsergebnis, um die Konformität mit den Vorgaben bestätigen zu können. In der Regel sind diese Anforderungen in entsprechenden Prüfspezifikationen festgelegt.

Es gibt viele Möglichkeiten zur Eignungsfeststellung. Entweder über statistisch abgesicherte Verfahren oder einfach nur durch die Anwendung des technischen Verstandes in Verbindung mit umfassenden Kenntnissen der Messtechnik und der Messfehler und Fehlerursachen. Die sicherlich bekanntesten Verfahren zum Eignungsnachweis sind die Measurement System Analysis (MSA, AIAG) oder der VDA Band 5 (Prüfprozesseignung, Eignung von Messsystemen, Mess- und Prüfprozessen – bei geometrischen Merkmalen). Diese Verfahren sind jedoch nicht zwingend erforderlich, um die Eignung feststellen zu können. Eine Eignung ist auch dann gegeben, wenn der Abstand zwischen der Fehlergrenze des Mess- oder Prüfmittels wesentlich kleiner ist, als die Toleranzgrenze für die Konformitätsentscheidung. Wichtig ist, dass ein zuverlässiges und reproduzierbares Messergebnis erzeugt werden kann.

Absicherung der Eignung als Erfolgsfaktor

Nachdem einmal die Eignung eines Verfahrens zur Ermittlung gültiger und zuverlässiger Überwachungs- und Messergebnisse nachgewiesen wurde, besteht die zweite Kernaufgabe darin, die Eignung kontinuierlich sicherzustellen. Dazu zählt dann u.a. die regelmäßige Verifizierung der Überwachungs- und Messverfahren mit Hilfe geeigneter Standards oder die Kalibrierung der eingesetzten Mess- oder Prüfmittel. Nur durch diese Maßnahmen sind metrologisch rückführbare Überwachungs- und Messergebnisse zur Konformitätsbewertung darstellbar.

DIN EN ISO 9001:2015 „Qualitätsmanagementsysteme – Anforderungen“

DIN 32937:2018 „Mess- und Prüfmittelüberwachung – Planen, Verwalten und Einsetzen von Mess- und Prüfmitteln“

DIN EN ISO 10012:2004 „Messmanagementsysteme – Anforderungen an Messprozesse und Messmittel“

VDI/VDE 2600:2013 Bl. 1, „Prüfprozessmanagement – Identifizierung, Klassifizierung und Eignungsnachweise von Prüfprozessen“

IATF 16949:2016 „Qualitätsmanagement – System – Standard der Automobilindustrie“

DIN EN ISO 9001:2015 „Qualitätsmanagementsysteme – Anforderungen“

DIN EN ISO/IEC 17025:2018 Allgemeine Anforderungen an die Kompetenz von Prüf- und Kalibrierlaboratorien“

ISO/IEC-Leitfaden 99:2007 „Internationales Wörterbuch der Metrologie“

Testo Fibel – Prüfmittelmanagement und Kalibrierung / Die Forderungen der Richtlinien und deren praktische Umsetzung“

Jörg Roggensack ist von Haus aus Elektroniker und Calibration Engineer GAF sowie zertifizierter Auditor für div. Managementsysteme. Er hat umfassende Erfahrung als Managementsystemkoordinator und als Auditor für diverse Regelwerke und Managementsysteme (IMS, QM, UM, AS, GMP, GLP) sowie als LEP Assessor die er in über 27 Jahren bei der Bundeswehr, in der Industrie und bei Zertifizierungsgesellschaften sammeln konnte. Über mehrere Jahre bildete er u.a. Kalibriertechniker an der Technischen Schule der Luftwaffe in Kaufbeuren aus und begann seine industrielle Kariere als Kalibrierlaborleiter bei BEYSCHLAG. In diversen Veröffentlichungen, als Herausgeber des Weka Werkes der „Mess- und Prüfmittelbeauftragte“ und als Auditor, Trainer sowie Umsetzungsberater bei JR Management Services & Qualifizierung gibt er immer wieder Hilfestellungen zur Gestaltung wirtschaftlicher und normkonformer Mess- und Prüfmittelüberwachungssysteme.

Qualität entsteht aus der Vernetzung – neue Ansätze für die Qualitätssicherung in der Supply Chain

Die vermeintlich fragilen und linearen Lieferketten sind in Wirklichkeit robuste, verzweigte Netze. Diese Sicht auf die Liefernetze hilft, ihre moderne Rolle in der digitalen Disruption neu zu verstehen. Qualität entsteht in diesen Liefernetzen nicht als Summe der Qualitätsbeiträge der einzelnen Lieferanten, sondern aus einer aktiven Vernetzung der beteiligten Menschen heraus. Neue Organisationsformen und vernetzungsroutinierte Mitarbeiter fördern eine lieferantenübergreifende Qualitätssicherung. (mehr …)