Big Data in der Kunststoffverarbeitung

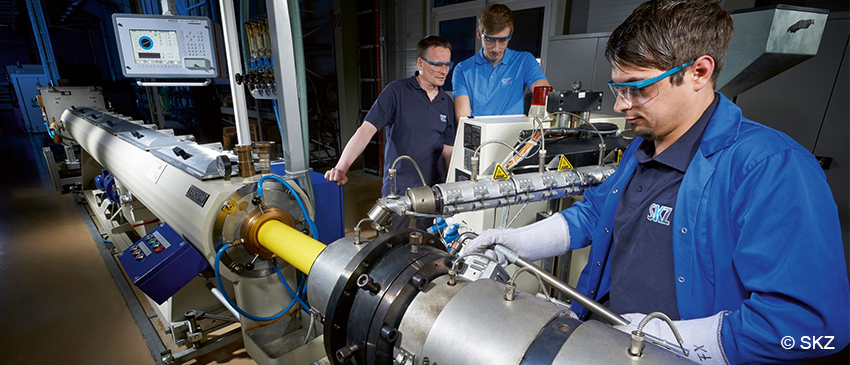

Zerstörungsfreie Prüfmethoden beim Compoundieren

Die Überwachung von Produktionsprozessen und die dabei auftretende Generierung und Verarbeitung großer Datenmengen (Big Data) hat in den letzten Jahren zunehmend an Wichtigkeit gewonnen und führt letztlich zu einem verbesserten Qualitätsstandard vieler Produkte. In der Kunststoffbranche bestehen insbesondere beim Compoundieren, der Basis für die sich daran anschließenden, formgebenden Verarbeitungsverfahren, hohe Ansprüche bezüglich der Prozesskontrolle und der dafür notwendigen Messverfahren zur Informationsgewinnung über den Ist-Zustand. Seit Langem etabliert sind hierbei Druck- und Temperaturmessungen. Moderne Messmethoden bieten aber weit darüber hinausreichende Möglichkeiten. (mehr …)

Daten werden zum Wirtschaftsgut – Unternehmen auf dem Weg in die Datenökonomie

In unserer Gesellschaft spielen Daten, die wir durch Messung oder Beobachtung erhalten, eine zentrale Rolle. Nicht umsonst gelten sie als das neue Öl unserer Zeit. Dies betrifft sowohl die Daten, die tagtäglich über uns gesammelt werden, als auch Daten, Kennzahlen und Messwerte im unternehmerischen Kontext. Durch neue und rasante technologische Entwicklungen wächst die verfügbare Datenmenge aus allen Geschäftsbereichen eines Unternehmens stetig an. Doch was fängt man mit diesen Daten an und welchen Nutzen können Unternehmen aus ihnen ziehen? Inzwischen geht es nicht mehr nur darum, vorhandene Daten sinnvoll zu nutzen – zum Beispiel zur Fehlerbehebung oder Prozessoptimierung. Daten selbst werden zur Ressource und zum Wirtschaftsgut. Datenökonomie bedeutet, Daten in eigenständigen Geschäftsmodellen zu kommerzialisieren.

Big Data bei vielen Unternehmen an erster Stelle

Neue Technologien, wie das Internet of Things, künstliche Intelligenz oder Block Chain haben einen immer größeren Einfluss auf die Wettbewerbsfähigkeit von Unternehmen. Das besagt eine repräsentative Befragung von Managern in 604 deutschen Unternehmen ab 20 Mitarbeitern, die der Digitalverband Bitkom 2018 durchgeführt hat. Ein zentrales Ergebnis: Big Data steht an erster Stelle der geplanten oder bereits umgesetzten Technologien (57 Prozent).

(mehr …)

Digitalisierung – so ändern sich die Anforderungen an Datenerhebung und statistische Methoden

Die Relevanz von Daten und deren Erhebung, Analyse und Interpretation stehen zunehmend im Zentrum digitalisierten Industrie und Gesellschaft. Neben dem Einsatz innovativer Technologien und der Entwicklung digitaler Geschäftsmodelle bietet die Analyse großer Datenmengen für Unternehmen bemerkenswertes Potenzial zur besseren Marktpositionierung.

DGQ-Statistik-Trainings: Lange Tradition in der Vermittlung statistischer Methoden

Für produzierende Unternehmen sind statistische Methoden für die Analyse von Produktionsprozessen seit jeher die Basis, um Prozesse und Produkte zu vebessern. Im Qualitätsmanagement oder in der Qualitätssicherung bilden die Voraussetzung für reproduzierbare Qualität. Durch geeignete statistische Methoden lassen sich Prozesse beherrschen und systematische Einflüsse von zufälligen Streuungen unterscheiden. Entlang des Produktionsprozesses haben sich in der Praxis eine Reihe von statistischen Verfahren als Werkzeuge etabliert.

Big und Smart Data – von der Statistik zur Datenanalyse

Statistik gehört zu unserem Alltag. Auch wenn wir nicht direkt im Berufsalltag mit statistischen Verfahren arbeiten, werden wir täglich mit einer Vielzahl von Statistiken konfrontiert: Wir erfahren über das Fernsehen, die Zeitung oder das Internet etwas über Aktienkurse, Trends auf dem Arbeitsmarkt, die aktuellen Wahlhochrechnungen oder die Auswertungen rund um die Fußball-Bundesliga. (mehr …)